ResNet还是DenseNet?即插即用的DS涨点神器来了!

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文转载自:AI人工智能初学者 | 文末附论文PDF下载

-

论文:

https://arxiv.org/abs/2010.12496

DSNet比ResNet取得了更好的结果,并且具有与DenseNet相当的性能,但需要的计算资源更少。其中改进的DS2Res2Net性能非常强大。

作者单位:韩国科学技术院(KAIST)

1、简介

大多数基于深度学习的方法都是通过backbone网络实现的,其中两个最有名的方法就是ResNet和DenseNet。尽管它们具有差不多的性能和受欢迎程度,但它们两个都存在固有的缺点。对于ResNet,稳定训练的identity shortcut方式也限制了其表示能力,而DenseNet具有更高的特征,可以进行多层特征串联。但是,密集级联会引起新的问题,即需要较高的GPU内存和更多的训练时间。部分由于这个原因,在ResNet和DenseNet之间不是一个简单的选择。

本文提供了dense summation的统一视角来分析它们,从而有助于更好地了解它们的核心差异。同时进一步提出了dense weighted normalized shortcuts,以解决它们之间的难题。所提出的密集快捷方式继承了ResNet和DenseNet中简单设计的设计理念。

2、相关方法

2.1、Micro-module design

都是耳熟能详的操作,大家可以自行进行调研和研读:

-

normalization modules -

attention modules -

group convolutions -

bottleneck design -

weight normalization -

instance normalization -

group normalization

2.2、Macro-architecture design

都是耳熟能详的模型,大家可以自行进行调研和研读:

-

AlexNet -

VGGNet -

GoogleNet -

ResNet -

DenseNet -

WideResnet -

ResNext -

Preactivation-ResNet -

CondenseNet -

Dual path network -

mixed link network -

FractalNet

3、本文方法

3.1、ResNet和DenseNet中的Dense Connection

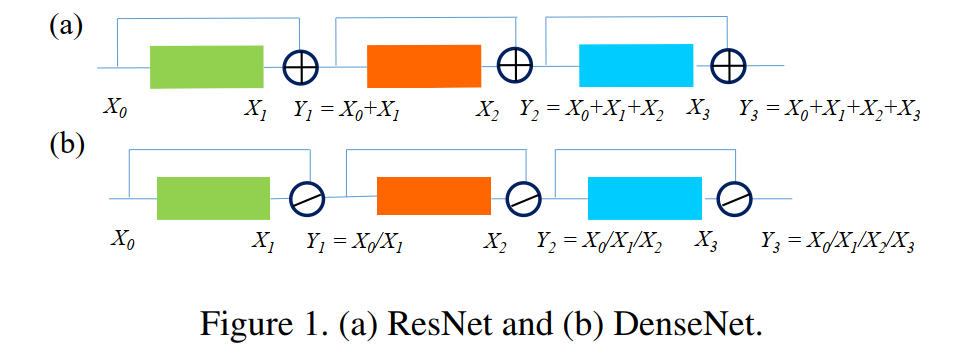

ResNet和DenseNet的区别是什么?顾名思义,区别似乎在于ResNet只使用前面的一个特征图,而DenseNet使用了前面所有卷积块的特性。

似乎结果像前面说的那样,而实际上通过上图可以看出ResNet与DenseNet的不同之处在于,ResNet采用求和的方法将之前所有的feature map连接起来,而DenseNet将所有feature map使用cat的方法连接起来。

3.2、Unified perspective with dense summation

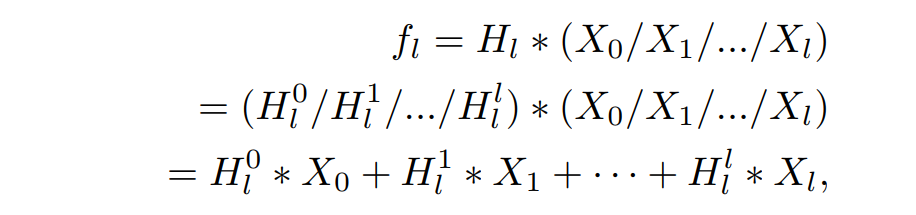

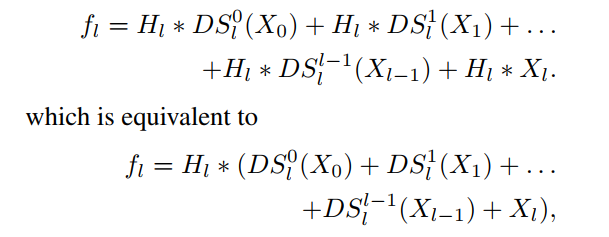

在这里,作者证明了卷积运算前的dense concatenation可以等价于卷积后的dense summation:

其中, ,注意, 表示卷积块中的第1个卷积,而不是整个卷积块。因此, 是卷积块中第1次卷积后的feature-map。综上所述,如图所示,其中 和 分别为输入通道数和输出通道数。

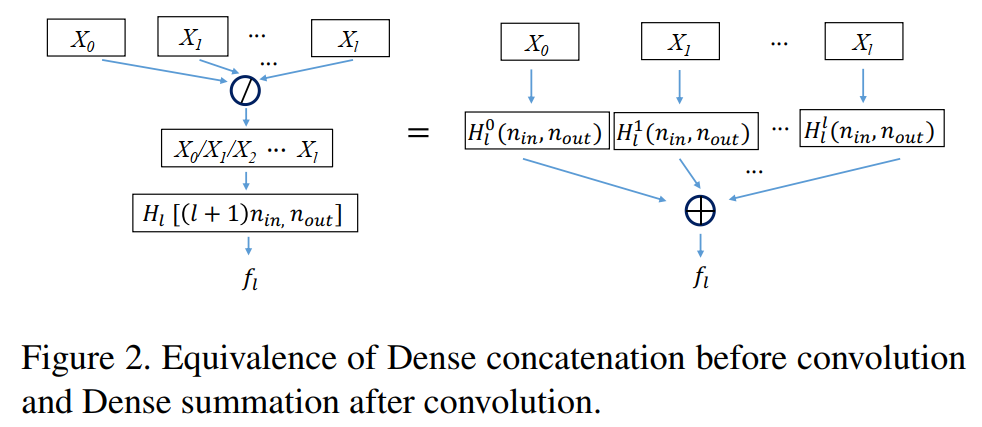

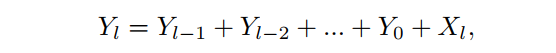

最终可以得到关于ResNet和DenseNet的如下表达式:

这个公式提供了一个更统一的视角来感知ResNet和DenseNet的相似之处。然而,通过比较DenseNet和ResNet的两个公式,阐述统一观点的主要目的是为了更好地理解它们的核心差异,展示它们的优缺点。通过对比式中DenseNet和ResNet的两个公式,发现主要区别在于ResNet中的卷积权

对于前一层输出

是相同的,而DenseNet中的

对于

是不同的。

该差异导致了实际使用中的其他差异。

中的输入通道

随着

的增加而增加,当

变大时,

通常大于ResNet的

。由于连接特性,

中的

通常非常小,但有更多的层。因此,DenseNet在实际应用中往往需要更多的训练时间。此外,导致大输入通道

的串联特性也需要更多的GPU内存。然而,DenseNet设计的优点是,由于每个

都是不同的,所以它在使用以前的特性映射时表现出了更大的灵活性。

但是,上式并没有反映它们的实际执行的情况(即

比更快;

比更加有效),以上的分析只是说明了两者之间的理论联系。

3.3、Dense shortcut and DSNet

通过以上统一可以看出ResNet和DenseNet的核心区别在于,对于前面的每个输出,卷积参数 是否共享。这使得DenseNet在需要更多GPU资源的情况下获得了更好的性能。这种差异的根源在于采用了不同的Dense Connection、identity shortcut和Dense Concatenation。基于上述的问题提出了一种可选择的Dense Connection来缓解该缺点。它引入了使用前面的feature-maps的灵活性,同时对前面的每个feature-map仍然使用相同的 。基于ResNet的Benchmask,文中提出的方法可以表达为:

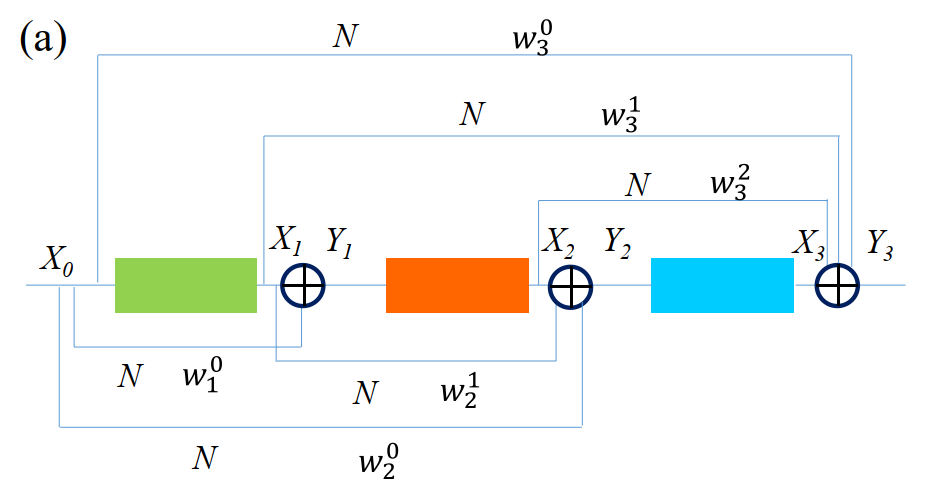

其中,DS()表示Dense ShortCut,它是指由Normalization和Channel wise加权组成的Normalized ShortCut(即,)。基于上式表达式的模型图如下:

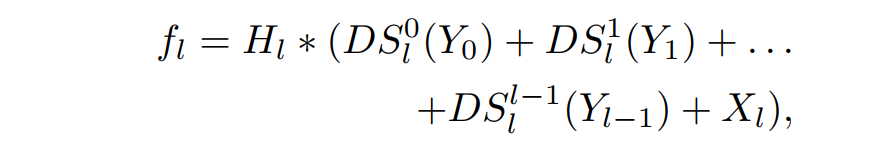

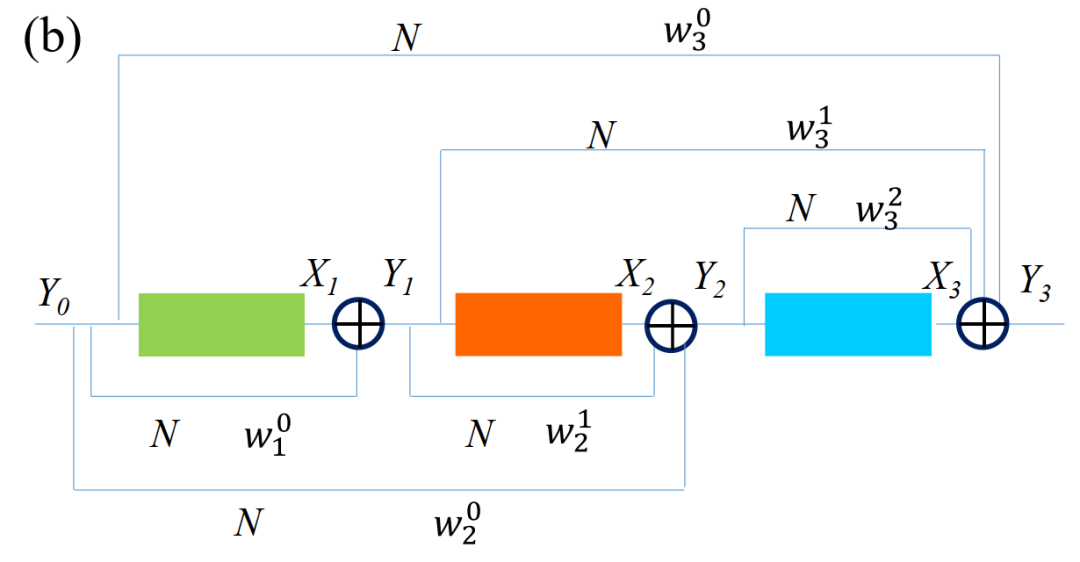

但是feature-map在aggregation输出 中包含的有用的特征比对应的单卷积块输出 更多,因此提出了另一种变体,将 替换为 :

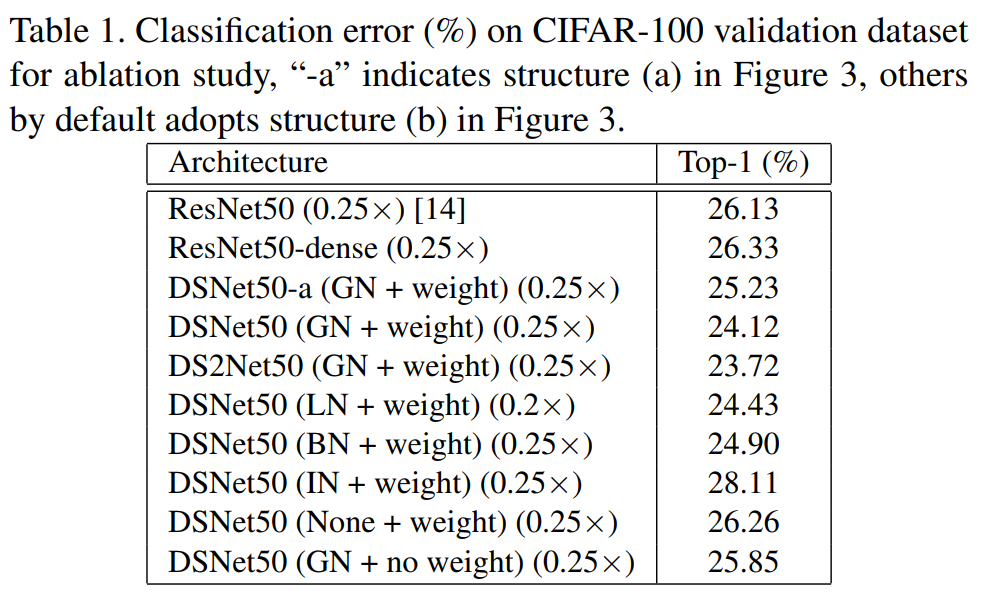

实验结果也证明了该结论的成立:

作者将所提出的网络命名为采用Adopting DS ShortCut的DSNet。DSNet采用与ResNet相同的网络Backbone(卷积块本身和块设计)。ResNet主干是为identity shortcut定制的,而不是为提出的DS ShortCut定制的。如果重新设计主干结构可能会进一步提高DSNet的性能。

注:DSNet和ResNet唯一区别是用提出的dense shortcut代替了identity shortcut.

3.4、实现插入方式

为了在ResNet中引入dense shortcut,一种简单的方法是将 中的单个identity shortcut替换为dense shortcut,从而连接所有前面的特征映射,得到:

可以递归地扩展为:

比较dense shortcut等价于在每个卷积块的末端增加额外的常数。表1中所示的ResNet50-Dense的这种设计并没有取得比原来的ResNet50更好的性能。于是便设计了DS ShortCut,而这里使用归一化的动机是为了将前面的所有特征归一化到一个相似的尺度,方便训练。加权求和是为了让网络根据特征图的显著性给每个归一化特征图分配适当的权值。

此外,在实验中发现,在3*3卷积的卷积块内插入weighted normalized shortcut也有助于性能的提高,由于增加的计算负担几乎很少,值得考虑。这里称之为DS2Net。

4、实验结果

4.1、基于CIFAR-100实验

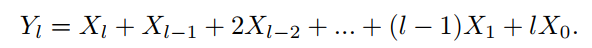

可以看出在CIFAR-100数据集上基于DS的设计,参数更少,精度更高;

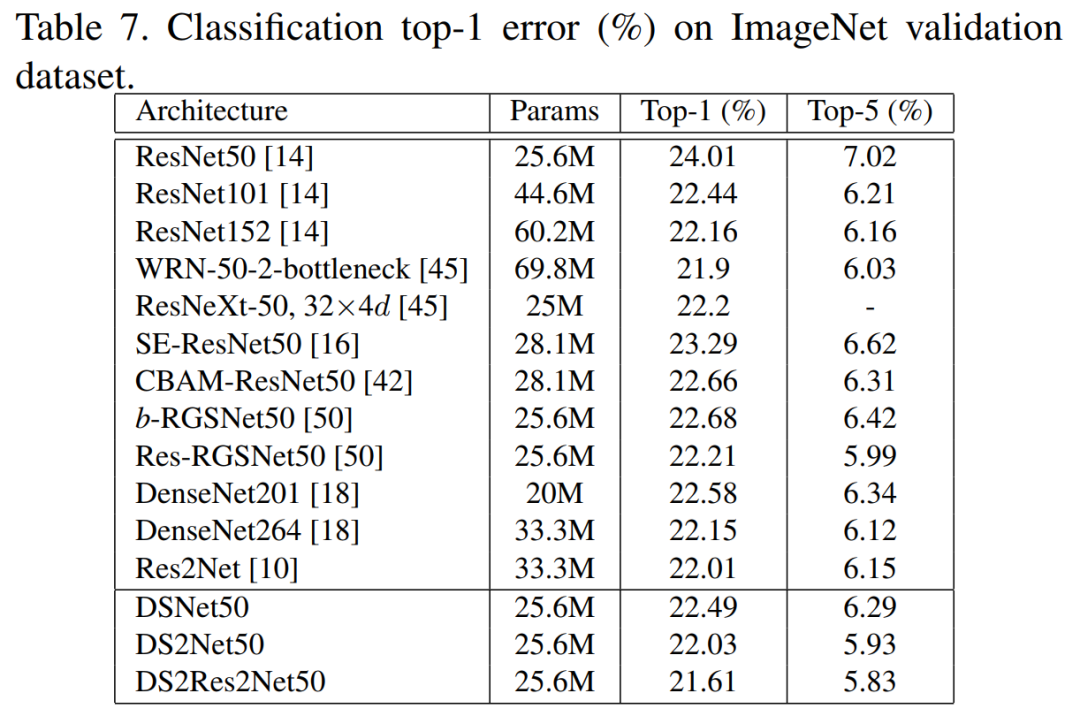

4.2、基于ImageNet实验

可以看出在ImageNet数据集上基于DS的设计,参数更少,精度更高;

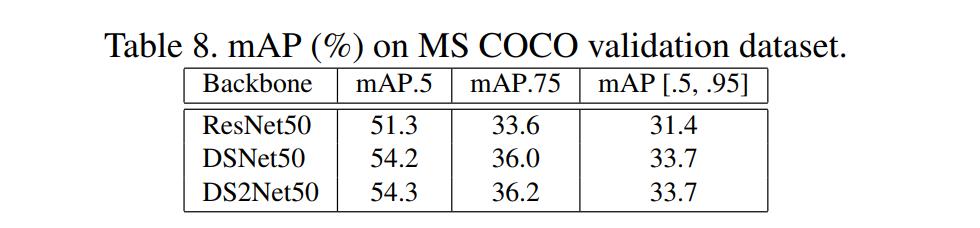

4.3、基于MS COCO 2014检测实验

可以看出在ResNet中使用DSNet提升mAP将近3个百分点;

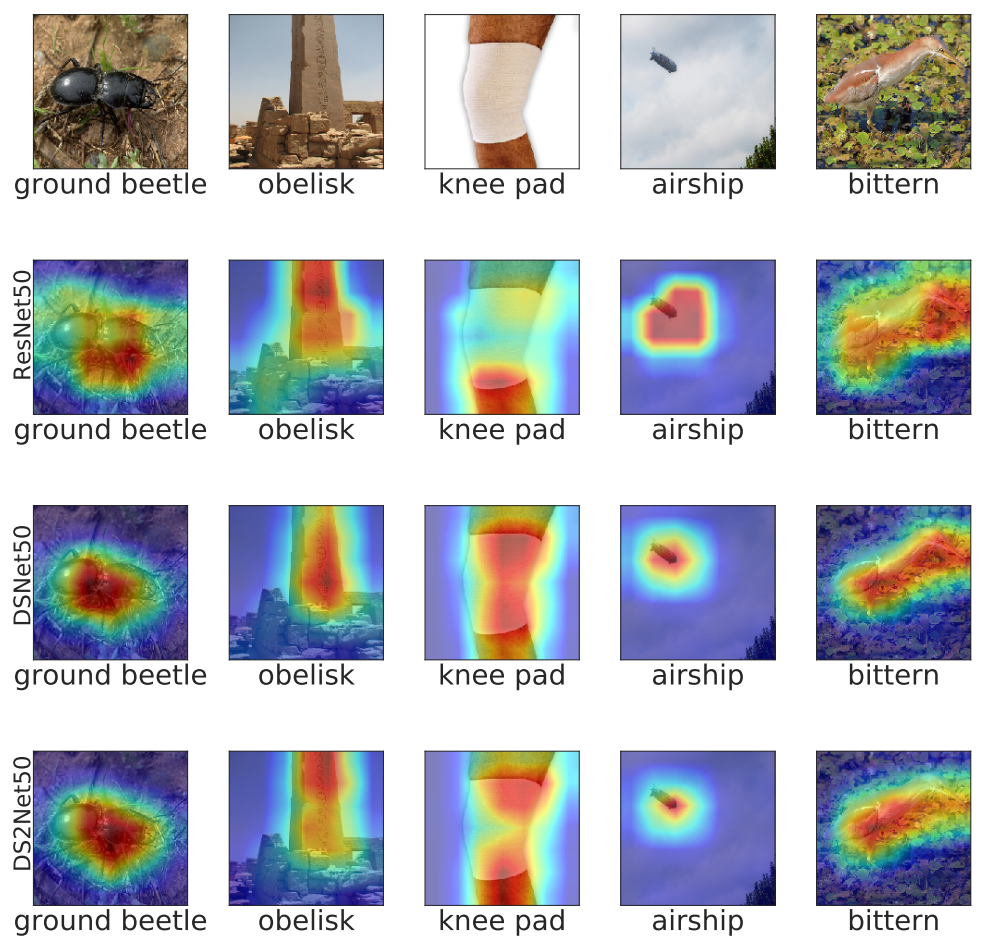

4.4、Grad-CAM可视化实验

可以看出对于DSNet,其对于目标的识别区域更加的准确和集中,也因此会带来更好的效果。

更为详细内容可以参见论文中的描述。

References

[1] ResNet or DenseNet? Introducing Dense Shortcuts to ResNet

论文PDF下载:

上述论文已打包好,在CVer公众号后台回复:DSNet,即可下载论文PDF,推荐阅读学习!

下载1

在CVer公众号后台回复:PRML,即可下载758页《模式识别和机器学习》PRML电子书和源码。该书是机器学习领域中的第一本教科书,全面涵盖了该领域重要的知识点。本书适用于机器学习、计算机视觉、自然语言处理、统计学、计算机科学、信号处理等方向。

PRML

下载2:CVPR / ECCV 2020开源代码

在CVer公众号后台回复:CVPR2020,即可下载CVPR 2020代码开源的论文合集

在CVer公众号后台回复:ECCV2020,即可下载ECCV 2020代码开源的论文合集

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2400+人,旨在交流顶会(CVPR/ICCV/ECCV/NIPS/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI/TIP等)、SCI、EI、中文核心等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加微信群

▲长按关注CVer公众号

整理不易,请给CVer点赞和在看!