【泡泡一分钟】GOMSF——基于多传感器融合的图优化无人机鲁棒位姿估计方法

每天一分钟,带你读遍机器人顶级会议文章

标题:GOMSF---Graph-Optimization Based Multi-Sensor Fusion for robust UAV Pose estimation

作者:Ruben Mascaro, Lucas Teixeira, Timo Hinzmann, Roland Siegwart and Margarita Chli

来源:2018 IEEE International Conference on Robotics and Automation (ICRA)

编译:黄思宇

审核:颜青松,陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

从内置或外置的传感器测量数据中得到精确的、高速率的位姿估计是对行动敏捷的移动机器人(如无人机UAV)进行导航算法研究的基础。

本文提出了一种解耦的基于多传感器融合的图优化方法(GOMSF),它结合6自由度的视觉惯性里程计的估计位姿和3自由度的全局位置来实时推断全局坐标系下的机器人6自由度位姿。该方法将融合问题视为局部视觉惯性里程计下的位姿和全局位置的实时对齐问题。对齐的坐标转换关系通过优化包含了最近几帧机器人状态的滑动窗口中的位姿图进行持续更新。

我们用小型UAV在仿真数据和大尺度的室外实验中评估了目前存在的位姿估计方法和本文方法,结果表明本文提出的方法在位姿估计方面基本比其他解耦的融合策略更加精确。我们也和紧耦合的融合了视觉、惯性测量单元和GPS测量的扩展卡尔曼滤波方法进行了比较,本文方法能在直接处理不同的输入资源的情况下得到和紧耦合方法相当的结果。

Video – https://youtu.be/GIZNSZ2soL8

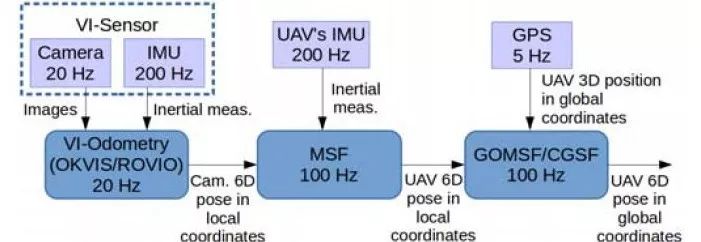

图1 提出的位姿估计系统--GOMSF的组成。

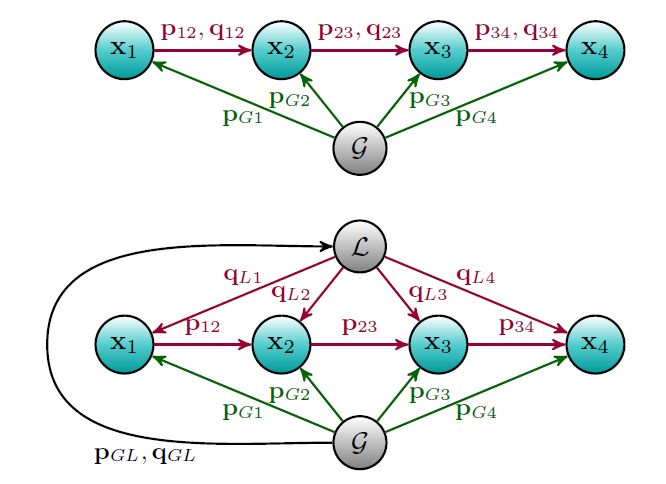

图2 传统图结构(上图)与本文提出的结构(下图)的比较。绿色箭头代表全局位姿测量产生的约束(GPS),红色箭头表示通过视觉惯性里程计的位姿估计。在我们的方法中视觉惯性里程计会产生两种类型的约束:连续节点的位置约束和在每个节点和虚拟L节点之间的方向约束。虚拟L节点跟踪视觉惯性里程计局部帧和全局参考帧之间的方向来提供先验,从而获得可靠的全局定位估计。

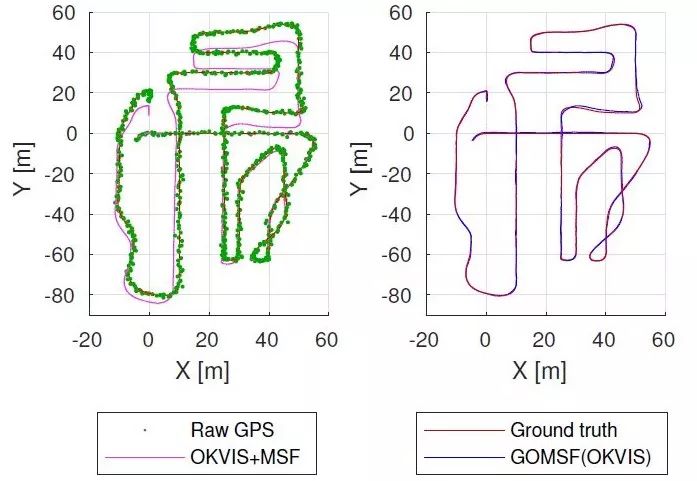

图3 本文提出的方法与OKVIS+MSF方法在轨迹估计上的对比。

Abstract

Achieving accurate, high-rate pose estimates from proprioceptive and/or exteroceptive measurements is the first step in the development of navigation algorithms for agile mobile robots such as Unmanned Aerial Vehicles (UAVs). In this paper, we propose a decoupled Graph-Optimization based Multi-Sensor Fusion approach (GOMSF) that combines generic 6 Degree-of-Freedom (DoF) visual-inertial odometry poses and 3 DoF globally referenced positions to infer the global 6 DoF pose of the robot in real-time. Our approach casts the fusion as a real-time alignment problem between the local base frame of the visual-inertial odometry and the global base frame. The alignment transformation that relates these coordinate systems is continuously updated by optimizing a sliding window pose graph containing the most recent robot’s states. We evaluate the presented pose estimation method on both simulated data and large outdoor experiments using a small UAV that is capable to run our system onboard. Results are compared against different state-of-the-art sensor fusion frameworks, revealing that the proposed approach is substantially more accurate than other decoupled fusion strategies. We also demonstrate comparable results in relation with a finely tuned Extended Kalman Filter that fuses visual, inertial and GPS measurements in a coupled way and show that our approach is generic enough to deal with different input sources in a straightforward manner.

Video – https://youtu.be/GIZNSZ2soL8

如果你对本文感兴趣,请点击点击阅读原文下载完整文章,如想查看更多文章请关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

百度网盘提取码:vst0

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/bbs/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com