最孤独的神经网络:只有一个神经元,但会「影分身」

![]()

新智元报道

新智元报道

编辑:LRS

【新智元导读】神经网络模型越训越大,也越来越费电。柏林工业大学的研究团队反其道行之,搞了一个单神经元的网络,能模拟多层神经网络,性能还不差!

要说世界上最先进的神经网络模型是什么?那绝对是人脑莫属了。

人脑有860亿个神经元,相互结合在一起构成的神经网络不仅在性能上超越人工神经网络,能量消耗也少的惊人。

当下的人工智能系统试图通过创建多层神经网络来模仿人脑,旨在将尽可能多的神经元塞进尽可能少的空间。

这种方式虽然取得了性能进步,但这样的设计不仅需要大量的电力,并且输出的结果与人脑相比也是相形见绌。

根据估计,OpenAI在微软数据中心使用 Nvidia GPU 训练神经网络GPT-3时,大约需要 190,000 千瓦时的电量,相当于丹麦 126 户家庭每年使用的电量。如果换算成化石燃料产生的二氧化碳含量来算,相当于驾驶一辆汽车从地球出发往返一趟月球。

并且神经网络以及使用巨大数据集训练它们所需的硬件数量,还在不断增长。以GPT为例,在GPT-3时已经有1750亿个参数了,比前身GPT-2的参数量要多100倍。

这种「越大越好」的神经网络设计显然不符合可持续的科学发展观。

来自柏林工业大学的一个多学科研究小组最近创建了一个新型神经「网络」。但叫它网络还是比较勉强的,因为它新就新在,只有一个神经元!

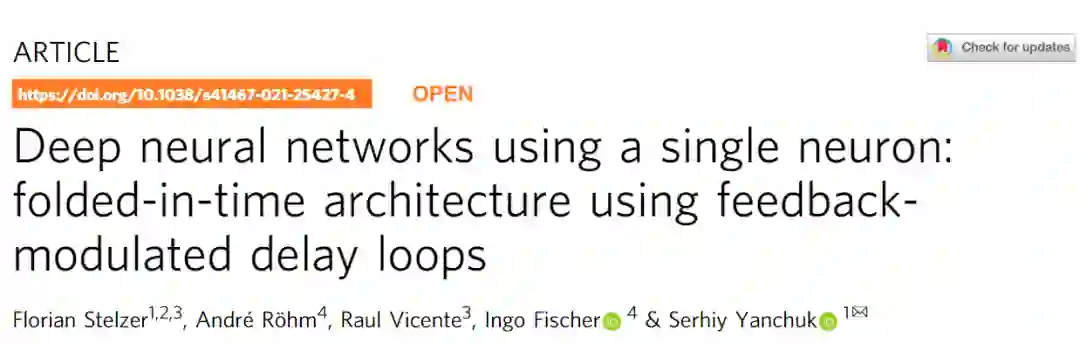

研究人员提出一种新的方法,能够将一个任意大小的深度神经网络折叠成一个具有多个延时反馈的单一神经元循环。这个单神经元深度神经网络只包括一个单一的非线性和适当地调整反馈的信号,可以完全表示标准的深度神经网络(DNN),包含稀疏DNN,和将DNN的概念扩展到动态系统的实现。

这个新模型也称为时间折叠(Folded-in-time) Fit-DNN,在基准任务的测试中也表现出相当强的性能。

独木难成林?

独木难成林?

一个常规的神经网络网络需要在空间上申请多个节点彼此连接,而单个神经元模型则是在时间维度上进行扩散连接。

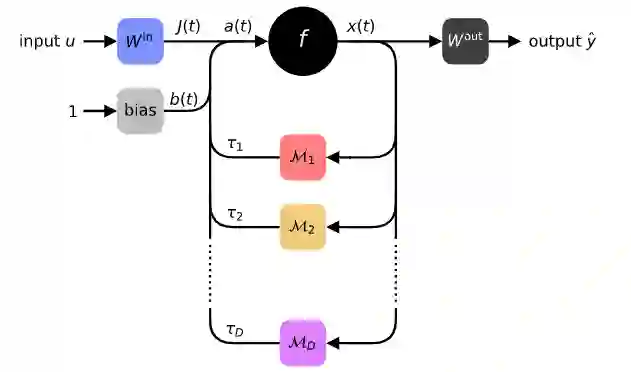

研究人员设计的多层前馈DNN的完全时间折叠的方法,只需要一个带有反馈调节延迟环的单一神经元。通过非线性操作的时间顺序化,可以实现一个任意深度或宽度的DNN。

在传统的神经网络中,如GPT-3,每个神经元都有一个权重值,以便对结果进行微调。但这种方式导致的结果通常是更多的神经元,产生更多的参数,而只有更多的参数才能产生更精确的结果。

但柏林工业大学的团队发现,他们可以通过在不同时间对同一神经元进行不同的加权,而不是在空间上分散不同加权的神经元来实现类似功能。

这就好比在宴会上,你可以通过快速切换座位的方式,装作不同的客人说出不同的部分来模拟餐桌上的对话。

听起来有点「人格分裂」,但通过这种时序上的扩展,一个人(神经元)也可以完成多个人才能完成的事。

刚才提到「快速」切换,柏林团队表示,这种说法已经很低调了。

实际上他们的系统通过激光在神经元中激活基于时间的反馈回路,理论上可以达到接近宇宙极限的速度——也就是以光速或接近光速进行神经网络切换。

根据研究人员的说法,这对人工智能来说意味着,能够显著降低训练超大规模神经网络的能源成本。

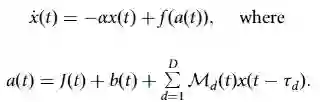

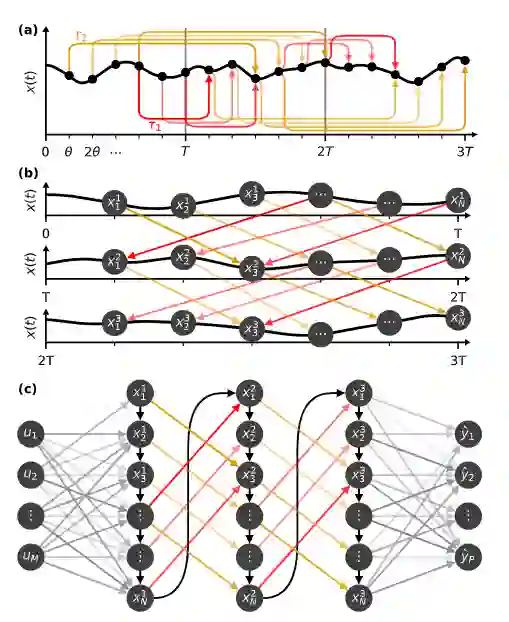

为了实现上述想法,研究人员假设系统状态根据一般形式的微分方程在连续时间内演变。

这里x(t)表示神经元在时间t的状态;f是一个非线性函数,其参数a(t)结合了数据信号J(t)、时间变化的偏置b(t)以及由函数Md(t)调制的延时反馈信号x(t -τd)。可以明确考虑不同延迟长度τd的多个环路。由于反馈环路,系统成了一个所谓的延迟动力系统。

直观地说,Fit-DNN中的反馈回路导致神经元重新引入已经通过非线性f的信息,这使得非线性f可以多次连锁。经典的DNN通过逐层使用神经元来构成其可训练的表征,而Fit-DNN则通过重复向同一神经元引入反馈信号来实现同样的目的。

在每个pass中,时变的偏置b(t)和延迟线上的调制Md(t)确保系统的时间演变以期望的方式处理信息。为了获得数据信号J(t)和输出y,两个变量都需要一个适当的前处理或后处理操作。

为了进一步说明Fit-DNN在功能上等同于多层神经网络,可以看到Fit-DNN可以将具有多个延迟环的单个神经元的动态性转化为DNN。

x(t)的时间演化可以分为长度为T的时间间隔,每个间隔模拟一个隐藏层。在每个区间中,选择N个点。使用一个具有小时间间隔θ的等距时间网格。对于有N个节点的隐藏层来说,可以得出θ=T/N。在每个时间网格点tn=nθ,将系统状态x(tn)作为一个独立变量。每个时间网格点tn将代表一个节点,而x(tn)代表其状态。可以进一步假设数据信号J(t)、偏置b(t)和调制信号Md(t)是步长为θ的步长函数。

作为一个非常稀疏的网络,研究人员首先将Fit-DNN应用于图像去噪任务:在Fashion-MNIST数据集的图像中加入强度为方差为1的高斯噪声,将其视为值在0(白色)和1(黑色)之间的向量。然后截断阈值0和1处剪切所得到的向量条目,以获得有噪声的灰度图像。去噪的任务就是要从其噪声版本中重建原始图像。

实验结果对比了原始Fashion-MNIST图像、其噪声版本和重建图像的例子。可以看到恢复的效果还是相当不错的。

但Fit-DNN真正的问题是,时间循环的单个神经元是否能产生与数十亿个神经元相同的结果。

为了证明Fit-DNN和时间状态下的计算能力,研究人员选了五个图像分类任务:MNIST40、Fashion-MNIST41、CIFAR-10、CIFAR-100,以及SVHN。

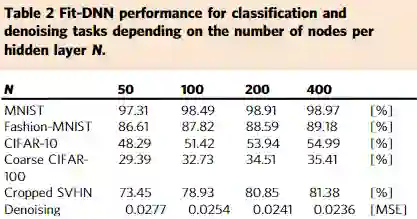

实验对比了Fit-DNN在上述任务中每个隐藏层的不同节点数N=50、100、200和400时的表现。从结果中可以看到对相对简单的MNIST和Fashion-MNIST任务上单个神经元取得了很高的准确率。但对于更具挑战性的CIFAR-10、CIFAR-100和SVHN任务的准确率则比较低。

虽然这些结果显然不能与当下sota模型创造的性能记录相媲美,但它们是在一个新颖的、完全不同的架构上实现的。特别是,这里的Fit-DNN只使用了权重矩阵可用对角线的一半。对于测试的任务,增加N显然会导致性能的提高。

随着进一步的发展,科学家们相信该系统可以扩展到时间维度上「无限数量的」神经元连接。

他们表示,这样的系统是可行的,它可以超越人脑,成为世界上最强大的神经网络,这就是人工智能专家所说的「超级智能」。

参考资料:

https://thenextweb.com/news/how-ai-brain-with-only-one-neuron-could-surpass-humans

https://www.nature.com/articles/s41467-021-25427-4.pdf