对抗样本引发的系列讨论

所谓对抗性样本,指的是对于训练好的神经网络(比如是训练好神经网络用作图片分类) ,随便拿一张能被网络正确分类的图片 ,人为的对图片的像素加一些很小的扰动 (perturbation),神经网络会以很大的概率将perturbed的图片 分类错误,即

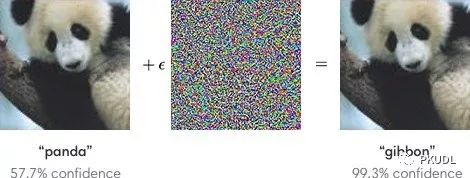

,重要的是扰动后的图片人眼是不会分类错误的,甚至都无法察觉加了扰动。比如下图将一个大熊猫的图片进行很小的扰动就会将其分类为长臂猿。也就说明当今被人们广为称道的深度学习模型是如此的脆弱不堪。

注意这个小扰动 不是一个随便的扰动,而是解一个优化问题得到的扰动,我们称为这个求解过程为攻击网络,这也是被称为对抗性样本的原因。

原文链接:

https://mp.weixin.qq.com/s/H1xapBTuImocpnAoT0bIow

登录查看更多

相关内容

对抗样本由Christian Szegedy等人提出,是指在数据集中通过故意添加细微的干扰所形成的输入样本,导致模型以高置信度给出一个错误的输出。在正则化背景下,通过对抗训练减少原有独立同分布的测试集的错误率——在对抗扰动的训练集样本上训练网络。

对抗样本是指通过在数据中故意添加细微的扰动生成的一种输入样本,能够导致神经网络模型给出一个错误的预测结果。

实质:对抗样本是通过向输入中加入人类难以察觉的扰动生成,能够改变人工智能模型的行为。其基本目标有两个,一是改变模型的预测结果;二是加入到输入中的扰动在人类看起来不足以引起模型预测结果的改变,具有表面上的无害性。对抗样本的相关研究对自动驾驶、智能家居等应用场景具有非常重要的意义。