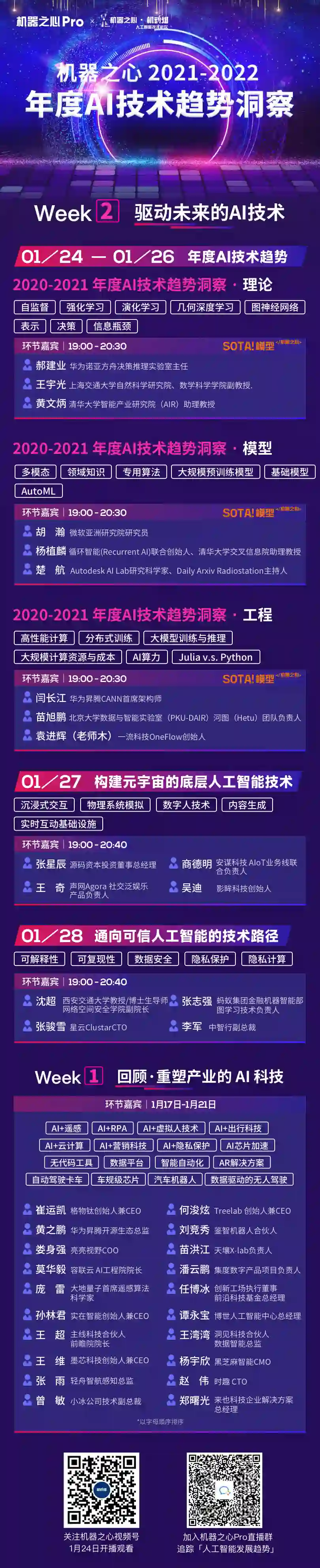

通用(大)模型的最后一公里:ETA计算中

- 「基础模型(foundation model)」是否将成为下一个 AI 范式?

- 「基础模型(foundation model)」的出现是否意味着距离实现「通用模型」只剩最后一公里的路程的?

- 针对细分应用领域,例如生化领域等,搞「专用模型」是否还有未来价值?「专用模型」又有哪些不一样的玩法?

胡瀚,微软亚洲研究院研究员

陈虞君,循环智能(Recurrent AI)人工智能部门资深算法总监

楚航,Autodesk AI Lab 研究科学家、Daily Arxiv Radiostation 主持人

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月15日