【CMU博士论文】强化学习可解释:统一状态和策略级解释,132页pdf

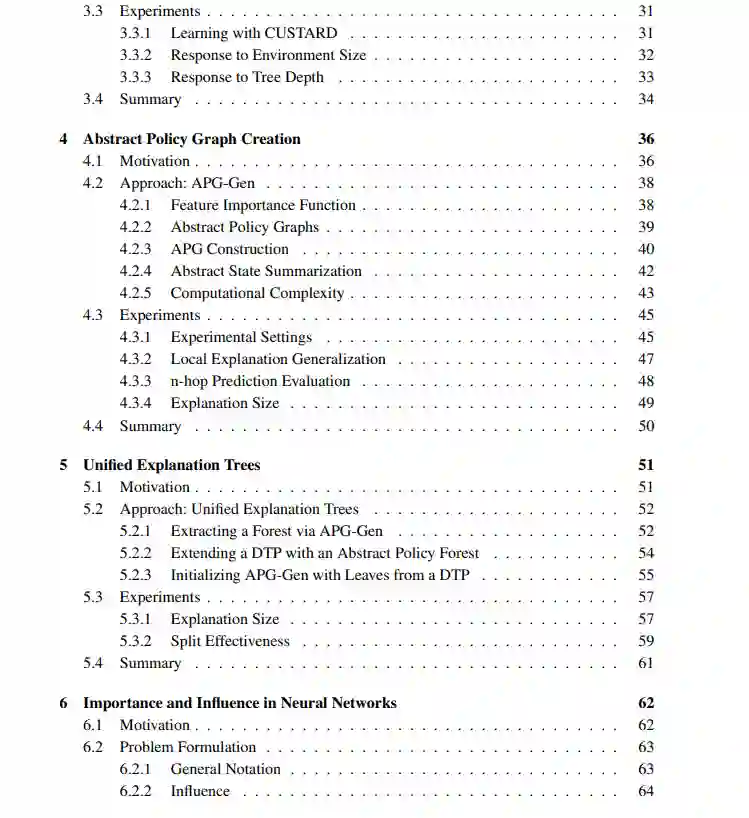

强化学习(RL)能够在不需要学习领域动态模型的情况下求解领域。当与神经网络作为函数逼近器相结合时,RL系统可以解决复杂问题。然而,由于这些特性,验证和预测RL智能体的行为变得困难;一个博学的策略传达的是“做什么”,而不是“为什么”。本文专注于对深度强化学习进行解释,总结可用于下游分析的行为及其原因。具体来说,我们将重点放在从与环境的有限的已知交互集合中获得最终策略的设置上。我们将现有的解释方法分为两个方向:

1. 方法是解释单一动作行为还是策略级行为

2. 一种方法是否根据状态特征或过去的经验提供解释

在这种分类下,有四种类型的解释方法,它们能够回答关于智能体的不同问题。我们将介绍创建这些类型的解释的方法。此外,我们引入了一个统一的解释结构,它是所有四种类型的组合。这种结构能够获得关于智能体已经学习到什么以及它为什么这样做的进一步信息。

首先,我们介绍了CUSTARD,这是我们用状态特征解释单一动作行为的方法。CUSTARD的解释是策略的决策树表示。与生成这种决策树的现有方法不同,CUSTARD在训练后直接学习树而不近似策略,并且与现有的RL技术兼容。

然后我们介绍了APG-Gen,这是我们根据状态特征创建策略级行为解释的方法。APG-Gen在抽象状态上生成马尔可夫链,从而能够预测未来的行动和未来状态的各个方面。APG-Gen只查询智能体的Q值,对智能体的决策过程不做任何假设。

我们将这两种方法集成起来,生成统一解释树(UET)。UET是一棵从状态直接映射到操作和抽象状态的树,因此在状态特征方面统一了单个操作和策略级行为解释。

我们扩展了在深度神经网络中寻找重要训练点的现有工作。我们的方法,MRPS,根据过去的经验来解释单一动作行为。MRPS可以为点集找到重要值,并考虑特征的大小,从而产生更有意义的重要值。最后,我们找到UET中任何节点的过去经验集的重要值。此外,我们还介绍了计算UET节点的近似和精确影响的方法。由于UET既传达单一行为又传达策略级行为,因此这些重要性和影响值根据过去的经验解释了这两个级别的行为。我们的整体解决方案支持识别UET的部分,如果从智能体使用的集合中删除或添加特定的经验,则该部分将发生更改。

便捷下载,请关注专知人工智能公众号(点击上方关注)

点击“发消息” 回复 “RL132” 就可以获取《【CMU博士论文】强化学习可解释:统一状态和策略级解释,132页pdf》专知下载链接