【AAAI2022】基于分层随机注意的Transformer 不确定性估计

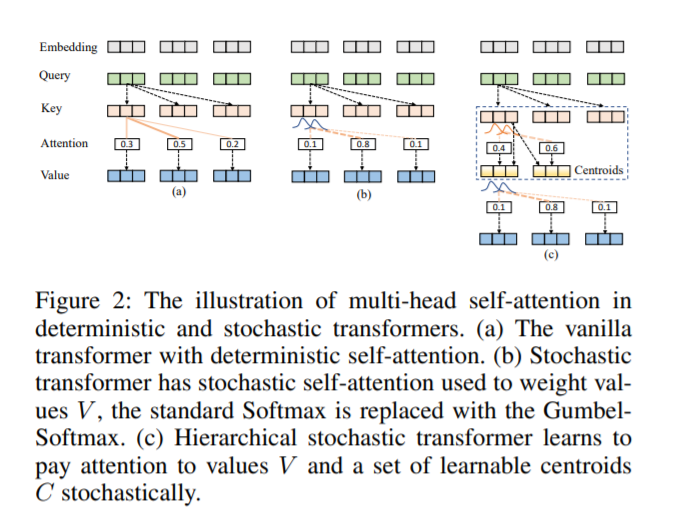

Transformers 在许多NLP任务中都是最先进的,并且也被应用到许多现实世界的产品中。理解变压器模型预测的可靠性和确定性对于构建可靠的机器学习应用(如医疗诊断)至关重要。虽然最近提出了许多Transformer的扩展,但对Transformer模型的不确定性估计的研究还不够深入。在本工作中,我们提出了一种新的方法,使Transformer具有不确定性估计的能力,同时,保持原有的预测性能。这是通过学习一个分层随机的自注意力来实现的,它分别关注值和一组可学习的质心。然后使用Gumbel-Softmax方法,将采样的质心混合形成新的注意力头。从理论上证明了从Gumbel分布中抽样得到的自注意力近似是有上界的。在两个具有域内(ID)和域外(OOD)数据集的文本分类任务上,我们实证地评估了我们的模型。实验结果表明,该方法具有较好的预测性能和不确定性权衡;(2)在ID数据集上表现出非常有竞争力的(在大多数情况下是改进的)预测性能;(3)在OOD数据集的不确定度估计方面与蒙特卡罗dropout和集成方法相当。

https://www.zhuanzhi.ai/paper/adbc5e805b7d14d200f7242d9815a3cf

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“HSAT” 就可以获取《【AAAI2022】基于分层随机注意的Transformer 不确定性估计》专知下载链接

登录查看更多

相关内容

Arxiv

21+阅读 · 2020年12月17日