Yoshua Bengio 指出的未来方向 GFlowNets 与现有的生成模型有什么关系?

生成流网络(GFlowNets)是图灵奖得主 Yoshua Bengio 对 AI 领域未来方向提出的想法。GFlowNets 基于强化学习、深度生成模型和概率建模,涉及变分模型及推断,为非参数贝叶斯建模、生成式主动学习以及抽象表征的无监督或自监督学习打开了新的大门。去年,Bengio 以一作的身份发表了长达 70 页的论文《GFlowNet Foundations》。

GFlowNets 灵感来源于信息在时序差分 RL 方法中的传播方式(Sutton 和 Barto,2018 年)。两者都依赖于 credit assignment 一致性原则,它们只有在训练收敛时才能实现渐近。由于状态空间中的路径数量呈指数级增长,因此实现梯度的精确计算比较困难,因此,这两种方法都依赖于不同组件之间的局部一致性和一个训练目标,即如果所有学习的组件相互之间都是局部一致性的,那么我们就得到了一个系统,该系统可以进行全局估计。

现在,Bengio 及其学生张鼎怀等发表了一篇新论文《Unifying Generative Models with GFlowNets》,简要介绍了现有深度生成模型与 GFlowNet 框架之间的联系,阐明了它们的重叠特征,并通过马尔可夫轨迹学习的视角提供了一个统一的观点,并进一步提供了一种统一训练和推理算法的方法。

![]()

论文地址:https://arxiv.org/abs/2209.02606

论文主要内容分成 6 个部分:

第二部分是 Hierarchical VAE (HVAE),这是一类重要的生成模型。本文基于分析发现:HVAE 和 GFlowNets 之间存在细微差别,基于此他们得出两个观察:一是在某种定义下,HVAE 是一种特殊的 GFlowNets;另一个是两者在训练方式上,存在一些相似性。

第三部分是扩散模型 & SDE( stochastic differential equatio ):扩散模型也是一类重要的生成模型,是受非平衡热力学的启发,其与 VAE 或流动模型不同,扩散模型是用固定的程序学习的;而 SDE 可以看做是生成模型当中的一项重要技术。本文发现:在某种意义上,SDE 是 GFlowNets 的一种特殊情况,本文将随机过程特性和 GFlowNets 特性之间进行类比。

第四部分是精确似然模型,这里介绍了自回归模型(AR 模型),这是最常见的平稳时间序列模型之一,本文发现 AR 模型可以被视为 GFlowNets,此外,本文还发现 NF(归一化流)也是一种特殊的 GFlowNets。

第五部分是从数据中学习奖励函数,本文认为基于能量的模型(EBM)可以用作 GFlowNets 训练的 (负对数) 奖励函数,可以使用任何 GFlowNets 建模,并将其与 EBM 一起训练。

第六部分为总结,该论文将现有的生成模型解释为在样本轨迹上具有不同策略的 GFlowNets。这提供了一些关于现有生成建模框架之间重叠的见解,以及它们与用于训练它们的通用算法的联系。此外,这种统一意味着一种构建不同类型生成建模方法聚合的方法,其中 GFlowNets 充当易于处理的推理和训练的通用粘合剂。

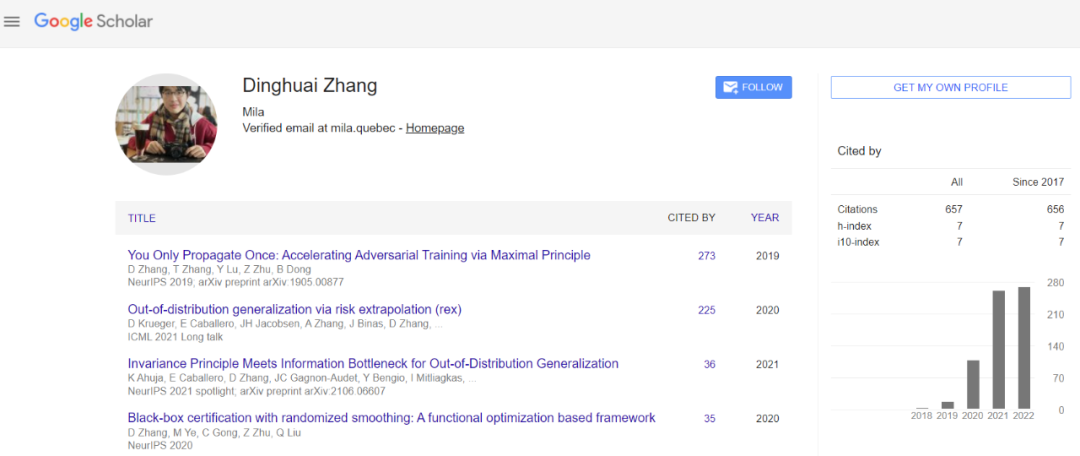

这篇论文的一作是蒙特利尔学习算法研究所(Mila)的博士生张鼎怀,导师是 Bengio 和 Aaron Courville。他的研究兴趣包括因果推理、分布外泛化、贝叶斯推理、生成模型、强化学习和主动学习等。

![]()

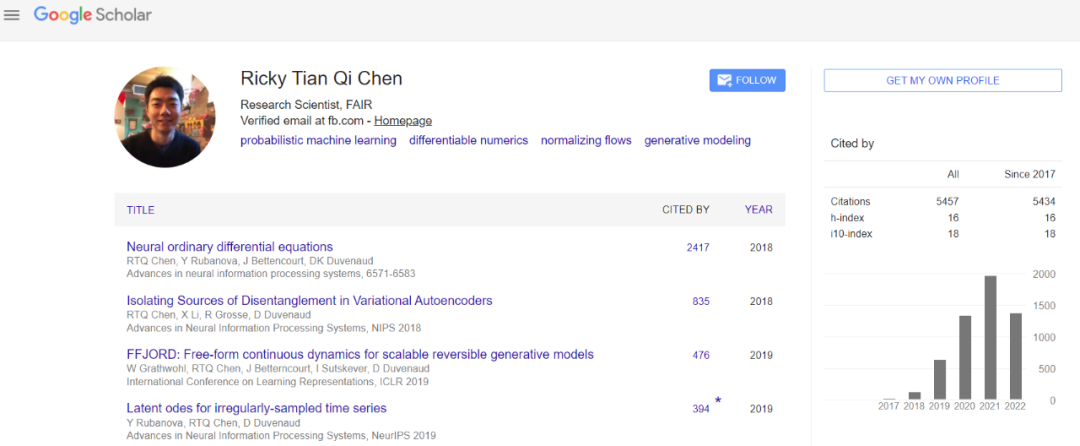

第二作者陈天琦是多伦多大学博士,现在是 Meta AI 的研究科学家。2018 年,陈天琦等人的论文《Neural Ordinary Differential Equations》获得 NeurIPS 最佳论文奖,引起了极大关注。他的主要研究兴趣是概率深度学习。

![]()

第三作者 Nikolay Malkin 是 Mila 的博士后研究员,另一位作者是图灵奖得主 Yoshua Bengio。

感兴趣的读者可以阅读论文原文,了解更多研究内容和理论细节。

参考链接:https://zhuanlan.zhihu.com/p/499206074

掌握「声纹识别技术」:前20小时交给我,后9980小时……

《声纹识别:从理论到编程实战》中文课上线,由谷歌声纹团队负责人王泉博士主讲。

课程视频内容共 12 小时,着重介绍基于深度学习的声纹识别系统,包括大量学术界与产业界的最新研究成果。

同时课程配有 32 次课后测验、10 次编程练习、10 次大作业,确保课程结束时可以亲自上手从零搭建一个完整的声纹识别系统。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com