论文是图灵奖获得者 Yoshua Bengio 对 AI 领域未来的方向提出的新想法——名为「生成流网络」(Generative Flow Networks,GFlowNets)的重要概念。

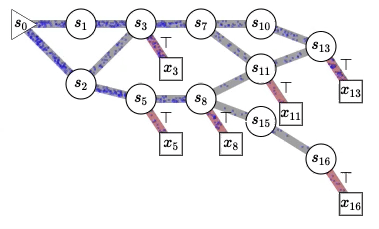

GFlowNets 灵感来源于信息在时序差分 RL 方法中的传播方式(Sutton 和 Barto,2018 年)。两者都依赖于 credit assignment 一致性原则,它们只有在训练收敛时才能实现渐近。

由于状态空间中的路径数量呈指数级增长,因此实现梯度的精确计算比较困难,因此,这两种方法都依赖于不同组件之间的局部一致性和一个训练目标,即如果所有学习的组件相互之间都是局部一致性的,那么我们就得到了一个系统,该系统可以进行全局估计。

本文为主动学习场景提供了形式化理论基础和理论结果集的扩展,同时也为主动学习场景提供了更广泛的方式。

GFlowNets 可以应用于:对集合和图进行一般概率运算,例如可以处理较难的边缘化问题,估计配分函数和自由能,计算给定子集的超集条件概率,估计熵、互信息等。

成为VIP会员查看完整内容

相关内容

Yoshua Bengio是蒙特利尔大学计算机科学与运筹学系的教授,Mila和IVADO的科学总监和创始人,2018年图灵奖获得者,加拿大统计学习算法研究主席以及加拿大AI CIFAR主席。 他开创了深度学习的先河,并在2018年每天获得全球所有计算机科学家中最多的引用。 他是加拿大勋章的官员,加拿大皇家学会的成员,并于2017年被授予基拉姆奖,玛丽·维克多奖和年度无线电加拿大科学家,并且是NeurIPS顾问的成员。 ICLR会议的董事会和联合创始人,以及CIFAR“机器和大脑学习”计划的程序总监。 他的目标是帮助发现通过学习产生智力的原理,并促进AI的发展以造福所有人。

https://mila.quebec/en/yoshua-bengio/

专知会员服务

106+阅读 · 2019年12月11日

Arxiv

1+阅读 · 2022年4月18日

Arxiv

10+阅读 · 2021年10月4日

Arxiv

10+阅读 · 2018年4月11日