【NeurIPS 2019演讲解读】Yoshua Bengio:如何用深度学习来实现System2?

新智元推荐

【新智元导读】图灵奖得主Yoshua Bengio在NeurIPS 2019的报告提到了几个非常有意思的观点,例如,人的认知系统包含两个子系统,system1直觉系统和system2逻辑分析系统,并解释了如何用深度学习来实现system2。本文带来清华大学唐杰教授对Bengio报告的重新解读。戳右边链接上 新智元小程序 了解更多!

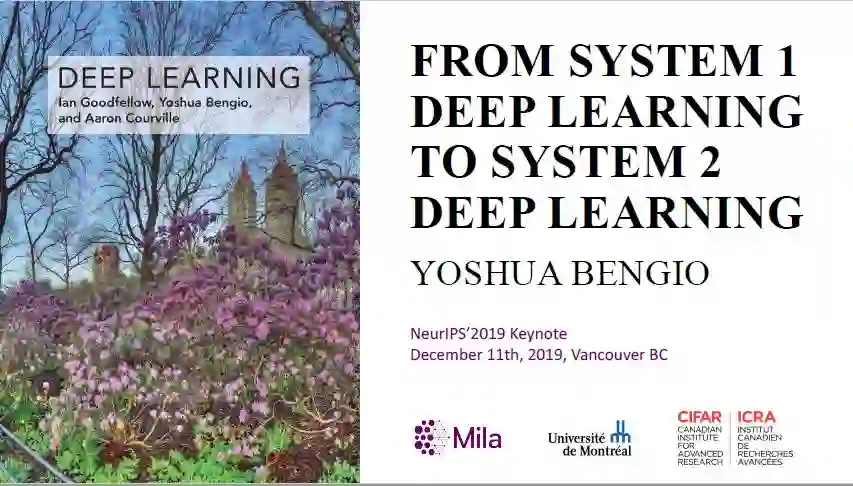

近日, 图灵奖得主Yoshua Bengio在NeurIPS 2019带来一场题为《From System 1 Deep Learning To System 2 Deep Learing》的报告,提到了几个非常有意思的观点。

本文为大家带来Yoshua Bengio的报告详解。

报告地址:

https://nips.cc/Conferences/2019/Schedule?showEvent=15488

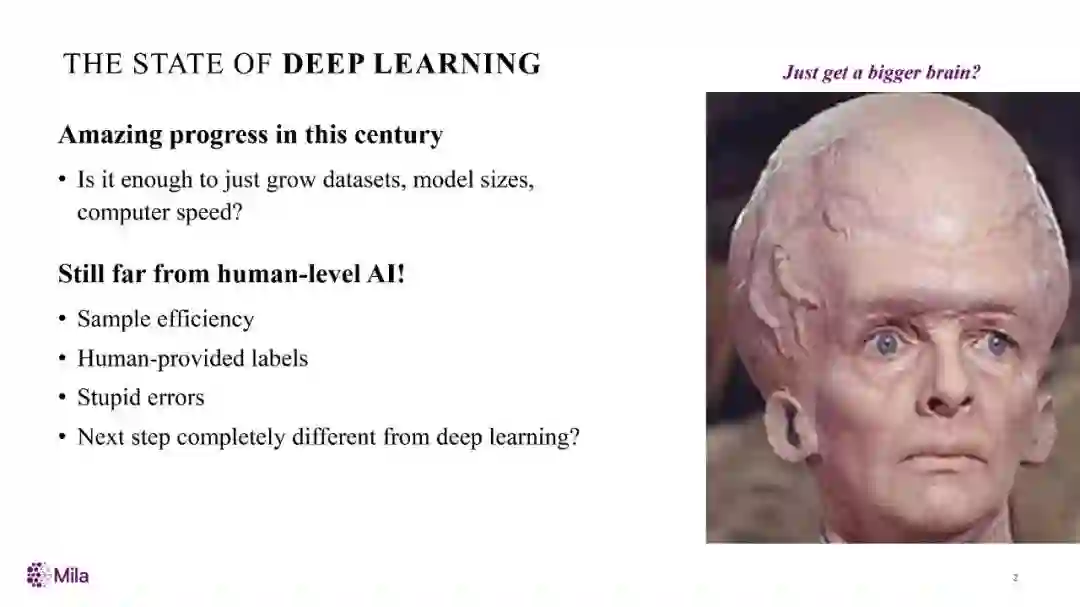

Yoshua认为,AI作为本世纪的惊人进步,仅仅依靠增加数据集、模型大小、电脑速度是否就足够了呢?实际上AI距真正的人工智能还差的很远!

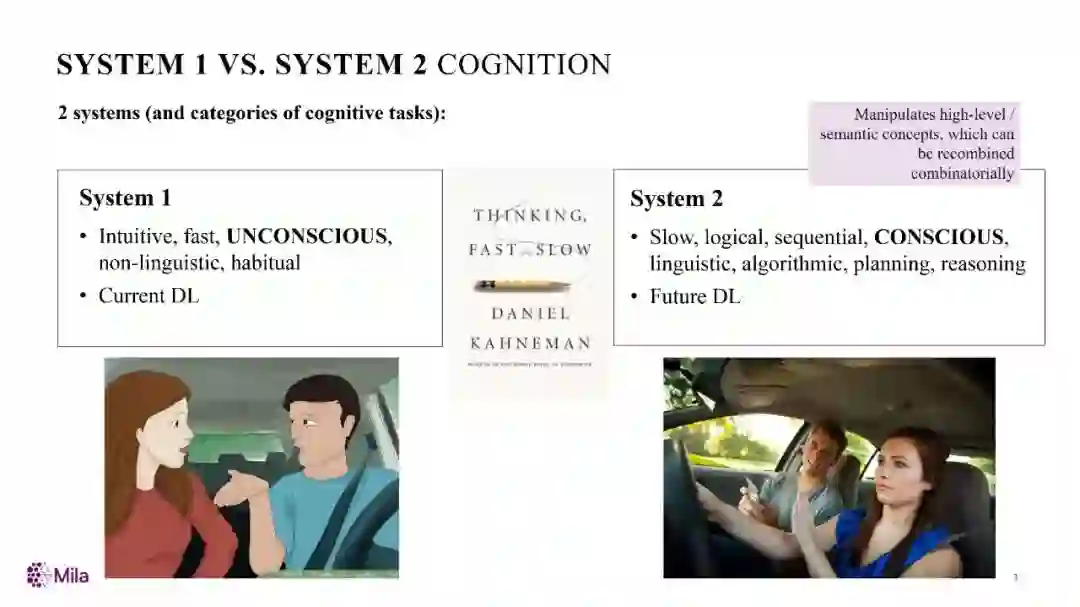

Yoshua的第一个观点,是指人的认知系统包含两个子系统(这是认知理论中大家共识的观点):System1直觉系统,主要负责快速、无意识、非语言的认知,这是目前深度学习主要做的事情;System2是逻辑分析系统,是有意识的、带逻辑、规划、推理以及可以语言表达的系统,这是未来深度学习需要着重考虑的。当然Yoshua也提到计算机作为Agent实现AI,需要从计算机角度考虑,比如更好的模型和知识搜索等。

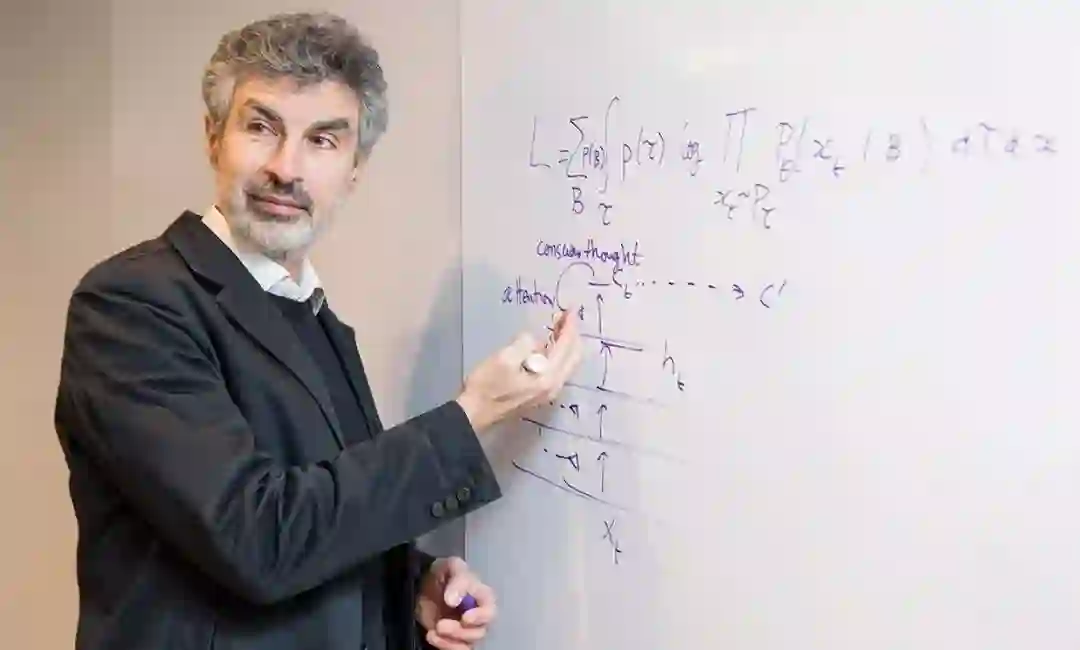

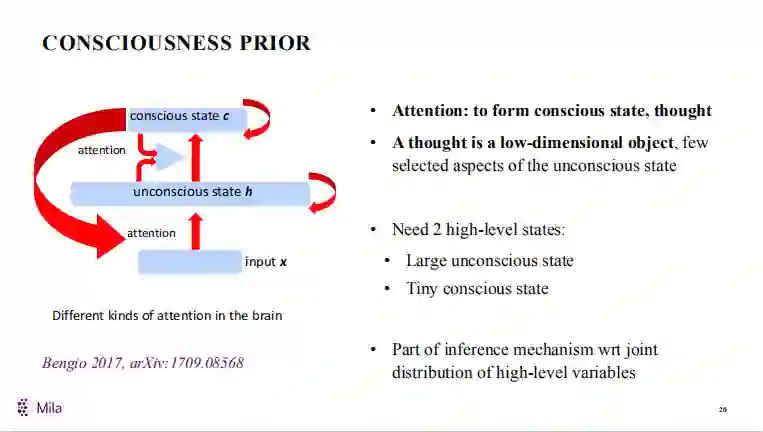

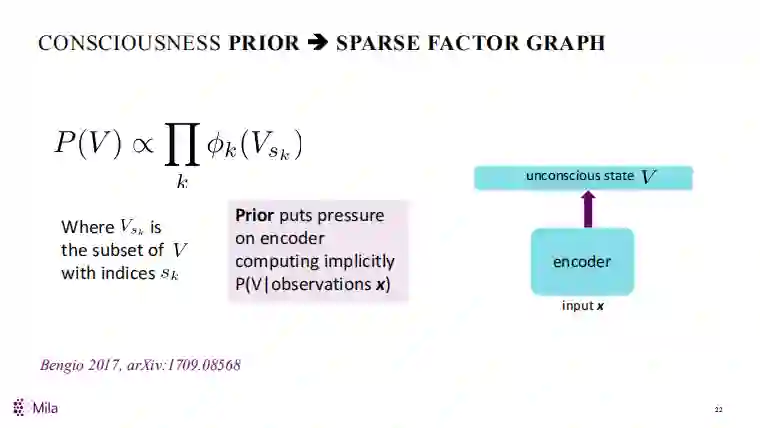

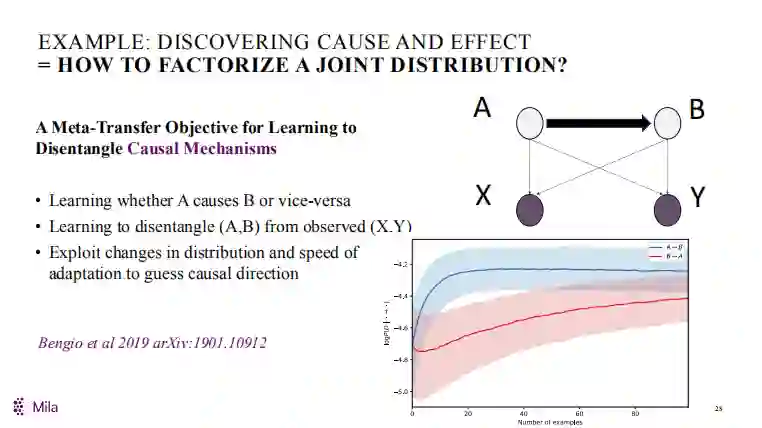

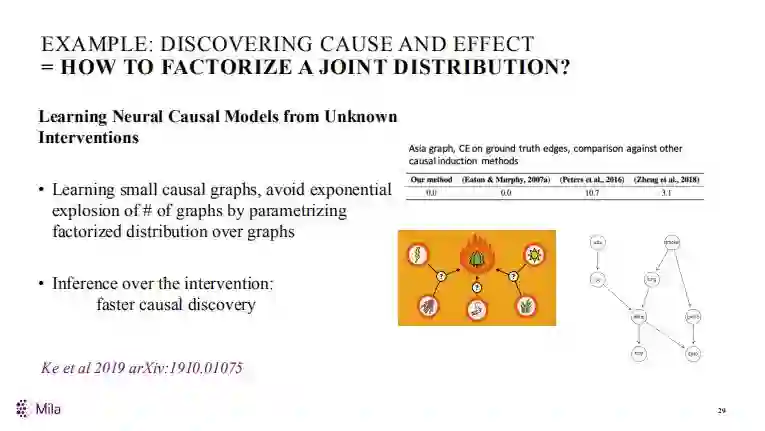

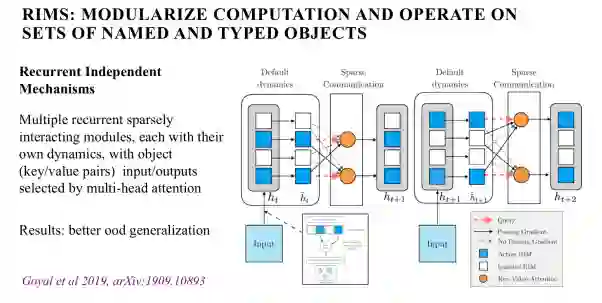

Yoshua认为,对于计算机来说,最关键的是处理数据分布中的变化。对于System 2来说,基本的要素包括:注意力和意识。注意力(Attention)实际在目前的深度学习模型中已经有大量的实现和探讨,比如GAT(图注意力机制)等;意识这部分则比较难,其实意识最关键的是定义到怎样的边界。Yoshua提到意识先验可以使用稀疏因子图模型来实现,这是一个思路,实现了因果关系。从整体的理论框架方面可以考虑元学习(Meta-learning)、局部修正假设(localized change hypothesis)、因果发现(causal discovery),最后架构方面可以考虑如何学习不同对象的操作。

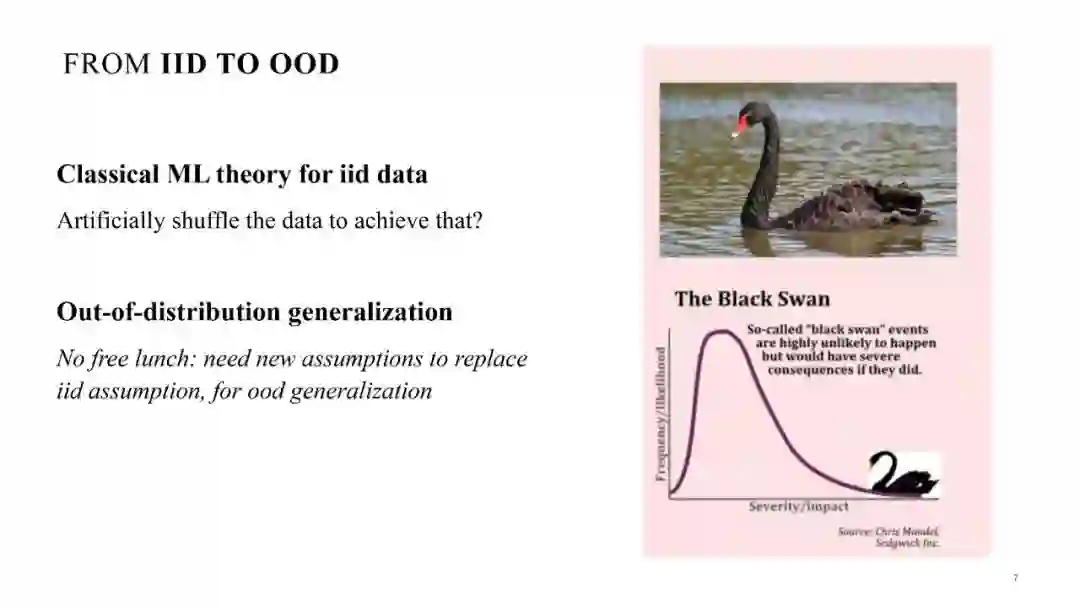

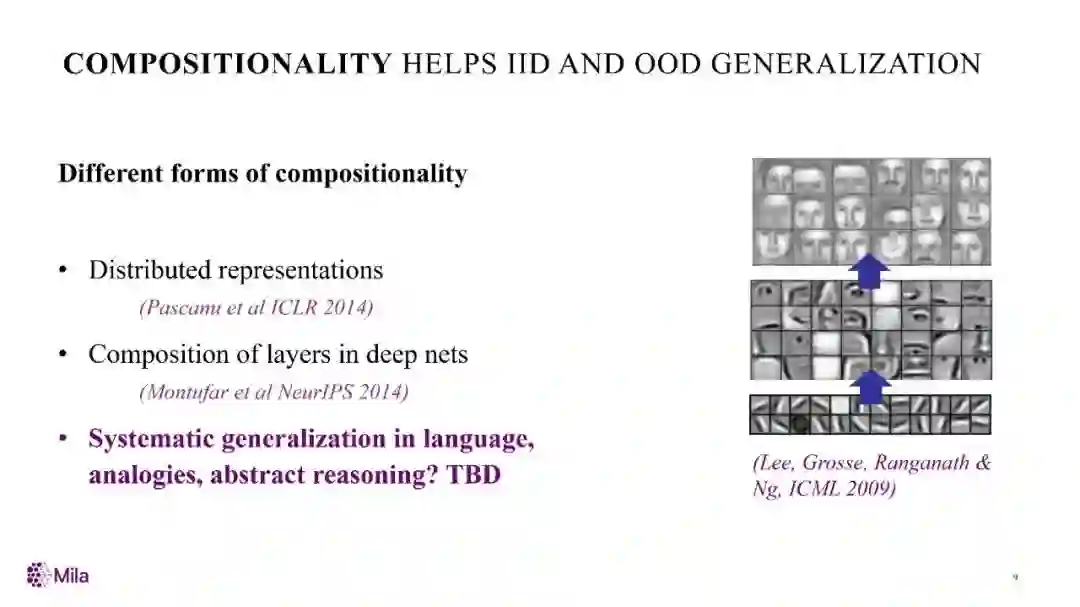

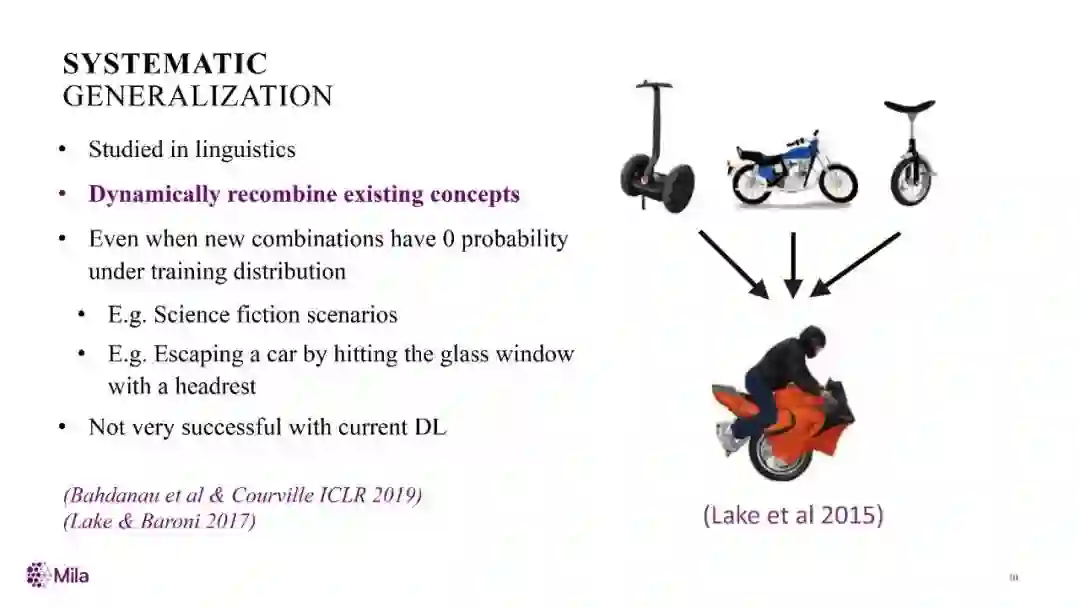

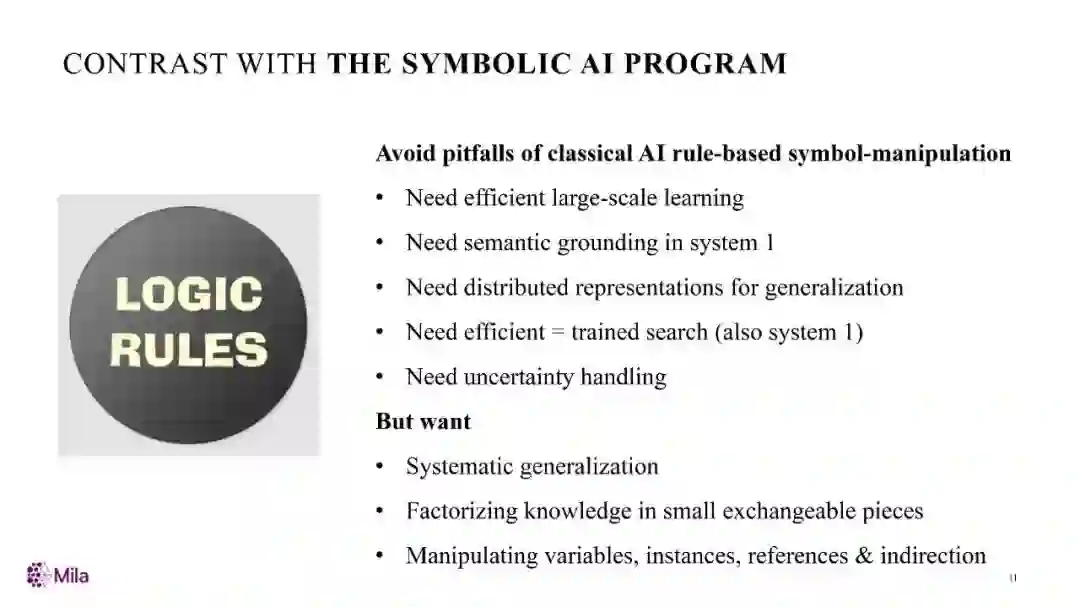

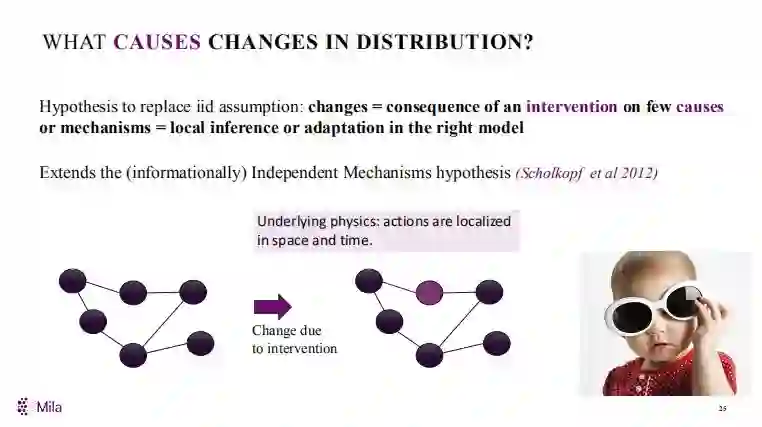

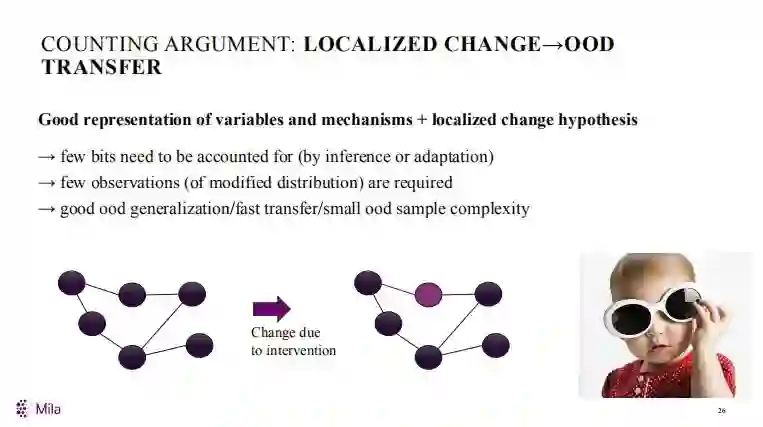

对于处理数据分布,传统机器学习都是基于IID(independent and identically distributed),也就是独立同分布的假设,但实际现状是很多真实场景下我们感兴趣的数据往往是出现次数非常少的数据,也就是我们在处理时需要关注更多的是OOD(out of distribution),也就是在数据中出现较少的分布,当然这需要我们在机器学习算法中有新的数据假设。尤其是从Agent的角度来考虑,需要考虑哪些是影响数据分布变化的因素,以及不同分布的可组合性等方法如何对现在的IID和OOD进行泛化。相对传统的符号AI系统,当前的AI需要更多具有泛化能力的机器学习能力。

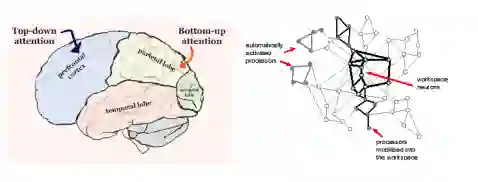

注意力机制是最近几年深度学习发展的一个重要技术,最近几年在很多系统中都有大量应用,注意力机制可以看做实现意识的第一步,在人类大脑中有自上而下的注意力和自下而上的注意力。

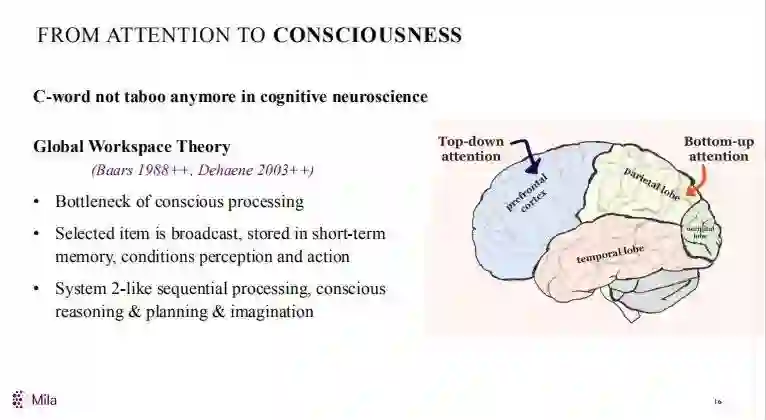

从认知角度来说,意识是一个很复杂的机制,Global Workspace Theory是1988年Baars等人提出的一个认知神经理论,其核心思想就是意识内容在各种不同认知过程中全局存在,包括Attention、 Evaluation、 Memory and verbal report。这些概念听起来有点抽象,后来Dehaene、Changeux and colleagues 等人提出了一个Global Workspace Architecture的实现模型。Global workspace theory和前面介绍的System2很相似,其他和意识相关的认知理论还包括Multiple drafts theory,这是Daniel Dennett在1991年提出的一个理论。

机器学习和意识模型相结合的关键是如何在机器学习中实现意识,或者说意识相关的理论/模型如何帮助机器学习。比如可以基于意识理论构造一些假设,然后用机器学习的方法来验证这些假设。当然从人的角度来看意识,高层次的表示可以说是语言,这需要把人的两个认知系统System1和System2有机地结合起来,也就是说把低层次的表示和高层次的决策结合起来。

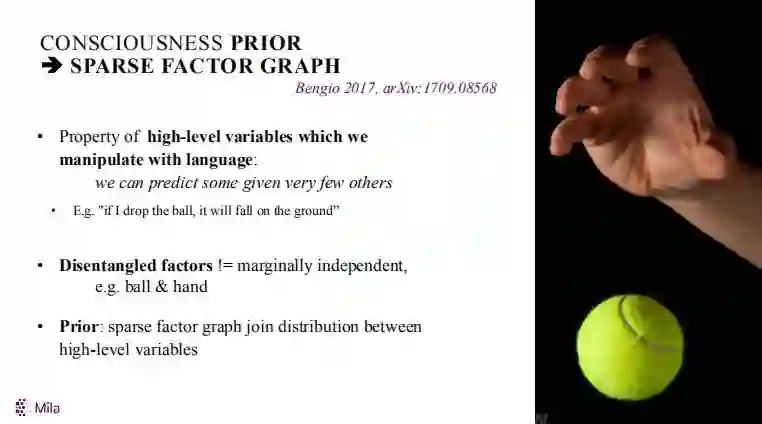

Yoshua还提到了前意识/意识先验。具体可以使用稀疏因子图,稀疏因子图不是一个新的事,基本思路是图模型的统一模型,因子图的好处是可以把有向图和无向图都统一起来。稀疏因子图可以用来学习变量之间的因果关系,从而构造变量之间的因果关系(找到真正的因果关系,而不是给不同变量给一个权重,这是为什么考虑稀疏的原因)。

元学习(学习学习的模型)是可能实现机器学习到OOD和模型快速迁移的一个办法。说到OOD,究其原因是有行为的变化,或者是用户行为对于数据的干预。元学习的知识表示可以有效帮助克服OOD,比如通过元迁移学习到变量之间的因果关系,这里的挑战是如何学习到未知干预变量的因果特性。最后是如何学习样本的可能操作,类似自动机器学习,但这里是在对象的不同操作层面。

本文经授权转载自学术头条,ID:SciTouTiao