[ACML 2017] LSNN:局部平滑神经网络,建立感受野之间的联系

2017年11月17日,在韩国首尔举行的ACML 2017 会议上,中科院计算所网络数据科学与技术重点实验室程学旗老师团队的博士生庞亮(导师:李国杰院士和兰艳艳副研究员)发表了题为“Locally Smoothed Neural Networks”(作者:庞亮,兰艳艳,徐君,郭嘉丰,程学旗)的论文并作了大会报告。本届ACML会议共收到稿件172篇,录用41篇(录用率23%)。

卷积神经网络大量应用在图像、语音和文本领域,这种网络结构将参数设定为局部连接和权值共享的形式,模拟了人眼的局部感受野的结构,在这些重要的任务上取得了突破性的成果。但是由于权值共享性质的引入,导致卷积神经网络在建模信息的位置关系上出现了劣势,在人脸认证任务、文本生成任务和图像问答任务上尤为突出。于是有些模型在设计时有意去掉权值共享假设,使用局部连接神经网络结构来替代原有的卷积神经网络结构,得到了更好的效果。然而局部连接神经网络引入了大量的参数,导致网络容易在数据量不足的情况下过拟合。我们提出的局部平滑神经网络很好的平衡了卷积神经网络和局部连接神经网络之间的弊端,并能充分发挥两类模型的优势,达到更好的效果。

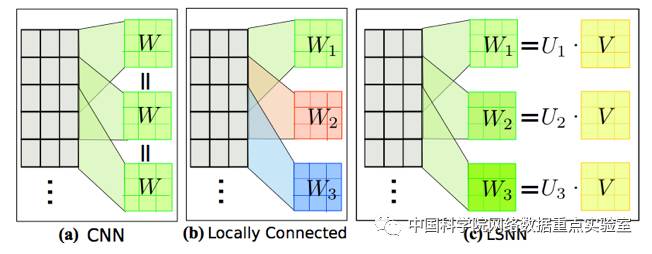

局部平滑神经网络和局部连接神经网络一样,在不同的局部区域,会有不同的参数,但是对于局部平滑神经网络而言,相邻的局部区域间的参数被一个空间分布所约束。我们将所有的参数看做W,那么在卷积神经网络中所有局部区域的W是相同的,在局部连接神经网络中所有局部参数是独立的,而在局部平滑神经网络中W是由一个空间分布函数U和一个共享的局部算子V共同决定的。

图1卷积层,局部连接层和LSNN之间的关系

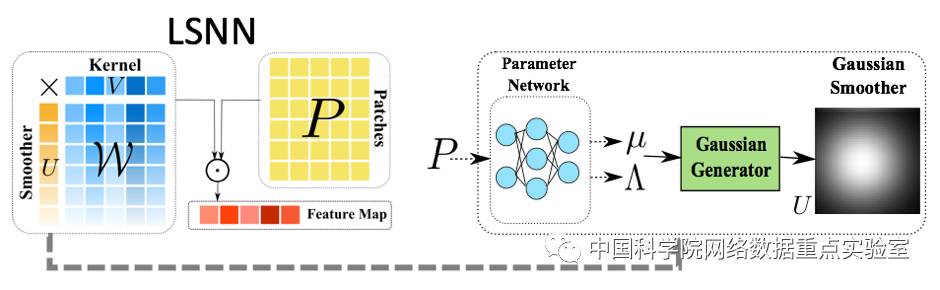

空间分布函数U可以产生自一个高斯分布(参数为均值和方差),根据高斯分布参数的取值方式,可以将LSNN网络分为两类。第一类是位置相关的LSNN网络,它的高斯分布的参数是自由参数,针对每一个样本是共享的;第二类是内容相关的LSNN网络,它的高斯分布的参数是由输入数据经过一个神经网络产生的,所以是独立于各个样本的。

图2 LSNN模型图

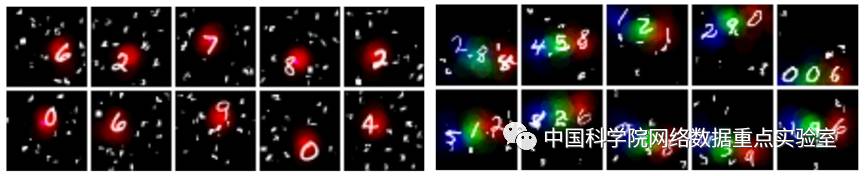

在我们设计的升级版MNIST数字识别的实验中,通过利用高斯分布作为U,可以在实验中学习到数字分类的同时,定位数字在图片中的位置。下图展示了我们的部分实验结果。

图3 MNIST实验结果

我们工作的意义在于,通过建立起各个位置的局部感受野的联系,解决了卷积层结构和局部连接层结构的缺点;LSNN可以同时捕获内容和位置的信息;卷积层结构是LSNN的一种特例,而LSNN可以近似局部连接层结构。

详细请参考具体的论文:

Liang Pang, Yanyan Lan, Jun Xu, Jiafeng Guo, Xueqi Cheng. Locall Smoothed Neural Networks. In Proceedings of 9th Asian Conference on Machine Learning (ACML2017), Seoul Korea, Nov 2017.