快速且不需要超参的无监督聚类方法

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

来源:知乎专栏

链接:https://zhuanlan.zhihu.com/p/69855313

本文已由作者授权转载,未经允许,不得二次转载

方法

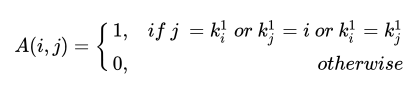

代表第

代表第

个点的最近邻点。

个点的最近邻点。

是

数据的邻接矩阵。

是

数据的邻接矩阵。

-

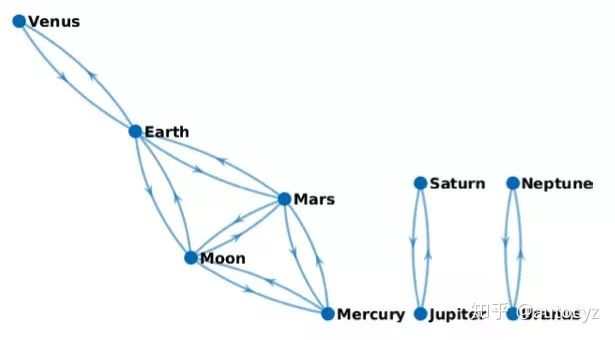

: 对于第i个点来说,我的最近邻就是第j个点。

-

: 对于第i个点来说,我是第j个点的最近邻。

-

: 第i个点的最近邻点和第j个点的最近邻点相同。

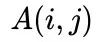

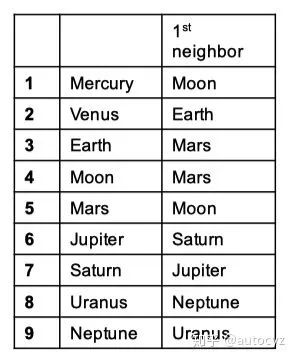

例子

-

条件1: ,在第i个行星的最近邻的处标上1; Mercury的最近邻是Moon,其id为4,所以(1,4)为1。

-

条件2: ,谁的最近邻是我,那就在谁那儿标1,结果发现没有行星的最近邻是Mercury,所以不标1。

-

条件3: ,谁的最近邻和我的最近邻一样(即谁的最近邻也是Moon),那就在谁那儿标1。 发现Mars的最近邻也是Moon,其id为5,所以在(1,5)处也标记为1。

-

计算每个数据的最近邻 -

根据公式计算邻接矩阵 -

根据邻接矩阵得到有向图,从而完成一次聚类

总结

-End-

*延伸阅读

CV细分方向交流群

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割、OCR、姿态估计等极市技术交流群(已经添加小助手的好友直接私信),更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~

登录查看更多