【学术思想】连续吸引子神经网络:神经信息表达的正则化网络模型

本文来自公众号:吴思Lab计算神经科学及类脑计算,AI科技评论获授权转载。

笔者按

最近清华大学施路平老师团队的“天机”芯片引起了公众的广泛兴趣。我们课题组有幸参与了该项目的部分研究,主要是贡献了用连续吸引子神经网络模型(CANN)来实现自行车的视觉跟踪。很多朋友因而问起了CANN的细节,我正好借此机会介绍一下CANN。CANN及其应用是我课题组在过去20年的重点研究方向。简单说,CANN是大脑编码、储存、运算、及交流信息的正则化的(即普适性的)神经网络计算模型;硬件实现CANN对类脑智能的未来发展具有重要意义。

|

01 |

为什么要发展正则化的神经计算模型 |

理论研究的最高境界是要从可观察现象和实验数据中总结、归纳、推演出系统背后工作的一般性原理,使得我们能够用少量理论和模型就能描述、理解、和“改造”纷繁复杂的外部世界。物理学的发展可以说是这方面最成功的例子,如牛顿的三大力学定律、万有引力定律,麦克斯韦的电磁学理论,爱因斯坦的广义相对论,统计物理的相变理论等。但生命科学与物理学有一个不同,生命今天存在的形式是亿万年进化、适者生存的结果(生命科学的黄金法则是达尔文的进化论)。由于不同物种可能面临不同的生存环境,需要执行不同的计算任务,因此不同物种的大脑结构和处理信息的方式也通常不同,而且同一物种大脑的不同感觉器官(如视觉与听觉)处理信息的策略也可以不同。因此,大脑处理信息的方式可能没有像物理学那种放之四海而皆准的普适性定律。但作为计算/理论神经科学工作者,我们也希望尽可能找到大脑信息处理的较普遍的法则和计算模型,即便它们达不到物理学定律那样的普适性,但如果能抓住复杂脑计算背后的简单工作机理、能够揭示多个脑功能的共同机制,能够在类脑计算中得到应用,也是一种巨大的成功。

大脑的信息处理是由海量神经元所构成的复杂神经网络来完成的,这些网络的结构是否有一些普适性的特点呢?目前还没有确定的答案。但实验和理论研究表明,在很大一类计算任务上,大脑采用的神经网络具有特定的结构。这种网络叫连续吸引子神经网络,即continuous attractor neural network (CANN)。它是当前为数不多的得到了实验验证和广泛应用的正则化神经计算模型。

|

02 |

连续吸引子神经网络的一些发展背景 |

我们先简单介绍一些CANN的发展背景。有趣的是,与通常实验发现推动理论研究不同,CANN的发展是理论走在实验的前面。早在上世纪70年代,几位计算神经科学的先驱Wilson, Cowan, Amari就从纯理论的角度提出了CANN模型,并研究其数学性质[1,2]。到了80年代,更多数学和物理学家相继加入,进一步推动了CANN的动力学性质研究[3,4]。但CANN在神经信息处理建模上的广泛应用始于90年代后,经典的成功例子包括运动方向编码的mental rotation现象[5],视觉朝向编码 (orientation tuning)[6]、头朝向编码[7]、空间位置编码[8]等。这些建模工作证明CANN在神经信息中的重要性,也体现了早期纯思辨模型研究的前瞻性。而关于CANN最直接的实验证据则出现在近几年[9-11]。笔者在CANN方面的研究兴趣始于1998-2000年在日本理化学所Amari实验室做博士后期间(见备注1),并在随后职业生涯中一直将其作为研究的重点(见备注2,及参考文献)。

|

03 |

连续吸引子神经网络的数学模型 |

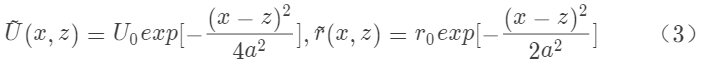

我们先从吸引子网络谈起。所谓吸引子指的是一个动力学系统在不接受外界输入情况下靠自身动力学就能维持的非静息的稳定状态(active stationary state),其被广泛认为是神经系统表达信息的方式(当然真正的神经系统并不需要严格意义上的稳定状态,吸引子网络只是为了研究方便而采用的理想化数学模型)[12]。要构成一个的吸引子网络,简单地说,需要两个基本条件:1)神经元之间有兴奋性的互馈连接 (recurrent connection),这样在没有外界输入的情况下,靠神经元之间的正反馈,网络就能维持住稳定活动;同时我们也要求兴奋性连接是局部的,这样才能形成有意义的空间局部活动;2)网络中要有抑制性作用,这样才能避免系统活动因反复的正反馈而爆炸。在调整好兴奋与抑制作用的比例后,一个吸引子网络就形成了。Hopfield模型(其实应该叫Amari-Hopfield模型,见备注1)采用吸引子的思想解释了大脑在收到部分或模糊信息条件下的联想式记忆机制[13]。但经典的Hopfield模型没有考虑神经元之间连接的对称结构,因而其具有的吸引子(多个)在空间上是相互孤立的(图1A)。

在吸引子网络的基础上,如果我们进一步要求神经元之间的连接具有空间平移不变性的对称结构,这时网络就将具有一簇连续的、而不是孤立的吸引子(注意,考虑到真实生物系统的神经数目足够大,为了方便,后面讨论都假设神经元数目是无穷的);这些吸引子在参数空间上紧密排列,构成一个连续的状态子空间;这正是“连续吸引子”这一名称的来源(图1B)[14]。

数学上很容易构造高维的CANN,但由于二维大脑皮层对神经布线的限制,通常我们只用到一维或二维的CANN(蝙蝠由于飞行的需要,其空间定位系统可能会用到三维CANN)。

实现CANN的数学模型有多个(这一点与物理学中的唯一正确模型不同),这里我们用自己提出的模型为例来介绍[15-17],其数学方程如下(一维为例):

其中U(x)代表在参数空间位点x上的神经元的突触总输入,r(x)是对应的神经元发放频率;J(x,x’)~exp[-(x-x’)/2a2]是神经元(x)和(x’)之间的兴奋性连接强度,我们看到其具有平移不变性,即其为(x-x’)的函数。该模型没有单独考虑抑制性神经元,而是将其作用效果包含在除法归一化作用中(divisive normalization,即方程2);这一点与其它CANN模型惯采用的Mexican-hat连接不同,但在生物学更合理,可以通过树突上的shunting inhibition来实现。

总的说来,该模型已经包含了上述的几个结构要素,因而构成一个CANN。我们喜欢这个模型的原因是(与作者的物理背景有关),这个模型在数学上有精准解,使得我们可以对其动力学做细致的理论分析,从而更容易理解其计算功能,并将其用于神经建模中。

以上方程的稳定解正好具有高斯函数形状,通常被称为波包 (bump),和实验记录的神经元群活动一致,表示为:

其中波包的顶点位置z是一个自由变量,可以取任何值,这表示网络具有一簇连续的稳定解,即连续吸引子(图1C)。

图1:A,离散的吸引子神经网络示意图。每个吸引子是能量空间中的局部极小点。B,一维CANN示意图。一簇连续的吸引子在能量空间中构成一个一维的平滑子空间,在其上系统随遇平衡。每个吸引子对应于一个高斯波包活动状态。C, 编码朝向的一维CANN示意图。D,果蝇大脑中头朝向神经元的分布图,摘自[11]。

|

04 |

连续吸引子神经网络的动力学性质 |

CANN的特殊结构决定了其特殊的动力学性质,进而决定了其能实现的计算功能。我们可以直观理解CANN独有的动力学性质如下。考虑一维参数空间x是一个周期变量,如朝向、运动方向、头朝向等。一个一维的CANN具有一簇高斯波包的稳定状态(图1C),它们在系统状态空间中构成一个一维的能量平滑的子空间(近似)(图1B)。在这个子空间上,因为能量函数是平的,系统状态处于随遇平衡(neutral stability);这意味着在外部微小输入的驱动下,系统可以轻松改变状态[16-17]。注意这个性质是其它非连续吸引子网络(如Hopfield网络)所不具有的(图1A)。这个随遇平衡是CANN动力学的关键,它使得网络状态能够平滑跟踪外部运动输入,从而实现了多项计算功能,如编码头朝向编码和空间位置等。

在头朝向编码中,大脑内的头朝向神经元通过互馈连接构成了一个一维的CANN[7]。网络的神经元群活动实时形成成一个高斯波包,波包的顶点位置即编码了头的朝向;当动物头转动时,网络的波包由于随遇平衡可以跟着转动,从而在大脑内实时保留了头的朝向信息,维持了我们的空间方位感(无意识下的脑计算)。

在空间位置编码中,海马中的空间神经元(place cell)构成了一个二维的CANN,其产生的神经活动波包编码了动物的空间位置[8]。同样CANN的随遇平衡使得网络活动状态能实时跟踪动物运动的空间位置,实现了空间导航(同样这是无意识下的脑计算)。

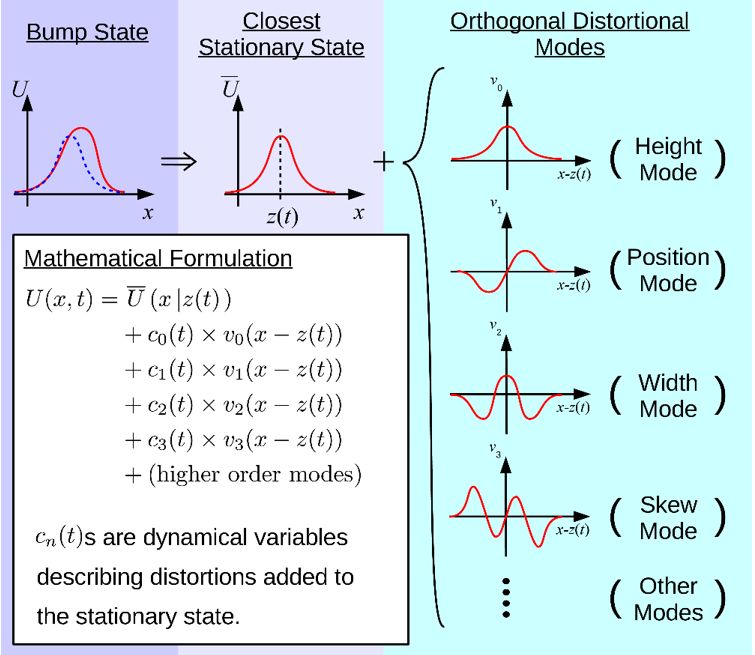

上述CANN直观的动力学特性可以被严格的理论分析。我们为此发展了一套投影算法(projection method)来精确解析上诉CANN模型的动力学行为(图2)[17-18]。简单地说,我们构造了一套本征函数(本征运动模式),每个本征函数都代表了有意义的网络状态变化模式,如前四个本征函数分别表示波包高度变化、波包位置平移、波包宽度变化、波包沿着一边倾斜,其对应的本征值则反应了该运动模式在CANN动力学中的贡献(有趣的是这些本征函数恰好是量子力学发展的Hermit polynomial function,难道神经计算和量子计算有某种关系吗?)。CANN动力学特点是,第二本征函数,即波包平移,具有最大的本征值0,其它本征函数的本征值都小于0,这是CANN随遇平衡的数学体现。另外,这些本征值都快速衰减,意味着我们只需将动力学方程投影到少数几个本征函数就足以近似CANN的动力学。利用这个技巧,我们完成了一系列基于CANN的建模工作(见文献)。

图2:分析CANN动力学的投影算法。本征函数(本征运动模式)是Hermite Polynomial Function,分别表示网络状态波包的高度、位置、宽窄、倾斜等形变。本征值大小反应了本征模式的贡献。第二本征模式,波包的平移,具有最大的本征值0,其它都小于0。

|

05 |

连续吸引子神经网络的实验证据 |

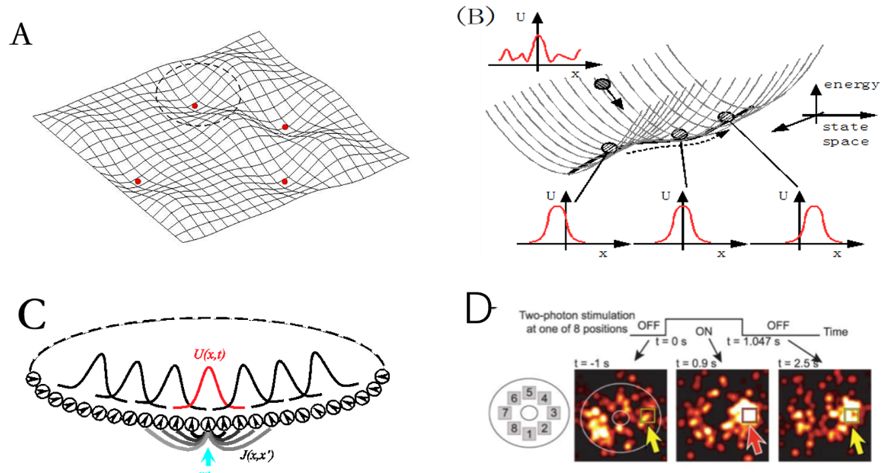

尽管有生物学合理的结构和漂亮的数学性质,但CANN从上世纪70年代被提出之后的近40年里,一直没有被神经科学实验直接证实。CANN能描述很多实验现象最多只能说明CANN是一个成功的唯像模型,并不能算直接佐证。我相信很多研究者,包括笔者本人,一直都是基于科学美感,相信CANN应该在大脑信息处理得到广泛应用,而坚持研究CANN,但内心是有点忐忑不安的。由于实验手段和成像技术的提高,CANN的实验证据最近有了重大的突破。最直接的证据是用成像方法在果蝇大脑中观察到了头朝向神经元在空间上如理论模型一般沿着一个环分布(对比图1C-D),并且在果蝇头转动的情况下,神经元群活动跟着一起平滑转动,正如理论所预言[11]。我这里想多介绍另一个不那么直接的理论预测的实验验证。

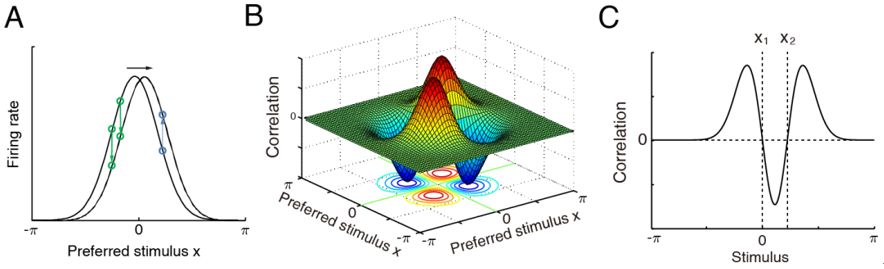

如上述,CANN的特殊结构导致了其特殊的动力学性质,这种特性动力学又可以导致特殊的神经元关联活动被实验所观测。如图3,理论预测:在固定刺激条件下,变换记录的神经元对,它们的关联强度应该反对称分布的[17];或者在固定记录的神经元对的条件下,变换刺激值,神经元对活动之间的关联强度是M-shape的。实验数据在理论预测提出多年后验证了后一个结果[9-10]。

图3:CANN的动力学特点决定了其神经元之间的关联活动也体现了独有的结构,可以作为实验观测的证据。A,由于网络状态(波包)最重要的变化模式是平移,在固定刺激条件下(噪声不可避免),神经元对之间的活动关联呈现反对称(B);在固定神经元对,变化刺激值的条件下,神经元对之间的活动关联呈现M-shape(C)。

|

06 |

连续吸引子神经网络的计算功能 |

CANN的生物学合理结构及漂亮的动力学性质促使得它成为了一种常用模型来模拟神经信息处理的过程。很多文献中的建模工作虽然没有明确强调CANN,但其实也暗含了CANN的结构。有关CANN的神经建模工作很多,这里我们主要用自己课题组完成的工作来举例说明其丰富的计算功能。

1

神经元群编码

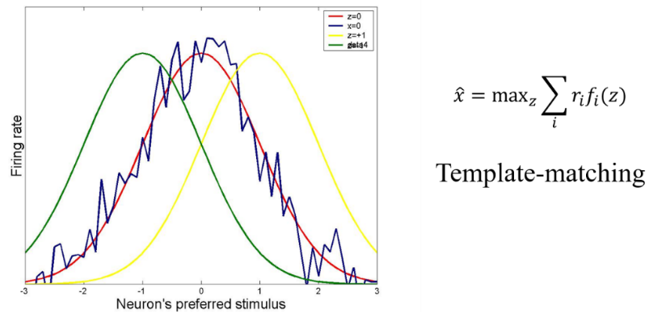

实验发现,对于很多类型的刺激,尤其是连续变量(如角度、空间位置等),神经系统的编码策略为:一大群神经元共同协作编码刺激值,其中每个神经元的反应覆盖一定范围的刺激值,且对某个特定值产生最大反应(表现为高斯形状的调谐函数);神经元群的调谐函数覆盖整个参数空间。当外部一个刺激呈现时,一群神经元做出反应,从而平均掉无处不在的噪声。CANN正好为这种群编码策略提供了一种非常自然的网络实现机制:参与编码的神经元群相连形成一个CANN;当有外部输入时,网络即进入一个吸引子,即产生一个高斯形状的波包活动;由于是吸引子,噪声被去除了,波包的顶点位置给出神经网络解码的结果[15,19]。理论分析表明,CANN实现的解码算法是“template matching”,也可以被是看作是在忽略神经元关联活动下的“unfaithful decoding”[20,21]。在高斯独立噪声的条件下,这种解码方法是统计优化的。

图4:CANN实现优化的神经元群编码。在接受外部有噪声的输入后,网络状态(波包)会快速移动到一个位置,使得波包和噪声输入的重叠最大,相当于一个template matching的操作,波包的顶点位置即为解码结果。

2

预测跟踪

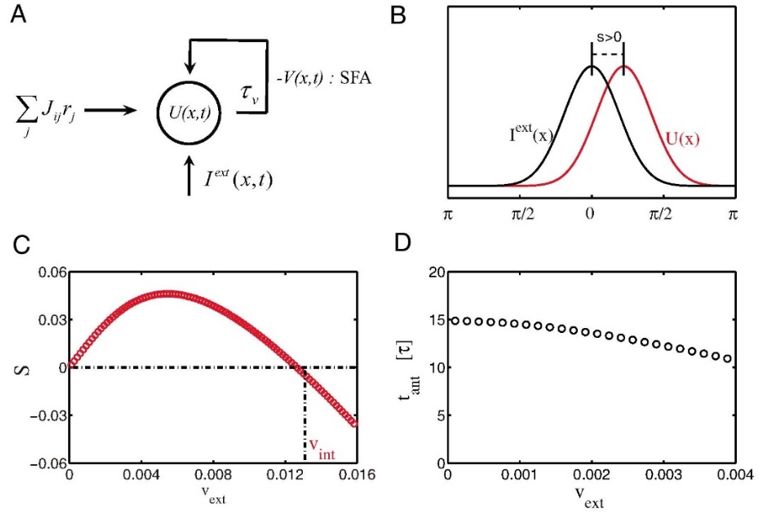

前面谈到CANN的随遇平衡特性使得其能平滑地跟踪运动目标,但实现的跟踪是滞后于运动目标的实时位置的,这是因为网络中神经元的反应和信号传递都需要时间[16]。这一点解释不了头朝向跟踪的实验发现,即神经系统实现的运动跟踪是提前的,且领先一个恒定的时间值,几乎不依赖目标的运动速度。为了实现预测跟踪,我们研究发现,如果在神经元动力学中引入神经系统广泛存在的负反馈机制(其可以是单个神经元发放强度的自适应(spike frequency adaptation)(图5A)[22]、神经元之间突触的短时程衰减(short-term plasticity)[23-24]、或者不同层间的反馈抑制[25]等),那么CANN就可以实现时间上恒定领先的运动预测跟踪(图5B)。我们首先发现在引入互反馈机制后,CANN能维持一个行波解(travelling wave),且行波的速度(网络的内在速度)由负反馈强度调制。在接受运动输入的情况下,网络中波包移动速度被锁定到输入的运动速度,但其空间位置是领先还是落后于目标位置则是由网络内在速度与目标运动速度的相对大小来决定的(图5C):当内在速度大于目标运动速度时,预测就发生了。理论研究表明,在很大一段速度范围内,网络波包领先的距离和目标速度成正比,即预测的时间是固定的,这一点和实验数据吻合(图5D)。

CANN的这种强大预测跟踪能力也为我们提供了一种类脑的运动目标跟踪算法。该算法的优点包括:1)预测跟踪的时间是恒定的,几乎不依赖于目标运动速度;2)模型的参数是可以根据任务,理论上预先设定的,不需要网络训练;3)CANN及反馈机制可以被类脑芯片实现。

图5:引入了适当负反馈作用的CANN可以实现运动目标的预测跟踪。A,负反馈机制示意图;B,网络波包领先外部输入示意图;C,领先的条件是内在速度大于目标速度;D,在很大一段速度范围内,领先时间近似为常数。

3

多模态信息整合

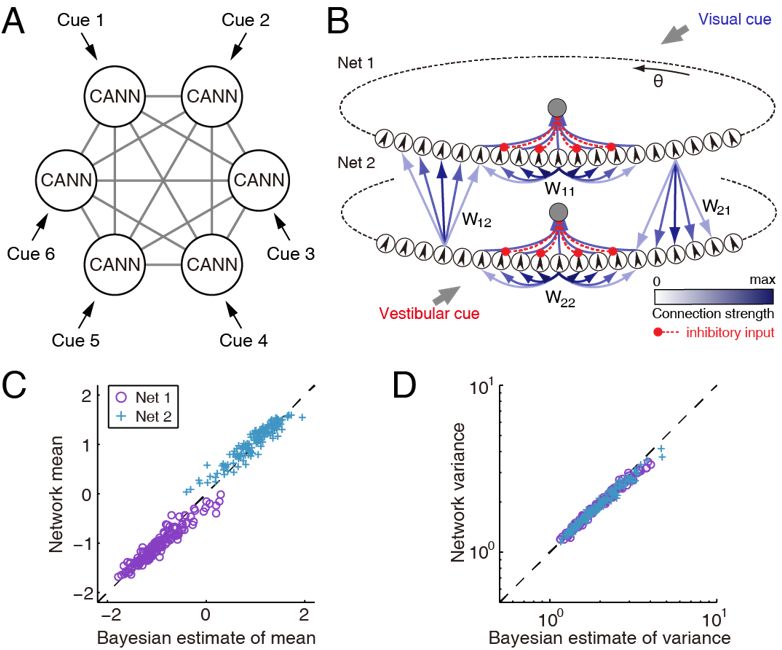

大脑用眼、耳、鼻、触觉、平衡觉等多种感觉器官来感知外部世界。这些感觉器官通过不同的物理、化学、机械等信号,从不同侧面提取了外部刺激的信息。这些信息在大脑内应该被整合起来,从而帮助我们更可靠、更全面地认识外部世界。大量行为实验表明,大脑的确整合、且优化地整合了多模态信息。从计算的角度看,在整合这些不同属性或特征的信号时,大脑需要一种共同的信息表达模式,才能相互交流信息。CANN,在其中信息被统一表达为神经群活动波包,为多模态信息整合提供了一种可能的操作平台。我们研究了视觉和平衡觉信息整合来感知头朝向(heading direction)的神经网络模型[26-27]。依据实验数据,我们提出了去中心化的计算模型,其中MSTd上的CANN主要接受视觉信号,而VIP上的CANN主要接受平衡觉信号,两者之间通过长程连接交换信息(图6)。我们的研究表明两个耦合的CANN能够可以实现贝叶斯优化信息整合,也可以实现统计优化的信息分离[28-29],初步支持了CANN可以作为大脑内信息表达、储存、运算、和交流的统一网络框架。

图6:CANN实现优化的多模态信息整合。A,去中心化的信息整合网络结构示意图。B,两个耦合的CANN,分别接受视觉和平衡觉信号,共同计算自身运动的方向。C和D,网络计算结果和统计优化的贝叶斯理论符合。

|

07 |

连续吸引子网络的硬件实现 |

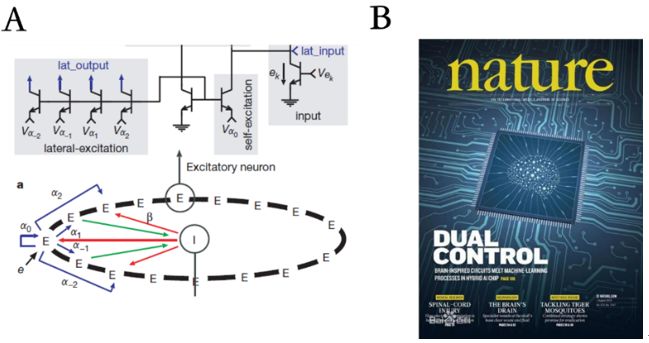

既然CANN具有生物学合理结构和强大的计算功能,不难想象科学家们会试图在硬件上实现它。的确,早在2000年MIT的Seung等就已经用简单电路实现了CANN,但由于当时工艺的限制,只用到了十几个神经元,也没有实现真正有价值的功能。因此,该工作虽然发表在了Nature上,但一直没有引起人们的足够重视[30]。

在最近的工作中,我们课题组有幸参加了清华大学团队负责的“天机”芯片项目(千万级的神经元和突触),在其上成功实现了我们的CANN模型[31]。在这个无人驾驶自行车任务中,CANN的功能是实时跟踪运动目标。由于硬件限制,目前只实现了简化的CANN模型,还没有预测跟踪及其它功能。但考虑到CANN在神经信息处理中的广泛应用,尤其是其提供了多功能脑区、多模态之间信息交流的统一平台,我们坚信:虽然这只是CANN实现的一小步,但却是未来类脑智能发展的关键一步!

图7:A,早期小规模CANN的电路示意图(摘自[30])。B,自然杂志封面论文“天机”芯片。

|

08 |

为什么是连续吸引子神经网络 |

以上只是介绍了CANN能编码简单特征,实验表明CANN也可以编码抽象特征[32],并且在一个临时任务中,大脑可以快速学会一个CANN来编码任务依赖的特征[33]。人们也许会好奇,为什么大脑会广泛采用CANN来处理信息。我们猜测这可能和大脑面临的计算任务和采用的学习法则有关。

在日常生活中,大脑需要不断识别和区分物体。为此大脑需要对物体进行归类,这种归类需要编码物体之间的相似性。一个有启发的发现是,用大量自然图像训练深度学习网络去完成单纯的物体分类任务,网络会自动学会神经表达来编码物体之间在语义上的相似性,即属于同一类或类别相近的物体,它们的神经表达之间的关联性也越强[34]。在生物学合理的Hebb学习率约束下,神经活动关联性决定了神经元之间互馈连接的强度;如果很多物体间相似性具有一个连续谱,那么网络就自然地形成了CANN。我们做了一个初步实验,利用深度学习网络从大数据中已经学到的神经表达,用适当的Hebb学习率就可以很自然地学到了CANN[35]。

我们知道一维CANN编码了头朝向,二维CANN编码了空间位置,但是动物(如大鼠)并没有抽象的角度和空间坐标概念(这是数学发明),那么动物大脑是如何学会编码角度和位置的CANN呢?一种可能的机制是,头的连续转动、动物在空间中的连续运动提供了角度、空间位置相似性的线索,即相邻角度、相邻空间位置发生的时间是相近的;这些线索在Hebb学习率的指导下,决定了神经元之间的连接强度,从而形成了CANN。

总的说来,CANN本质上是神经系统为了编码物体相似性(这种相似性可以是图形上的、语义的、时间上的,同时也是任务依赖的、数据约束的),采用Hebb学习率来修饰神经元之间突触强度的一个自然结果。

|

09 |

连续吸引子神经网络的发展展望 |

虽然CANN在大脑功能模拟、类脑计算、以及硬件实现上都取得一定进展,但未来还有大量的研究工作要做,也会有更多的惊喜在等着我们。在计算神经科学研究方面,我们需要回答大脑如何从不同特性的感觉输入中统一学会了CANN,CANN的互馈连接如何和神经元的前馈连接、反馈连接协调工作,CANN如何参与抽象概念的表达,CANN如何介导了脑区间、模态间的信息交流等。在类脑计算研究方面,我们需要探索互馈连接的CANN如何能和前馈连接的深度学习网络有效结合,实现更多的计算功能,尤其是数据驱动和知识驱动的融合。在神经芯片研究方面,我们需要进一步研究如何实现CANN的更多细致结构和更多的计算功能。以上三方面研究应该结合起来,共同发展。

备 注

1:Amari先生全名Shun-ichi Amari(甘利俊一),是神经网络研究的先驱和泰斗。在笔者看来,Amari先生是神经网络理论研究做得最好的科学家。其代表性工作包括信息几何 (information geometry,关于模型学习的最深刻理论)、随机梯度下降算法(完成于1967,远远早于后来的back-propagation)、Amari-Hopfield 模型(早于Hopfield)、CANN模型(1972)、natural gradient 算法 (一种流行的ICA算法)等。

2:也许是因为理论物理训练的缘故,笔者一开始就被CANN的简洁结构和漂亮计算性质所吸引,当时就有一种模糊的感觉,CANN可能蕴含了大脑处理信息的一般性原理。因此从1999年开始就现在一直坚持在做这个方面的工作,和合作者一起发表大量学术论文(可能是国际同行中发表最多的),包括提出了新模型,发展了一套新的动力学分析工具、系统研究了CANN的计算性质、将其用于神经元群编码、预测跟踪、多模态信息整合等多项脑功能建模、以及类脑计算应用等(见参考文献)。

|

10 |

参考文献 |

1. Amari S: Dynamics of pattern formation in lateral-inhibition type neural fields. Biol Cybern. 1977; 27(2): 77–87.

2. Continuous attractor network. Scholarpedia

3. Ermentrout B: Neural networks as spatio-temporal pattern-forming systems. Rep Prog Phys. 1998; 61: 353–430.

4. Bressloff PC: Spatiotemporal Dynamics of Continuum Neural Fields. J Phys A. 2012; 45(3): 033001.

5. Georgopoulos AP, Taira M, Lukashin A: Cognitive neurophysiology of the motor cortex. Science. 1993; 260(5104): 47–52.

6. Ben-Yishai R, Bar-Or RL, Sompolinsky H: Theory of orientation tuning in visual cortex. Proc Natl Acad Sci U S A. 1995; 92(9): 3844–3848.

7. Zhang K: Representation of spatial orientation by the intrinsic dynamics of the head-direction cell ensemble: a theory. J Neurosci. 1996; 16(6): 2112–2126.

8. Samsonovich A, McNaughton BL: Path integration and cognitive mapping in a continuous attractor neural network model. J Neurosci. 1997; 17(15): 5900–5920.

9. Ponce-Alvarez A, Thiele A, Albright TD, et al.: Stimulus-dependent variability and noise correlations in cortical MT neurons. Proc Natl Acad Sci U S A. 2013; 110(32): 13162–13167.

10. Wimmer K, Nykamp DQ, Constantinidis C, et al.: Bump attractor dynamics in prefrontal cortex explains behavioral precision in spatial working memory. Nat Neurosci. 2014; 17(3): 431–439.

11. Sung Soo Kim, Hervé Rouault, Shaul Druckmann, Vivek Jayaraman. Ring attractor dynamics in the Drosophila central brain. Science V.356, 849-853, 2017.

12. Amit, D. J. (1989). Modeling brain function: The world of attractor neural networks. New York, NY: Cambridge University Press.

13. Hopfield, J. J. (1982). Neural networks and physical systems with emergent collective computational abilities. Proceedings of the National Academy of Sciences 79, 2554–2558.

14. Wu, S., Wong, KYM., Fung, CCA., Mi, Y., and Zhang, W. (2016). Continuous attractor neural networks: candidate of a canonical model for neural information representation. F1000 Research, 66(16), 209-226.

15. S. Wu, S. Amari and H. Nakahara. (2002). Population Coding and Decoding in a Neural Field: A Computational Study. Neural Computation, v14, no.5, p.999-1026.

16. Wu, S., and Amari, S.-I. (2005). Computing with continuous attractors: Stability and online aspects. Neural Computation 17: 2215–2239.

17. Wu, S. Hamaguchi, K., and Amari, S.-I. (2008) Dynamics and computation of continuous attractors. Neural Computation 20 (4): 994-1025.

18. Fung CC, Wong KY, Wu S: A moving bump in a continuous manifold: a comprehensive study of the tracking dynamics of continuous attractor neural networks. Neural Comput. 2010; 22(3): 752–792.

19. Deneve S, Latham PE, Pouget A: Reading population codes: a neural implementation of ideal observers. Nat Neurosci. 1999; 2(8): 740–745.

20. S. Wu, H. Nakahaara, N. Murata and S. Amari. (2000). Population Decoding Based on an Unfaithful Model. Advances in Neural Information Processing Systems 12 (NIPS*1999), pp.192-198, 2000.

21. S. Wu, H. Nakahara and S. Amari. (2001). Population Coding with Correlation and an Unfaithful Model. Neural Computation, v.13, p.775-798.

22. Mi Y, Fung CA, Wong KYM, et al.: Spike Frequency Adaptation Implements Anticipative Tracking in Continuous Attractor Neural Networks. Paper presented at: Advances in Neural Information Processing Systems. 2014.

23. C. C. Fung, K. Y. Michael Wong and S. Wu (2012). Delay Compensation with Dynamical Synapses. Advances in Neural Information Processing Systems (NIPS*2012).

24. Fung CC, Wong KY, Wang H, et al.: Dynamical synapses enhance neural information processing: gracefulness, accuracy, and mobility. Neural Comput. 2012; 24(5): 1147–1185.

25. Zhang W, Wu S: Neural information processing with feedback modulations. Neural Comput. 2012; 24(7): 1695–1721.

26. Zhang W, Wu S: Reciprocally Coupled Local Estimators Implement Bayesian Information Integration Distributively. Advances in Neural Information Processing Systems. 2013.

27. W.Zhang, A. Chen, M. Rasch and S. Wu (2016). Decentralized multi-sensory information integration in neural systems. The Journal of Neuroscience, 36(2):532-547.

28. W. Zhang, H. Wang, KYM Wong, S. Wu (2016). “Concurrent” and “Opposite” Neurons: Sisters for Multisensory Integration and Segregation. Advances in Neural Information Processing Systems (NIPS*2016).

29. W. Zhang, H. Wang, A. Chen, Y. Gu, Tai-Sing Lee, KYM Wong, Si Wu (2019). Complementary congruent and opposite neurons achieve concurrent multisensory integration and segregation. eLife 2019;8:e43753.

30. Hahnloser RH, Sarpeshkar R, Mahowald MA, Douglas RJ, Seung HS. Digital selection and analogue amplification coexist in a cortex-inspired silicon circuit. Nature. 405: 947-51.

31. Jing Pei et al. (2019). Towards artificial general intelligence with hybrid Tianjic chip architecture. Nature, v.572, p.106–111.

32. Mante V, Sussillo D, Shenoy KV, et al.: Context-dependent computation by recurrent dynamics in prefrontal cortex. Nature. 2013; 503(7474): 78–84.

33. Logothetis NK, Pauls J, Bülthoff HH, et al.: View-dependent object recognition by monkeys. Curr Biol. 1994; 4(5): 401–414.

34. Daniel L.K. Yamins, Ha Hong, Charles F. Cadieu, Ethan A. Solomon, Darren Seibert, and James J. DiCarlo. Performance-optimized hierarchical models predict neural responses in higher visual cortex. Proceedings of the National Academy of Sciences, 111(23):8619–8624, 2014.

35. X. Zhou, Z. Ji, X. Liu, Y. Mi, KYM Wong and S. Wu (2017). Learning a continuous attractor neural from real images. ICONIP 2017.

|

11 |

笔者和合作者在CANN上发表的相关论文 |

1. W. Zhang, H. Wang, A. Chen, Y. Gu, Tai-Sing Lee, KYM Wong, Si Wu (2019). Complementary congruent and opposite neurons achieve concurrent multisensory integration and segregation. eLife 2019;8:e43753.

2. X. Zou, Z. Ji, X, Liu, T. Huang, Y. Mi, D-H Wang and S. Wu (2018). Learning, storing, and disentangling correlated patterns in neural networks. ICONIP 2018.

3. X. Zhou, Z. Ji, X. Liu, Y. Mi, KYM Wong and S. Wu (2017). Learning a continuous attractor neural from real images. ICONIP 2017.

4. W. Zhang, A. Chen, M. Rasch and S. Wu (2016). Decentralized multi-sensory information integration in neural systems. The Journal of Neuroscience, 36(2):532-547.

5. W. Zhang, H. Wang, KYM Wong, S. Wu (2016). “Concurrent” and “Opposite” Neurons: Sisters for Multisensory Integration and Segregation. Advances in Neural Information Processing Systems (NIPS*2016).

6. Wu, S., Wong, KYM., Fung, CCA., Mi, Y., and Zhang, W. (2016). Continuous attractor neural networks: candidate of a canonical model for neural information representation. F1000 Research, 66(16), 209-226.

7. Y. Mi, X. Lin, and S. Wu (2016). Neural Computations in a Dynamical System with Multiple Time Scales. Frontiers in Computational Neuroscience.

8. Fung CC, Wong KY, Mao H, et al.: Fluctuation-response relation unifies dynamical behaviors in neural fields. Phys Rev E Stat Nonlin Soft Matter Phys. 2015; 92(2): 022801.

9. He Wang, Kin Lam, C. C. Alan Fung, K. Y. Michael Wong and Si Wu (2015). A Rich Spectrum of Neural Field Dynamics in the Presence of Short-Term Synaptic Depression. Physical Review E.

10. C. C. Alan Fung, K. Y. Michael Wong, Hongzi Mao and Si Wu (2015). Fluctuation-response Relation Unifies Dynamical Behaviors in Neural Fields. Phys. Rev. E 92, 022801.

11. Mi Y, Fung CA, Wong KYM, et al.: Spike Frequency Adaptation Implements Anticipative Tracking in Continuous Attractor Neural Networks. Advances in Neural Information Processing Systems. 2014.

12. Fung CCA, Wang H, Lam K, Wong KYM and Wu S (2013). Resolution enhancement in neural networks with dynamical synapses. Front. Comput. Neurosci. 7:73.

13. Zhang W, Wu S: Reciprocally Coupled Local Estimators Implement Bayesian Information Integration Distributively. Advances in Neural Information Processing Systems. 2013.

14. Fung CC, Wong KY, Wang H, et al.: Dynamical synapses enhance neural information processing: gracefulness, accuracy, and mobility. Neural Comput. 2012; 24(5): 1147–1185.

15. Zhang W, Wu S: Neural information processing with feedback modulations. Neural Comput. 2012; 24(7): 1695–1721.

16. C. C. Fung, K. Y. Michael Wong and S. Wu (2012). Delay Compensation with Dynamical Synapses. Advances in Neural Information Processing Systems (NIPS*2012).

17. Fung CC, Wong KY, Wu S. A moving bump in a continuous manifold: a comprehensive study of the tracking dynamics of continuous attractor neural networks. Neural Comput. 2010; 22(3): 752–792.

18. C. C. Fung, K. Y. Michael Wong, H. Wang and S.Wu (2010). Attractor Dynamics with Synaptic Depression. Advances in Neural Information Processing Systems (NIPS*2010).

19. C. C.Fung, K.Y.Michael Wong and S. Wu (2009). Dynamics of Two Dimensional Continuous Attractor Neural Networks. New Jounral of Physics A.

20. C. C.Fung, K.Y.Michael Wong and S. Wu (2008). Tracking Changing Stimuli in Continuous Attractor Neural Networks. Advances in Neural Information Processing Systems 22 (NIPS*2008), p.481-488.

21. C. C.Fung, K.Y.Michael Wong and S. Wu (2008). Dynamics of Neural Networks with Continuous Attractors. European Physics Letter, v.84, 18002.

22. Wu, S. Hamaguchi, K., and Amari, S.-I. (2008) Dynamics and computation of continuous attractors. Neural Computation 20 (4): 994-1025.

23. S. Wu (2007). Behavior Signatures of Continuous Attractors. International Conference on Cognitive Neurodynamics (ICCN’07).

24. S. Wu, K. Hamaguchi and S. Amari (2007). The Tracking Speed of Continuous Attractors. International Symposium on Neural Networks (ISNN*07), p.926-934.

25. Wu, S., and Amari, S.-I. (2005). Computing with continuous attractors: Stability and online aspects. Neural Computation 17: 2215–2239.

26. S. Wu, D. Chen, M. Niranjan and S. Amari. (2003). Sequential Bayesian Decoding with a Number of Neurons. Neural Computation, v.15, p.993-1013.

27. S. Wu, S. Amari and H. Nakahara. (2002). Population Coding and Decoding in a Neural Field: A Computational Study. Neural Computation, v14, no.5, p.999-1026.

28. S. Wu and S. Amari. (2002). Neural Implementation of Bayesian Inference in Population Codes. Advances in Neural Information Processing Systems 14 (NIPS*2001).

29. S. Wu, H. Nakahara and S. Amari. (2001). Population Coding with Correlation and an Unfaithful Model. Neural Computation, v.13, p.775-798.

吴思Lab的研究方向为计算神经科学、类脑计算。实验室的研究兴趣是以数学模型和计算机仿真来构建神经系统的计算模型,解析神经系统处理信息的一般性原理,并在此基础上发展类脑的人工智能算法。目前开展的课题包括:视觉信息处理的动态交互机制、神经信息表达的正则化网络模型、神经突触短时程可塑性的计算功能、多模态信息处理、神经形态计算的模型等。

想了解更多吴思Lab的研究内容,可扫码关注

吴思Lab计算神经科学及类脑计算