对抗攻击最新研究:仅修改「一个像素」即可骗过神经网络!

作者:Jiawei Su、Danilo Vasconcellos Vargas、Sakurai Kouichi(九州大学)

摘要:在图像识别领域,基于DNN的方法克服了传统的图像处理技术,甚至达到媲美人类的结果。

最近的研究证实,深度神经网络(DNN)的输出不是连续的,对输入向量的微小扰动非常敏感,因此人们已经提出了几种方法来制定对网络的有效扰动。在本论文中,九州大学的科研人员提出了一种基于差分进化算法的极小对抗扰动(少像素攻击)的新方法。它需要很少的对抗信息,对更广泛的DNN模型类型有效。

结果表明,73.8%的测试图像可以在一个像素上修改为对抗图像,平均具有98.7%的置信度。另外,我们都知道,调查DNN的鲁棒性问题可以为高维输入空间理解DNN决策图的几何特征提供关键线索。与以前的工作相比,进行少量像素攻击的结果有助于对不同角度的几何理解进行定量测量和分析。

但需要注意的是,这种攻击在jpg格式下可能会失败,比如说,压缩或解压缩过程去除或减少了一些像素,但该论文并没有对此进行阐述。

介绍

在图像识别领域,基于DNN的方法克服了传统的图像处理技术,甚至达到媲美人类的结果。然而,一些研究表明,对自然图像的人为扰动很容易使DNN错误分类,因此提出了生成称为“对抗图像”的样本的有效算法。创建对抗图像的主要方式是将少量的调整好的附加扰动添加到正确分类的自然图像中,使人眼不可察觉。这种修改可能导致分类器将修改的图像标记为完全不同的东西。然而,大多数以前的攻击并没有考虑到有些特殊的对抗案例,即修改的数量有时在实施中,是可以被肉眼识别出来的。此外,研究在有限场景下创建的对抗图像更有趣,因为它们可能更接近源和目标类别之间的边界,并且研究这些关键点可能会给出关于DNN输入空间的几何特征的新见解。

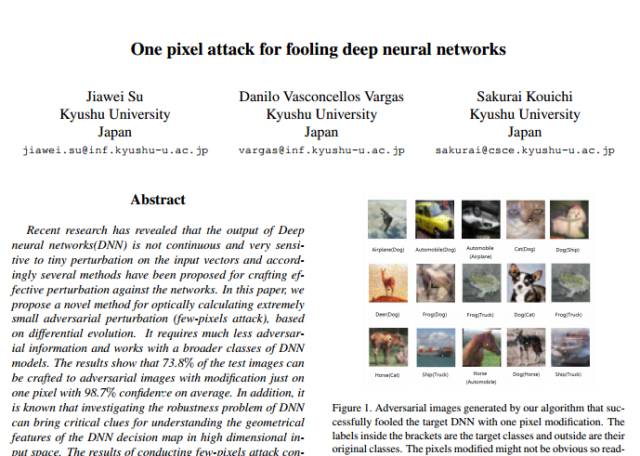

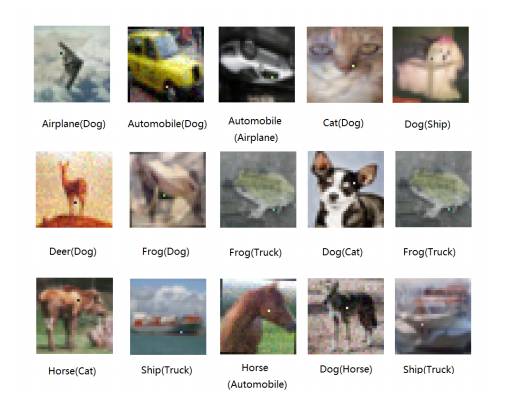

图1:仅修改了一个像素,我们的算法生成的图像便骗过了目标DNN。括号内的标签是目标类,而外部的标签是它们的原始类。修改的像素可能不明显,因此读者必须仔细查看

在本论文中,通过差分进化算法扰动几个像素(1024或1024像素中的1、3或5个像素),我们提出了一个黑盒DNN攻击,我们称之为“少像素攻击”,只有可用的信息是概率标签。 我们的建议主要有以下优点:

•能够通过修改1、3或5个像素,发起非目标攻击,成功率分别为73.8%、82.0%、87.3%,平均目标类别的概率标签为98.7%。

•仅需要黑盒反馈(概率标签),但不需要目标DNN的内部信息,如梯度和网络结构。我们的方法也更简单,因为它不会将搜索扰动的问题抽象到任何明确的目标函数来解决,而是直接关注改进目标类的概率标签值。

•可以攻击更大范围的DNN(例如,不可微分的网络或计算梯度比较困难的网络)。

我们使用少像素攻击有两个主要原因。

1)少像素攻击可以在实践中隐藏修改的效果。据我们所知,之前的论文都不能保证所做的扰动是完全看不见的。减轻这个问题的一个最直接的方法就是使扰动尽可能的小。具体来说,我们提出一个经验解,而不是理论上提出额外的约束或考虑更复杂的扰动成本函数,而是通过严格控制32×32图像中特定的1、3或5个像素中可修改的像素数量,即我们使用像素数作为单位,而不是扰动矢量的长度,以测量扰动强度,并考虑最差情况,对一个像素修改,以及另外两个场景(即3和5像素)进行比较。

2)几何上,以前的几篇论文通过限制像素修改的强度,分析自然图像的临近区。例如,通用扰动为每个像素增加了小的值,使得它在自然图像周围的球体区域中搜索对抗图像。另一方面,提出的少像素扰动可以被认为是使用非常低维的切片,切割输入空间,这是探索DNN输入空间特征的不同方法。

根据实验结果,我们工作的主要贡献包括:

•使用少像素攻击进行非目标攻击的有效性。结果显示,只有1个像素修改,有73.8%的图像可以被扰乱为一个或多个目标类,在3个和5个像素攻击的情况下,数据为82.0%和87.3%。我们证明,非敏感图像甚至比敏感图像更稀少,即使将扰动限制在这么小的范围内,因此,少像素修改是搜索对抗图像的有效方法,但在实践中几乎不会被人眼识别出来。

•自然图像可以伪装的目标类的数量。在1个像素扰动的情况下,每个自然图像平均可以扰动2.3个其他类。具体来说,有18.4%、17.2%和16.6%的图像可以被扰乱到1、2、3个目标类。在5个像素扰动的情况下,可以被扰乱到1到9个目标类别的图像的数量几乎相等。

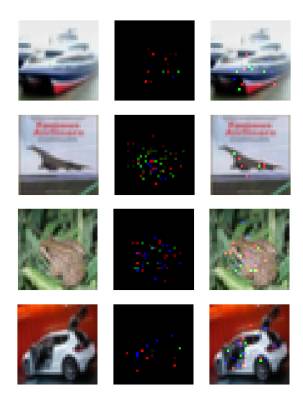

生成的对抗图像的图示。扰动是在总像素的约4%上进行的,并且可以很容易被人眼识别。 由于对抗像素扰动已经成为生成对抗图像的常见方法,因此可以通过专业知识识别出这种异常“噪声”。

•与特定目标类相似的扰动方向。通用扰动的有效性表明,许多图像可以通过类似的方向进行扰动,使得决策边界可能泄漏多样性,而我们的结果表明,属于同一类的数据点总是可以更容易地被扰乱到具有相同数量扰动(即1、3或5个像素的修改)。

•对高维输入空间数据点分布的几何理解。在几何上,通过进行少像素攻击获得的信息也可以被认为是通过使用简单的低维切片,切割输入空间,而获得的横截面上的类别标签的变化的定量结果。特别的是,我们的研究结果表明,一些决策域可能对许多不同的方向有很大的深度,但在这些深度区域内,决策域相当窄。换句话说,这些域可以在输入空间中朝向不同方向具有许多长而薄的延伸突触。

结论

在本论文中,我们提出了一种用于产生对抗图像的基于差分进化算法的方法。实验结果表明,我们的建议在非常有限的条件下生成对抗图像是有效的。例如,在理想的情况下,可以通过总共1024个像素中的一个像素扰动来完成。我们还讨论了我们的结果如何有助于定量地了解高维输入中DNN的几何特征。