专访Ian Goodfellow:不积跬步无以成就GAN

编者按:近日,NeuroAscent联合创始人、数据科学家Sanyam Bhutani对Ian Goodfellow博士进行了一次采访。在他们的对话中,深度学习研究员、GAN之父Goodfellow回顾了自己当年的科研经历,简要介绍了自己对于科研、行业和未来发展的一些看法。

Sanyam Bhutani:您好,GAN之父,感谢您愿意接受我的采访。

Ian Goodfellow:非常欢迎!非常感谢你愿意采访我,以及撰写博客来帮助其他学生。

Sanyam Bhutani:作为Google AI的研究科学家,同时也是生成对抗网络(GAN)的发明人,您能向我们的读者透露一下自己的科研经历吗?比如您是什么时候开始研究GAN的?是什么让您对深度学习产生了兴趣?

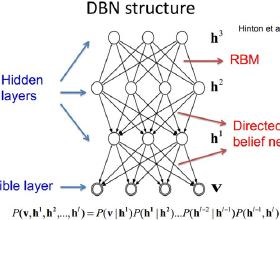

Ian Goodfellow:我从本科开始就已经在研究人工智能了,只不过那时机器学习主要是SVM、boosted tree等。在课余,我也是游戏编程的业余爱好者,会用GLslang制作一些小项目。一次,我的朋友Ethan Dreyfuss(他现在在Zoox工作)告诉了我两件事:Geoff Hinton在谷歌的技术演讲上提到了深度信念网络(DBN);CUDA GPU。

我当即就意识到深度学习能弥补SVM带给我的很多缺憾。一方面,SVM在设计模型上不够自由,投入更多数据资源后,它不会直接变得更“智能”,但深度神经网络可以随着投入数据的增加不断提升性能。另一方面,CUDA GPU能允许我训练更大的神经网络,由于有游戏编程经验,我知道该怎么编写GPU代码。

就在那个寒假,我和Ethan在斯坦福大学搭好了第一台CUDA计算机,并用它开始训练玻尔兹曼机。

Sanyam Bhutani:正如您所讲的,你只花了一晚上就写出了第一个GAN,但一般在研究上作出突破都至少需要几个月甚至几年。您能谈谈自己为什么能在一夜之间就实现突破吗?

Ian Goodfellow:如果你有一个和新想法相关的高质量codebase(代码库),实现这个想法其实很容易。早在几年前,我和同事就已经围绕Theano和Pylearn2的库做了很多工作,它们都是第一个GAN的构建基础。早年有篇论文叫Maxout Networks,我们曾仿照它自己写了个MNIST分类器,到训练GAN时,我们直接复制了分类器的代码,论文的超参数在GAN里也很好用,所以我们基本没做什么更新。再加上在MNIST上训练用时很短,我认为第一个MNIST GAN只花了我大约一小时的时间。

Sanyam Bhutani:自发明以来,我们在GAN上看到了很多可喜的进展,您最欣赏其中的哪一个呢?

Ian Goodfellow:这很难选。当Emily Denton和Soumith Chintala提出LAPGAN的时候,我第一次意识到GAN的广大前景。当然,LAPGAN只是暴风雨前的一朵小浪花。

Sanyam Bhutani:除了GAN,你最好看深度学习的哪个领域呢?

Ian Goodfellow:我在研究模型对于对抗样本的稳健性上花了不少时间。为了把机器学习用于实际应用,确保它的安全性非常重要。我也希望这项研究能帮我们更好地理解什么是机器学习。

Sanyam Bhutani:对于那些有兴趣从事深度学习的读者和初学者,对于那些梦想着有一天能进入Google工作的人,您有什么好的建议吗?

Ian Goodfellow:首先要学习基础知识:编程、debug、线性代数、概率论。大多数高级研究项目最看重一个人的基础知识掌握水平,而不是他对先进技术的了解程度。举个例子,今天我就在调试内存泄露,因为它让我没法实验,我也在加快软件库的单元测试,以便尝试更多研究思路。当我还在读本科、读博士的时候,我经常会向吴恩达讨教,他建议我一定要彻底掌握这些基础知识。那时我觉得这些工作很无聊,希望他能多跟我说说超实数之类的东西,但现在几年过去了,我觉得他的建议真的是正确的。

Sanyam Bhutani:您能跟我们说说您在Google的一天是什么样的吗?

Ian Goodfellow:对于不同人,甚至是同一个人的不同人生阶段,这种体验是非常不一样的。有时候,我就是写写代码、跑跑实验、读几篇论文,或者写写书。有时候,我就需要花大多数时间参加几个不同的会议,检查许多不同的项目。现在我在检查别人工作上花去的时间要占60%,处理自己的项目则占40%。

Sanyam Bhutani:有一种普遍想法是,如果想在深度学习中取得重大成果,一个必要前提是有大量资源。您是怎么看待这个观点的呢?你是否觉得存在那么一个人,他没有Google能提供的那么多资源,但他最终做出了突破性贡献?

Ian Goodfellow:我同意,当然存在这么一个人,但他首先得选好合适的研究项目。比如证明一个有趣的理论结果可能不需要计算资源,设计一个只需极少数据但性能好、通用性强的算法也不需要超大型数据集。但是,如果你没有足够多的硬件做并行计算,你最好不要去挑战构建全世界训练速度最快的ImageNet分类器。

Sanyam Bhutani:鉴于研究成果的爆炸性增长,您是怎么让自己与时俱进的?

Ian Goodfellow:不久前,我觉得自己已经掌握了深度学习的所有知识,尤其是在我编书的时候。但现在我做不到了,我真的只能关注和自己的研究有关的主题,我甚至都说不清GAN发生了什么变化。

Sanyam Bhutani:您觉得机器学习被高估了吗?

Ian Goodfellow:就其长期潜力而言,我实际上认为机器学习还是被低估了,因为外行人还没有像我们一样对它津津乐道。但我认为机器学习确实经常被“错误炒作”:人们会夸大现阶段这种技术的可能性,或者夸大个别项目的进展等。

Sanyam Bhutani:您认为非机器学习专业的博士/硕士能否为深度学习领域做出贡献?

Ian Goodfellow:我认为培养专业知识很重要,但我不认为博士学位是获得这种专业知识的唯一途径。最优秀的博士生往往都是自学型人才,只要有足够时间学习,他们也能做到边工作边成长。

Sanyam Bhutani:最后,您能给那些对深度学习感到不知所措的初学者一些建议吗?

Ian Goodfellow:从一个简单项目开始,重新实现那些你已经了解,而且知道肯定能成的东西,比如CIFAR-10分类器。很多人都会想一开始就直接去做一些新的事情,然后项目失败了,你也不知道是项目本身行不通,是你自己的思路有问题,还是你对一些关键点的理解有误。我觉得有一个可以实践的项目很重要:深度学习有时就像开飞机,你可以读很多东西,但你也要亲自上手体验并发现另一些直观的经验。

原文地址:hackernoon.com/interview-with-deep-learning-researcher-and-the-ganfather-dr-ian-goodfellow-cd300863ecff