ICML2018对抗生成网络论文评述

编者按:《GANs in Action》作者Jakub Langr评述了在ICML 2018上发表的GAN论文,以及相应报告。

郑重声明,我非常尊重研究人员在ICML上发表的所有惊人工作。我离他们的水平还差得远,感谢他们为推进这一领域研究所做的贡献!

参加ICML总体上是一次很棒的体验。不过本文的主题不是我的想法、印象、体验。整个工业界正缓慢地滑入学术会议,我觉得我也许可以更进一步,总结一下从业者最感兴趣的ICML上GAN方面的成果。

这意味着,在我看来无法为最终目标主要不是发表论文的人所应用的那些学术贡献,我的评价会打上一些折扣。这也意味着,我会使用更平易近人的语言,不会深入论文的理论或技术细节。另外,这还意味着,我会给出一些个人的意见和想法,其中一些意见和想法,你可能并不赞同。我希望这篇文章对机器学习从业者有用,特别是那些初入这一领域的人。我在准备这次会议的时候大概读了50篇这方面的论文,所以我想为他们提供一些上下文。

本文中的解释常常是简短而粗糙的,另外不是每篇论文的主题都是GAN。

我的公司Mudano提供了培训的预算,我选择把部分预算用于参加ICML,机器学习的三大顶会之一。这是一次令我增广见闻的独特体验。为了更好地总结参会的收获,我决定记录大部分接触到的论文。本文按照ICML的议程排序。我没有列入周六、周日的内容,因为那两天大部分是workshop。(我参加了可重现机器学习的workshop,我希望大多数机器学习从业者至少有些熟悉这一主题。如果大家对此感兴趣,我以后会写文章介绍。)

11日,周三

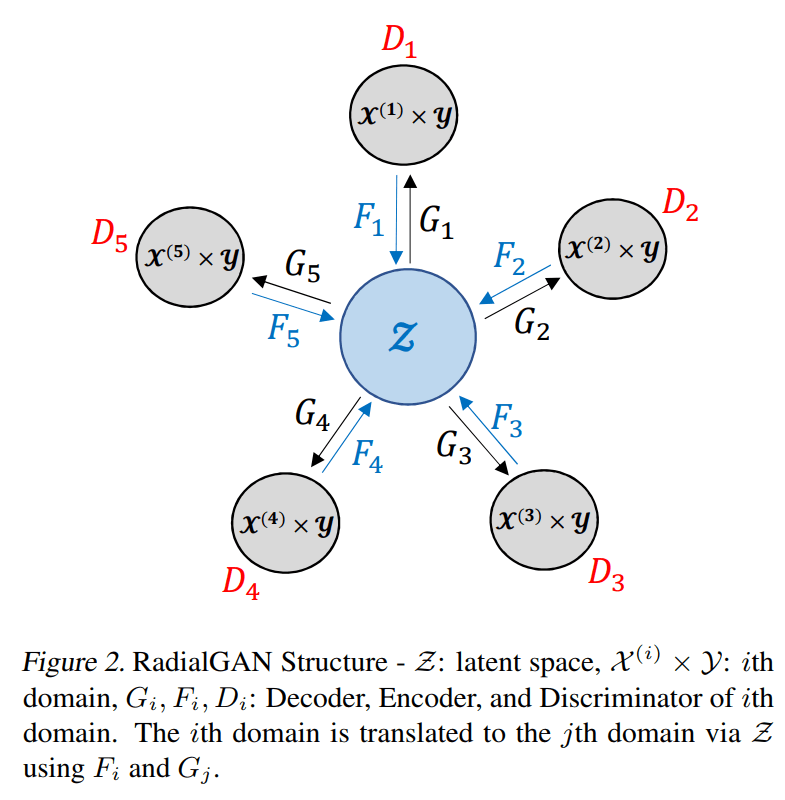

RadialGAN

GAN的优势部分在于半监督学习和数据增强。基本上,RadialGAN让我们可以利用多个不同来源的数据集,通常这能带来更好的表现,即使在某些数据集质量不高或者和手头任务关系不密切的情况下也是如此。RadialGAN首先将数据集转换为共享的潜空间,接着再将潜空间转换为手头任务的目标域。

我个人非常喜欢这篇论文。这篇论文在工业界有很大的潜力。报告很清晰。我的一个同事很为RadialGAN的潜力激动。如果能将RadialGAN应用到你手头的问题上,相信效果会大为不同。

ILVM

基本上,ILVM通过人工介入的主动学习方法确保我们能以更容易让人理解的方式解释潜空间。虽然有潜在的降低精确度的风险,但能让我们说明潜空间的哪个维度影响哪个性质。

听起来很有趣,因为通常解释清楚潜空间和生成样本之间的变换需要大费周折。报告的表述不是非常清晰。

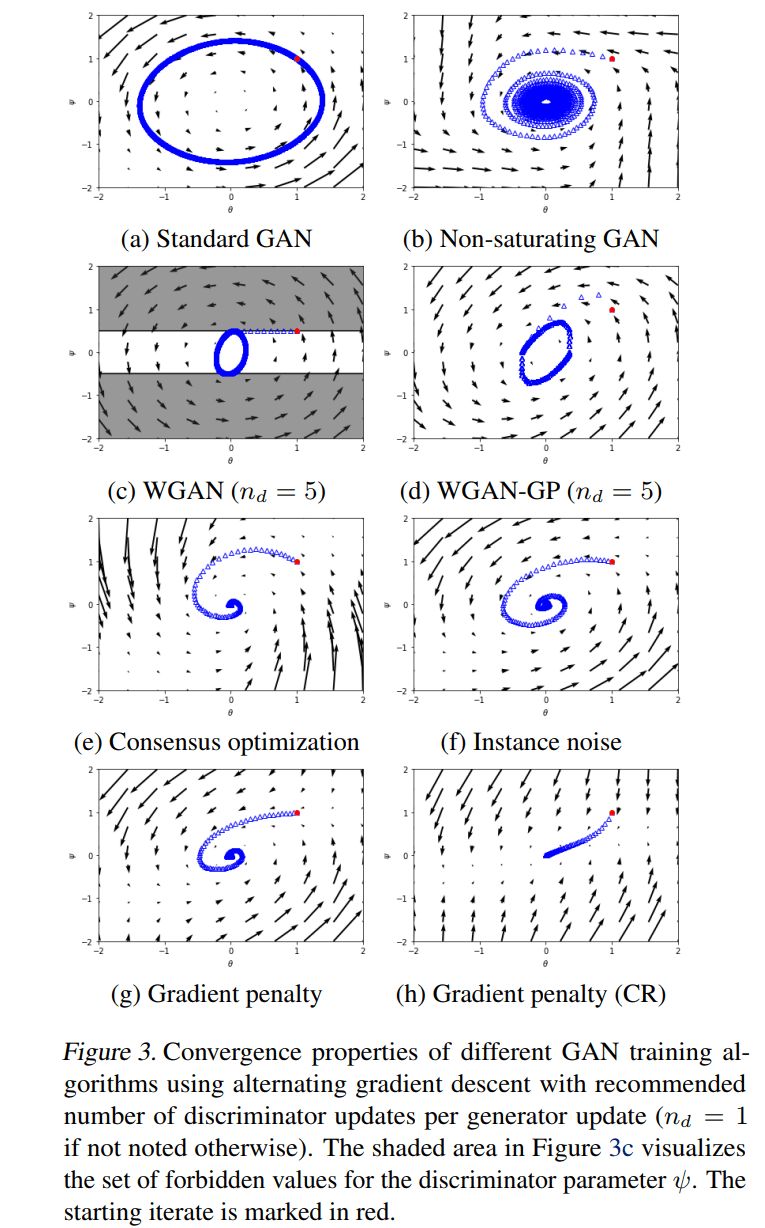

哪种GAN的训练方法真能收敛?

Lars等发表的这篇论文通过在GAN的训练过程中施加特定类别的梯度惩罚,在较老的架构上取得了当前最先进的表现(在该项基准测试上超过了之前最佳的学术成果)。相关代码见GitHub:LMescheder/GAN_stability

令人印象相当深刻的成绩。所用的技术比较复杂,但花一些时间理解这一技术应该是值得的。之前有一些类似的研究,但这次取得的结果让这一技术的价值不言而喻。在无需渐进增长的情况下取得PGGAN等级的结果!

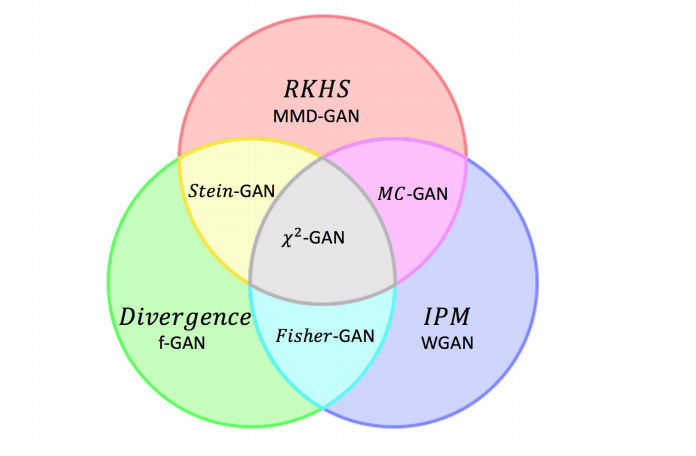

气平方GAN

气平方GAN结合了GAN的三种不同思路:

中央的x2-GAN即气平方GAN

这篇论文的理论价值大概很高,但对从业者而言,实际用途看起来多少比较有限。

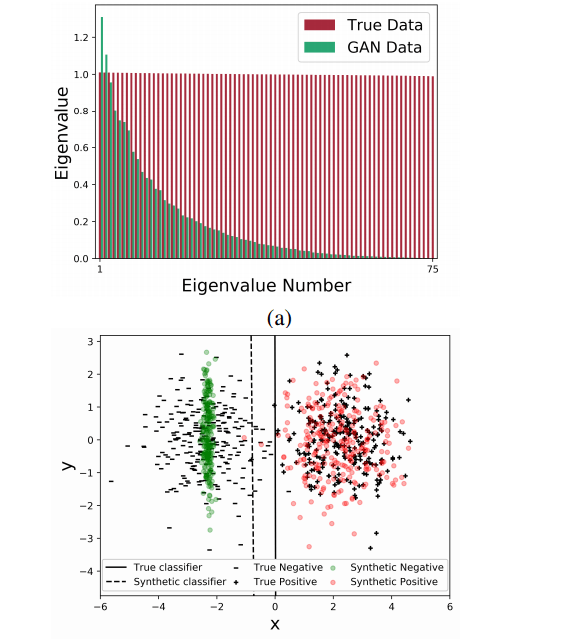

基于分类的GAN分布协方差偏移研究

Santurkar等的这项检测模型崩塌(mode collapse)的研究很酷。学术界常常需要尝试检测训练中出现的问题,在这方面这篇论文意义很大。

我觉得为评估训练质量提供一个一致的基准真是功莫大焉。不过我更偏爱其他测度。但是这项研究提出的方法大概可以作为测度集成的一部分使用。

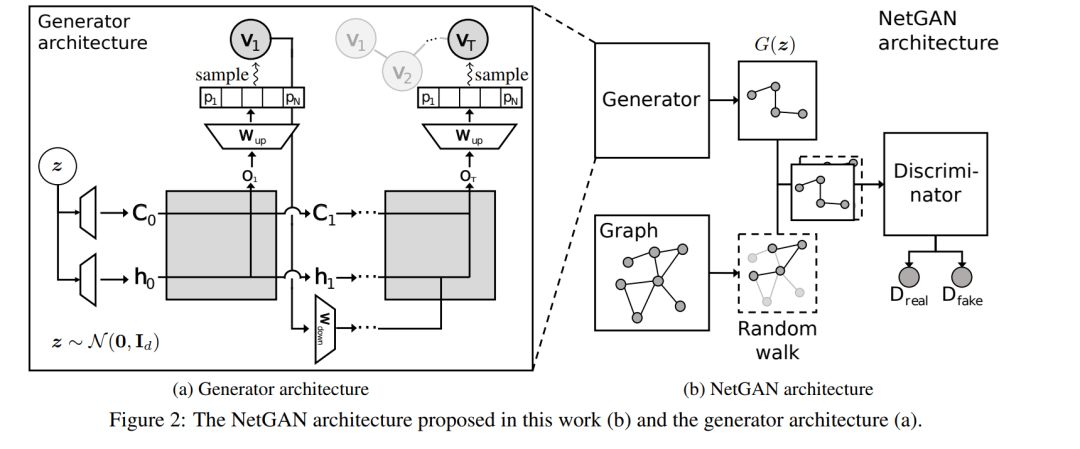

NetGAN

挺有趣的工作,展示了GAN可以应用于生成非常复杂的图。NetGAN取得了当前最先进的表现(据链接预测精确度)。

12日,周四

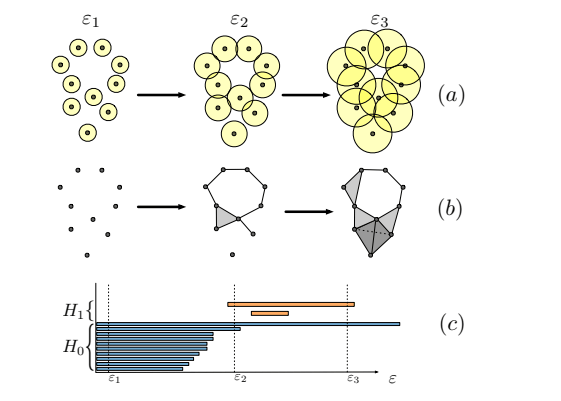

几何学评分

这项工作提出了一种基于拓扑分析构建的通用测度,可以评估成功覆盖了多少比例的原数据集,并通过逼近计算生成数据集的多样性。

实际上我对此感到非常兴奋,因为它让我们可以评估任何领域的GAN并检测模型塌缩。在这项工作之前,我们完全没有通用的评估方法。也许以后有一天,我们甚至能看到评估质量的通用方法。

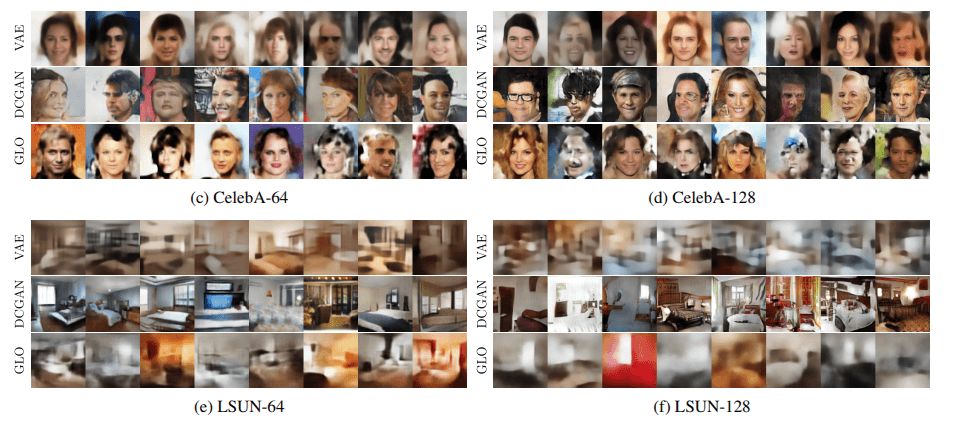

GLO

GLO与典型的GAN设置不大一样,它的目标是创建能够生成更好样本的模型。GLO优化生成网络的潜空间,聚焦于模型塌缩问题和生成不一样但足够类似的样本。

我对这篇论文感觉有点复杂。一方面,我觉得这篇论文写得主观性很强——在学术界这可不同寻常——我不同意其中的很多东西。另一方面,在ICML期间的非正式讨论事实上非常好,提供了很多信息。在讨论时,有一个研究者提出了一个有趣的观点,模型塌缩正是GAN奏效的原因。这是一则迷人的断言,我很想知道是不是果真如此。关于这篇论文还有一桩趣闻,这篇论文被ICLR拒了,作者们重新在ICML上发表了。

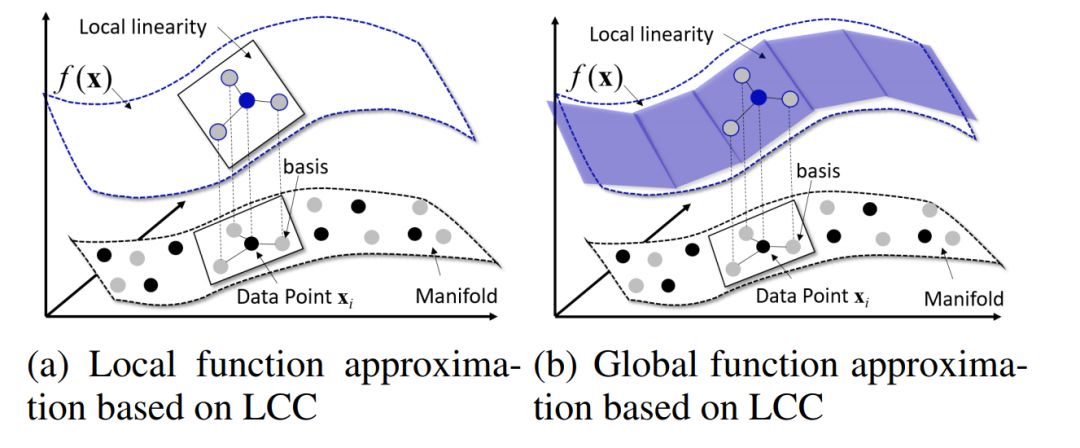

LCC

LCC试图通过局部坐标编码提升GAN的表现,这让潜空间更复杂了。报告的表述不是非常清晰,但主要思想是探索流形假说——某个低维潜空间和复杂流形(例如,图像)间存在一个映射。所有GAN归根打底都取决于这一假说。但如果你思考这个映射的话,它看起来显得有些奇怪,你可以在这么低维的空间表示所有图像。由于某种原因,这篇论文没有对比当前最先进方法。

3D点云的学习表示和生成式模型

3D点云,谁不爱?太酷了。在这篇论文中,作者创建了一个更为强大的模型以生成一般物体的3D点云。尽管仍有许多需要改进的地方,总的来说效果很赞。

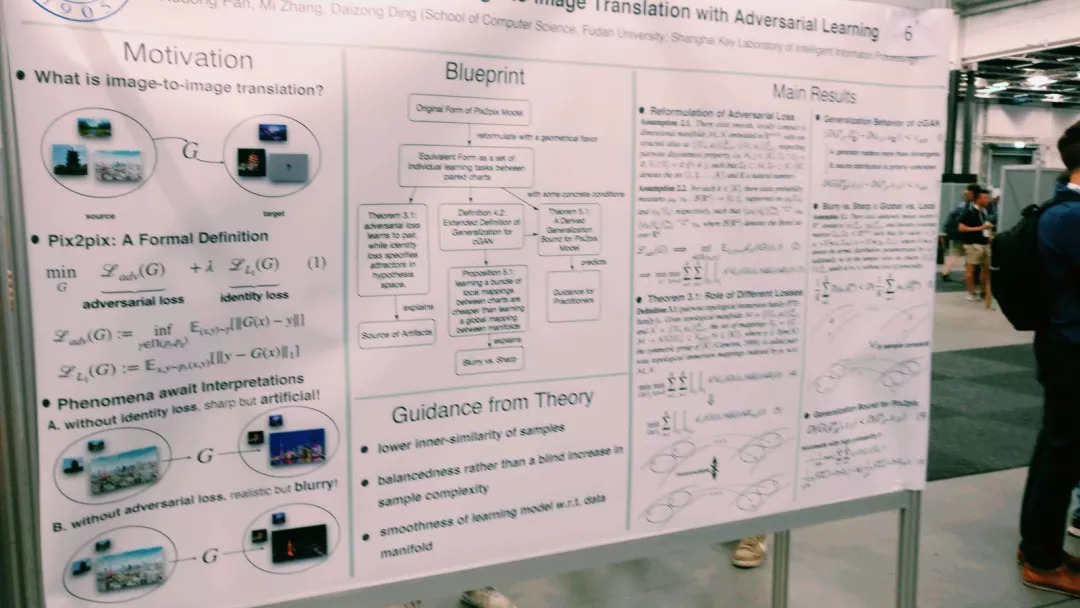

对抗学习图像到图像转换的理论分析

这篇论文分析了GAN的配对转换,主张配对图像转换的损失基本上由两部分组成。身份损失(identity loss)确保图像是正确的,而对抗损失(adversarial loss)确保图像是清晰的。

这是一项有趣的理论工作,但目前而言从业者大概用不到。同时论文中一张图也没有,所以我这里附上了招贴画上的图像(不好意思,拍糊了!)。

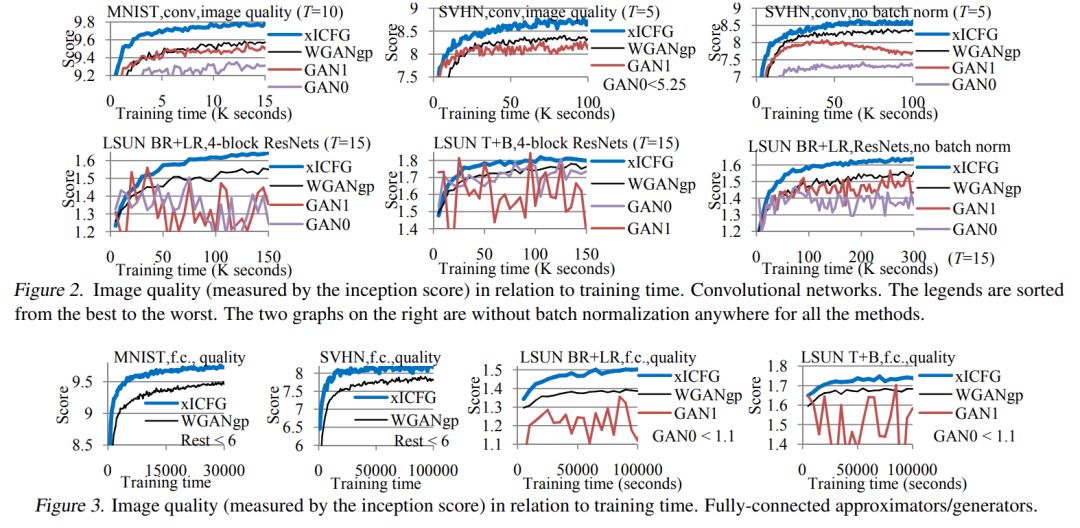

复合函数梯度

这篇论文引入了一种看起来有理论支持的更为复杂的训练算法(渐进式复合函数梯度,ICFG),接着又创建了一个逼近ICFG的算法版本xICFG,在训练过程中加入了if语句,在我看来感觉像是一种ad-hoc。最终结果超过了当前最先进的水平,但我一般不太喜欢增加这么多复杂度的方法。

调和对抗网络

这篇论文背后的高层想法很有趣。和PGGAN类似,作者也认为GAN的问题在于刚开始面对的任务太难了。因此作者转而创建了一个网络,给图像加上了一点变形,让生成器的任务轻松一点。采用这一方法后,表现超过了当前最先进水平。

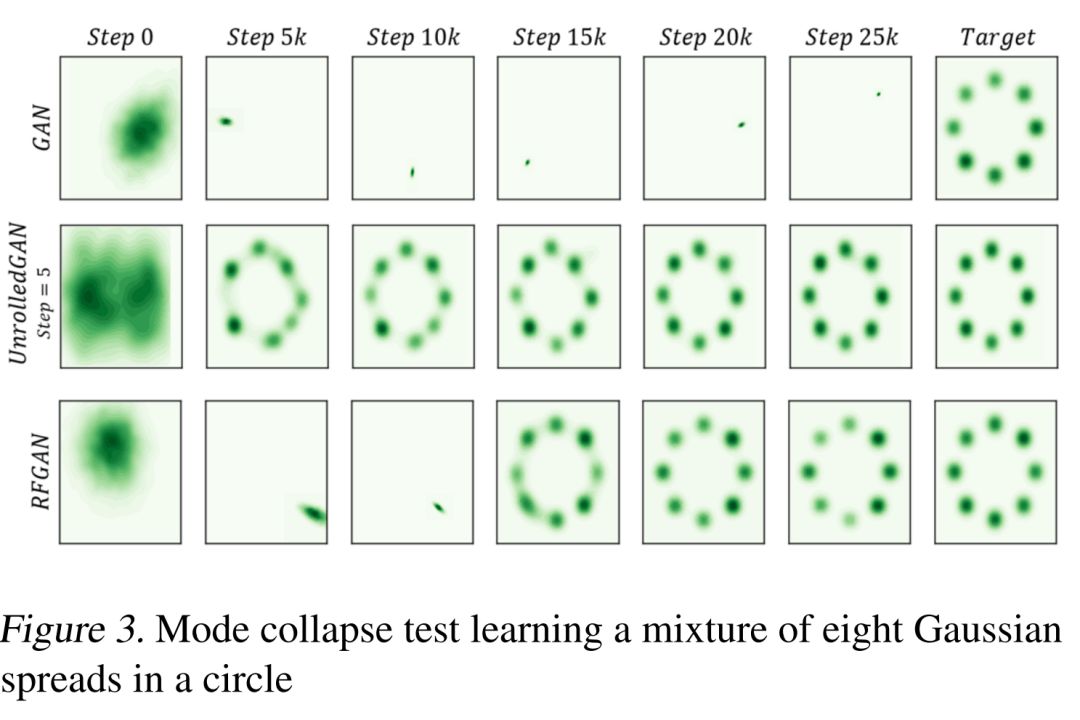

RFGAN

基本上,这篇论文连接了生成图像的自编码版本,传给判别器作为参考。招贴画极为清晰地描述了这一架构,只可惜我的手机好像丢失了相关照片。

所得结果超过了当前最先进水平,但超得不多,所以我不太确定这是否可以算是一项突破。

计算精确Wasserstein距离

这篇论文引入了线性编程以可控地计算精确的Wasserstein距离,并据此改善训练。Wasserstein距离的问题在于,即使简单的点云也会带来组合性的复杂度,使得精确距离的计算变得相当复杂。这篇论文做到了这一点,并且战胜了当前最先进的模型。

论文中用于基准测试的数据集既简单又有限(MNIST、CIFAR-10),所以我很想知道这一方法在Celeb-A HQ和ImageNet-1000这样的数据集上表现如何。

Jacobian clamping

和其他一些ICML上的论文一样,我老早就读过这篇论文,但作者们在招贴画上非常出色地简要总结了结果。基本上,他们使用Jacobian clamping控制生成器更新从而达成稳定得多的训练。虽然表现没有明显提升,但稳定性方面的提升表明了这一技术的价值。

作为从业者,如果你碰到GAN稳定性的问题,这是值得尝试的论文。

GAIN

这也许是从业者最感兴趣的论文之一,因为它处理的是我们经常碰到的问题——缺失数据。它创建了带有提示机制的GAN配置,以推断匹配分布的缺失值。我们知道GAN很擅长创建生成式分布。提示机制的加入很有必要,否则这一问题对判别器而言太难了——部分缺失数据和真实数据有太多合理的排列组合,没有提示机制问题很快会失控。

我已经给一些同事安利过这篇论文。

基于受限查询和信息的黑盒对抗攻击

这是为数不多的真实对抗攻击论文。技术上说,其中并没有涉及GAN或者生成式建模——我猜除了扰动的部分涉及一点——但这是一篇以非常有趣的方式进行真实对抗攻击的论文。

我仍然认为深度学习模型还没有普及到可以让这一对抗攻击造成任何实际伤害,但这篇论文涉及到了实际的问题。

一等GAN

这篇论文背后的思路是在WGAN-GP之类的梯度惩罚的情形下,与其优化WGAN损失接着加入惩罚,不如直接优化带有惩罚的损失。作者们说,在一些病态情形下,优化损失接着加入惩罚会让生成分布不那么接近目标分布。在招贴画周围有人(不是我)写了一些非正式的质疑和证明,但我可不会拿这些去逼问作者们的,哈哈哈。

SPIRAL

DeepMind的这项工作使用GAN生成能够控制笔刷的程序,可以学习绘制任意风格的作品。

MAGAN

好吧,我现在相当确定MAGAN是流形对齐GAN(Manifold Alignment GAN)的简称,虽然报告的时候从来没提到这点。但当我第一次见到一个美国人报告这样一篇论文,我还以为这个名称有什么政治寓意呢,哈哈。(译者注,作者这里应该是联想到了川普的口号Make America Great Again)。基本上,MAGAN通过添加对应损失确保两个流形总是一致对应的(而不是像其他算法中那样随机对应)。

有意思的珍品。在报告之后,有人“提问”,声称上一届NIPS已经有一篇论文做的是一模一样的事情。作者不知道那篇论文。你怎么看?

时刻到事件的对抗建模

这篇论文和GAIN的领域类似,只不过聚焦于时序数据,并且大致可以得到更好的特定时间的时刻分布的概率分布(基本能够自动推断)——例如医院中的并发症。

对处理时序数据的人而言,这是篇很有用的论文。

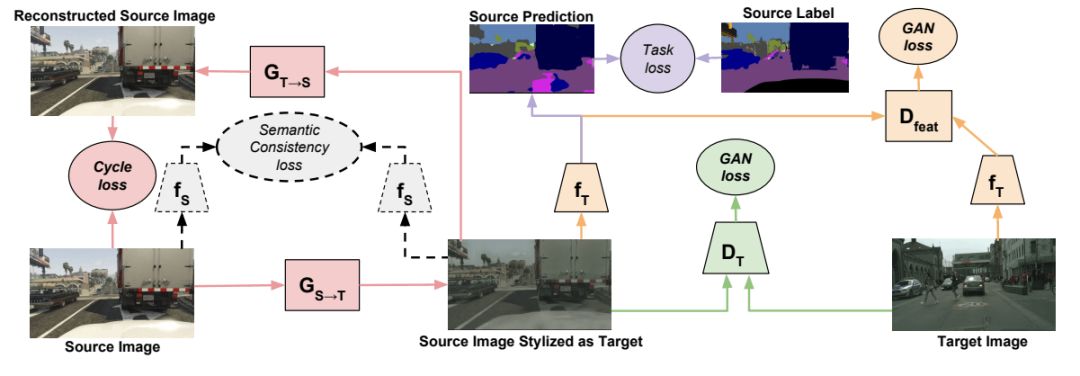

CyCADA

这篇论文应对的是大量从业者在GAN上反复碰到的问题:我们的模型没有概括性。我们经常碰到这样的事情,部署在ImageNet(打个比方)上训练的模型,然后发现它的表现很糟糕。这只是因为,即使只考虑ImageNet上的分类,真实世界也比ImageNet复杂得多。CyCADA扩展了CycleGAN,基本上可以在实现领域到领域的变换时保证正确语义。所以CyCADA具有应用于自动驾驶汽车之类的场景的潜力,可以在安全、可伸缩的计算机生成环境中创建自动驾驶汽车,接着转换机器学习系统至真实世界。

真的很有趣!绝对值得一试。

AIQN

技术上说,这篇论文并不涉及GAN。AIQN“不过”是一个自回归模型,但它能够生成和当前最先进的GAN的水平相当的结果。真的很令人印象深刻,但和所有自回归模型一样,这个设定在放大上很成问题。报告之后,作者提出可以使用自动编码器来放大图像,但这又带来了一堆新的挑战。

这是一个有趣的方法,但有人做过类似的工作(虽然生成图像质量不如这项工作好),这些工作都没能跨过32×32的像素限制,AIQN也是一样。很多人尝试过,但都没能克服这一限制。除非能突破限制,否则我们不太确定这类方法是否真能放大;注意GAN已经进入1024×1024的时代。

M-BGAN

不同于常规的GAN,M-BGAN使用真实数据和合成数据混合的batch,进一步提升判别器的能力。正如作者们在总结部分所说:“一个简单的架构技巧使其能够可证实地复原所有作为无序集合的batch的功能。”

我真心喜欢这篇论文,因为它是一个优雅的想法,同时总结部分很好地总结了这篇论文。让我们拭目以待,看看这是否会成为占据统治地位的框架。不过我觉得作者们引用其他架构的方式有点奇怪(全部引用同一篇论文)。

JointGAN

这是一个类似CycleGAN的架构,不过CycleGAN仅仅推断条件分布,而JointGAN联合学习每个域的边缘概率分布。刚开始,它通过噪声生成X,接着以X为条件基于边缘概率分布生成Y。

我发现报告有点含糊,但结果看起来真是很有趣。生成的文本看起来真是令人印象深刻,不过接着作者说这实际上是由一个自动编码器从潜空间生成的文本,而这个自动编码器是由GAN生成的。

AugCGAN

AugCGAN是增强CycleGAN(Augmented CycleGAN)的简称。这真是一个非常酷的CycleGAN扩展。和标准形式的CycleGAN相比,AugCGAN在第一次和第二次生成时插入了潜空间。CycleGAN的循环一致性损失(Cycle-consistency loss)是通过diff(X1, X2)衡量的,其中X1 -> Y -> X2. 基本上AugCGAN为我们提供了一个额外的变量,让我们可以创建具有特定属性的样本。例如,如果我们在Y域中有鞋子的轮廓,我们可以生成X域中的样本,鞋子的颜色是蓝色,或橙色,或任何我们选择的颜色。

如果你喜欢CycleGAN,但想要更多控制转换过程,你会喜欢这篇论文的。

GAN动力学中一阶逼近的局限

这是一篇主要通过简单示例进行论证的纯理论论文。要点是解释了多判别器更新的意义。这篇论文考虑了极端情况,展示了最优判别器情形下良好的收敛性质。但除此之外,目前而言大概没什么从业者感兴趣的内容。

结语

这些就是ICML上关于生成对抗网络的论文了。我希望这篇文章对你有帮助。我会在十二月份参加NIPS,如果你想要看到类似这篇的总结,请告诉我。

感谢Karen Trippler和Mihai Ermaliuc的评论!

想要加入对话?欢迎在jakublangr.com上评论,或者发推给我(langrjakub)。我正在撰写一本关于对抗生成网络的书,这里有一些样章:www.manning.com/books/gans-in-action 论智公众号(ID: jqr_AI)后台留言icml2018gan可获取上述所有论文的打包下载地址。

原文地址:http://jakublangr.com/icml-gans.html