Attention!注意力机制模型最新综述(附下载)

来源:专知

本文多资源,建议阅读5分钟。

本文详细描述了Attention模型的概念、定义、影响以及如何着手进行实践工作。

[导 读]Attention模型目前已经成为神经网络中的一个重要概念,本文为大家带来了该模型的最新综述文章,详细描述了该模型的概念、定义、影响以及如何着手进行实践工作。

介绍

本篇综述提供了关于注意力模型的全面概述,并且提供了一种将现有注意力模型进行有效分类的分类法,我们调查了用于不同网络结构的注意力模型,并显示了注意力机制如何提高模型的可解释性,最后,我们讨论了一些受到注意力模型较大影响的应用问题。我们希望本次综述能够为为大家提供一份简明扼要的介绍,帮助大家理解这一模型并着手进行实践。

注意力模型(AM)自机器翻译任务【Bahdanau et al 2014】首次引入进来,现在已经成为主流的神经网络概念。这一模型在研究社区中非常受欢迎,适用领域非常广泛,包括自然语言处理、统计学习、语音和计算机视觉方面的应用。

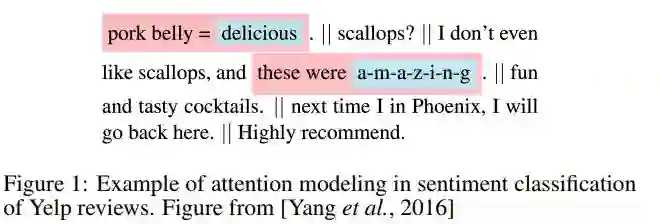

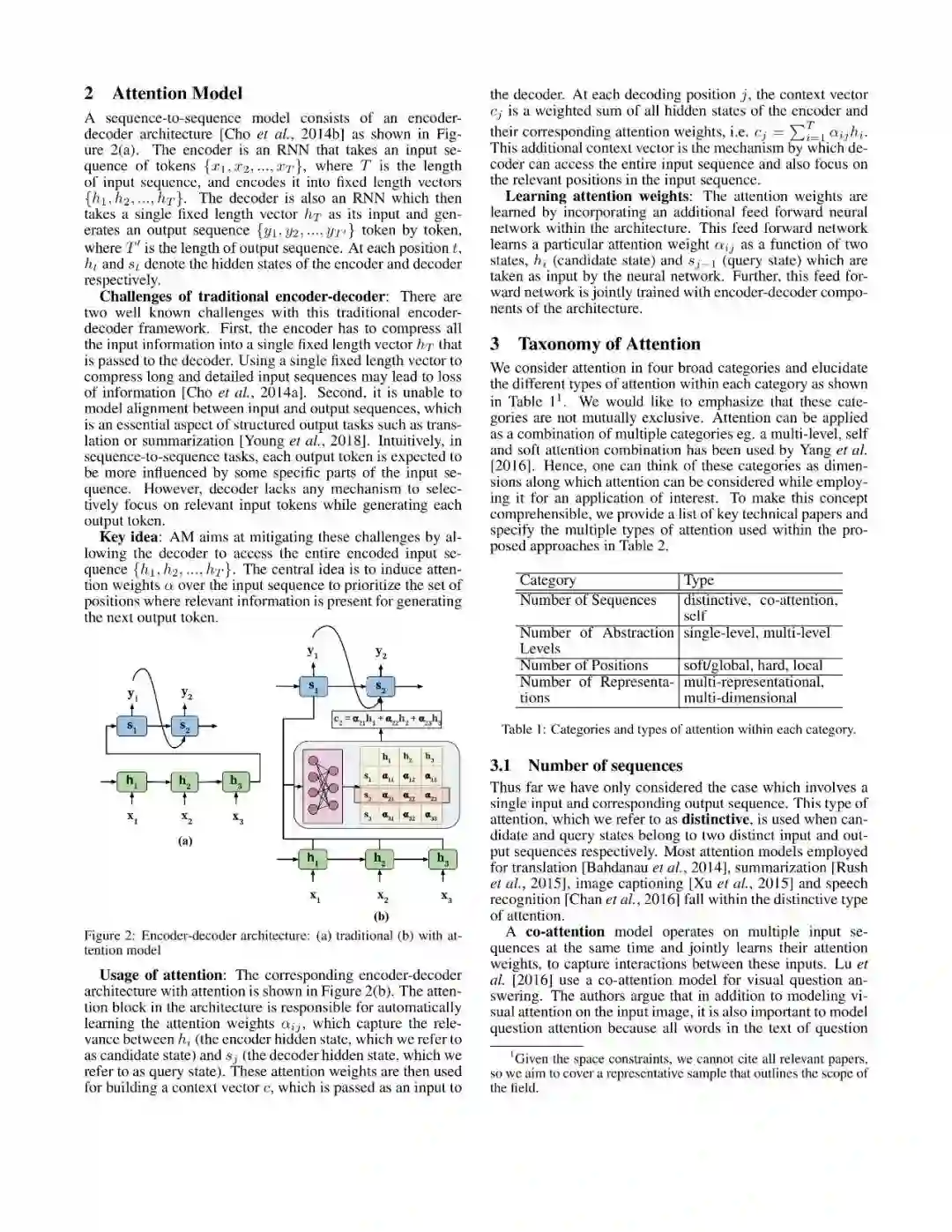

注意力模型的思想可以通过人类生物系统来进行解释,例如,在我们的视觉系统中,更倾向于关注图片的某一部分,而忽视其他不相干的信息,这样有助于提高感受能力。相似的,在某些问题涉及到文字、语音与视觉的任务中,部分信息的重要程度要明显高于其他信息,例如,在翻译与摘要任务中,输入序列中只有部分词汇与下个词的预测有关。同样的,在图片描述问题中,输入图像的某些区域可能对描述词更加相关。AM整合了这种相关信息,允许模型对某些有用的输入信息,动态的提供注意力,以此提高模型的性能,例如在文本分类任务中。

注意力模型的飞快发展可以被总结为三个理由:

这些模型是很多任务的state-of-the-art,例如机器翻译、问答系统、情感分析、词性标注、对话系统等;

除了提高任务性能之外,还带来了其他几种优势。如,提高模型的可解释性等;

AM解决了RNN模型的很多问题,例如在面对长文本时的性能衰减,以及计算序列数据对任务的权重影响等。

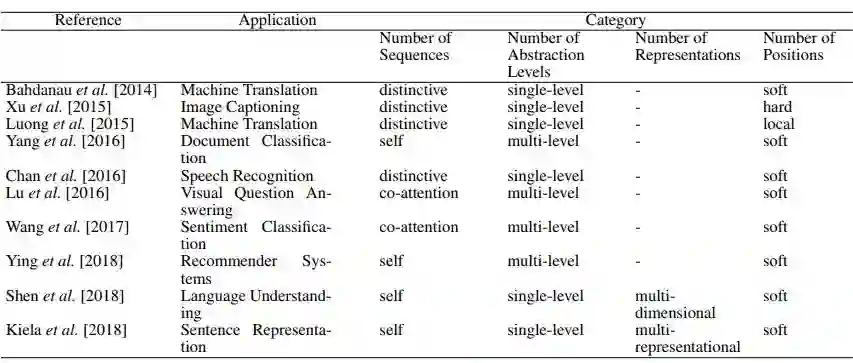

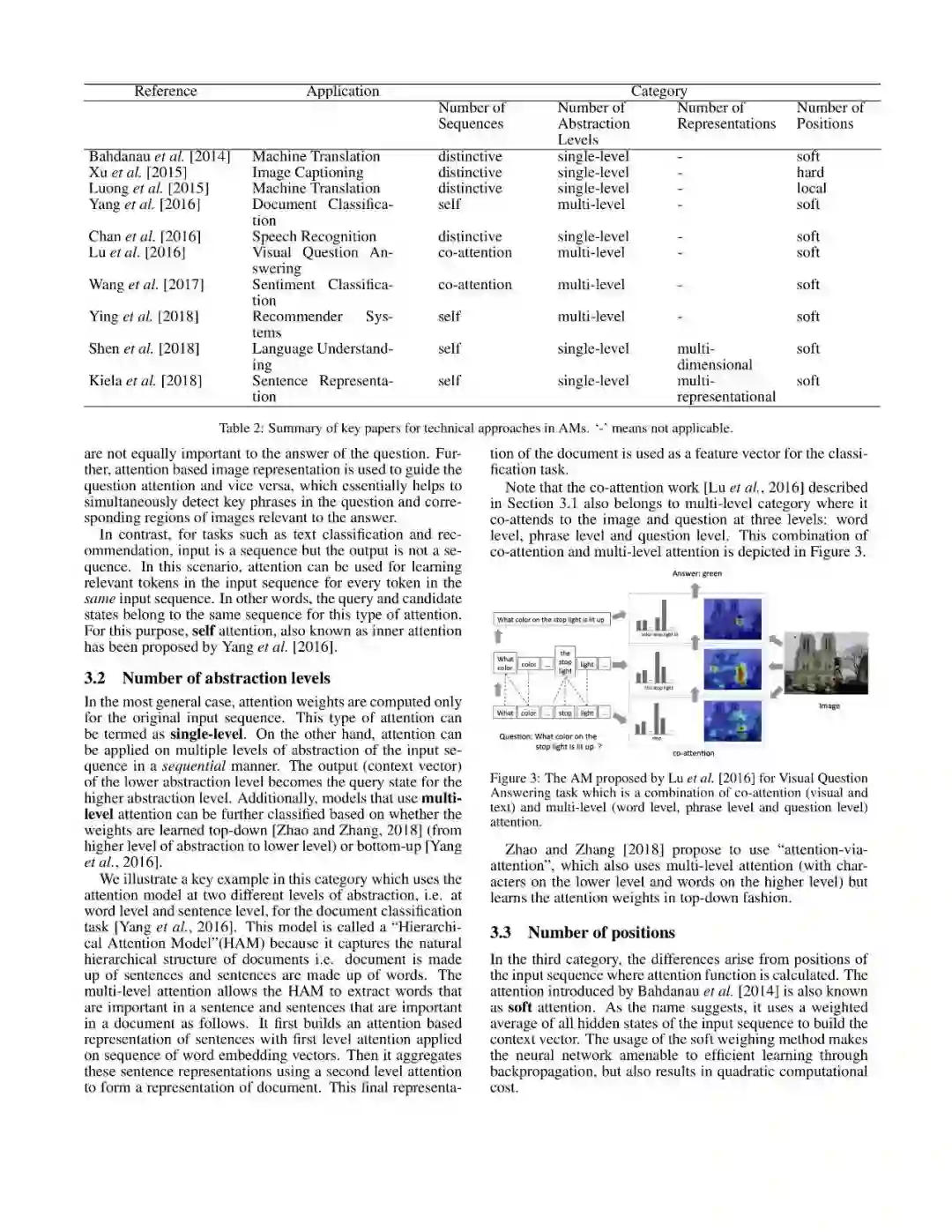

文章从Number of Sequences、Number of Abstraction Levels、Number of Positions、Number of Representations等多个维度对注意力模型进行了分类,具体结果如下:

后台回复“20190408” 即可获取《Attention 模型最新综述》的下载链接~

附全文预览:

编辑:文婧

校对:林亦霖