CSIG云上微表情第五期研讨会成功举办--微表情数据库背后那些事

微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)主办、CSIG机器视觉专业委员会承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

第五期云上微表情于2020年9月28日晚8点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座邀请到了英国曼彻斯特大学的Adrian K. Davison博士、京东数科的颜文靖博士、首都师范大学的曲方炳博士和中国科学院心理研究所的李婧婷博士,主要介绍了SAMM、CASME、CASME2、CAS(ME)2微表情数据库以及微表情编码和分享系统。本次报告得到了微表情研究领域的广泛关注,期间有五十多位听众参加了此次讲座。

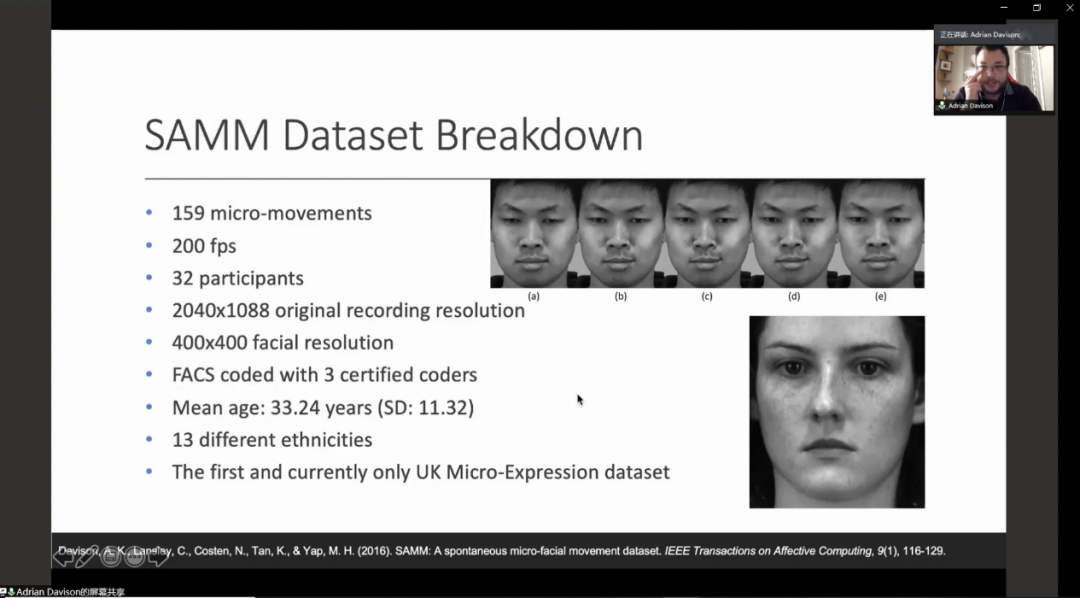

1. Dr. Adrian Davison介绍SAMM数据库

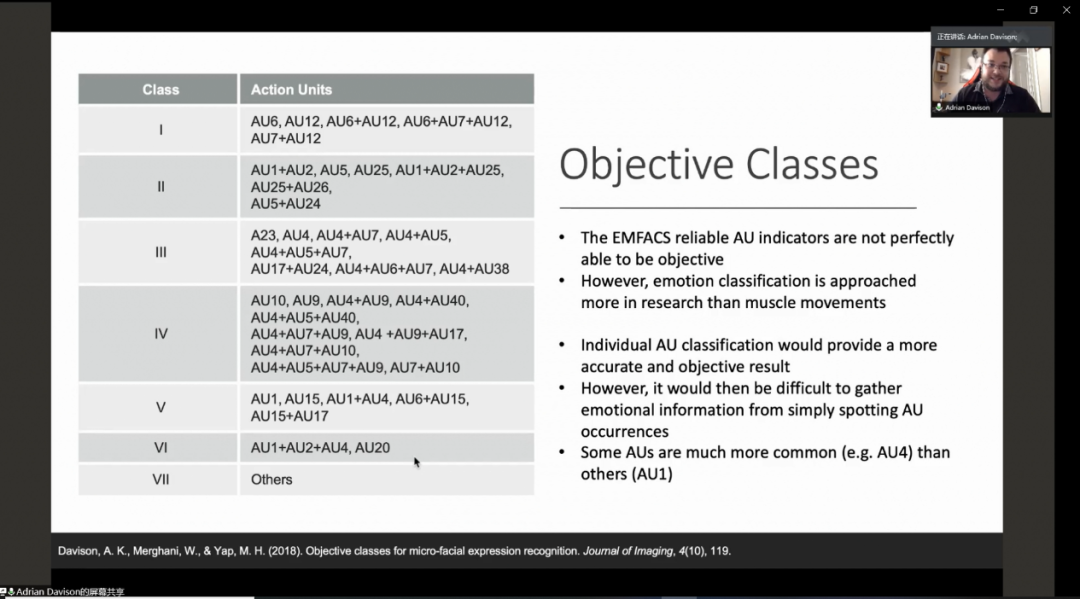

其次,为了避免主观的微表情情感标注分类中存在的困难,Davison博士介绍了他们提出的基于AU组合的客观微表情分类法。

另外,Davison博士也介绍了基于SAMM数据库的用于长视频中微表情检测的SAMM Long Videos,其中同时包括了宏观表情和微表情样本,最大程度地构建了接近真实情况的宏观表情-微表情数据库。

最后,Davison博士指出了目前自动化微表情研究中心遇到的问题,包括数量有限的微表情数据库、很难获取真实场景中的微表情、视频中的微表情检测十分困难、实时处理很难实现、以及研究成本等问题。

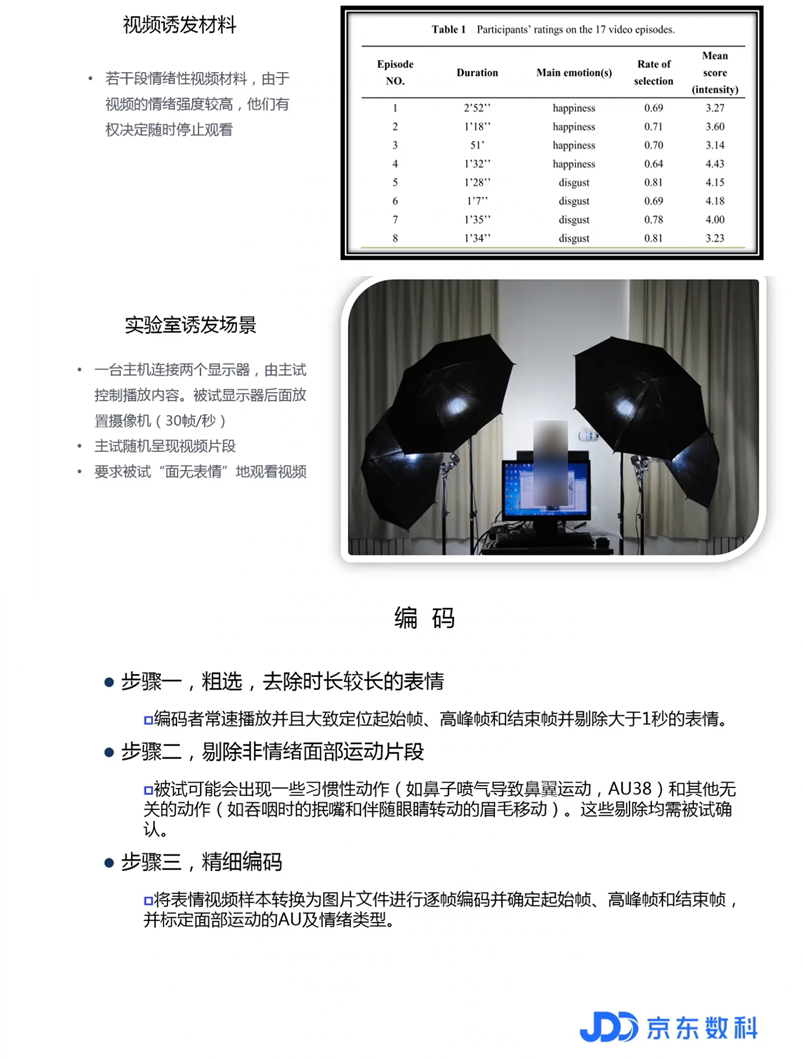

然后,颜博士介绍了如何建立微表情数据库,包括视频诱发材料、实验室诱发场景和微表情编码三个步骤。

随后,颜博士指出了目前微表情数据库构建过程中存在的问题:样本数量少、标准困难、以及生态效度的问题。

进一步地,颜博士从心理学的层面介绍了情绪、表情心理学和微表情的关系,指出微表情是局部的面部动作,有时很难对应到某种特定的情绪。

最后,颜文靖博士从心理学和数据库两个方面对微表情未来的发展提出了建议。

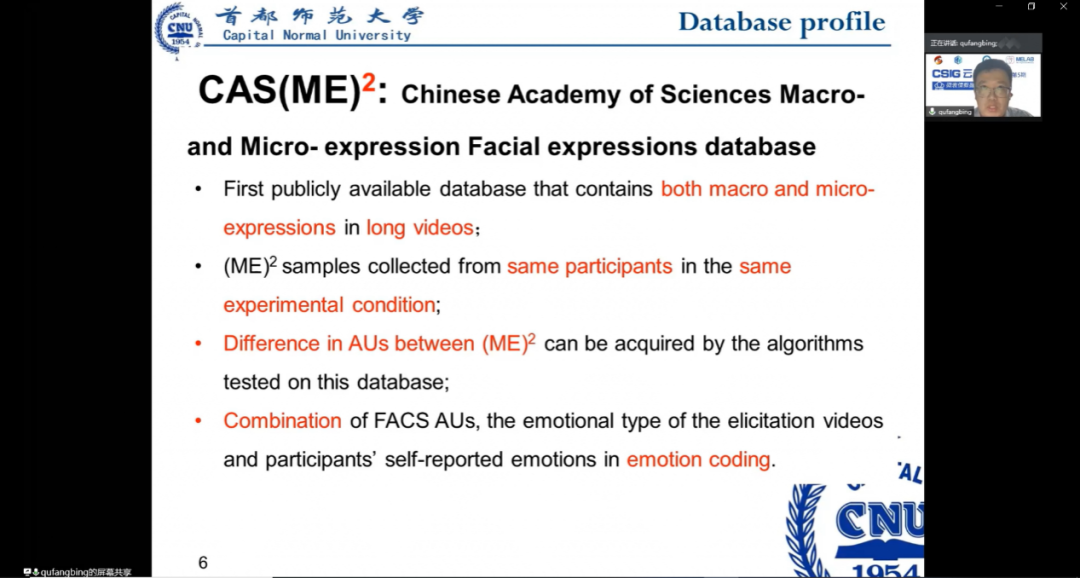

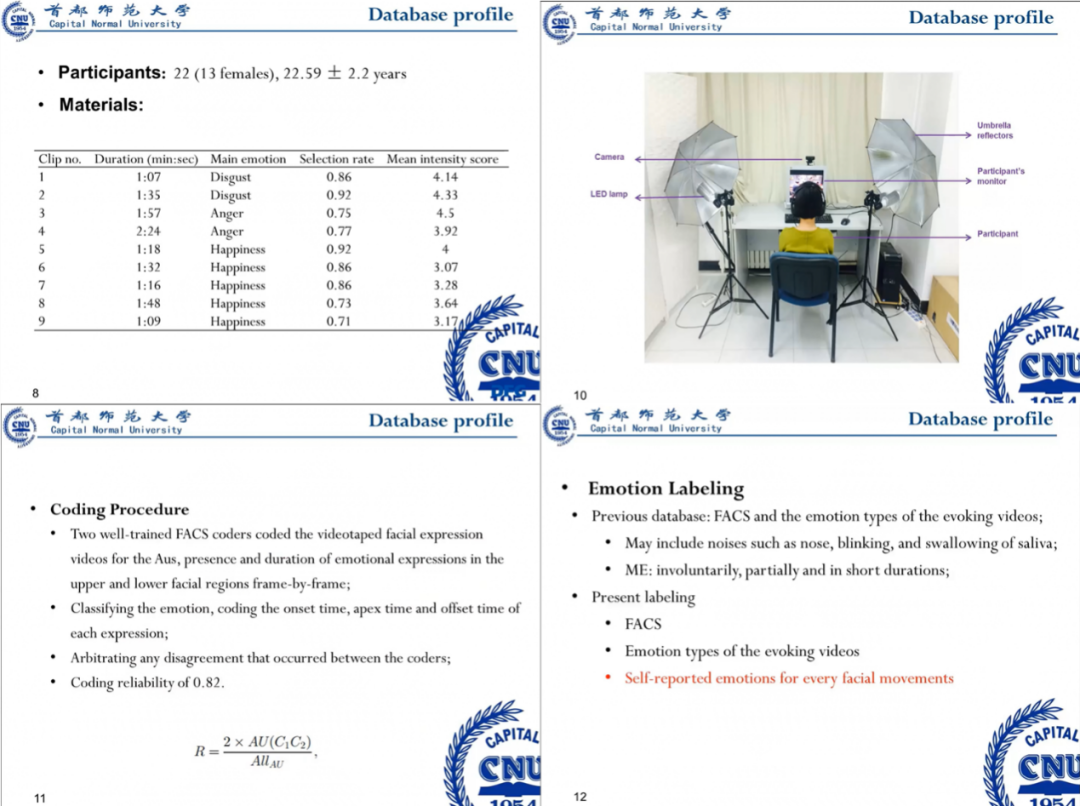

接下来,曲博士详细介绍了CAS(ME)2数据库的构建过程,包括被试人员情况、录制环境、编码程序和情感标注,并展示了CAS(ME)2中样本情感分类的统计情况和样本视频。

最后,曲博士提出一个问题希望大家展开思考和讨论:微表情是否会在青少年群体中体现?

在讨论环节,听众们踊跃发言,提出了很多非常有意义的问题。讨论主要涉及到以下方面:

1. 如何诱发“笑里藏刀”类型的微表情(masked micro expression),以及如何处理一段较为明显的情绪中发现其他类型微表情的情况?在情绪诱发的实验设置中,初步可以采取如下方案:要求被试首先保持一种特定表情后观看情绪诱发材料,从而产生微表情。对于第二个问题,目前的自动化微表情识别技术还很难解决,期待后续更多的技术能够很好地区分发生在同一时刻的宏观表情和微表情。

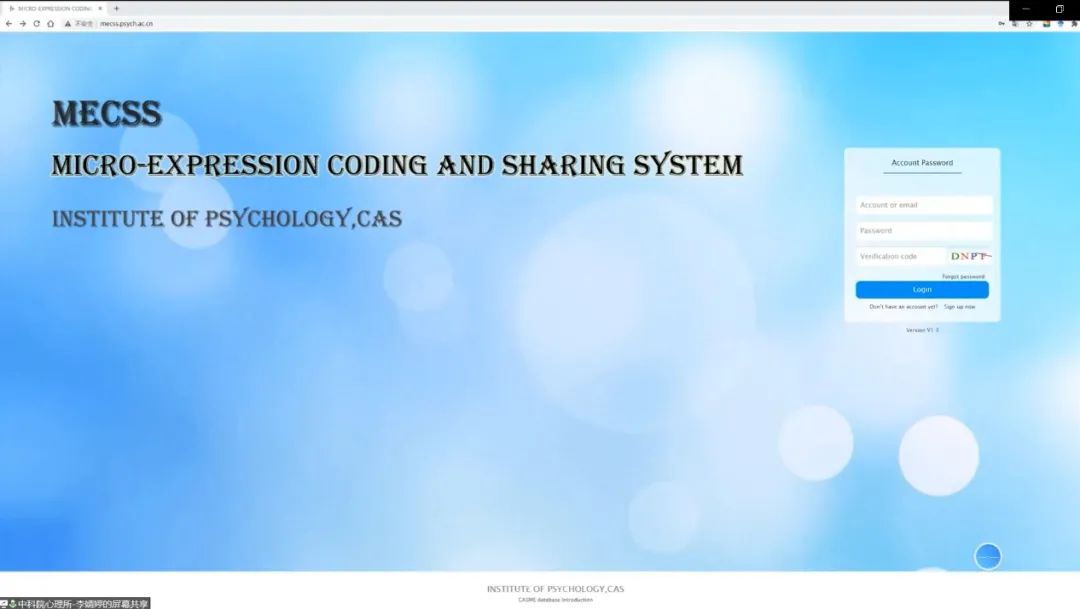

2. 为了促进结合计算机视觉的微表情分析发展,在未来的微表情数据库构建中我们应该为研究者提供哪些更多的信息?Davison博士首先指出微表情编码和标注系统是一个非常好的帮助微表情研究的工具;其次由于需要对大量的数据进行分析,我们需要一个统一的达成共识的解释微表情的标准,通过不同团队科研人员的合作,我们可以取得很大的进展。颜文靖博士指出微表情的情绪意义值得进一步探究,目前微表情的研究都是基于AU的,但是从心理学层面上看,表情和情绪的关系经常是多变的。因此,如果一个数据库能够提供个体的情绪体验,从心理学角度来看十分有意义;另外就是情景因素的考虑,包括身体姿态、所处情境等,可以促进对微表情的理解。曲方炳博士提出需要进一步探讨微表情和谎言识别之间是否存在明确的关系,另外在微表情样本采集层面,也应当扩充被试人员的复杂度,如增加年龄的广度等。

3. 在采集微表情数据过程中,是否发现不同年龄以及不同人种存在的微表情差异?Davison博士介绍年轻人更容易出现较为明显的微表情,但是人种的差异分析还有待进一步的探索。

此外,参会者还就数据库大小对微表情研究的限制、微表情样本采集过程中的情绪诱发材料和情感报告等问题展开了讨论。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结,并对后续三期CSIG云上微表情活动进行了预告。敬请继续关注!