每日三篇 | 神经网络能力;词嵌入维度选取;SACNN

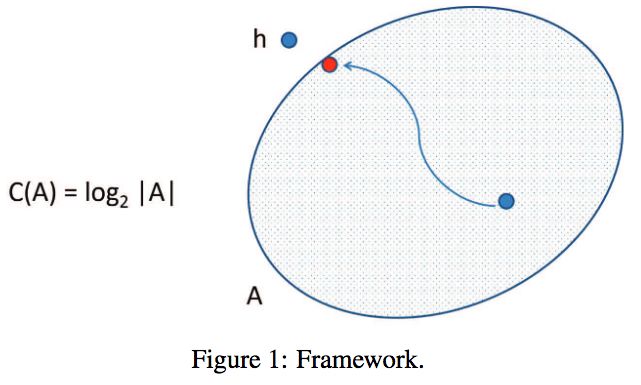

On Neuronal Capacity

Pierre Baldi和Roman Vershynin在NIPS 2018上口头报告了他们关于神经网络模型能力的论文。他们将学习机器的能力定义为它可以实现的函数量的对数。在这篇论文中,他们使用这一概念推导了线性模型、ReLU神经元、全循环网络、层叠前馈网络等模型的能力。

地址:http://papers.nips.cc/paper/7999-on-neuronal-capacity

On the Dimensionality of Word Embedding

在NIPS 2018上,斯坦福的Zi Yin和Yuanyuan Shen提出了一种新的词嵌入不相似性的测度,成对内积损失(Pairwise Inner Product loss,简称PIP损失)。论文作者从矩阵摄动理论出发,揭示了词嵌入维度选取中基础性的偏差-方差权衡。这一理由可以解释为何最优维度存在,词嵌入对过拟合的鲁棒性等问题。通过优化PIP损失的偏差-方差权衡,可以明确回答词嵌入该如何选择维度这一问题。

地址: http://papers.nips.cc/paper/7368-on-the-dimensionality-of-word-embedding

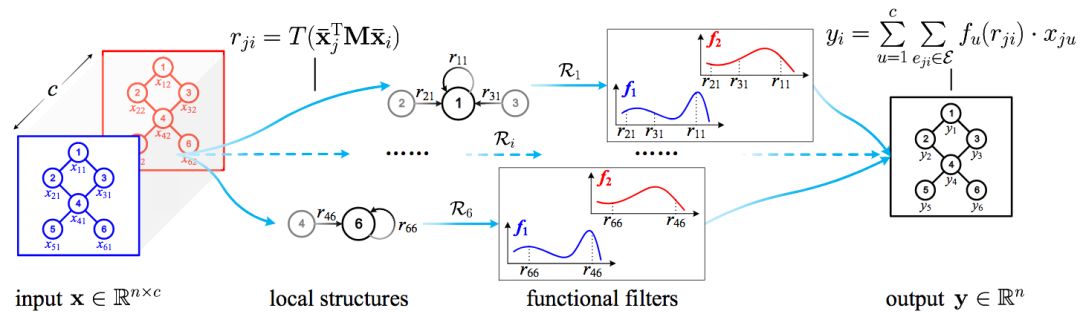

Structure-Aware Convolutional Neural Networks

传统的卷积神经网络(CNN)内在地取决于仅能在同样的拓扑结构上聚合局部输入的不变过滤器。因此,CNN擅长处理欧式或网格状的结构(比如图像),而不擅长处理非欧结构或图结构(例如,交通网络)。在NIPS 2018上,中科院的研究人员报告了他们开发的SACNN(Structure-Aware Convolutional Neural Networks),这一CNN的扩展通过将传统卷积过滤器推广至单变量函数,拓宽了CNN的应用范围。在11个数据集上的试验表明,SACNN在图像分类和聚类、文本归类、基于轮廓的行动识别、分子活动识别、出租车流量预测等多种机器学习任务上,表现优于当前模型。

地址:http://papers.nips.cc/paper/7287-structure-aware-convolutional-neural-networks