【干货】DeepMind 提出 GQN,神经网络也有空间想象力

来源: DeepMind Blog

强大的场景表征,和仿佛学到了环境常识的渲染器。

编者按:人类理解一个视觉场景的过程远比看上去复杂,我们的大脑能够根据已有的先验知识进行推理,推理的结果所能涵盖的内容也要远超出视网膜接收到的光线模式的丰富程度。比如,即便是第一次走进某个房间,你也能马上就认出房间里都有哪些东西、它们的位置又都在哪里。如果你看到了一张桌子下面有三条腿,你很容易推断出来很有可能它还有一条一样形状、一样颜色的第四条腿,只不过现在不在可见范围里而已。即便你没法一眼看到房间里所有的东西,你也基本上能描绘出房间里的大致情况,或者想象出从另一个角度看这间房间能看到什么。

这种视觉和认知任务对于人类来说看似毫不费力,但它们对人工智能系统来说却是一大挑战。如今顶级的视觉识别系统都是由人类标注过的大规模图像数据集训练的。获取这种数据成本很高,也很费时,需要人工把每个场景里的每一个物体的每一个视角都用标签标识出来。所以最后,整个场景里往往只有一小部分的物体能被标识出来,这也就限制了在这样的数据上训练的人工智能系统的能力。随着研究员们开发能够运行在现实世界里的机器系统,我们也希望它们能够完全理解它们所处的环境 —— 比如最近的能够站稳的平面在哪里?沙发的材质是什么?这些阴影是哪个光源造成的?灯光开关有可能在哪里?

DeepMind 近期发表在 Science 杂志上的论文《Neural Scene Representation and Rendering》(神经网络场景表征与渲染)就研究了这个问题。论文中他们提出了生成式询问网络 GQN(Generative Query Network),这是一个可以让机器在场景中移动,根据移动过程中它们收集到的数据进行训练,从而学会理解它们自己的所处环境的网络框架。就像婴儿和动物一样,GQN 尝试理解自己观察到的所处的世界的样子,从而进行学习。在这个过程中,GQN 基本学到了场景的大致样子、学到了它的几何特点,而且不需要人类对场景中的任何物体进行标注。

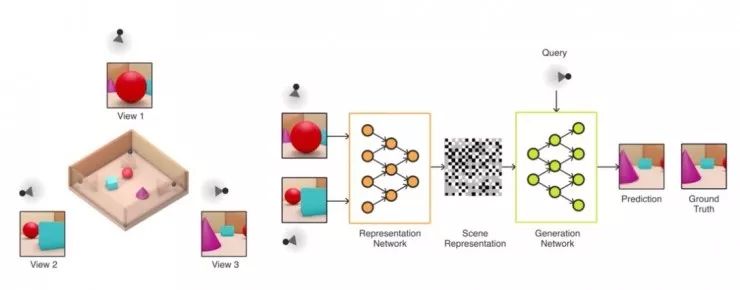

GQN 模型由两部分组成:一个表征网络和一个生成网络。表征网络把智能体观察到的画面作为输入,然后生成一个表征向量,这个向量就描述了网络认识到的场景。生成网络接下来就会从一个之前未使用过的观察角度对场景进行预测(也可以说是「想象」)。

表征网络并不知道生成网络要预测的视角是什么样的,所以它需要找到尽可能高效的方式、尽可能准确地表征出场景的真实布局。它的做法是捕捉最重要的元素,比如物体的位置、颜色以及整个屋子的布局,在简明的分布式表征中记录下来。在训练过程中,生成器逐渐学到了环境中的典型的物体、特征、物体间关系以及一些基本规律。由于有了这组共享的「概念般」的表示方法,表征网络也就可以用一种高度压缩、抽象的方式描述场景,然后生成器会自动补足其它必要的细节。例如,表征网络可以简洁地用一组数字代表「蓝色方块」,同时生成器网络也知道给定一个视角以后要如何把这串数字再次转化为像素点。

DeepMind 在一组模拟的 3D 世界环境中进行了控制实验,环境里有随机位置、颜色、形状、纹理的多个物体,光源是随机的,观察到的图像中也有许多遮挡。在环境中训练过后,DeepMind 的研究人员们用 GQN 的表征网络为新的、从未见过的场景生成表征。通过实验,研究人员们表明了 GQN 有以下几个重要的特性:

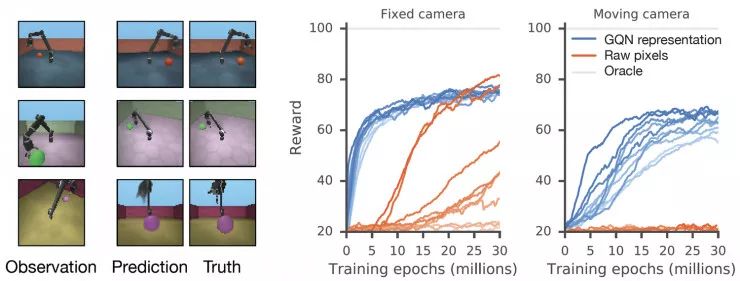

GQN 的生成网络可以以惊人的精确性从新的视角为从未见过的场景生成「想象」的图像。对于给定的场景表征和新的视角,生成网络不需要任何透视、遮挡、光照条件的先验指定,就可以生成清晰的图像。这样一来,生成网络也就是一个从数据学到的不错的图像渲染器。

GQN 的 表征网络不需要任何物体级别的标签就可以学会计数、定位以及分类。即便网络生成的表征规模不大,GQN 对于提问视角的预测也很准确,与事实相差无几。这表明表征网络对场景的感知也很准确,比如准确描述了下面这个场景中组成积木的方块的具体状况。

GQN 能表征、测量以及减小不确定性。它自己对于场景的认知中可以包含一定的不确定性,尤其对于场景中的部分内容不可见的情况,它可以组合多个部分的视角,形成一个一致的整体理解。下图通过第一人称视角以及上帝视角展示了网络的这项能力。网络通过生成一系列不同的预测结果的方式展现出了不确定性,而随着智能体在迷宫中四处移动,不确定的范围逐渐减小。(图中灰色圆锥表示观察的位置,黄色圆锥表示提问的位置)

GQN 的表征为鲁棒、样本高效的强化学习带来了可能。把 GQN 的紧凑的表征作为输入,相比无模型的基准线智能体,目前顶级的强化学习智能体能够以更数据高效的方式进行学习,如下图所示。对于这些智能体来说,生成网络中编码的信息可以看做是存储了这些环境的「固有信息」、「通用特性」。

通过使用 GQN,DeepMind 的研究人员们观察到了数据效率显著更高的策略学习,相比一个标准的、把原始像素作为数据的方法,它与环境交互的数量只需要大概 1/4 就可以得到接近收敛级别的表现。

GQN 是基于多视角几何、生成式建模、无监督学习和预测学习方面的大量近期论文构建的,DeepMind 也在这篇报告中介绍了相关工作。GQN 介绍了一种新的方式从物理场景学习紧凑的、可靠的表征。最关键的是,所提的方法也不需要任何专门针对领域的工程设计或者耗时的内容标注,所以同一个模型可以用在多种不同的环境中。它还学到了一个强有力的神经网络渲染器,能够从新的视角为场景生成准确的图像。

不过 DeepMind 也表示,相比传统的计算机视觉技术,GQN 也遇到了诸多限制,目前也只尝试了在生成的场景中训练。不过,随着获得新的数据、硬件方面得到新的提升,他们也希望未来能够在更高分辨率的、真实的场景中研究 GQN 网络框架的应用。在后续研究中,研究如何把 GQN 应用到场景理解的更多层面上也是一个重要课题,比如通过对于一段时间和空间的提问,让模型学会一些物理原理和运动常识;GQN 在虚拟现实、增强现实中也有机会得到应用。

虽然这项方法距离实际应用还有很长的距离,但 DeepMind 相信这是向着全自动场景理解的目标的重要一步。

论文地址(Science版):http://science.sciencemag.org/content/sci/360/6394/1204.full.pdf

论文地址(Open Access 版):https://deepmind.com/documents/211/Neural_Scene_Representation_and_Rendering_preprint.pdf

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【征稿通知】IEEE IV 2018“智能车辆中的平行视觉”研讨会

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【学界】伯克利发布世界最大自动驾驶数据库,是百度的800倍

☞【深度】伯克利发布目前最大规模、内容最具多样性的高质量标注公开驾驶数据集BDD100K

☞【学界】CVPR 2018 | 牛津大学&Emotech首次严谨评估语义分割模型对对抗攻击的鲁棒性