时隔五年,普林斯顿大学经典书《在线凸优化导论》第二版发表

2016 年发表的《在线凸优化导论》第一版已成为领域内经典书籍。

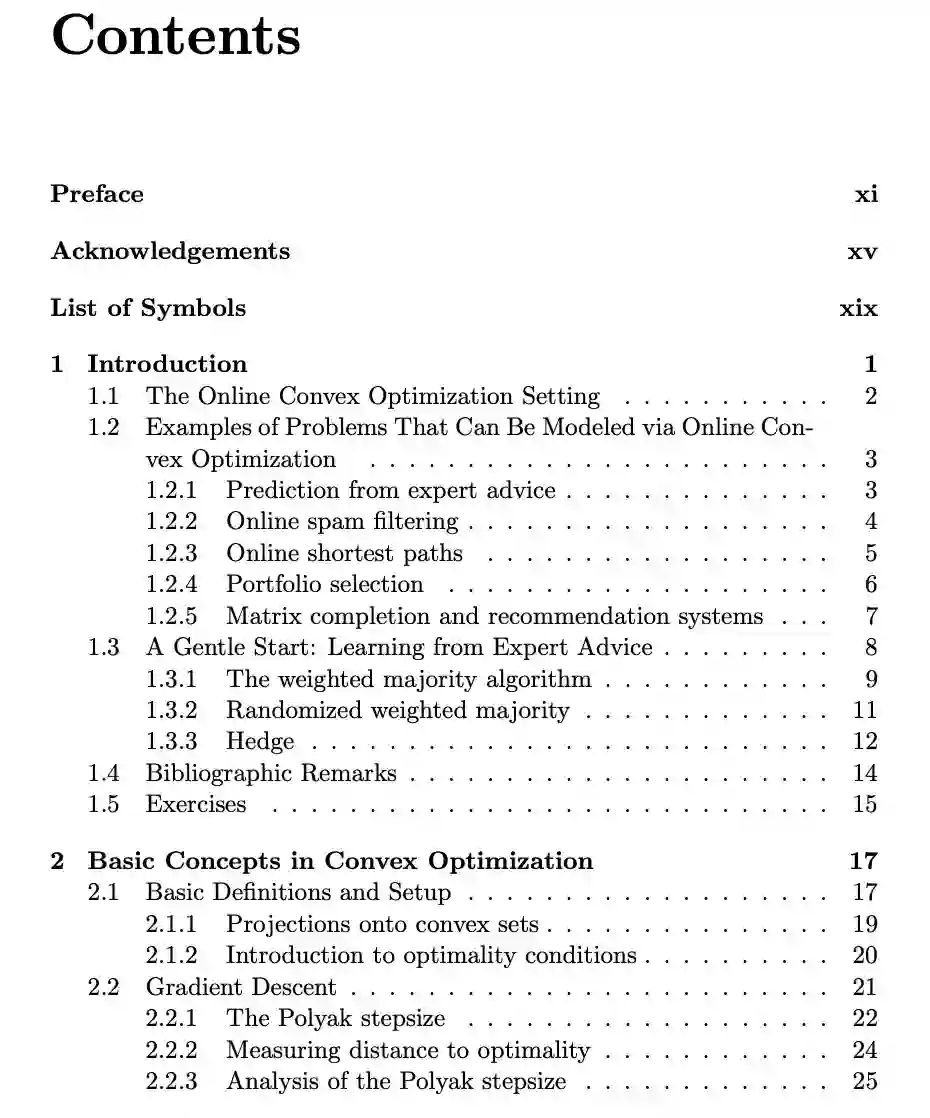

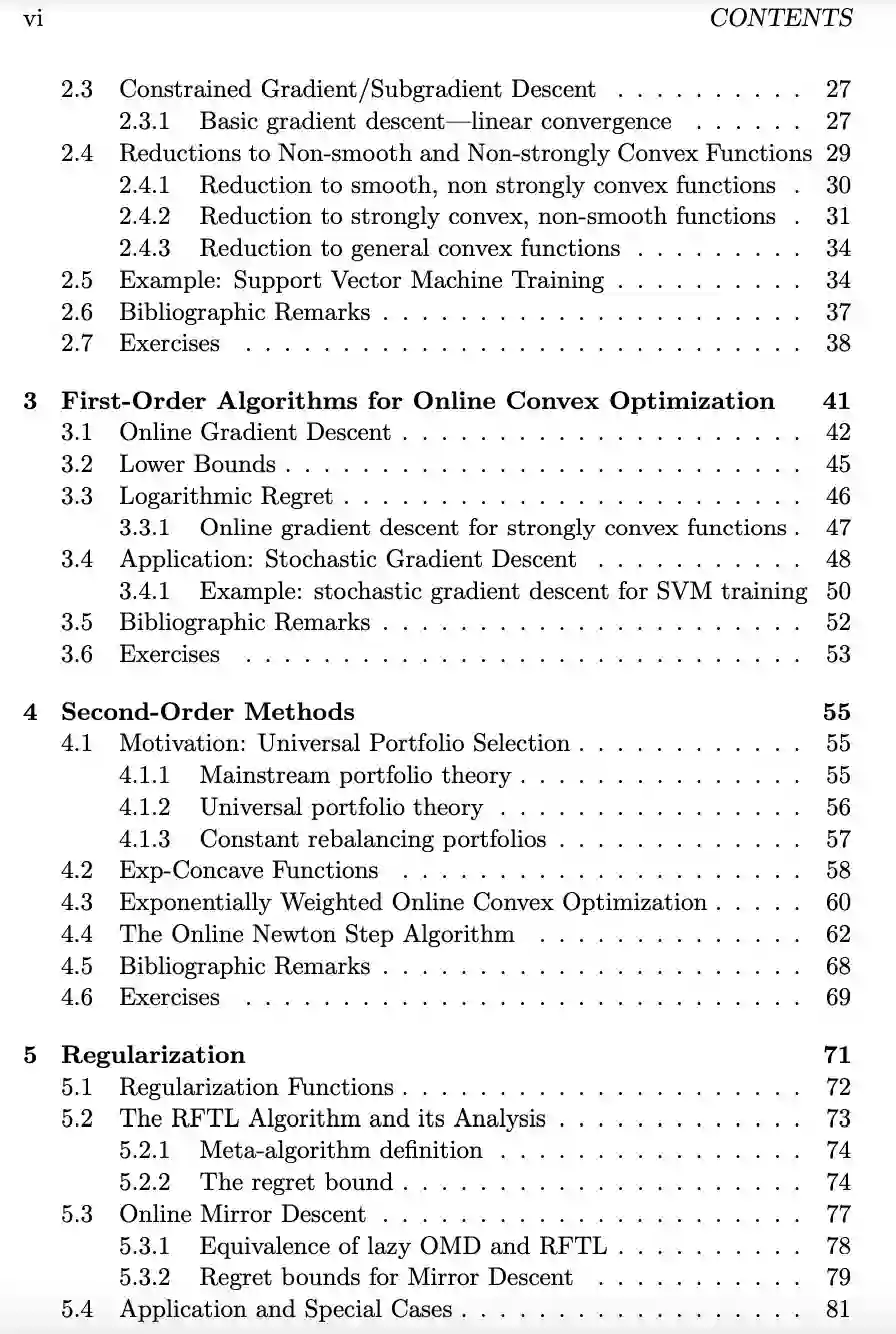

第 1、2 章介绍了在线凸优化的基础知识和基本概念;

第 3、4 章系统地介绍了两类在线凸优化的方法;

第 5 章介绍了正则化的内容;

第 6 章具体介绍了经典框架 Bandit 凸优化(BCO)的内容;

第 7 章讲解了无投影算法的内容;

第 8 章从博弈论的角度讲解在线凸优化理论;

第 9 章讲解了与在线凸优化有关的统计学习理论;

第 10 章介绍了在现实多变的环境中在线凸优化的实际应用问题;

第 11 章主要介绍了机器学习算法 boosting 和在线凸优化算法的衡量指标 regret;

第 12 章讲解了在线 boosting 方法及其用途;

第 13 章介绍了 Blackwell 可接近性定理。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月19日

Arxiv

0+阅读 · 2022年4月16日