SFFAI 分享 | 李宏扬 :二阶信息在图像分类中的应用

关注文章公众号

回复"李宏扬"获取PDF及视频资料

1、导读

此次分享的文章主要关于二阶信息在图像分类中的应用。从Alexnet起,深度神经网络飞速发展,取得了一系列骄人的成绩。总体来说,深度分类网络主要分为两个部分:特征提取和分类器。无论是VGG还是GoogleNet,后来的Resnet、Densenet,仔细观察可以发现,无论设计了多么性能优异的网络,在连接分类器之前,一般都连接了一个Pooling层,如下表所示:

| Network | Pooling layer |

|---|---|

| Resnet | Average pooling |

| Densenet | Average pooling |

| Alexnet | Max pooling |

| VGG | Max pooling |

无论是Average Pooling也好,还是Max Pooling也好,终究使用的是关于feature的一阶信息。一阶信息往往简单,快速、有效,但并不是所有时候。举个简单例子:学校跳绳队从小张、小明两人中拍一个人去参加比赛,测验10次,很巧合地是二人的平均成绩相同,那么怎么选择呢?于是我们考虑了方差,选择方差小的队员去参加比赛。回过头来思考分类问题,尤其是细分类问题,我们是不是也可以理解为由于细分类问题中类间差异不显著,一阶信息有一些不适用了呢?那么二阶信息是否可以带给分类器更有区分性、更有价值的信息呢?此次分享的两篇大连理工大学李培华老师组的文章《Is Second-Order Information Helpful for Large-Scale VisualRecognition?》《Towards Faster Training of GlobalCovariance Pooling Networks by Iterative Matrix Square Root Normalization》向我们展示了二阶信息的作用。

2、分享者简介

李宏扬,北京大学信息科学技术学院在读硕士,本科毕业于北京科技大学,2018年MS COCO Panoptic Segmentation Contest PKU_360团队(第三名)成员之一。目前主要研究兴趣点在于图像中的object detection。希望可以结识更多的人,彼此分享,共同交流。

3、方法

在该部分简单介绍两篇论文的方法,详细内容请参考原文以及李培华老师CVPR2018微软亚洲研究院分享会视频:

https://www.icourse163.org/learn/MSRA-1002806001?tid=1002976005#/learn/content?type=detail&id=1004213003&cid=1005216029

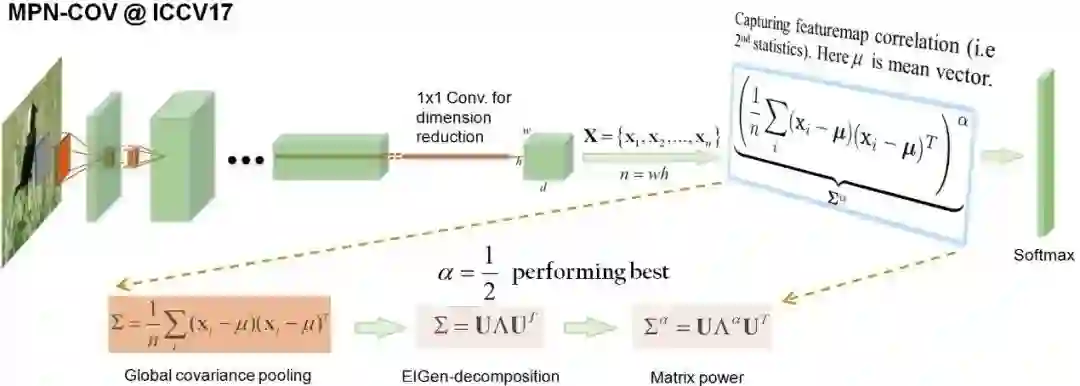

3.1 MPN-COV

上图展示了MPN-COV的全部过程,经过特征提取之后,将得到feature,首先计算协方差矩阵,与一阶的Max Pooling 和Average Pooling不同的是,协方差矩阵可以刻画每个channel之间的相关性,这对于一阶操作来说是做不到的。

之所以取幂,是为了解决在协方差估计中小样本高维度的问题,以resnet为例,最后得到的feature为7X7X512,也就是49个512维的feature,这样估计出来的协方差矩阵是不靠谱的,而通过幂这个操作,可以解决这一问题。通过实验可以发现,当幂次为0.5也就是平方根操作时,效果最优。

但是以上方法最大的问题在于计算矩阵的幂需要首先对协方差矩阵求特征值,而特征值操作在GPU上支持的非常不友好,这也就降低了该方法的效率。这也就衍生出下一篇文章,通过迭代的方式求取平方根,进而加速该方法。

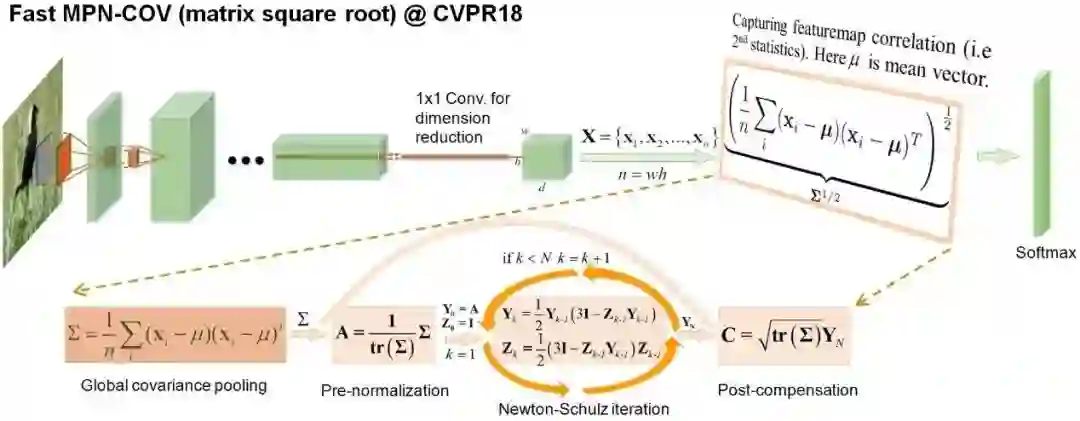

3.2 iSQRT-COV

这篇文章可以说是对MPN-COV的很好的延续,巧妙地利用迭代的方式近似求解平方根,因此整体的操作不再赘述。值得注意的一点是,在进行迭代前后分别进行了预处理和后操作。预处理的目的在于保证迭代的收敛,具体可以参考论文中的分析;由于预处理过程中改变了协方差矩阵的特征值大小,为了消除这一影响,引入后处理操作,将除掉的特征值大小乘回来,实验表明,后处理这个操作也是十分关键。

4、总结

就个人而言,二阶信息的使用帮助我更好的理解细分类问题,为什么BCNN在细分类问题中可以取得显著的效果。总体上看,MPN-COV以及iSQRT-COV主要从feature层面进行思考,为我们提供了一定的借鉴。Network Architecture、Feature、Prior Knowledge是比较重要的几个问题,关于网络结构的寻优,先验知识的应用,仍然有很大的空间。我认为在这些方面可以进一步挖掘。

注:此次分享大多为个人感性理解,如有不当,深表歉意。

5、参考文献

[1] Li P, Xie J, Wang Q, et al. IsSecond-Order Information Helpful for Large-Scale Visual Recognition?[J].international conference on computer vision, 2017: 2089-2097.

[2] Li P, Xie J, Wang Q, et al. TowardsFaster Training of Global Covariance Pooling Networks by Iterative MatrixSquare Root Normalization[J]. computer vision and pattern recognition, 2018:947-955.

[3] Lin T, Roychowdhury A, Maji S, et al.Bilinear CNNs for Fine-grained Visual Recognition[J]. arXiv: Computer Visionand Pattern Recognition, 2015.

SFFAI简介

人工智能前沿学生论坛

(Student Forum on Frontiers of Artificial Intelligence)

是公益性的学术交流社区

欢迎对AI感兴趣的各位大佬们加入

分享机器学习、神经科学、认知科学、计算机视觉、自然语言处理等领域的前沿工作

希望SFFAI能够促进大家在各个AI分领域都能跟进前沿

历史文章推荐: