图片出处:https://bmk.sh/2020/05/29/GPT-3-A-Brief-Summary/

如果你错过了上一波深度学习引发的NLP范式转换,不要再错过这一波超大预训练模型的崛起。

现在,有一个重要机会摆在你面前:明晚,“悟道”公开课将正式开课

(地址:http://live.bilibili.com/21887724)

,手把手教你使用著名大规模预训练模型“悟道”开发自己的智能应用,更有

120万+

“悟道之巅”比赛奖金等你拿!

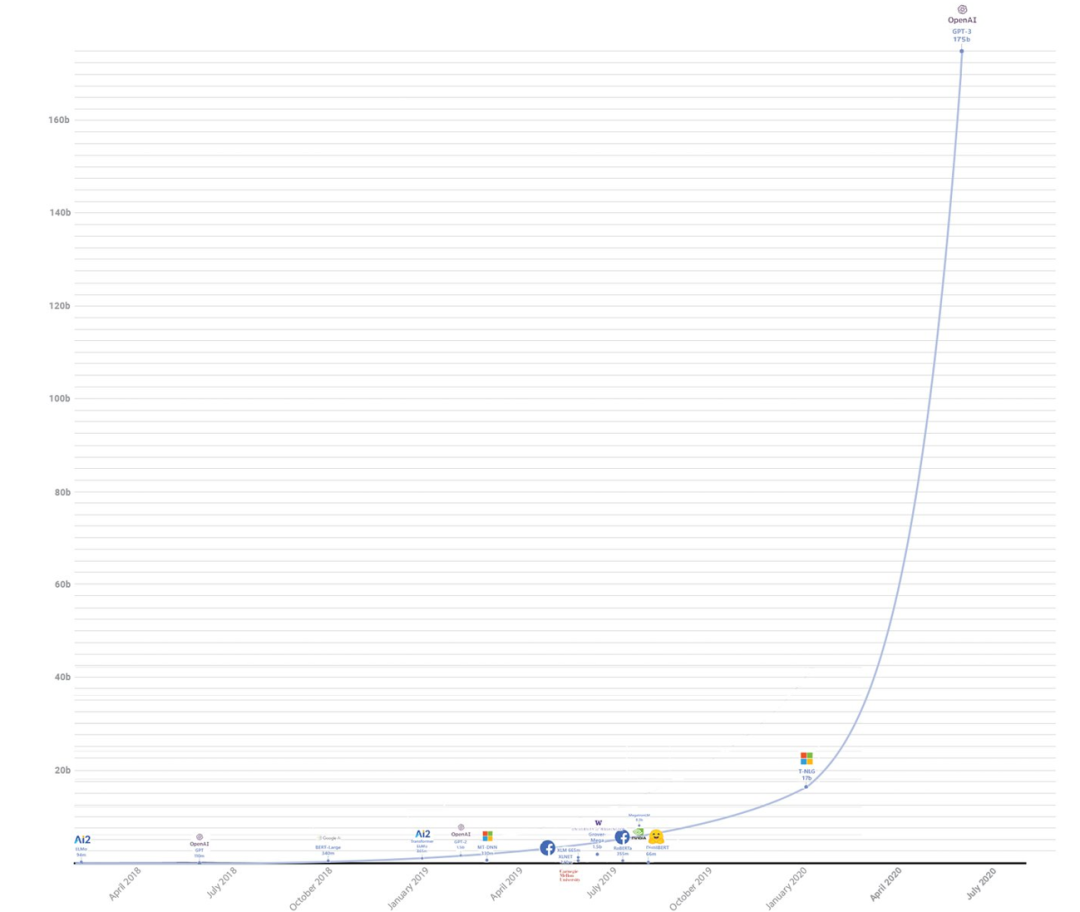

事实上,以OpenAI 的GPT-3 在 2020年问世为起点,这几年,预训练模型对NLP领域带来了颠覆性的影响为代表。大量令人印象深刻的演示如雨后春笋般涌现,它们利用GPT-3的泛化能力来完成各式各样的任务。最令人兴奋的是,即使在如此大规模的情况下,模型在性能上仍能平稳扩展而非停滞不前,这也就意味着,随着参数的增加,预训练模型还可以表现得更好。

这是一个相当有诱惑力的承诺。但是有一道门槛横亘在我们面前:它没有公开发布。

OpenAI 选择将其商业化,并仅通过付费 API 提供访问权限。鉴于 OpenAI 的盈利性质,这个操作无可厚非。因此,自去年以来,不少商业机构和学术团队都在致力于创建自己的 GPT-3 。

“悟道”由智源研究院学术副院长、清华大学唐杰教授领衔,包括北京大学、清华大学、中国人民大学、中国科学院等单位的100余位AI科学家团队联合开发,参数达到1.75万亿参数。

目前悟道已经进化到2.0版本。它已经不仅仅是个语言模型,正在攀登文本和视觉两大座大山的悟道2.0,在问答、绘画、作诗、视频等任务中逼近图灵测试,并训练出包括中文、多模态、认知、蛋白质预测在内的系列模型,是我国人工智能应用基础设施建设的里程碑。

另一个激动人心的好消息是,现在,“悟道”核心团队将推出首档公开课,手把手教你理解并应用“悟道”,进一步挖掘“悟道”的潜力。

而且,明晚开始的第一讲,可以说是面向所有人的大模型科普课,从大规模预训练模型与传统机器学习模型的区别、机器学习范式的变化和GPT-3讲起,让你与预训练模型这一人工智能领域最重要的趋势保持同步。

如果你已经对大模型非常熟悉,一直在等待机会亲自体验使用大模型开发自己的1应用,那么,本系列课程更加不容错过:

1、与公开课紧密相关的“悟道之巅”大赛,准备了120万奖金等你来拿。

2、最全面的悟道背景、主要技术与训练方法,全部免费奉上。

快来预约学习吧(地址:http://live.bilibili.com/21887724)!“数据实战派”将同步发出系列课程相关内容,敬请关注!

大赛官网:https://wudaoai.cn/summit

(点击文末“阅读原文”即可访问)

比赛讨论区:https://baai.org/l/wudaosummit