本文中,包括刘知远、唐杰、孙茂松等在内来自清华大学的研究者对大模型的参数高效微调进行了全方位的理论和实验分析。

预训练语言模型 (PLM) 已经毫无疑问地成为各种 NLP 任务的基础架构,而且在 PLM 的发展中,呈现出了一个似乎不可逆的趋势:即模型的规模越来越大。更大的模型不仅会在已知任务上取得更好的效果,更展现出了完成更复杂的未知任务的潜力。然而,更大的模型也在应用上面临着更大的挑战,传统方法对超大规模的预训练模型进行全参数微调的过程会消耗大量的 GPU 计算资源与存储资源,巨大的成本令人望而却步。

这种成本也造成了学术界中的一种「惯性」,即研究者仅仅在中小规模模型上验证自己的方法,而习惯性地忽略大规模模型。

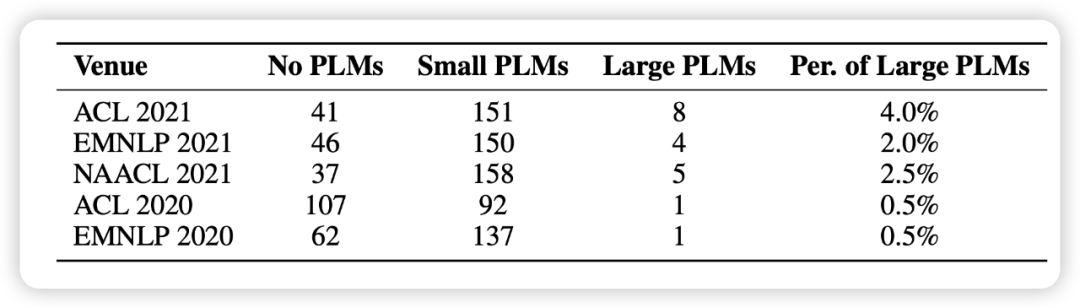

在近期论文《Delta Tuning: A Comprehensive Study of Parameter Efficient Methods for Pre-trained Language Models》中,来自清华大学和北京智源人工智能研究院的研究者随机选取了 1000 篇来自最近五个 NLP 会议的论文,发现使用预训练模型已经成为了研究的基本范式,但涉及大模型的却寥寥无几(如下图 1 所示)。

在这样的背景下,一种新的模型适配方案——参数高效(Parameter-efficient)方法逐渐受到关注,与标准全参数微调相比,这些方法仅微调模型参数的一小部分,而其余部分保持不变,大大降低了计算和存储成本,同时还有着可以媲美全参数微调的性能。研究者认为,这些方法本质上都是在一个「增量」(Delta Paremters)上进行调整,因此将它命名为 Delta Tuning。

论文地址: https://www.zhuanzhi.ai/paper/394964350173683867cb546abdddb114

OpenDelta工具包:https://github.com/thunlp/OpenDelta

研究者定义和描述了 Delta Tuning 问题,并通过一个统一的框架对以往的研究进行梳理回顾。在该框架中,现有 Delta Tuning 方法可以被分为三组:增量式(Addition-based)、指定式(Specification-based)和重参数化(Reparameterization)的方法。

除去实践意义之外,研究者认为它还具有非常重要的理论意义,Delta Tuning 在某种程度上昭示着大模型的背后机理,有助于人们进一步发展面向大模型甚至深度神经网络的理论。为此,他们从优化和最优控制两个角度,提出理论框架去讨论 Delta Tuning,以指导后续的结构和算法设计。

此外,研究者对代表性方法进行了全面的实验对比,并在超过 100 个 NLP 任务的结果展示了不同方法的综合性能比较。实验结果涵盖了对 Delta Tuning 的性能表现、收敛表现、高效性表现、Power of Scale、泛化表现、迁移性表现的研究分析。

他们还开发了一个开源工具包 OpenDelta,使从业者能够高效、灵活地在 PLM 上实现 Delta Tuning。

图片