2021 MAXP大赛 | 图机器学习赛道,奖金40W

9月15日,由中国计算机学会高性能计算专业委员会和中国信息通信研究院(以下简称中国信通院)指导, ACM中国高性能计算专家委员会(ACMSIGHPC)和云计算开源产业联盟联合主办,亚马逊云科技和腾讯云支持,阿里云、华为云、UCloud、天翼云等厂商参与的2021全球高性能云计算创新大赛(以下简称2021 MAXP大赛)正式启动。大赛以高性能云计算为主题,旨在进一步推动国内高性能计算的发展,并为参赛者提供了高达40万元的奖金池,还会提供实习机会和权威荣誉证书。

扫码前往大赛官网

其中由亚马逊云科技支持的命题赛道,设计了当前AI领域火热的图机器学习的算法题目《基于DGL框架的图机器学习任务》以及无服务器计算相关的题目《基于Labmda的无服务器计算任务》。

围绕两大技术赛题,亚马逊云科技技术团队将为参赛团队带来共计5讲的系列公开课直播。课程内容包含如:Amazon Lambda、DGL、SageMaker等热门云计算应用的使用实操详解,以及比赛赛题的深度解析与技巧分享。

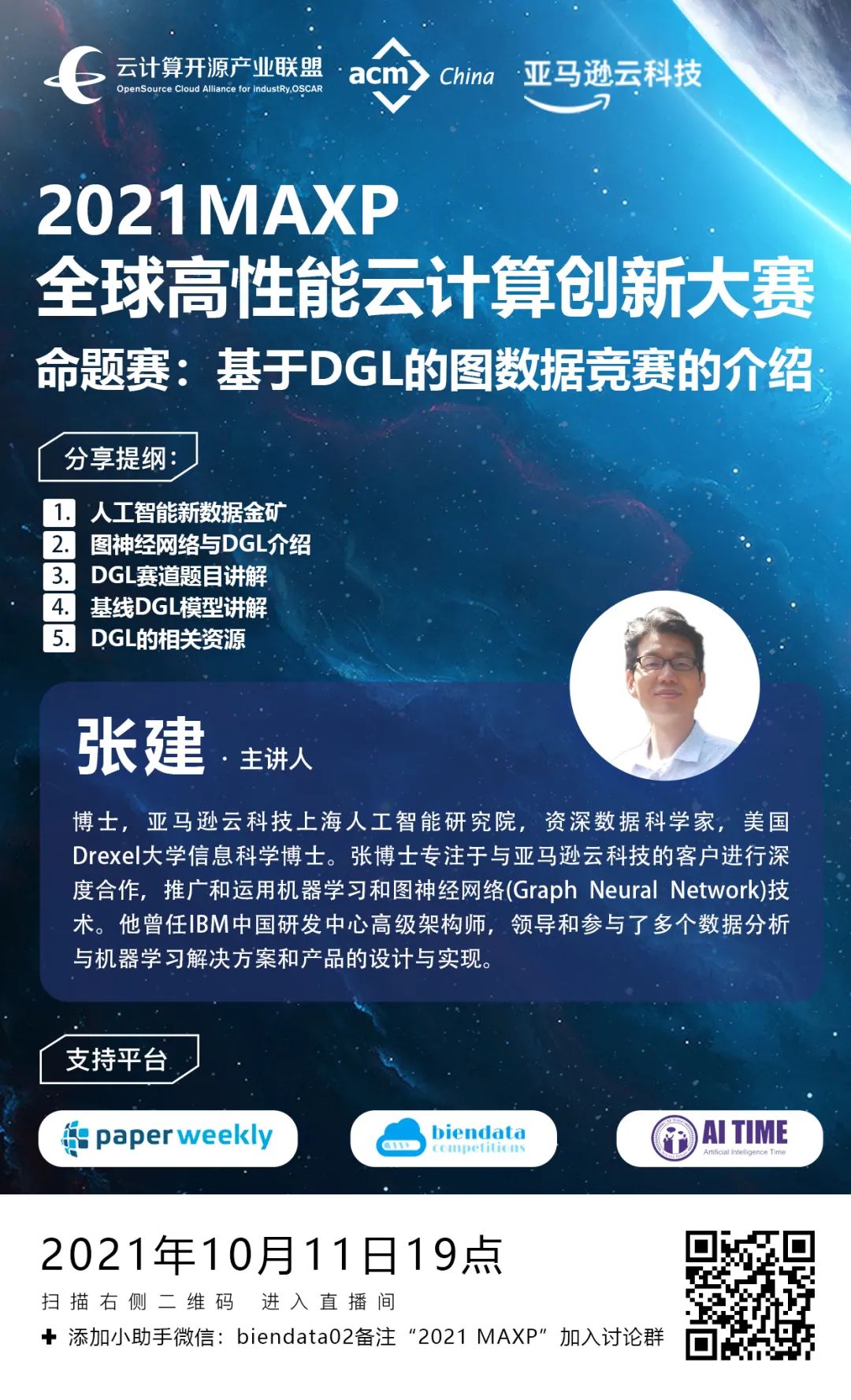

公开课来到了第二讲,将于10月11日由亚马逊云科技上海人工智能研究院张建博士为大家讲解基于DGL的图机器学习题目以及DGL的相关介绍。在本次课程中张建博士还将分享赛题任务的baseline模型。直播详情见下方海报:

关于 DGL

在2018年,亚马逊在 Neurips 大会上宣布开源的、面向图结构数据的专用深度学习框架。

这款框架的开发团队最初主要来自 NYU 和 NYU Shanghai,现由张峥教授带领的亚马逊云科技上海人工智能研究院主要开发。

DGL 是一项具有深远意义的开源项目,它易用性强,采用以“图”为核心的编程抽象,天然接近图算法的语义;具有高性能,使用算子融合等技术,相比同类系统能提速10倍甚至几十倍。借此,企业可以面向复杂的业务场景,提高语音分析、文字分析、时间序列分析等常规工作的效率和精准性;多平台支持,支持多款深度学习框架(PyTorch, MXNet, TensorFlow),用户可以基于此进行大规模图神经网络训练;海量巨图支持,支持多机多卡分布式训练,可以对十亿点规模的图做训练。

DGL 希望帮助开发者将图神经网络落地到具体的业务场景中,改善业务模式,创造更多价值。

与此同时,DGL 在学术圈具有广泛的影响力,基于 DGL 发表的学术论文有近400篇,包括图灵奖获得者 Yann Lecun 在内的诸多知名学者对项目给予高度评价。DGL 在几乎所有数据挖掘顶级会议上(KDD,WWW,WSDM 等)做过专场实操教学。

仅仅在两年时间内,来自学界和业界外部项目贡献者已经增长至140多位。此外,基于 DGL 的软件生态也初具雏形,衍生出面向分子生物,知识图谱,自然语言处理,推荐系统等多款专用AI 工具包。