论文浅尝 | MCCLK: 一个用于知识感知推荐的多层次的交叉视图对比框架

笔记整理:刘尧锟,天津大学硕士

链接:https://arxiv.org/pdf/2204.08807.pdf

动机

传统的基于知识图谱的推荐系统通常依赖于用户和物品的交互作为监督信号,因此广泛面临着监督信号稀疏的问题。受到最近对比学习范式的启发,我们提出了引入对比学习范式的解决方案Multi-level Cross-view Contrastive Learning for Knowledge-aware Recommender System(MCCLK)。不同于传统的通过数据增强方式构造图视角的对比学习方法,我们全面的考虑了三个不同的知识图谱推荐的图视角:全局的结构视角(user-item-entity 图)、局部的协同(user-item图)和语义(item-entity)视角。在开源基准数据集上的实验证明了 MCCLK 的有效性。

亮点

MCCLK的亮点主要包括:

1.强调了将自监督学习融入知识感知推荐的重要性,该方法将节点自识别作为一种自监督任务,为图表示学习提供辅助信号;2.提出了一个新模型MCCLK,它构建了一个用于知识感知推荐的多层次的交叉视图对比框架,MCCLK从user-item-entity graph中考虑了三个视图,包括全局级结构视图、局部级协作视图和语义视图。然后,MCCLK进行局部层次和全局层次的对比学习,从多个方面增强表征学习;3.此外,MCCLK还在少被考虑的语义图视角中,以k-NN的方式构建了一个item-item语义图,以此来捕获item-item语义关系。

概念及模型

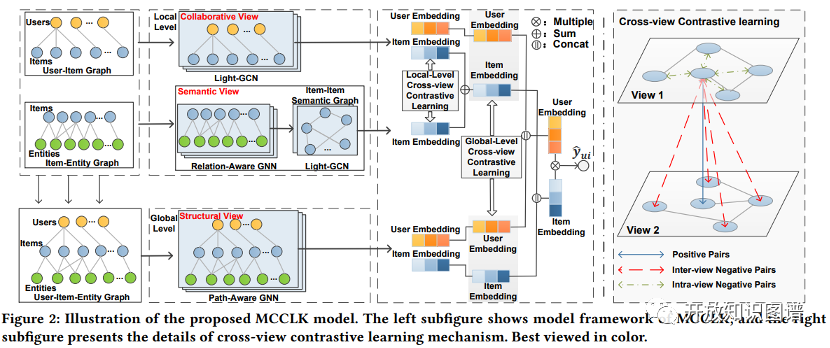

MCCLK包括三个主要模块:

1.多视图生成。它生成了三种不同的图视图,包括全局级结构视图、局部级协作视图和语义视图;2.局部对比学习。该算法首先利用LightGCN对协作视图和语义视图进行编码,然后在两个视图之间进行跨视图对比学习,以学习局部层面的综合节点嵌入;3.全局对比学习。该算法首先利用感知路径的GNN对结构视图进行编码,然后在全局视图和局部视图之间进行横向对比学习,学习全局层次上的判别节点嵌入。

模型整体框架如下:

•多视图生成

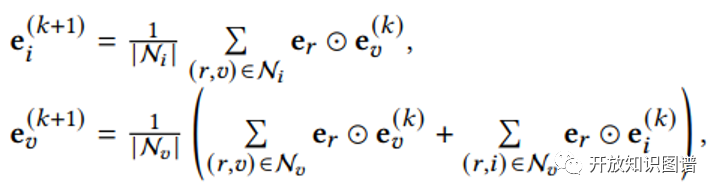

首先递归地从知识图G中学习 次的item表示,提出的关系感知聚合机制如下:

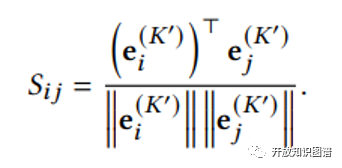

基于余弦相似度构建物品相似图,其计算方法如下:

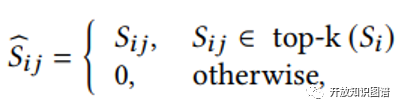

对全连通item-item图进行k-NN稀疏化:

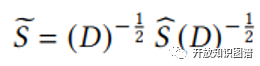

将邻接矩阵归一化如下:

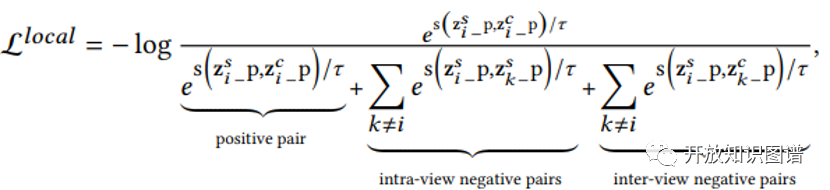

•局部对比学习

在获得的局部协作视图和语义视图互补的基础上,我们使用合适的图编码器来探索两个图视图,并在它们之间进行对比学习以监督彼此。具体来说,在两个视图中执行一个有效的Light-GCN来学习全面的item表示。然后,通过编码两个视图特定的嵌入,提出局部水平的对比学习,鼓励两个视图协同改进表示。对于定义的正样本和负样本,我们有以下对比损失:

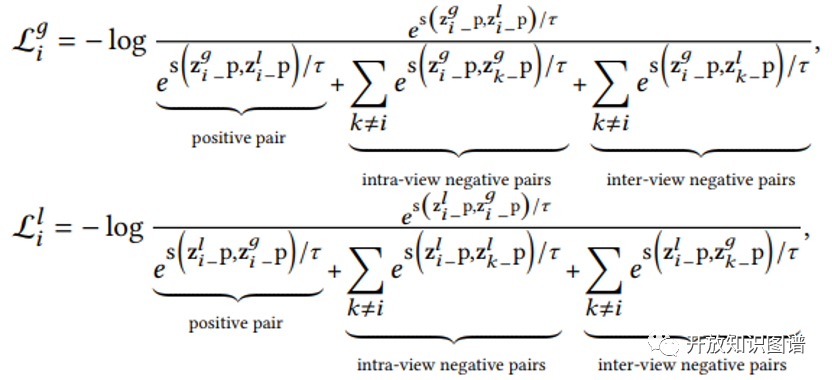

•全局对比学习

对局部水平的对比学习采用相同的正、负采样策略,我们有以下对比损失:

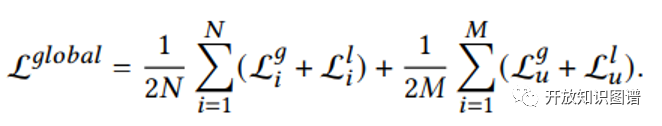

总体loss如下:

理论分析

实验

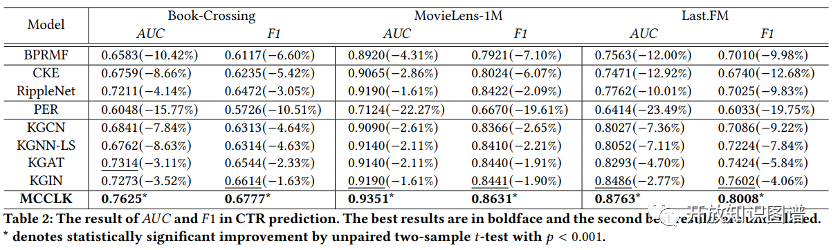

作者采用了3个公开数据集进行实验,分别是:Book-Crossing、MovieLens-1M和 Last.FM。首先是有效性实验,模型的评价指标为:AUC 和F1。

在所有指标方面,MCCLK在三个数据集上始终优于所有baseline。更具体地说,在Book、Movie和Music中,它比最佳baseline在 AUC上分别提高了3.11%、1.61%和2.77%,这证明了MCCLK的有效性。

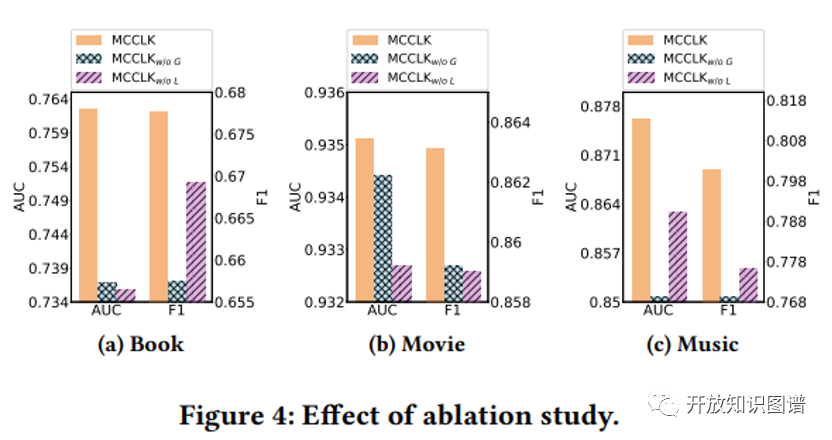

通过比较MCCLK和两种变体来检查模型中主要组件对最终性能的贡献:

MCCLK_o/wG:在这种变体中,全局级别的对比学习模块被删除,节点从两个局部级别的视图编码。

MCCLK_o/wL:这个变体去掉了local级别的对比学习模块,只保留了user-bundle-item 的结构视图学习。

图4报告了两种变体和MCCLK的结果,从中我们有以下观察结果:1)移除全局水平的对比学习显著降低了模型的性能,这表明其探索图结构信息对于kg感知推荐的重要性。2)在大多数情况下, MCCLK_o/wL 是最不具竞争力的模型,特别是在大规模数据集(如图书和电影)中,这表明了在local层面学习协作视图和语义视图之间的区别信息的优越性。

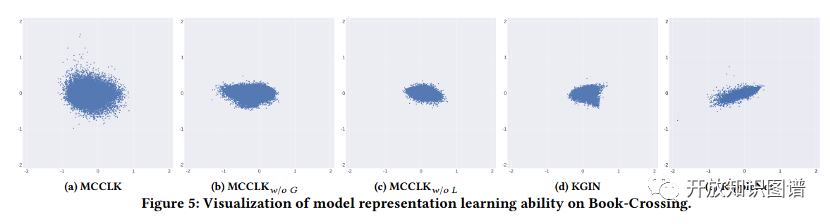

为了评估对比机制是否影响表征学习性能,在之前的对比学习工作的基础上,我们采用SVD分解将学习到的条目嵌入投影到2D中,并给出正则化的奇异值。

如图5所示,我们在Book-Crossing上比较了MCCLK、MCCLK_o/wG 、MCCLK_o/wL 、KGIN和RippleNet的可视化结果,从中我们可以观察到:

KGIN和RippleNet的节点嵌入有一定程度的混合,并落入一个狭窄的锥。相比之下,MCCLK的节点嵌入具有更多样化的分布,因此能够表示不同的节点特征信息,这表明我们在更好的表示学习和缓解表示退化问题方面的优势。

通过比较MCCLK及其变体,我们观察到,去除局部水平或全局水平的对比损失使学习的嵌入更加难以区分,这表明表示学习的有效性和鲁棒性来自多层次交叉视图的对比学习机制。

总结

本文重点探讨了KG aware推荐的对比学习,以一种自我监督的方式提高user/item表示学习的质量。我们提出了一个新的框架,即MCCLK,该框架从两个维度实现了更好的用户/物品表示学习:(1)MCCLK从全局结构视图、局部协同视图和语义视图三个视图考虑了用户/物品表示学习,并显式构造了一个k-NN的item-item语义图来挖掘语义视图中很少注意到的item-item语义相似性。(2) MCCLK在三视图之间进行多层次交叉对比学习,探索特征信息和结构信息,并进一步学习判别表征。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。