深入探讨深度学习模型性能与神经网络宽度之间关系

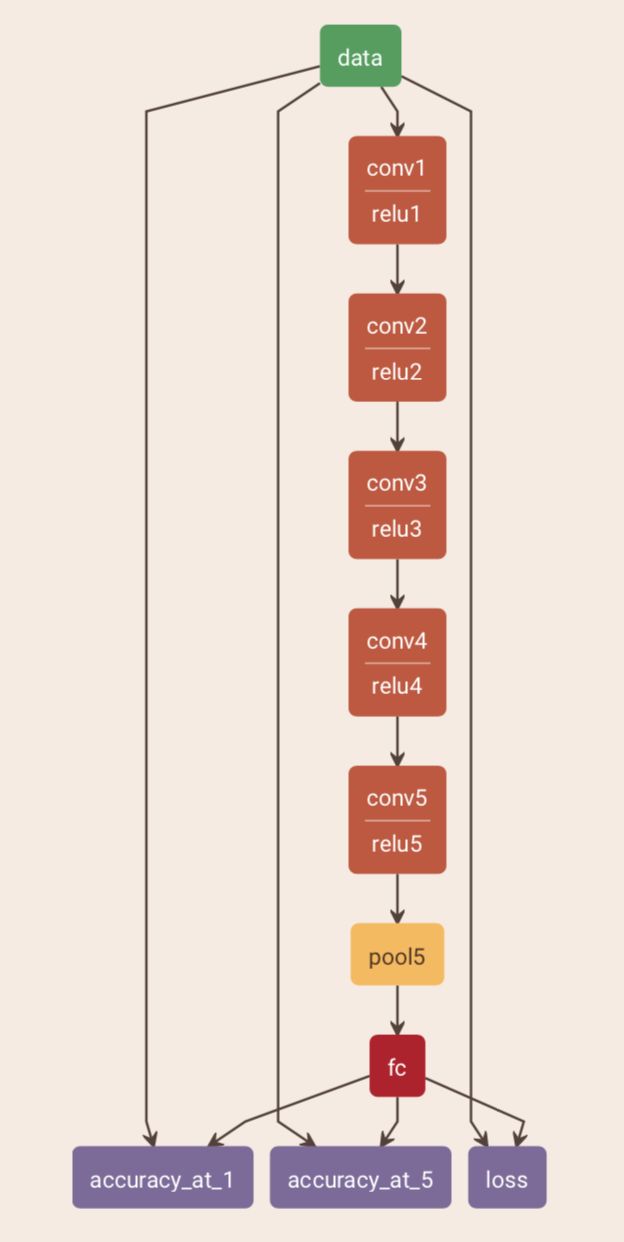

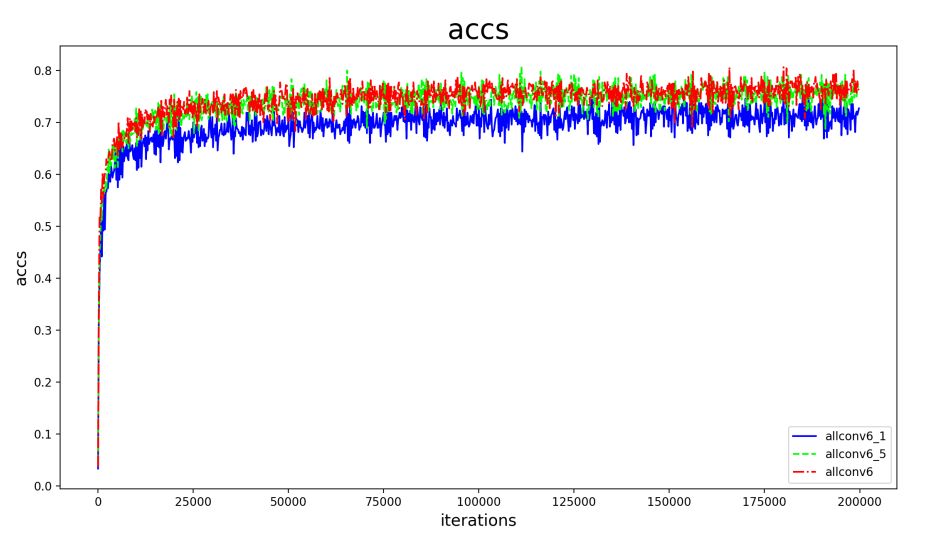

在一定的程度上,网络越深,性能越好。这一次我们来考虑另一个维度,宽度,即通道(channel)的数量。注意我们这里说的和宽度学习一类的模型没有关系,而是特指深度卷积神经网络的宽度。

1 为什么需要足够的宽度

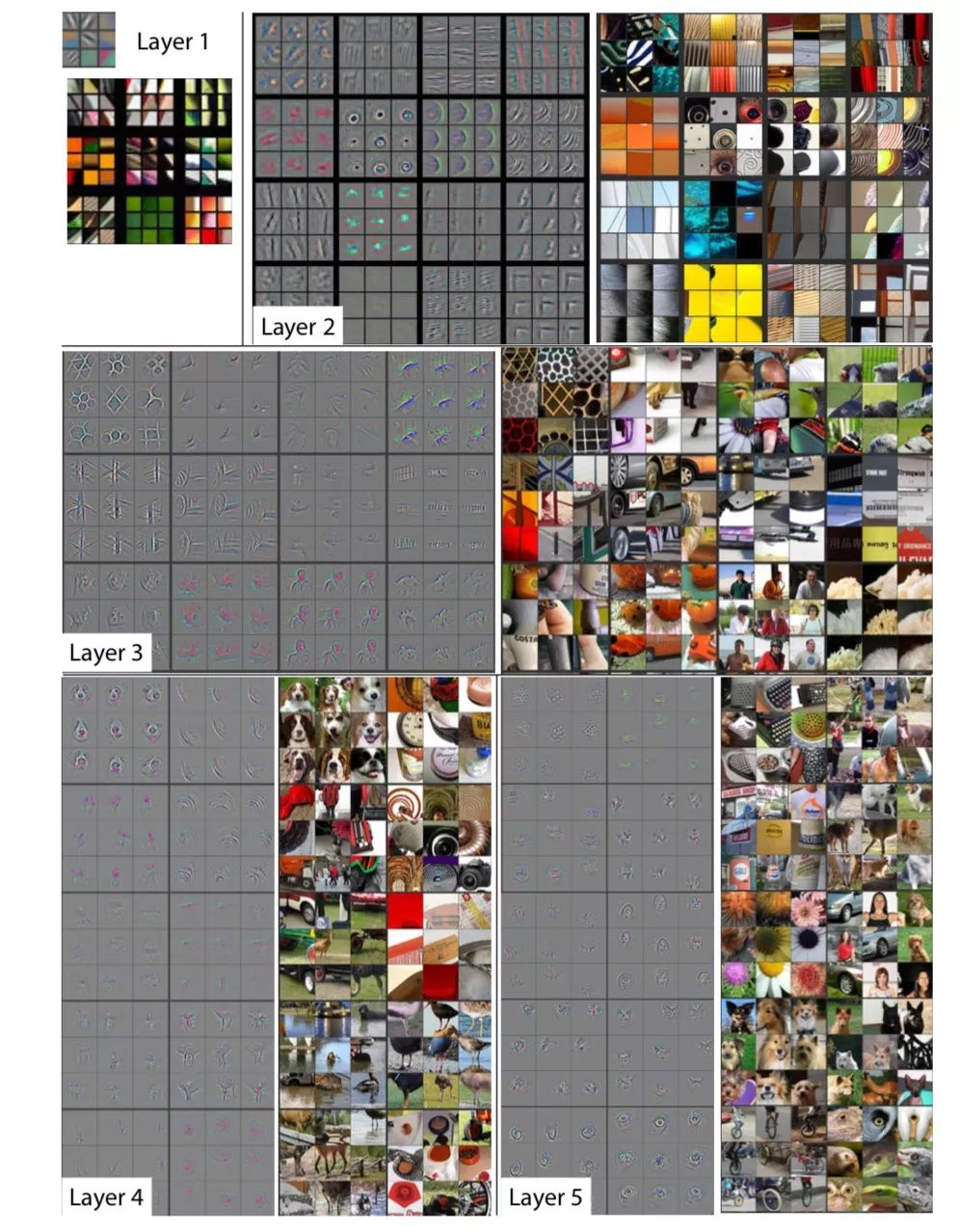

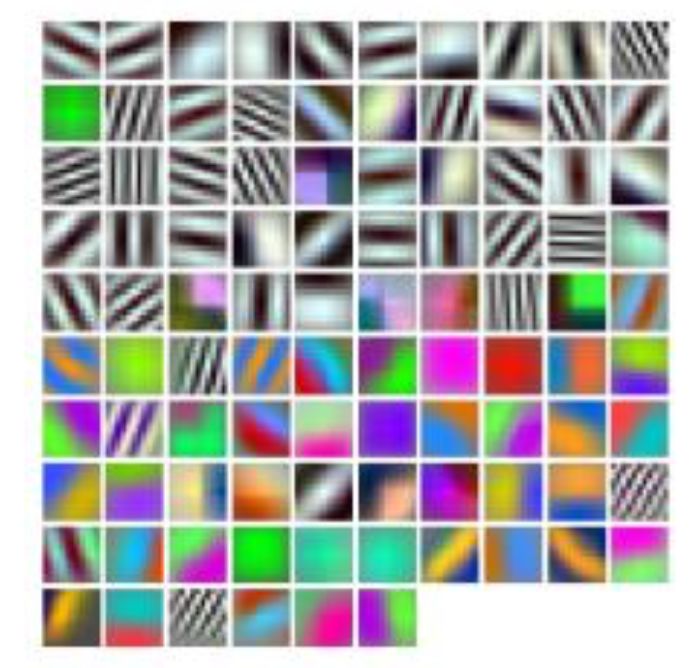

网络更深带来的一个非常大的好处,就是逐层的抽象,不断精炼提取知识,如下图第一层学习到了边缘,第二层学习到了简单的形状,第三层开始学习到了目标的形状,更深的网络层能学习到更加复杂的表达。如果只有一层,那就意味着要学习的变换非常的复杂,这很难做到。

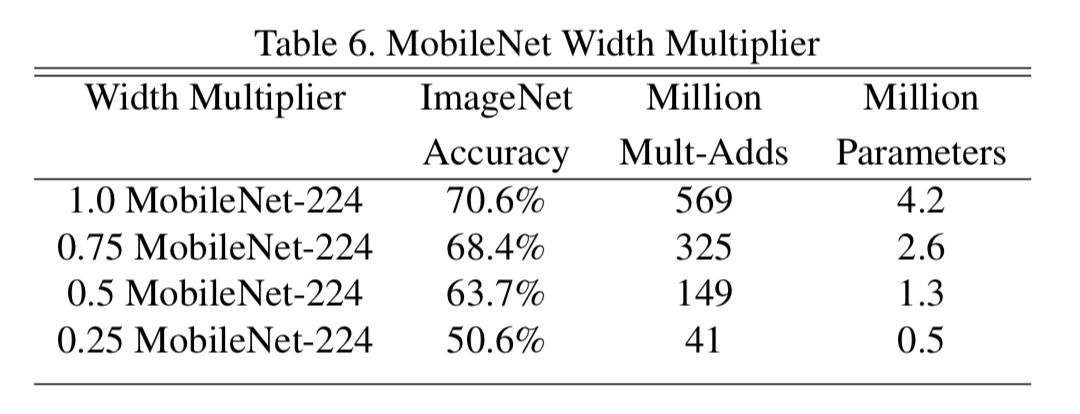

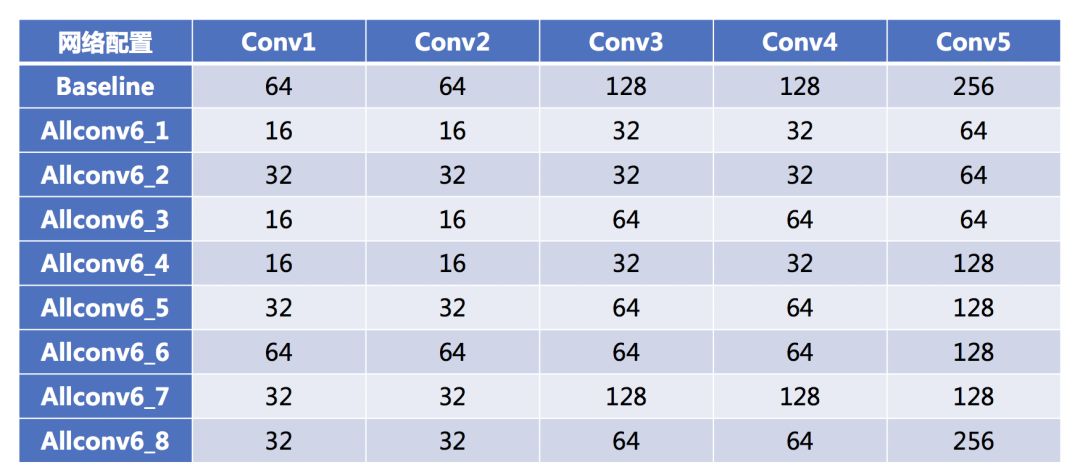

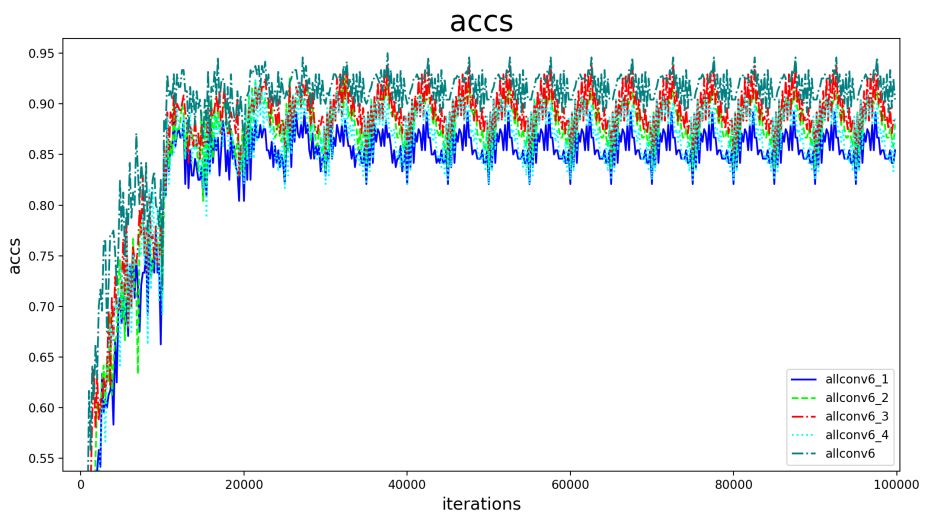

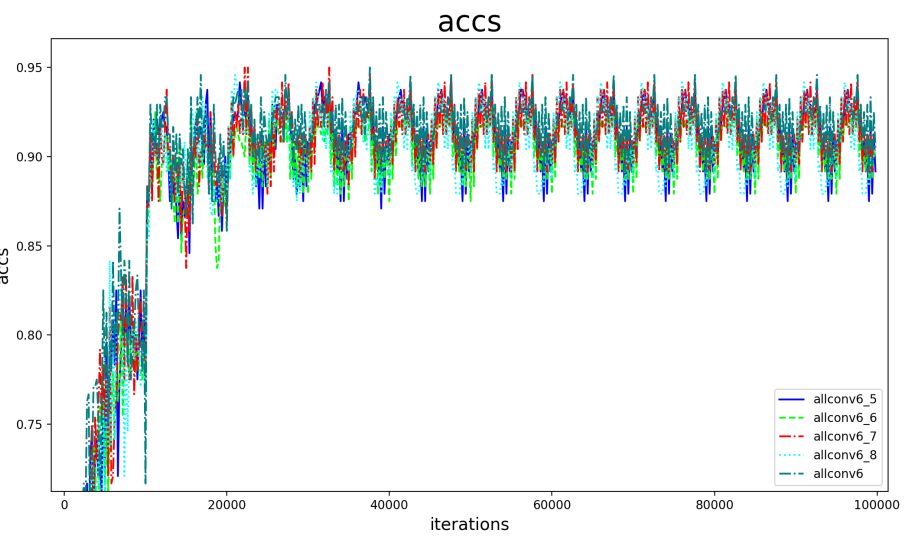

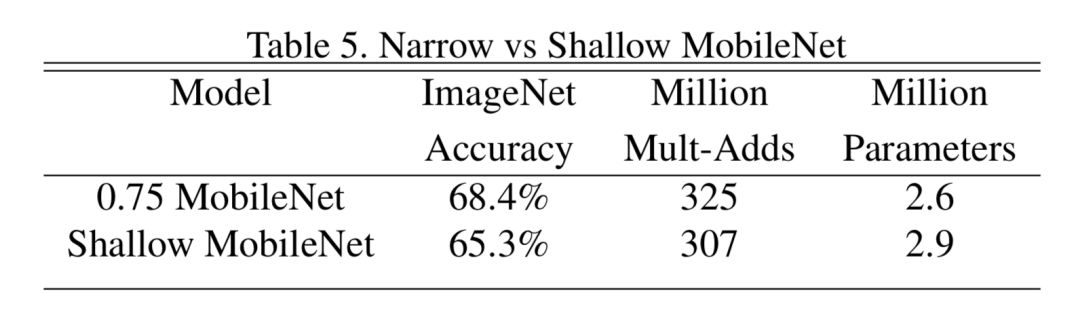

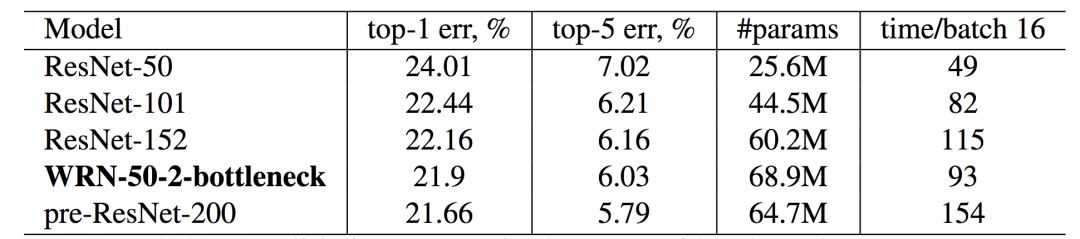

2 网络到底需要多宽

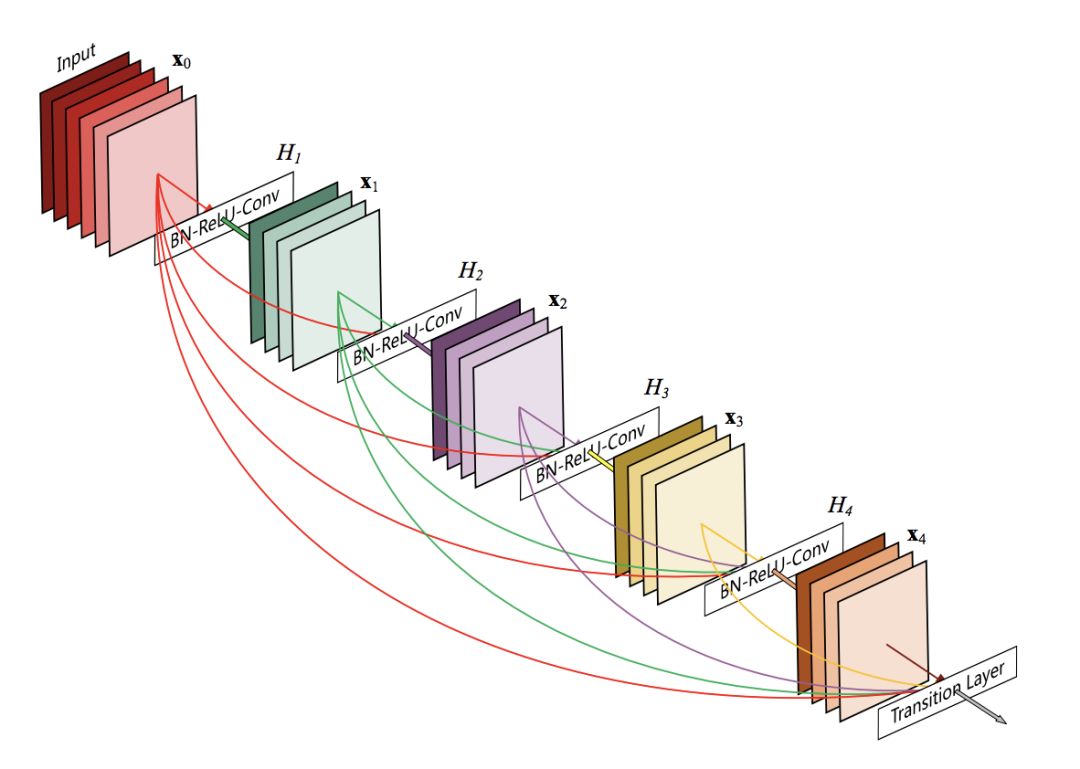

3 如何更加有效地利用宽度?

总结

送书福利

《深度学习之模型设计:核心算法与案例实践》

➤章节目录:

本书得到了依图科技CTO、新加坡工程院院士、IEEE Fellow颜水成教授,新智元创始人、CEO 杨静,中国科学院半导体研究所研究员鲁华祥,知识星球CEO吴鲁加4位业内大咖的鼎力推荐,是一本非常优质,适合任何深度学习领域从业者学习的好书。

登录查看更多

相关内容

Arxiv

3+阅读 · 2018年12月13日

Arxiv

7+阅读 · 2018年5月24日

Arxiv

3+阅读 · 2018年1月18日