微表情是一种短暂的、微弱的、无意识的面部微表情,持续时间往往在0.5s内,能够揭示人类试图隐藏的真实情绪。微表情识别的研究旨在让机器有足够的智能,能够从人脸视频序列中识别人类的真实情绪。然而由于微表情持续时间短、面部肌肉运动强度低,对其进行准确的表征与识别是一项极具挑战性的任务。为了促进心理学领域和计算机视觉领域针对微表情的进一步研究,由中国图象图形学学会(CSIG)和中国科学院心理研究所主办、CSIG机器视觉专业委员会和CSIG情感计算与理解专业委员会联合承办,中国科学院心理研究所的王甦菁博士组织了一系列云上微表情的学术活动。

![]()

第三十二期云上微表情于2022年9月30日晚上7点进行,由中国科学院心理研究所王甦菁老师团队的李婧婷博士主持。此次讲座邀请到来自山东大学的贲晛烨教授和芬兰奥卢大学的李晓白助理教授介绍SOTA微表情数据库:MMEW与4DME。此次讲座得到了微表情研究领域的广泛关注,期间有五十余名听众参加了此次讲座。

-

Micro-and-macro expression warehouse (MMEW) – 山东大学贲晛烨教授

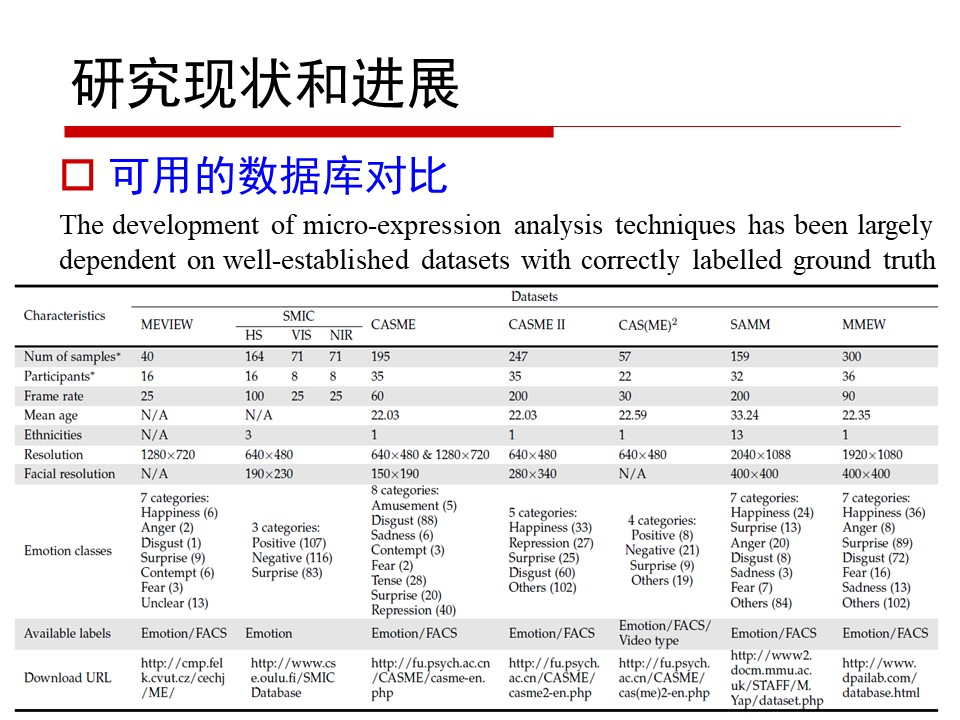

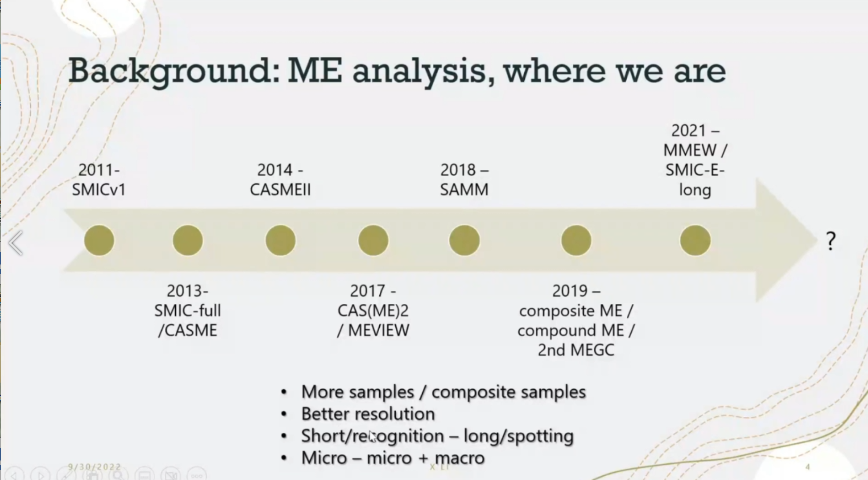

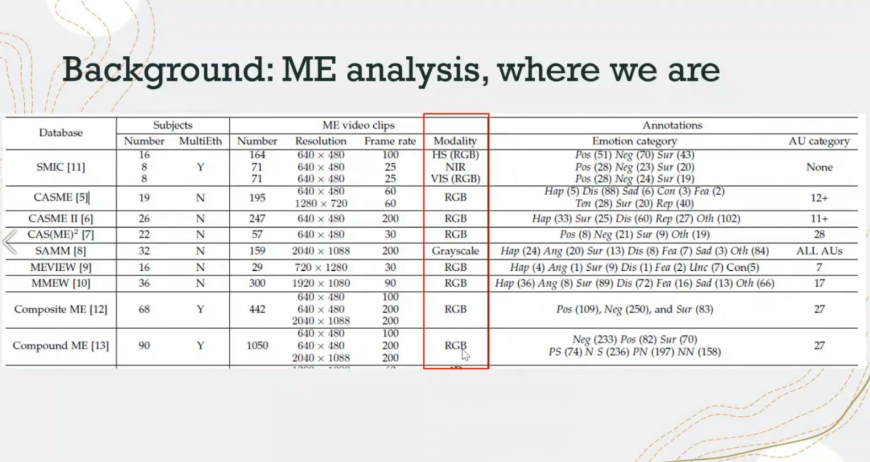

微表情是一种不受思维控制的面部表情,具有持续时间短暂、变化幅度微弱、动作区域较少等明显区别于宏表情的特点。当前微表情在国家安全、司法审讯、谎言测试等领域潜在的应用价值引起了人们极大的关注。随着计算机模式识别技术的发展微表情相关研究取得了很多成果,但作为研究基础的微表情数据库由于微表情捕捉困难、采集过程复杂、人工编码费时耗力和图像质量评价标准缺失等原因导致数据库样本数量不足、质量参差不齐,越来越无法满足微表情研究工作。针对上述问题,贲教授在本次报告深入分析了现有微表情数据库的特点。

![]()

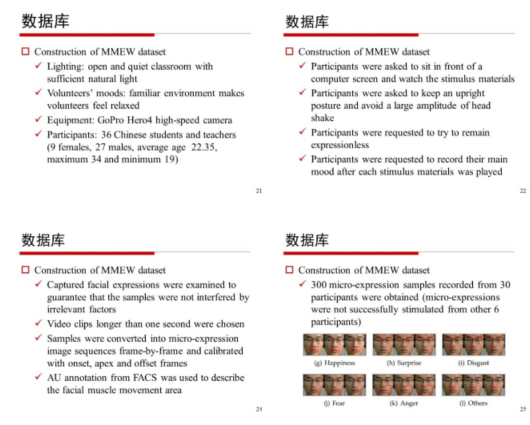

然后贲教授及其团队通过合理设置实验环境,改进实验方法等措施,建立了MMEW微表情数据集,该数据集种类齐全、图像分辨率最高。

![]()

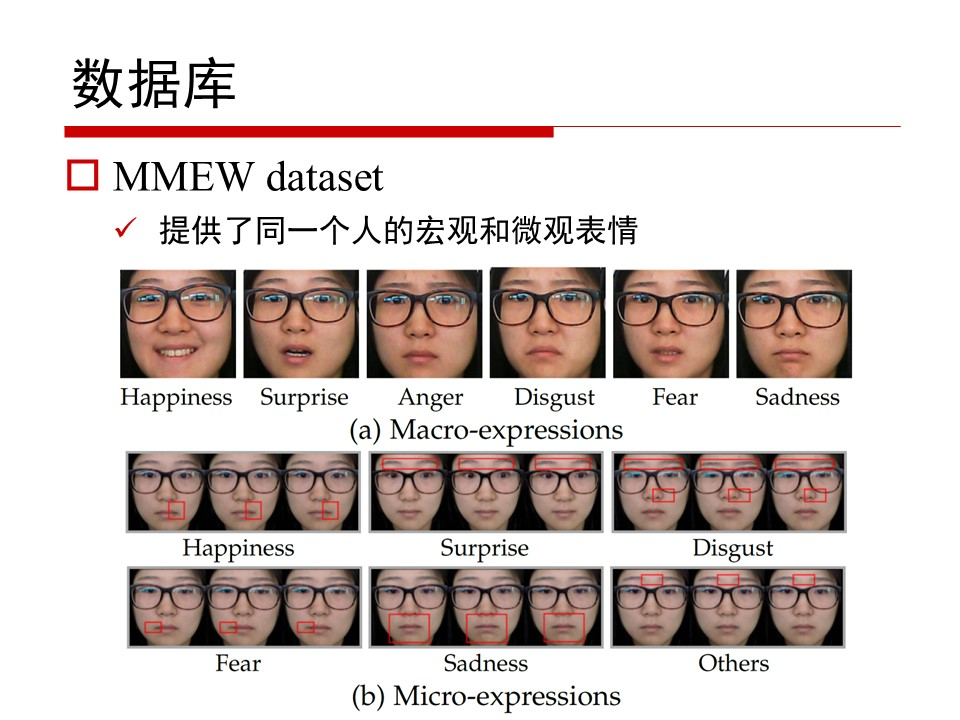

此外,MMEW 还提供了 900 个具有相同类别类别(快乐、愤怒、惊讶、厌恶、恐惧、悲伤)的宏表情样本,由同一组参与者提供,这些可能有助于进一步的跨模态研究(例如,从宏表情到微表情)。

![]()

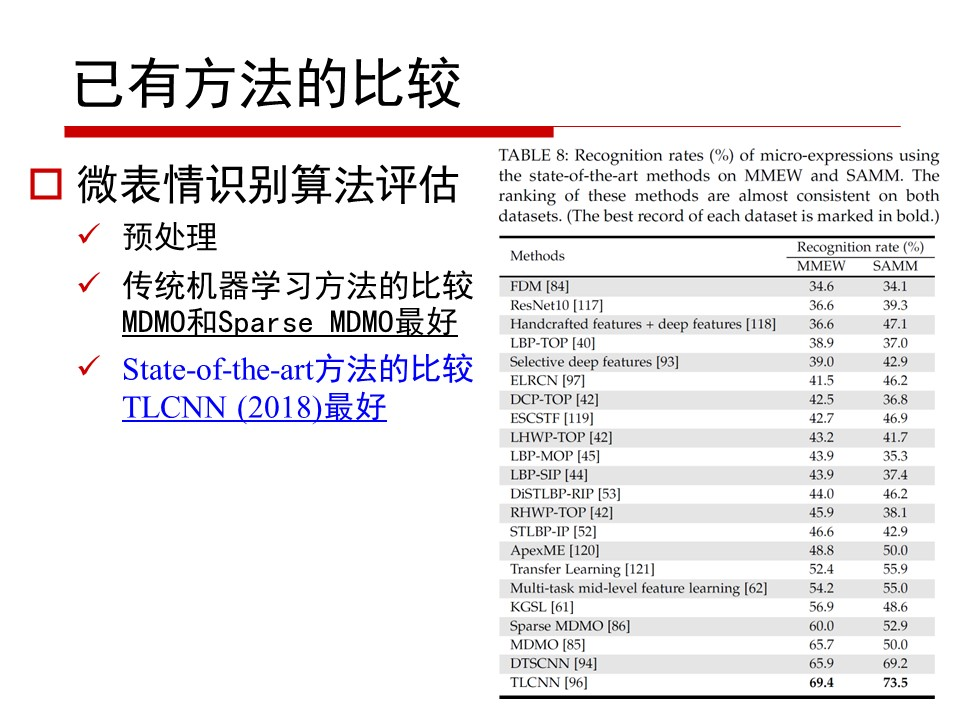

贲教授还提出被试独立和被试依赖两种微表情识别性能的评测方法,应用代表性方法在MMEW进行了统一公平比较。

![]()

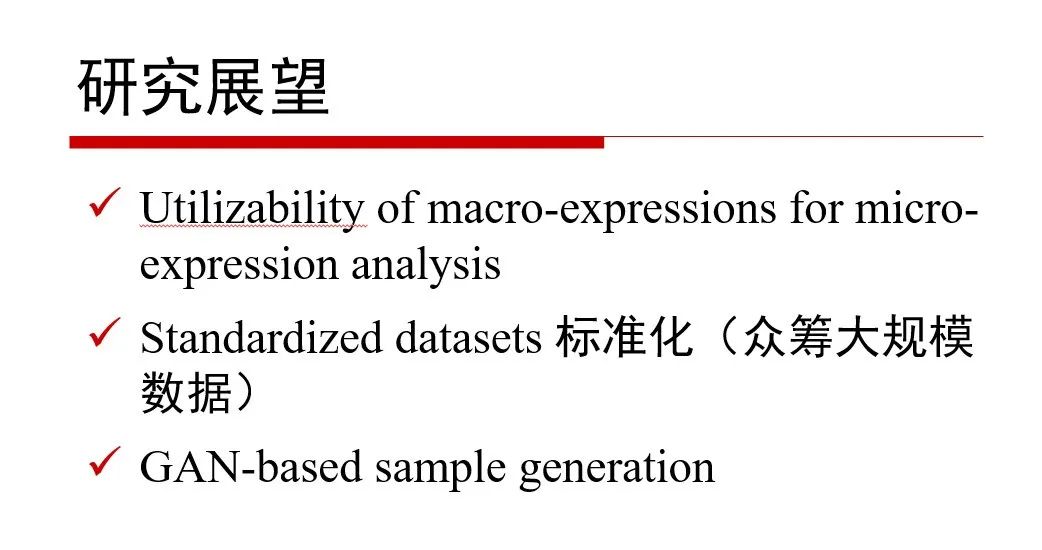

最后,贲教授概述了一些潜在的未来研究方向。

![]()

特别地,如果希望申请下载MMEW数据库,请填写许可协议后发送给贲晛烨教授。此外,如果是学生申请者,需由其导师签字并提交申请。

![]()

论文信息:

Ben, X., Ren, Y., Zhang, J., Wang, S. J., Kpalma, K., Meng, W., & Liu, Y. J. (2021). Video-based facial micro-expression analysis: A survey of datasets, features and algorithms. IEEE transactions on pattern analysis and machine intelligence.

-

4DME:新的4D微表情数据库

–

芬兰奥卢大学的李晓白助理教授

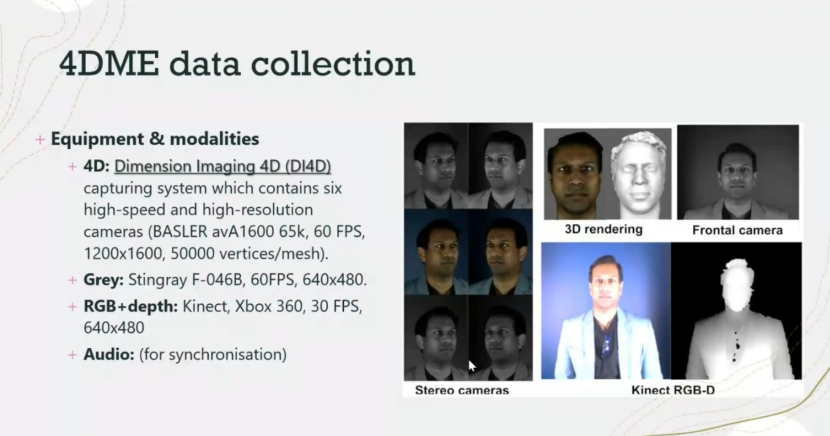

微表情是一种特殊形式的面部表情,当人们出于某些原因试图隐藏自己的真实感受时,就会出现这种表情。微表情是揭示人们真实情感的重要线索,但由于它们非常简短和微弱,普通人很难或不可能用肉眼捕捉到。李晓白博士等人希望能够开发出强大的计算机视觉方法来自动分析微表情,这需要大量的微表情数据。目前的微表情数据集并不充分,大多只包含单一形式的2D彩色视频。

![]()

![]()

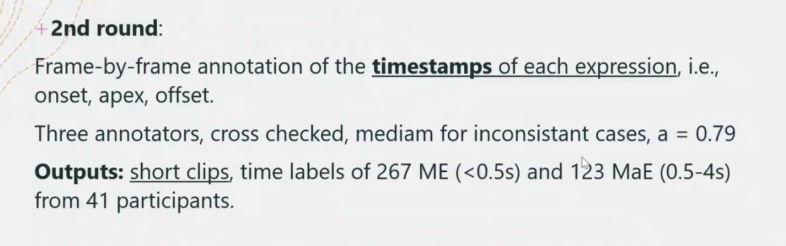

对普通面部表情的4D数据的研究已经取得了进展,但到目前为止还没有4D数据可用于微表情研究。在目前的研究中,李晓白博士介绍了4DME数据集:一个新的自发的微表情数据集,包括4D数据和其他三种视频模式。

![]()

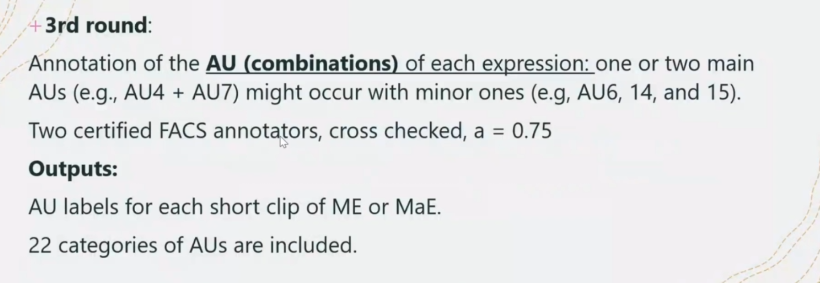

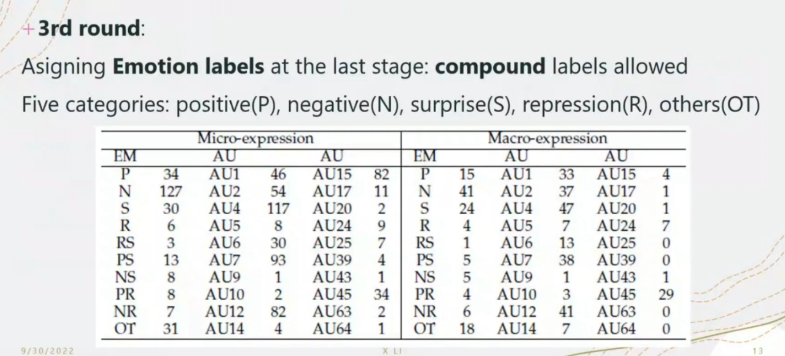

在4DME中,微表情和宏表情的视频片段都被标注出来,22个AU标签和5类情感标签被标注出来

。

![]()

![]()

![]()

![]()

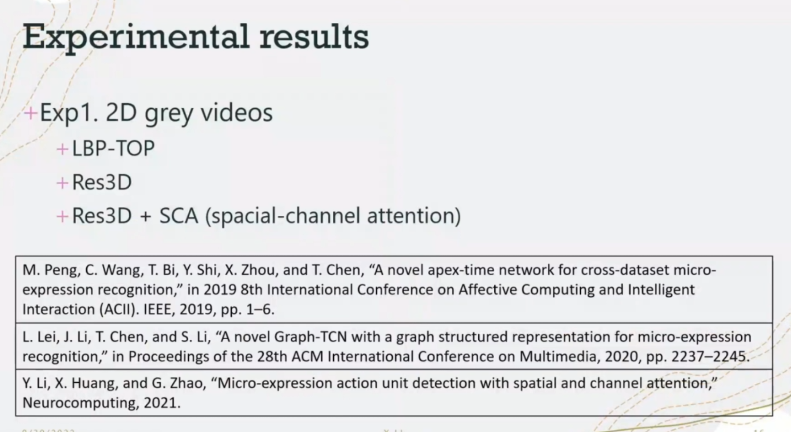

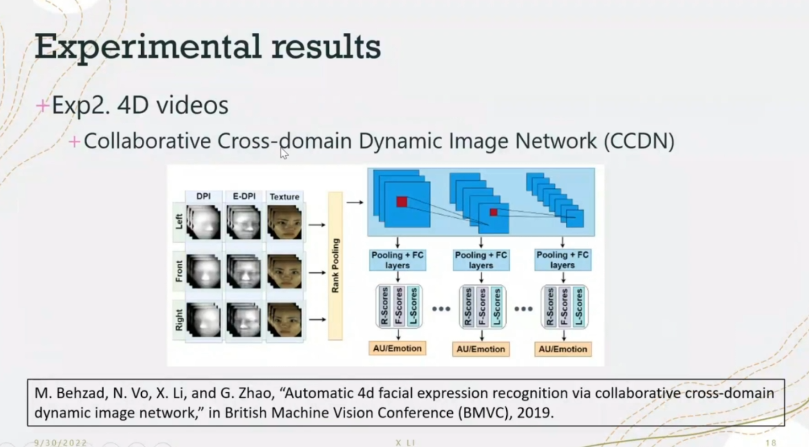

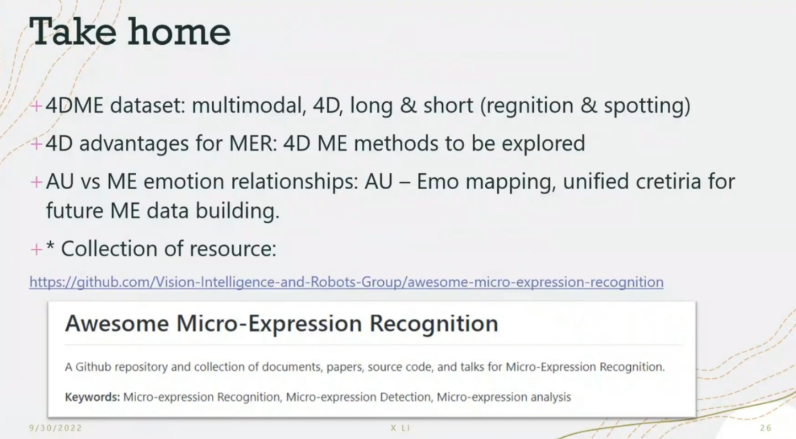

此外,李博士等人通过实验,使用三种基于2D的方法和一种基于4D的方法来提供基线结果。实验结果表明,4D数据可以潜在地有利于微表情识别。

![]()

4DME数据集可用于开发基于4D的方法,或探索融合多个视频源(例如,纹理和深度)用于未来的微表情分析任务。

![]()

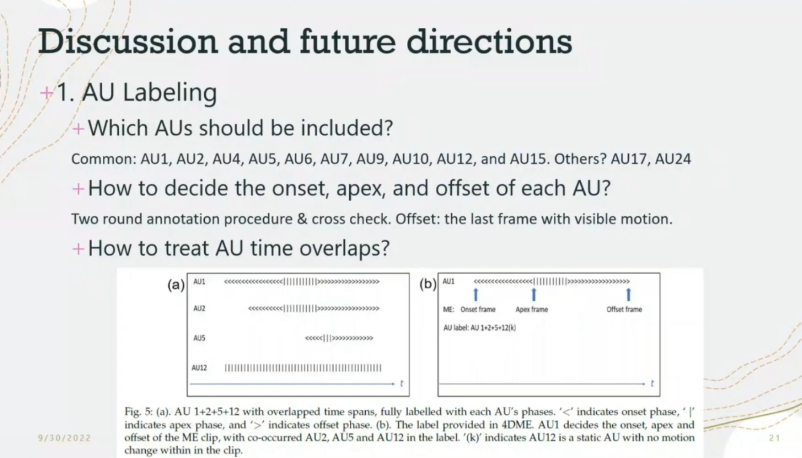

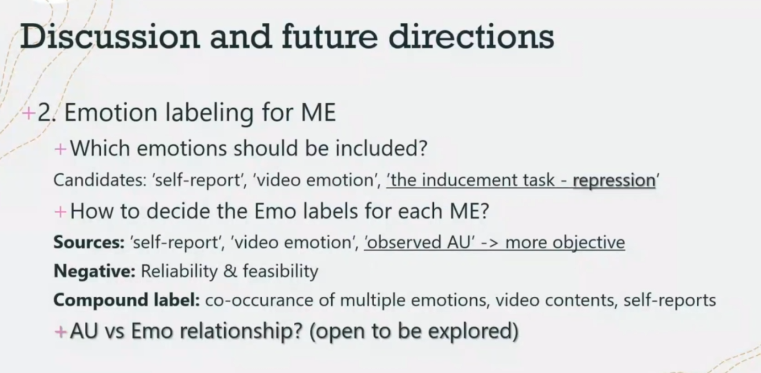

此外,李博士还强调了形成一个明确和统一的微表情注释标准对未来微表情数据收集研究的重

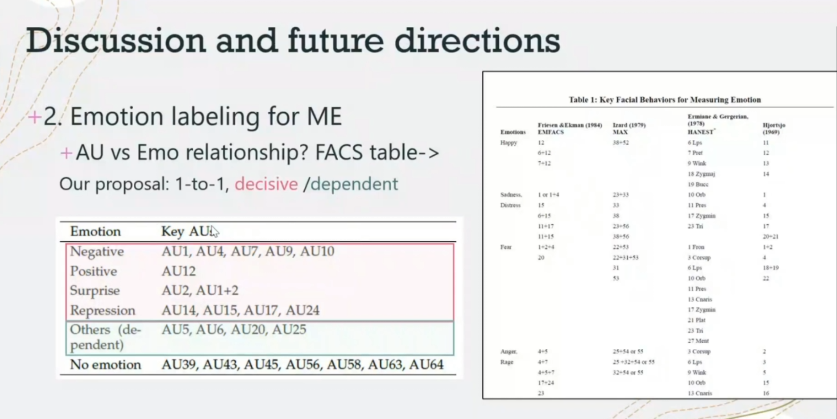

要性。李博士列出并深入讨论了与微表情注释相关的几个关键问题,特别是关于AU和微表情情感类别之间的关系。李博士提出了一个初步的AU-Emo映射表,并给出了合理的解释和支持性的实验结果。

![]()

![]()

![]()

此外,还总结了几个尚未解决的问题,供今后工作参考。

![]()

Xiaobai Li#, Shiyang Cheng# (equal contribution), Yante Li, Muzammil Behzad, Jie Shen, Stefanos Zafeiriou, Maja Pantic, Guoying Zhao*. “4DME: A spontaneous 4D micro-expression dataset with multimodalities.” (2022), IEEE Transactions on Affective Computing (accepted).

M. Behzad, N. Vo, X. Li, and G. Zhao, “Automatic 4d facial expression recognition via collaborative cross-domain dynamic image network,” in British Machine Vision Conference (BMVC), 2019

.

Y. Li, X. Huang, and G. Zhao, “Micro-expression action unit detection with spatial and channel attention,” Neurocomputing, 2021.

S. Cheng, I. Kotsia, M. Pantic, and S. Zafeiriou, “4dfab: A large scale 4d database for facial expression analysis and biometric applications,” in Proceedings of the IEEE conference on computer vision and pattern recognition, 2018, pp. 5117–5126..

在问答环节,听众和讲者们就微表情时长定义、微表情应用场景与采集设备的使用、微表情标注过程中被试自我报告与AU标注的权衡、微表情数据的去隐私化、微表情智能分析算法与普通表情分析算法的区别等问题进行了讨论。

在活动的最后,讲座的主持人李婧婷博士对活动进行了总结并对第三十三期CSIG云上微表情活动进行了预告。敬请继续关注!

此次讲座的回放已经发布在B站,欢迎观看!

https://www.bilibili.com/video/BV1P8411x71z?share_source=copy_web&vd_source=da367a2f90a1bbb21d8762ab6354d4ea

最后,中国科学院心理研究所微表情实验室(MELAB)诚聘博士后,微表情相关方向、计算机或心理学专业皆可,有意请联系王甦菁老师(wangsujing@psych.ac.cn)。