这项将在 4 月底正式发表于 NDSS 2022(计算机安全四大顶会之一)的研究,揭示了自动驾驶场景下多个以前未知的语义 DoS 漏洞。

![]()

如今,高等级自动驾驶(AD)车辆,即在大多数情况下可以在没有人类驾驶员的情况下自动驾驶的车辆,已经公开上路。一些公司,如 Waymo、百度、GM Cruise,也已经在提供没有安全驾驶员公共服务。在大规模部署之前,了解此类系统中可能存在的安全风险非常重要。典型的自动驾驶系统具有传感、规划和控制步骤。传感步骤使用不同的传感器(例如,相机、激光雷达、GPS)来了解周围环境。规划步骤根据周围环境生成驾驶轨迹。规划将为自动驾驶车辆做出关键任务决策,例如避免碰撞、变道。控制步骤将为车辆生成控制命令,使其可以完成计划的轨迹。先前的工作研究了在各种物理世界攻击下感知的安全风险,例如传感器欺骗或设计具有恶意外观、纹理或形状的对象。

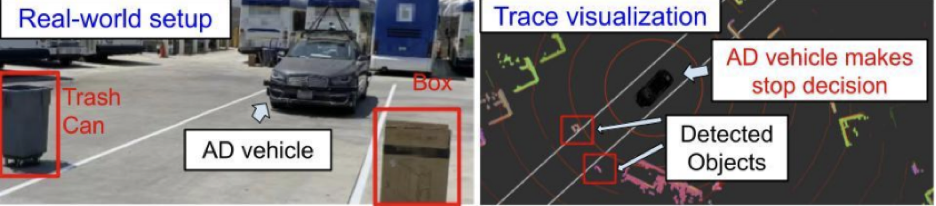

在这项工作中,我们完成了第一个特定于规划的安全分析。我们想研究攻击者是否可以通过简单地以正常方式改变周围环境(例如在另一条车道上驾驶另一辆车,或将常见物体放置在车道外)来将规划决策变为意想不到的决策。

![]()

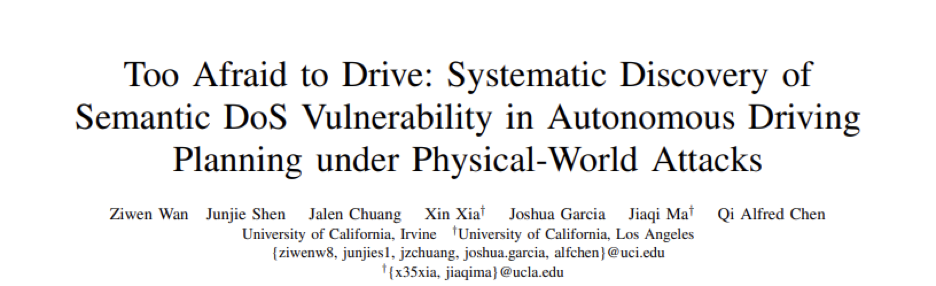

Fig. 1:自动驾驶规划语义 DoS 漏洞的问题定义

由于我们的目标是了解可能导致意外决策的安全风险,因此需要一个新的漏洞和攻击模型的定义。我们假设攻击者可以使用自动驾驶车辆周围的可控物体来改变规划的输入。这些物体可以是被丢弃的纸板箱、停放的自行车或移动的车辆,而对形状、质地或外观没有任何要求。这使我们的攻击变得切实可行。此外,我们要求物体遵循正常驾驶规范,例如物体不得放置在车道内,因此攻击是隐蔽的。

我们还定义了自动驾驶规划中的语义漏洞,这与一般漏洞的症状不同。自动驾驶规划中的语义漏洞是那些可以被利用并因此导致意外驾驶决策的漏洞。意外的决定可能是过于激进的决定(例如撞到障碍物)或过于保守的决定(例如紧急停止或不必要的永久停止)。我们将重点放在后面的一个,因为我们认为这在当今的系统中更为普遍。我们也将它们称为语义 DoS 漏洞。

![]()

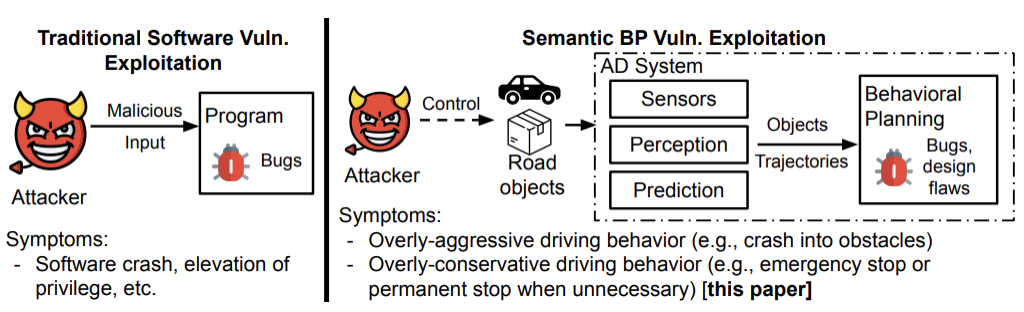

我们设计了一种名为 PlanFuzz 的新型动态测试工具 (Fig. 2),用于自动化语义 DoS 漏洞的发现过程。

由于漏洞定义是特定于域的,因此我们将规划不变量 (PI) 定义为测试标准。对此的定义是,在特定的规划场景下,无论攻击者可控物体如何变化,规划决策都应该始终相同。我们已经用时序逻辑形式化表达了规划不变量。在论文中,我们定义了 8 种不同驾驶场景下的通用约束,包括对静态物体和移动行人 / 车辆的约束。此外还有一个三步输入生成策略,以强制生成的输入能满足给定的条件,同时在为测试生成输入的过程中仍保持多样性和继承性。

为了提高测试效率,我们还设计了一个新的距离度量,称为 BP 漏洞距离,用于指导决策向意外的变化。我们的关键思想是利用那些与决策相关的条件中两个操作数之间的距离来导致决策变化。我们执行静态分析以提取控制 / 数据依赖关系。并且我们在在线测试之前基于依赖关系修改了程序的 binary 加入了用于计算这个距离的指令。因此,程序可以在在线测试阶段直接生成此距离度量。

我们的工具可以在百度 Apollo 和 Autoware.AI 的 3 种不同实现中成功发现 9 个以前未知的语义 DoS 漏洞。这些漏洞是在不同的驾驶场景下发现的,包括车道跟随、车道变换、车道借用和不同的交叉路口行车。触发语义 DoS 漏洞的方式也多种多样,包括将静态物体或停放的自行车放置在道路旁,以及在受害车辆周围驾驶车辆。

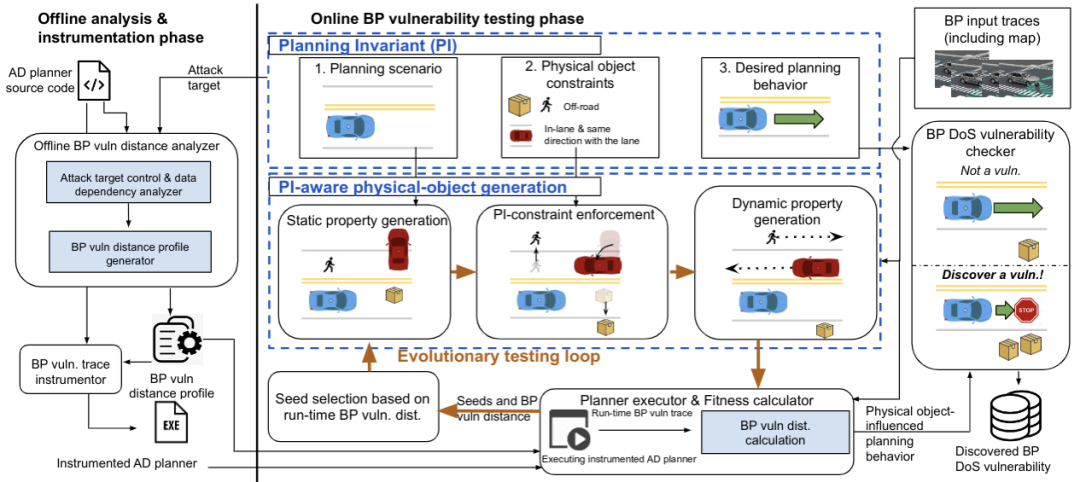

![]()

Fig. 3:Autoware.AI 车道行驶的语义 DoS 漏洞以及可能带来的追尾。攻击视频链接: https://www.youtube.com/watch?v=P5IdQ_R5WWY.完整视频信息链接:: https://sites.google.com/view/cav-sec/planfuzz#h.wxdo4hk0wfac.

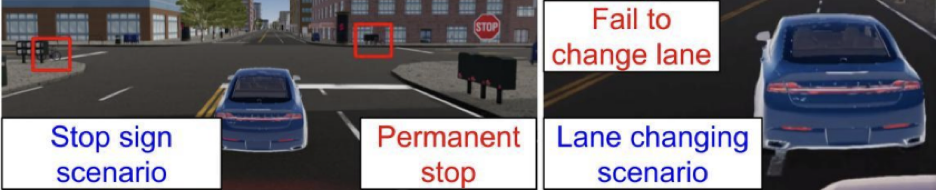

在 Fig. 3 中,攻击者可以通过放置两个偏离车道的静态物体来利用 Autoware.AI 中发现的一个漏洞,并在高速公路出口匝道上车道完全是空的情况下触发一个急剧且永久的停车。我们的案例分析表明,一种可能的安全后果是追尾碰撞。

![]()

Fig. 4:Autoware.AI 车道行驶的语义 DoS 漏洞的真车轨迹案例分析。攻击和正常场景对比视频链接: https://www.youtube.com/watch?v=eb7bEXrUPE4&t=1s. 完整视频集合: https://sites.google.com/view/cav-sec/planfuzz#h.4h1r5aah9kyo.

我们还通过从真实 AD 车辆收集的驾驶轨迹证明了此漏洞 (Fig. 4)。

![]()

Fig. 5:Apollo 停止标志和变道场景下的语义 DoS 漏洞迹案例分析。停止标志场景攻击视频: https://www.youtube.com/watch?v=dCWJTyiE_-s. 变道场景攻击视频: https://www.youtube.com/watch?v=DRvot2-9pOg. 完整视频集合: https://sites.google.com/view/cav-sec/planfuzz#h.n3txvyhytxt1.

此外,我们还展示了攻击者可以在停止标志的场景下使用停在十字路口周围的自行车来触发停车线前的永久停车。此外,在变道场景中,如果攻击者在特定条件下跟随受害车辆,它则放弃变道决定 (Fig. 5)。

我们还对发现的语义 DoS 漏洞的根本原因进行了调查。在发现的 9 个漏洞中,一个是由程序实现的错误引起的,另一个是由过于保守的规划参数(例如安全缓冲区、角度阈值)和对于周围行人和车辆运动趋势过于保守的估计引起的。

此外,我们已经通知了 24 家正在开发自动驾驶车辆的公司。他们中的一些回复了我们,他们目前正在针对此安全风险进行调查。

本次研究作者团队,来自加州大学尔湾分校、加州大学洛杉矶分校,一共 7 名研究人员。其中第一作者 Ziwen Wan 和第二作者 Junjie Shen 都是加州大学尔湾分校在读博士生。Jalen Chuang 以本科生身份参与本项目。Alfred Chen 和 Joshua Garcia 是加州大学尔湾分校计算机系和信息学系的助理教授。Xin Xia 和 Jiaqi Ma 分别是加州大学洛杉矶分校土木工程系的博士后和教授。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com