神经网络要从原子抓起:原来白花花的银子才是神经芯片的未来

本文授权转载自AI科技大本营(ID:rgznai100)

编译 | ziqi Zhang

审校 | 波波

最近几年,神经网络、深度学习的风靡程度简直可以跟当年美国19世纪中期的淘金热同日而语。大量研究者从传统的“机器学习”方法转向了对“神经网络”的研究。的确,一方面由于大量训练数据作为支撑,另一方面其内部的原理模仿了人类大脑神经网络的基本构造和功能,使得“神经网络”这一方法获得了不错的效果。

然而,伴随着机房里成排的“服务器”发出巨大的轰鸣声,你花费着几个星期甚至几个月的时间,去训练一个人类几秒钟就可以解决问题的神经网络的时候,你是否想过有一天会出现一个实体?它能真正模仿人类大脑神经的结构和功能,而不再需要依靠代码构造假的神经网络。

最近,在加州大学洛杉矶分校(UCLA)的加州纳米系统研究所(CNSI),研究人员成功开发出了纳米级别的神经元芯片,其功能和结构与人类大脑极为相似。

大脑,作为人类最重要的器官之一,不仅仅赋予人类相比动物更加敏锐的思维和解决问题的能力,同时还是身体上执行效率最高、能量转化率最充分的器官。人类大脑的功耗仅仅是一枚20w白炽灯泡的能耗,相反,作为世界上运算速度最快的计算机之一,日本神户K型超级计算机的功耗竟高达9.89兆瓦,相当于10000户家庭的用电需求。你敢相信吗?而在2013年,即便是消耗这么大的能量,这个庞然大物仍然要用40分钟的时间才能模拟出人类大脑在1秒钟内的思维活动的1%。

所以,UCLA加州纳米系统研究所的研究人员,就想让电脑系统在计算性能和功耗方面能像人脑一样高效,他们的方法是模拟大脑的结构来构建一个新系统。根据研究所副主任、研究科学家Adam Stieg的说法,他们正在打造的设备,可能是世界上第一种“真正受大脑结构启发,并能表现出某种大脑特性的设备。”他跟UCLA化学教授Jim Gimzewski共同领导该研究项目。

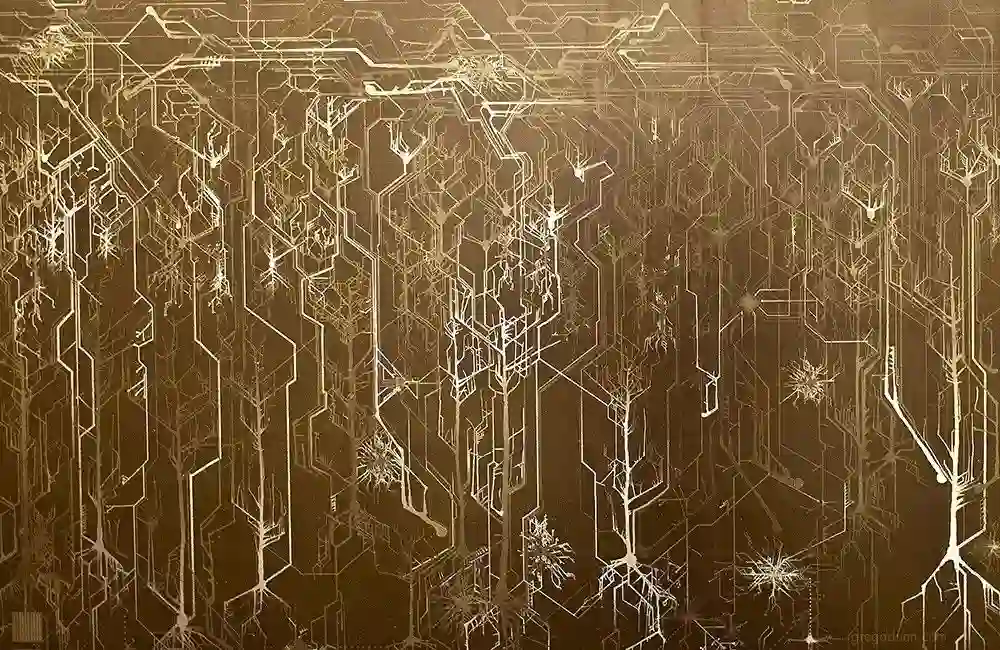

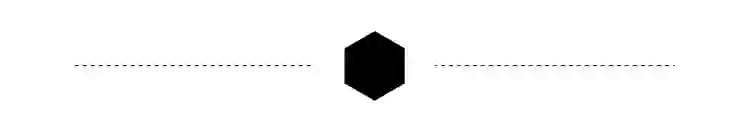

不同于传统电脑,新设备不是基于硅芯片的高度有序微电路,而是一块2mm见方的神经元芯片。该芯片上布满了由人造突触所连成的银制纳米电路。不同于硅芯片上极为规则的几何电路,该芯片看上去相当杂乱,就像“相互纠缠起来的一盘面条”。事实上,这种混乱并非是UCLA刻意设计出来的,而是芯片借由随机的化学和电气工序自己“生长”出来的。

其实,在这看似杂乱无章的背后,是一种有序的科学,因为这些纳米级的乱网恰恰是在模仿大脑内部的神经网络。该网络每平方厘米所拥有的人造突触梳理大约是10亿,这跟真实的大脑神经网络处在同样的水平。同时,该人造网络的电活动还表现跟大脑一样的独有特质:临界,这是一种介于有序和无序之间的状态,是工作效率最大化的一种表现形式。

更重要的是,初步的实验已经证明,该类脑神经元网络在功能方面有着巨大的潜力。比如,它可以进行一些简单的学习和逻辑操作。具体来说,它能轻松过滤接收信号中的噪音,这一点对于当前的语音识别或其它相似任务来说是非常重要,而传统电脑在执行此类任务时往往力不从心。这就意味着,人类终有一天能造出一台在计算能力和功耗方面可以跟人脑匹敌的设备。

鉴于传统硅芯片在微型化及能耗方面日益逼近其技术上的极限,该神经元芯片的优势便相当有吸引力了。“摩尔定律已死,晶体管已经不可能做得更小了,人们总是在问:我们今后该怎么办?”神经拟态计算公司CEO Alex Nugent表示他非常看好UCLA这一项目,尽管并未参与该项目,他对这里的进展还是相当兴奋:“我非常喜欢这个想法的前景,传统计算平台在效能方面至少要落后十亿倍。”

十年前开始进行该项目的时候,Gimzewski教授的目的并非是芯片能效,而仅仅是感到无聊。毕竟那时,他已经用隧道扫描显微镜在原子尺度上观察电路达20年之久了,他是这样说的,“我对其中的完美和精确控制感到有点厌倦,其背后的还原论尤其让我无聊。”

2007年,他收到Masakazu Aono的邀请一起来研究单原子开关,后者正在领导位于日本筑波的材料纳米结构国际中心。该原子开关的材料是硫化银,即银制勺子接触鸡蛋后所变成的黑色物质,介于固体和金属状态间。

这是一个神奇的电化学反应:向该设备施加电压时,带正电的金属银离子将从硫化银中转移到阴极的金属银一端,并被还原成银单质。随着原子大小的银丝纤维的不断生长,阴极和阳极之间空隙不断被填充,最终把开关闭合、让电流接通。反过来,施加反向电压则能产生相反的效果:银桥收缩,开关断开。

开始研究这个原子开关不久,Aono的团队就发现了一些不同寻常的现象。原子开关用得越多,开关闭合起来就越容易。如果有一段时间不用,它自己也会慢慢断开。换句话说,开关可以记住自己过去的情况。Aono他们还发现,不同的原子开关之间似乎可以相互交流,比如激活一个开关,有时会抑制甚至关闭相邻的其他开关。

Aono团队的多数成员都想把这一开关的古怪特性用到别的地方。其中,Gimzewski和Stieg(后者刚在前者团队拿到博士学位)则想到了神经元突触,也就是人脑神经细胞之间的信号开关,它们也会依据过往的情况来做出不同的反应,彼此之间也会相互影响。在他们多次访问日本的过程中,一种这样的想法冒了出来:我们为什么不能试试把这开关嵌入到哺乳动物大脑皮层的记忆结构里面呢?(这样我们就能好好研究其中的作用机制)。

但如何造出这一复杂的嵌入结构相当有挑战性,Stieg和刚刚加入团队的研究生Audrius Avizienis一起,想出来一种可行的草案。通过将硝酸银溶液倒在微小的铜球上,他们让极其细小的银丝相互交织成一层薄薄的网络。而后将其暴露在硫蒸气中,以在银丝之间生成一个硫化银层,正如Aono团队最初的原子开关一样。

当Gimzewski和Stieg把他们的成果告诉其他人时,几乎没有人会认为这样的原子开关可行。有人认为这种设计最终只能呈现出某种静态的活动,并稳定在那里;另有一些人则表达出相反的看法:开关效应将导致网络上所有的连接发生级联,使得电路短路,最终芯片被烧毁。

但是事实上,该设备并未烧毁。通过红外线摄像机观察,Gimzewski和Stieg发现,当电流通过设备时,它会不断改变路径——这一点证实了该网络的电流活动不是固定在局部,而是像人脑内部一样高度分散的。

然后到2010年秋天,Avizienis和他的研究生Henry Sillin有一天做实验,他们在增加输入电压的时候,突然发现输出电压开始波动,看上去还是随机的,就像这张由无数银丝构成的网一下子活了起来。Sillin说:“我们就着迷地坐在那,静静地看这奇妙的现象。”

异象之下,必有蹊跷。经过长时间的观察和研究,他们摸索出一些规律。对连续数天的重要监控数据进行分析后,Avizienis发现了一些规律:网络在短周期内更容易出现相同的活动水平,长周期则不然。此外,这种活动性在小区域内出现的频率比大区域更高。

Avizienis说:“这个发现太令人兴奋了,我们在第一时间就祭出了该网络的幂定律”。幂定律是描述一个变量随着另一个变量的变化呈现出巨大变化的数学关系。相比规模更大、时效更长的事件,该定律更多适用于规模较小的短时性随机系统。该定律由丹麦物理学家Per Bak首先提出,并被作为复杂动力学系统的标志。他解释说,幂定律表明任何一个复杂动力系统都是在有序和混度状态之间的动态“甜点”(sweet spot)上运行,该临界状态使得系统的所有部分都连接起来并相互影响,以实现系统运行效率的最大化。

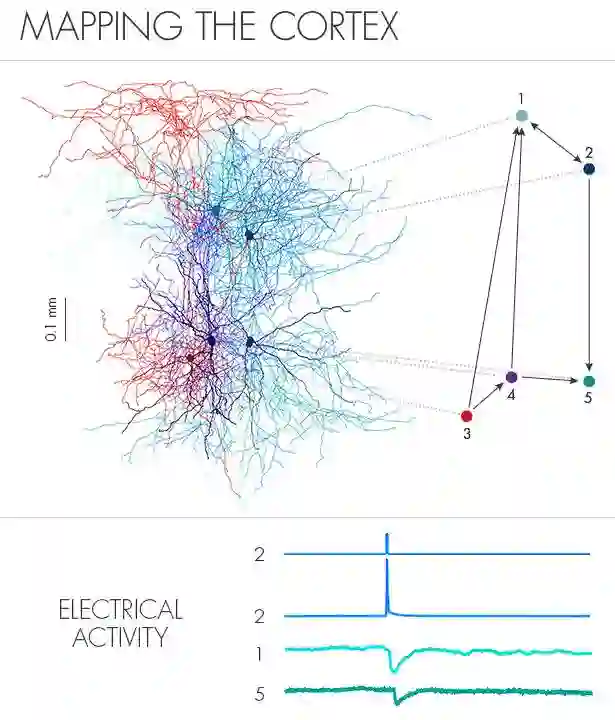

正如Per Bak所预言的,人脑中也已经观察到了某种幂定律行为:在2003年,NIH神经科学家Dietmar Plenz观察到,人脑神经细胞群可以激活其它神经细胞群,后者有可以激活其它的,这种方式传递下来最终往往会发生了一次全脑范围的激活级联。Plenz发现,这些级联的激活区域的大小是满足幂定律的,也就是说,人脑的神经活动确实时按最大化活动传播的方式在运行,且不会有失控的风险。

Plenz表示,上述UCLA实验设备所展显的幂定律行为意义重大,因为它意味着,跟大脑一样,系统各部分之间的相互激活和抑制存在一种微妙平衡。这种行为不会造成网络瘫痪,也不会自行消亡。

Gimzewski和Stieg后来还发现,银丝网络和大脑之间还有其他相似之处:正如睡眠中的人脑会比清醒时表现出更少的激活级联一样,在较低的能量输入下,银质网络的简暂短激活状态也会变得不那么常见。从某种程度上,减少系统的能量输入(电压),实验设备也能进入一种类似于人脑睡眠的状态。

介绍过银丝网络所具备的人脑特性,大家更关心的问题还是它能否真正用于实际的计算任务?初步的实验表明是可以的,尽管该实验设备大大不同于传统的电脑。

其中的一个因素是它不需要软件。相反,基于输出信号的测量位置,研究人员发现该网络可以以多种方式来扭曲输入的信号,这样的设备就可以用来清除输入信号中的噪音,这就意味着它可被用做语音或图像的识别。

这还意味着,该设备还可被用于储备池计算。因为在一个输入信号的基础上,原则上可以产生多达数百万种不同的输出信号。据此,用户可以选取或合并特定的输出信号,以得到他们所期望的输入信号的计算结果。举例来说,如果在同一时间去刺激该设备的两个不同位置,那么这几百万个输出中就有可能包含这两个输入信号的和。

这里的挑战是在于,如何从大量的输出信号里面找出正确的输出值并对其进行解码,以及如何找出编码信息的最佳方式使得该网络能够理解输入信号。解决问题的办法就是对设备进行训练:反复运行一项任务成百上千次,先用一种类型的输入训练,然后再换另一种输入,最后找出哪种输出最适合解决问题。

Gimzewski表示:“我们不必对设备进行编程,但我们要选择最好的方式来对信息编码,从而使该网络能够向正确的方向运行。”

在即将发布的论文中,研究人员训练了一个能够执行简单逻辑运算的银丝网络。而在尚未公开的实验中,他们训练该网络了执行一项类似于T迷宫记忆测试的任务。该测试是小白鼠们在实验室中经常被训练去做的,只要对迷宫的光线变化做出正确的反应,它们就能得到奖励。经过这项训练的银丝网络,其响应的准确率达到94%。

Nugent表示,到目前为止,这些结果仅仅是证明了神经元芯片原则上的可行性。一个能在迷宫中做出决定的小白鼠还是很初级的,跟人们在传统电脑上用机器学习所做的复杂决策没法比。Nugent比较怀疑该实验芯片能在短短几年内出现应用上的大飞跃。

但他强调,其中的潜力巨大。这是因为,像大脑这样的网络无需将记忆和处理分开执行,而传统电脑则需要不断处理这两大功能区域之间的信息交换。额外的通讯功能就需要额外的能量来为电路供电。Nugent表示,“如果在传统电脑上模拟人脑的全部功能,可能全法国的电能都不够你消耗,这里考虑的还只是中等分辨率的大脑模拟。”而如果银丝网络的效果能达到当前机器学习算法的程度,它的能耗可能仅需当前的十亿分之一。“只要能达到这样的计算效果,它们在能耗方面绝对完胜传统电脑。”

加州大学洛杉矶分校的研究结果同时也支持这样的观点:在正常的情况下,智能系统可以通过自组织的形式整合成一个完整的系统,而不需要任何模板或者事先的过程去设计。作为该项目的早期支持者,原DARPA项目主管Todd Hylton表示,银丝网络的成形完全是自发的:“在能量流经它的时候,很关键的一点是每次形成新的结构,能量都不会流失到其他地方。当前的计算机模型的神经网络需要设计很久才能存储某些临界状态,而银丝网络自己就能生长出相似的功能,完全不需要设计。”

Gimzewski坚信,如果用于复杂系统过程的预测,银丝网络的效果可能要比传统电脑好很多。传统计算机用方程对现实世界进行建模,只是相对而言更加接近,并不是完全准确。具有原子开关的神经元芯片利用自身的复杂性与其正在构建的模型相匹配。此外,他们的处理速度本身也相当快速,网络的状态可以以每秒几万次的波动改变。Gimzewski说:“我们在做的事就是创造一个真正的复杂系统,再用它观察复杂的现象”。

今年早些时候,在美国化学学会举办于旧金山的会议上,Gimzewski、Stieg及其同事介绍了该项目的一个实验结果。他们搜集了洛杉矶连续六年的车流量数据,并将前三年的每小时的车流量以脉冲的形式输入到神经元芯片中进行训练。经过数百次以后的训练,最终它很好地预测出后三年车流量的趋势,尽管它以前从未接触过这个问题和数据。

Gimzewski开玩笑说,“将来有一天,我也许该用这个网络来预测股市。”这就是为什么他拼命让学生来这个原子开关网络——万一某一天他真被华尔街挖走了,他的研究也有人接班。

作者 | Andreas von Bubnoff

原文地址:

https://www.quantamagazine.org/a-brain-built-from-atomic-switches-can-learn-20170920/

限时干货下载

Step 1:长按下方二维码,添加微信公众号“数据玩家「fbigdata」”

Step 2:回复【2】免费获取完整数据分析资料「包括SPSS\SAS\SQL\EXCEL\Project!」