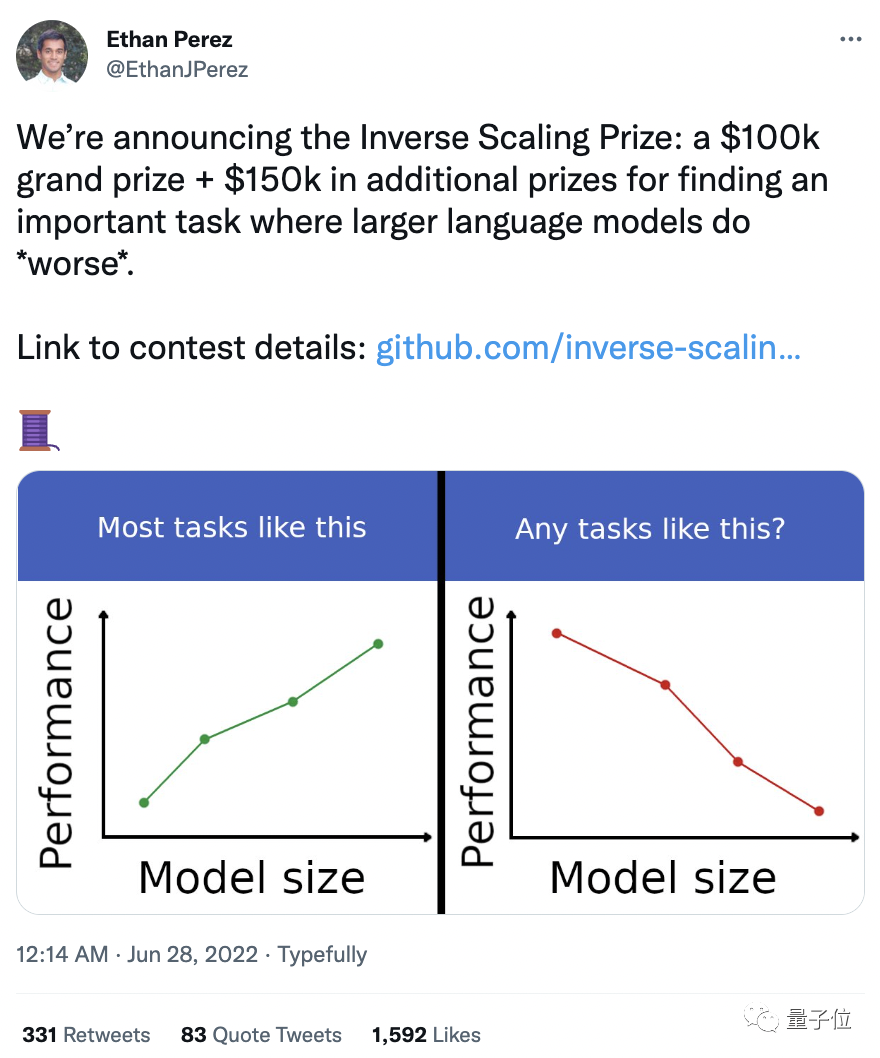

AI表现越差,获得奖金越高?纽约大学博士拿出百万重金,悬赏让大模型表现差劲的任务

羿阁 发自 凹非寺

量子位 | 公众号 QbitAI

模型越大、表现越差反而能获奖?

奖金总计25万美金(折合人民币167万)?

这样“离谱”的事情还真就发生了,一个名叫Inverse Scaling Prize(反规模效应奖)的比赛在推特上引发热议。

该比赛由纽约大学的7位研究人员共同举办。

发起人Ethan Perez表示,本次比赛的主要目的,是希望能找到哪些任务会让大模型表现出反规模效应,从而找出当下大模型预训练中存在的一些问题。

现在,该比赛正在接收投稿中,第一轮投稿将截止到2022年8月27日。

比赛动机

人们似乎默认,随着语言模型越来越大,运行效果也会越来越好。

然而,大型语言模型并非没有缺陷,例如种族、性别和宗教偏见问题,以及产生一些模糊的错误信息等。

规模效应表明,随着参数数量、使用的计算量和数据集大小的增加,语言模型会变得更好(就测试损失和下游性能而言)。

我们假设有些任务的趋势是相反的:随着语言模型的测试损失的提高,任务性能变得单调、效果变得糟糕,我们将这种现象称为反规模效应,与规模效应相反。

本次比赛旨在寻找更多的反规模效应任务,分析哪些类型的任务容易表现出反规模效应,尤其是那些对安全性要求高的任务。

同时,反规模效应任务还将有助于研究当前语言模型预训练和规模范式中潜在的问题。

随着语言模型越来越多地应用于现实世界的应用程序,这项研究的现实意义也在增强。

对反规模效应任务的收集,将有助于降低大型语言模型带来不良后果的风险,并预防伤害到现实用户。

网友争议

但针对这项比赛,有些网友提出了不同的看法:

我认为这是一种误导。因为它假设模型是静态的,并且在经过预训练后停止。

这更多的是一个在参数更多的标准语料库上进行预训练的问题,而不是模型大小的问题。

软件工程师James对该观点表示赞同:

是的,这整件事都是骗局。任何小型模型可以学习的东西,大型模型也可以。

小模型的偏差更大,因此“热狗不是热狗”在小模型中可能被识别为100%对的,而当大模型认识到可以将蛋糕制作成类似于热狗时,准确率会下降到 98%。

James甚至还进一步提出了“阴谋论”的看法:

也许这整件事就是一个骗局——让人们努力干活,并且展示遇到棘手任务时的训练数据,该经验会被大型模型所吸收,大型模型最终会更好。

因此他们不需要给奖金,还会得到一个更好的大型模型。

对此,发起人Ethan Perez在评论里这样写道:

澄清一下,该奖项的重点是寻找会导致反规模效应的语言模型预训练中,从未或很少见过的类别。

这只是使用大型模型的一种方法。还有许多其他能导致反规模效应的设置,没有涵盖在我们的奖项里。

比赛规则

根据参赛者提交的任务,赛方将会构建一个包含至少300个示例的数据集,并使用GPT-3/OPT进行测试。

该比赛的评选将由一个匿名评审小组来完成。

评审们将从反规模效应的强度、通用性、新颖性、再现性、涵盖范围以及任务的重要性6个方面考量,对提交作品进全方位的审核,最终评出一等奖、二等奖和三等奖。

奖金设置如下:

一等奖最多1位,10万美金;

二等奖最多5位,每人2万美金;

三等奖最多10位,每人5000美金。

比赛已于6月27日开始,8月27日将进行第一轮评估,10月27日开始进行第二轮评估。

发起人Ethan Perez

发起人Ethan Perez是一名科学研究人员,一直致力于大型语言模型的研究。

Perez在纽约大学获得自然语言处理专业博士学位,此前曾在 DeepMind、Facebook AI Research、Mila(蒙特利尔学习算法研究所)和谷歌工作过。

参考链接:

1、https://github.com/inverse-scaling/prize

2、https://twitter.com/EthanJPerez/status/1541454949397041154

3、https://alignmentfund.org/author/ethan-perez/

— 完 —

「量子位·视点」直播报名

什么是“智能决策”?智能决策的关键技术是什么?它又将如何打造引领企业二次增长的“智能抓手”?

7月7日周四,参与直播,为你解答~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~