EMNLP2020 tutorial | 高性能自然语言处理

今天分享的是华盛顿大学和谷歌研究院在 EMNLP 2020 上的tutorial,主题是关于高性能NLP的前沿进展。该tutorial长达274页ppt,广泛介绍了各种提高NLP效率的技术,包括知识蒸馏、量化、剪枝、更高效的架构,以及案例研究和实际实现中各种奇技淫巧。

简介

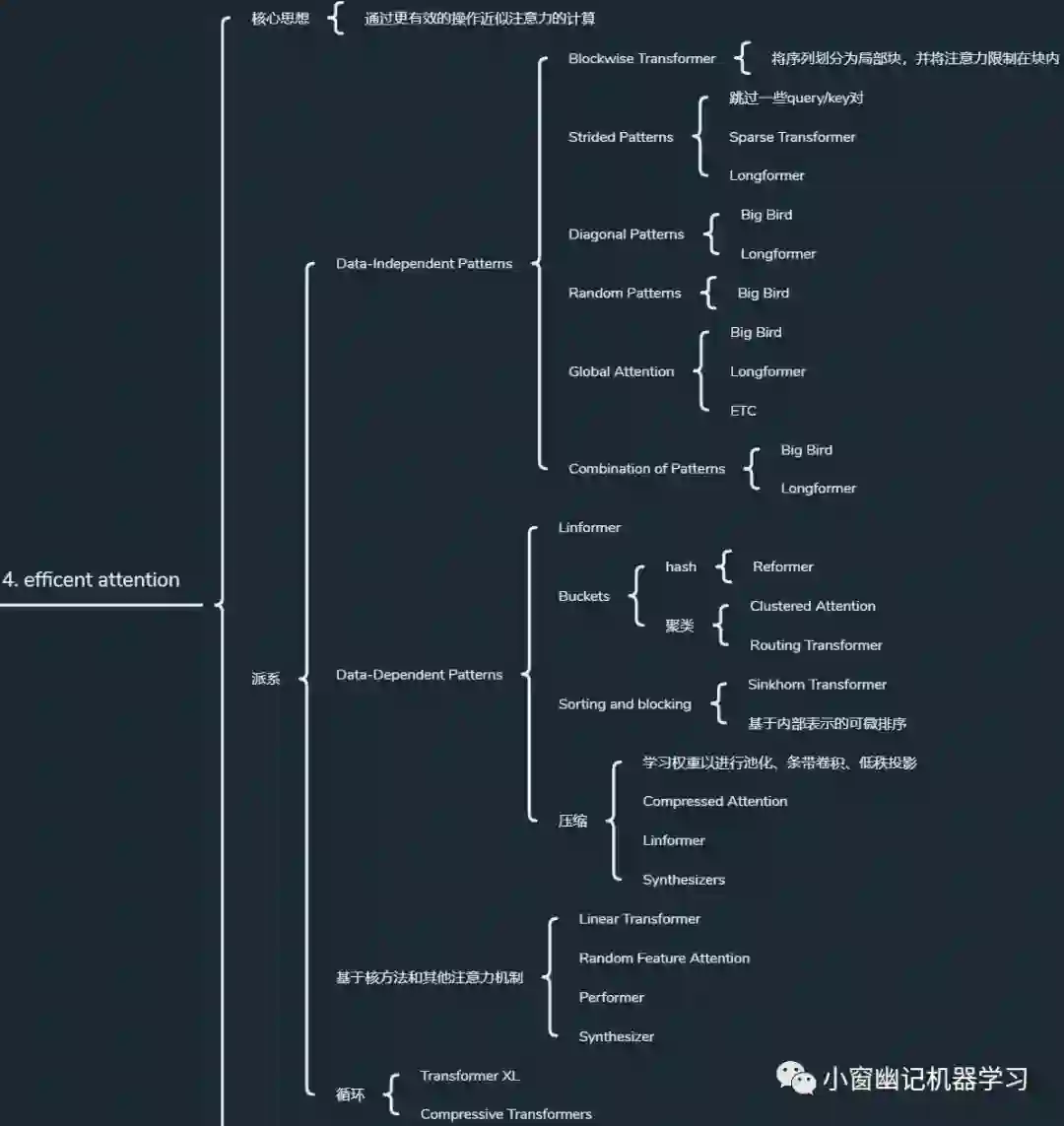

近年来,规模(Scale)这个词在自然语言处理的快速发展中起着关键作用。虽然各种基准测试(benchmarks)已经被越来越大的模型所主导,但如何高效利用有限的硬件资源对于这些大模型的广泛采用和在该领域的进一步发展至关重要。EMNLP 2020 的这个前沿tutorial中,演讲嘉宾先简要概括了自然语言处理中的最先进技术,并在建立这些基础之后,广泛介绍了各种提高效率的技术,包括知识蒸馏、量化、修剪、更高效的架构,以及案例研究和实际实现中各种奇技淫巧。

由于篇幅较大,这里以知识导图形式展现核心的几个方面,完整的274页ppt下载请关注小窗幽记机器学习公众号后台回复“高效” 就可以获取《EMNLP2020 tutorial | 高性能自然语言处理》

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏