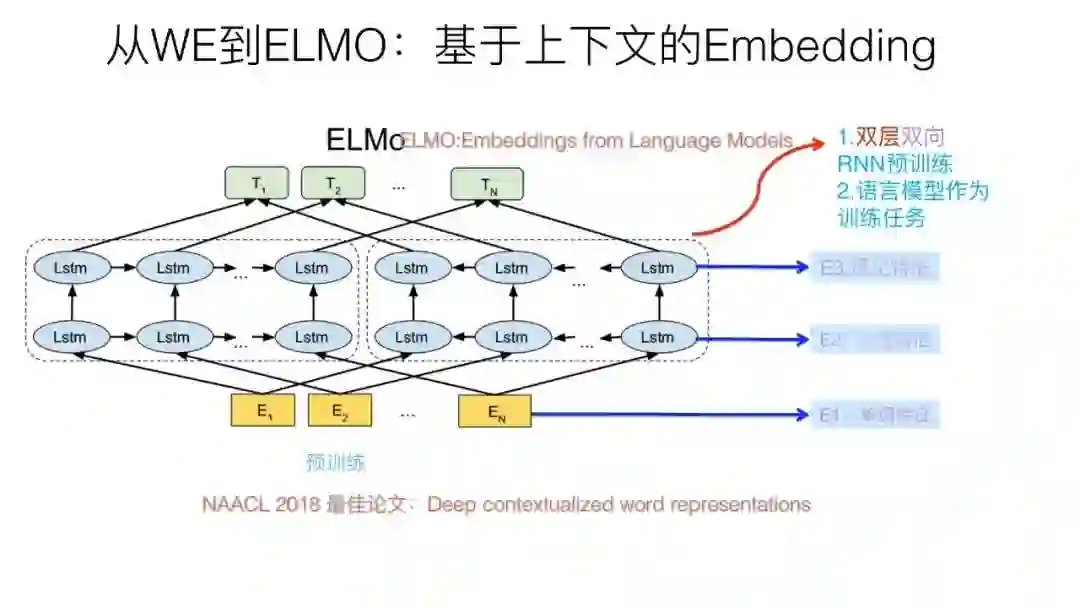

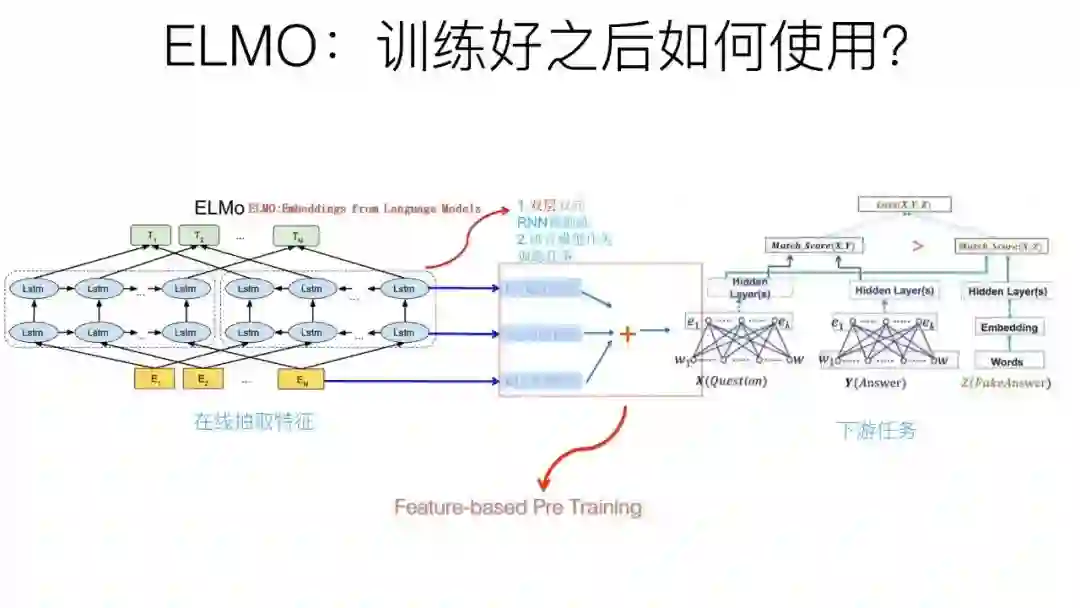

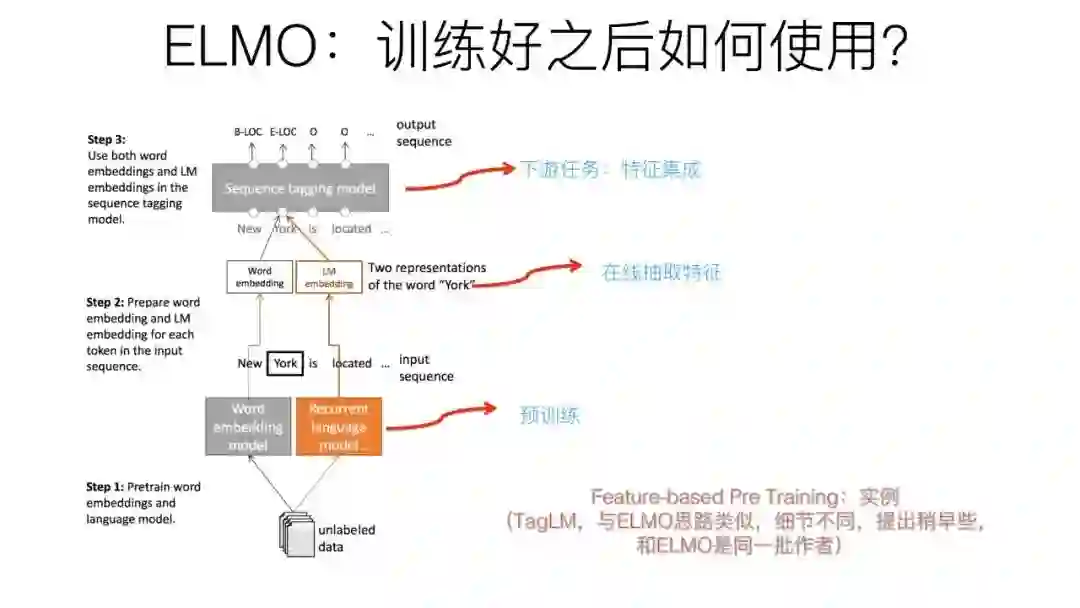

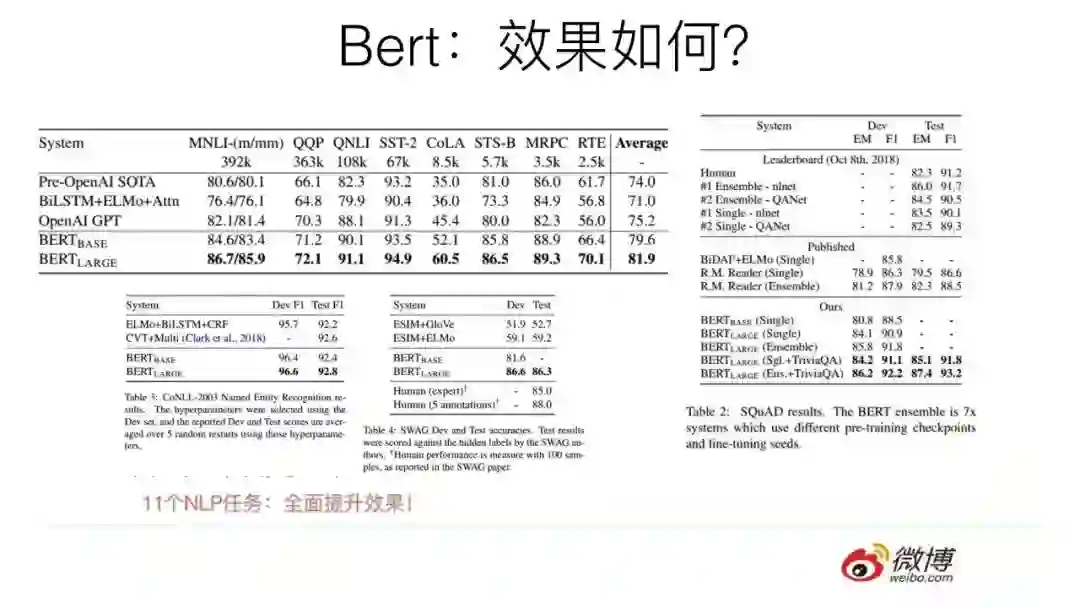

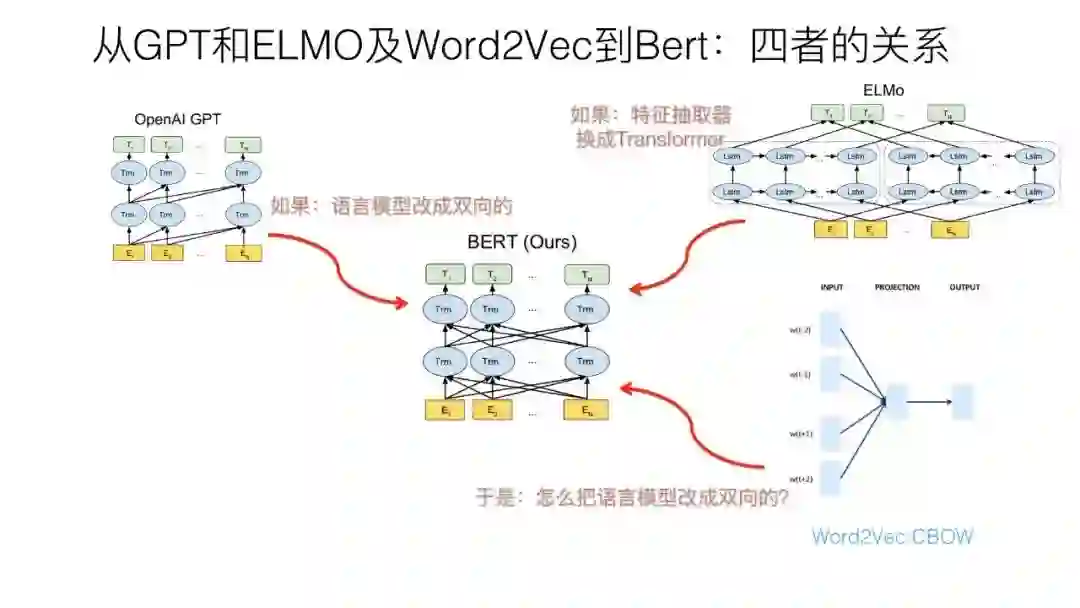

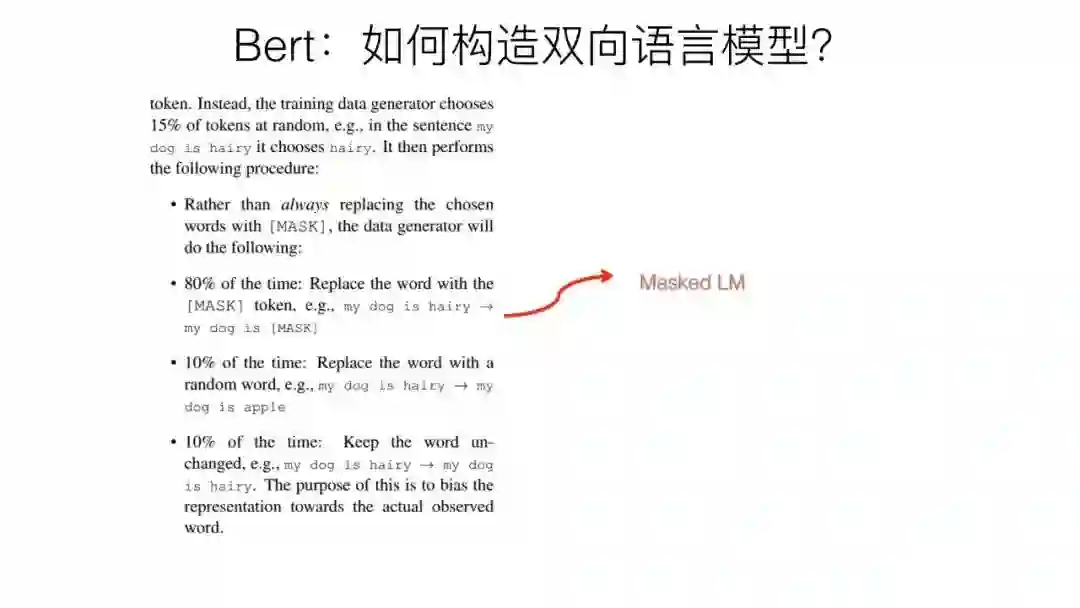

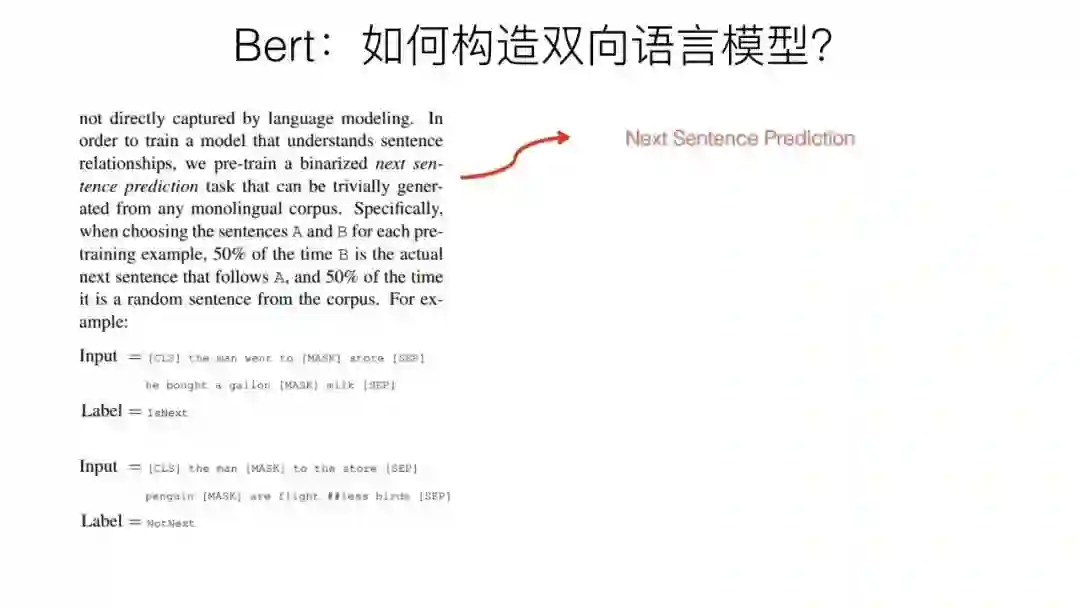

预训练在自然语言处理的发展: 从Word Embedding到BERT模型

以下是新浪微博机器学习部AI Lab的资深算法专家张俊林博士11月7日关于BERT的PPT分享,已取得授权转载到这里。节选微博上两段相关的信息:

@张俊林say: BERT这种具备NLP里程碑意义的模型你要是不搞明白就别说自己是搞自然语言处理的了

@微博机器学习

大家期待的PPT来啦![[中国赞]](https://cdn.zhuanzhi.ai/images/wx/0c038a475aa61471b848ba0ecc1d8310!/format/webp/quality/5)

整个PPT全是干货,感兴趣的同学点击链接即可下载。

百度网盘链接:https://pan.baidu.com/s/1o4SBdsx6dY4W4bnuBmU38Q 或 点击文末 “阅读原文”直达。

登录查看更多

相关内容

专知会员服务

54+阅读 · 2020年1月30日

专知会员服务

79+阅读 · 2019年12月29日

Arxiv

15+阅读 · 2018年10月11日