对话杨强:联邦学习的落地,沟通协调和模型训练一样重要

大数据文摘出品

编辑:曹培信

7月20日上午,上海市北·GMIS峰会迎来了第一位演讲嘉宾——微众银行首席人工智能官,国际人工智能学会理事长,香港科技大学教授杨强。杨强教授是国际人工智能界“迁移学习”技术的开创者”,同时提出“联邦学习”的研究新方向。

杨强教授演讲的主题是:“用户隐私、数据孤岛和联邦迁移学习”。

杨教授首先介绍了目前AI面临的两大挑战:数据孤岛和隐私保护。

目前在行业上看到的数据往往是小数据和细碎的数据,也就是没有联通起来的数据,又被称为数据孤岛,数据孤岛的存在严重制约了人工智能的发展。而用户的数据隐私对互联网企业则是一个更大的挑战,比如美国一些企业,就是因为数据泄露给公司带来了巨大的灾难。

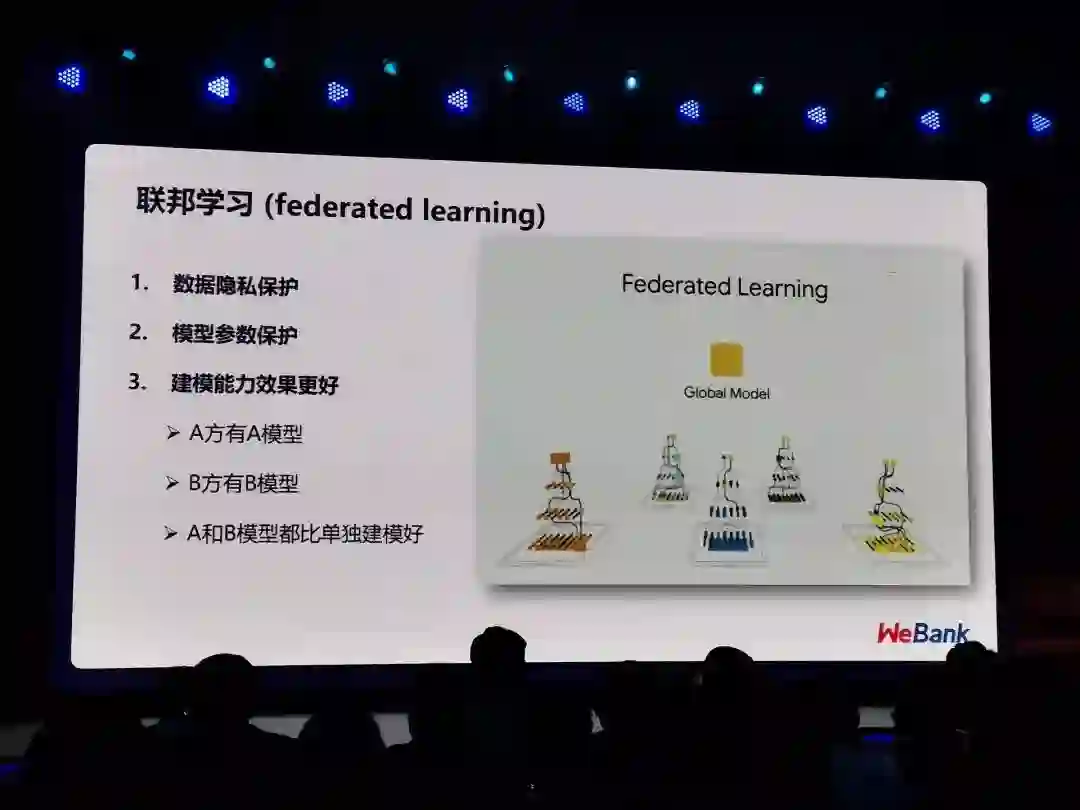

而在这样的背景下,杨强教授提出了联邦学习的概念,就是在数据不离开本地的情况下,让双方合作建立的全局模型模型在各个参与方之间移动,在安全加密的情况下,不断完善这个模型。

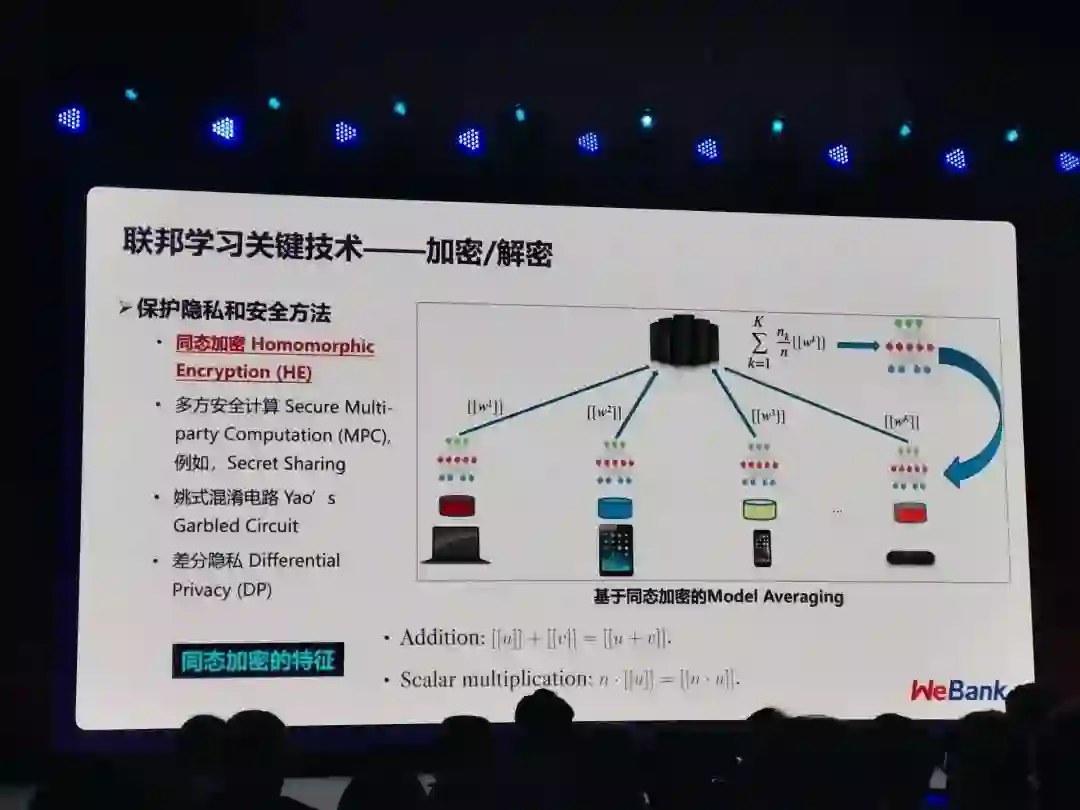

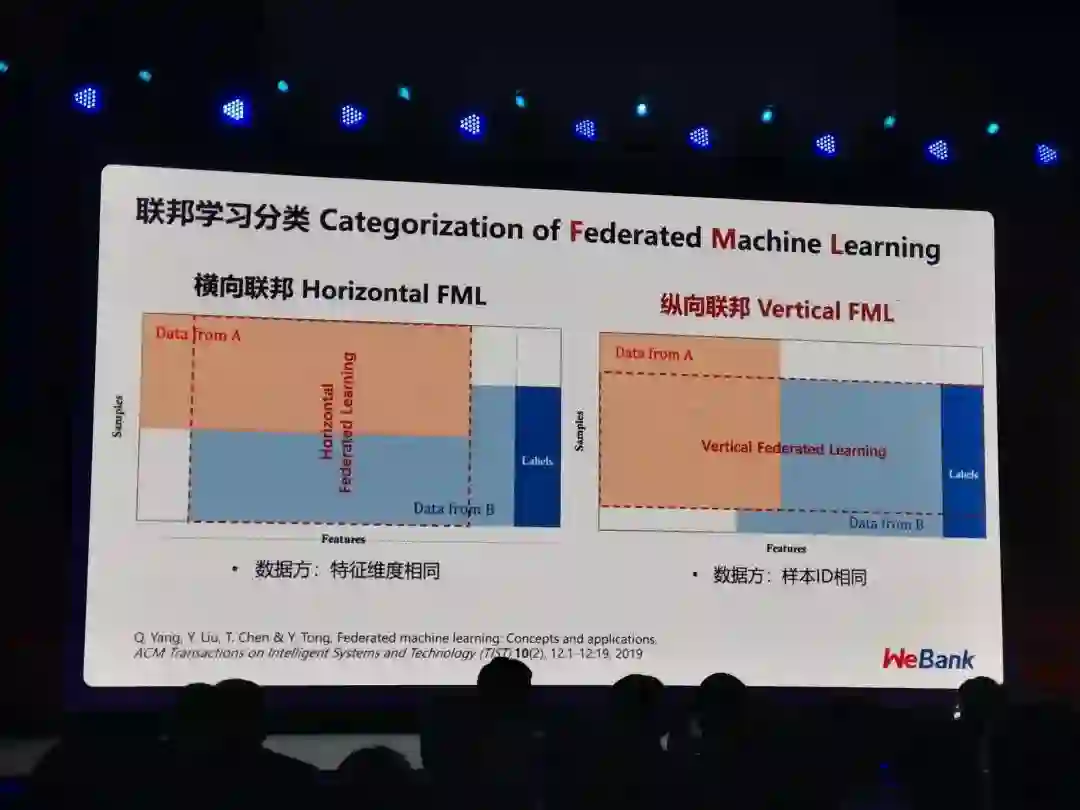

联邦学习主要采用了同态加密的技术来保护多方数据隐私,可以根据用户的特征维度和样本ID的重叠度分为横向联邦学习和纵向联邦学习,亦或在两者重叠度都很低的情况下采用联邦迁移学习。

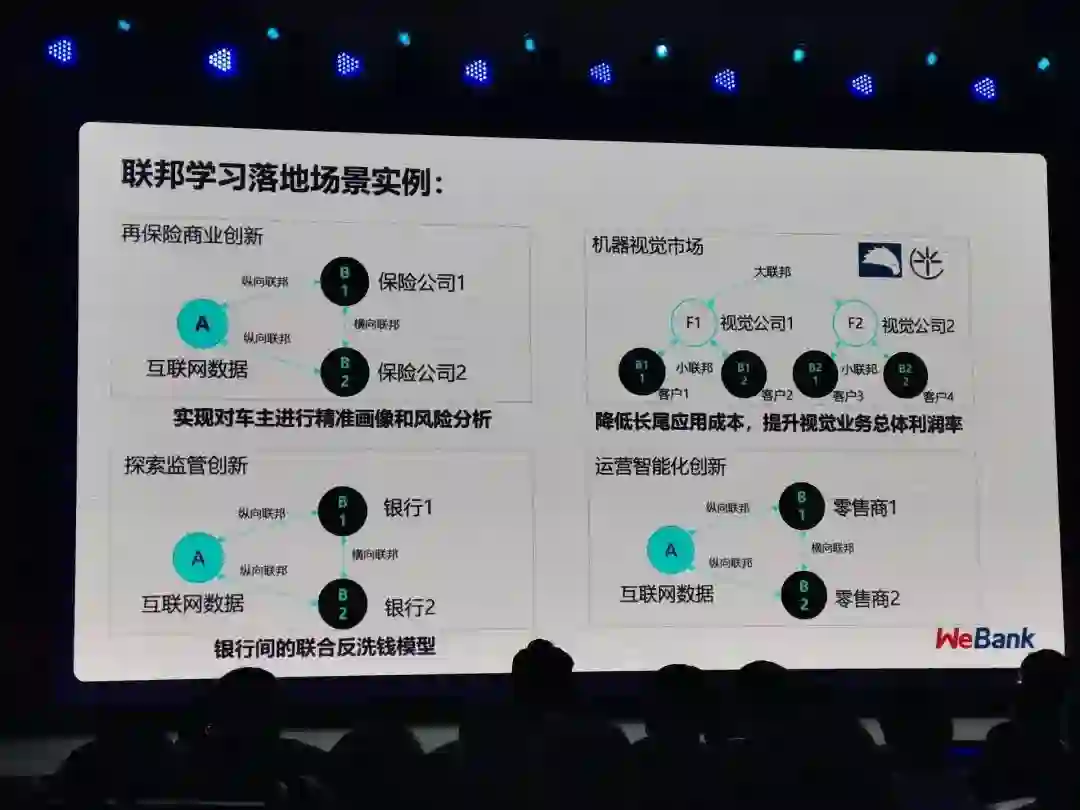

最后,杨强教授介绍了联邦学习在保险、银行等行业中的落地应用情况。

演讲结束后,大数据文摘也与杨强教授进行了交流,杨教授很细致地解答了我们关于联邦学习的一些疑问。

Q:联邦学习可以根据用户和属性的重叠度分为横向联邦学习和纵向联邦学习,那一般采取什么样的方式能在不泄露数据的情况下计算用户和属性的重叠度呢?

A:是这样的,我们可以进行多项式运算,做这些运算的时候,我们可以把这个加密乘到每一个单元里面去。那么这样的话,假设我们做一个集合的减法,我们就可以在加密的状态下做这个减法,最后就可以通过减法找到用户的交集,然后这个交集找到了以后我们再解密,就知道两个数据集里面哪些用户群是重叠的,但是整个过程并不知道彼此不重叠的用户。

例如有的企业在好多银行都借贷,银行要将这些用户找出来,但是又不能看彼此的数据。像这些就是我们要找出来的重叠用户,联邦学习就可以用这些重叠用户的数据来共同建模,一方先根据自己的数据和特征先建立一个模型,然后把这个模型的一些参数用同态加密办法传给另一方,另一方在这个模型的基础上建立一个更进一步的模型,然后再送回。所以这样的一个反复沟通的状态,双方只需要一些加密参数来壮大共同的模型,而这整个过程中双方都看不到彼此的数据。

Q:那在这个过程当中,第三方发挥了什么样的作用?

A:第三方起到一个加密解密和一个沟通的作用。如果假设我们两个人在共同建模,我们有一个一个可信赖的第三方的话,它可以使得我们的沟通次数减少,这样效率就可以提高,但是这样可能引入一个风险,就是假设第三方有数据泄露的话,就会出现问题,所以我们也可以不用第三方,就直接我们两个沟通,这样效率很显然会降低很多,但是可能更安全一些。

所以在联邦学习的时候,就面临一个选择,就是要不要第三方来做这个事,双方可以根据对效率和安全效果的要求来做这个选择。

Q:那这个过程中有没有模型受到暴露或者说受到攻击的情况?

A:中间的窃听是没有办法重构这个数据的,所以模型是没有暴露的风险的,但是有两个方面还是要注意:一个是单次传送的信息不能够用来重构我的数据;第二是进行的多次叠加也不能重构数据,所以这个是需要有一个数学证明叫Security Proof来证明的。

Q:如果不能保证对方的公司是完全诚实的,可能是半诚实的状态,要采取什么样的手段呢?

A:那这个过程就要修改两方建模的这个过程,需要多加一些噪音进去,就是加入差分隐私,差分隐私的效果就会使得窃听或者是反向工程变得更难。但是它的一个不好的地方就是会使得模型的效果和准确度降低。

Q:目前联邦学习的成本是不是还比较高呢?在落地应用方面会不会受到成本的影响?

Q:成本主要是两个方面,一是训练模型的计算成本,但是计算成本到现在为止还不是大问题。原因是我们发现当我们和另外一个互联网公司或者是是保险公司合作的时候,两方贡献的数据并没有那么大,而且训练的过程其实不是很复杂,但是更难的是说服对方来合作,因为对于这个联邦学习到底会不会泄露隐私是存在疑问的,这种顾虑使得大家不愿意合作。所以第二个就是这个中间协调的成本反而相对更大,占了主要方面。

Q:联邦学习的发展过程当中有什么比较大的挑战?

A:一个挑战就是两方的计算能力不一样,比方说谷歌的那个例子,它需要更新每个手机上的预测模型,比方输入法模型,那么就要求每个手机都得有一个建模能力,再把手机上模型压缩上传到云端。那这个流程里面是对这个手机的计算要求是非常高的,现在大多数的安卓手机没有这个能力。所以这种横向联邦的扩展性是和硬件的能力分不开的。

第二个挑战是参与方如果多了,那么我们对参与方的了解和控制就就降低了,那这样的话有些参与方就可能是恶意的,也许会进行偷听,但是现在我们大部分的落地应用情况,都是双方本着诚实的态度进行的,所以我们也没有进行特别多的探测和监控,这个也是一个挑战,需要我们进一步加强数据的保护。

Q:对于联邦学习这种新技术的出现,我国在法律上是否承认这种技术是保证了数据的安全的?还是说并没有明确?

A:还没有明确,所以我们也在也在呼吁说,监管立法要和技术方要密切沟通。比如欧洲GDPR的建立很显然并没有没有技术方参与,完全是一些人权律师写的条款,所以这种立法有可能严厉到足以扼杀整个AI行业的进步。

但其实是可以既保护隐私,又能保证技术进步的,比如像联邦学习这样的一种开源的技术就可以做到。那么如果有监管部门和立法部门明确了,联邦学习在技术上可以做到完全满足监管的要求,就像iso标准一样,那么就可以认证这是可信的应用,而要满足监管的要求,就必须使用类似这种保护数据的应用,这样就能形成一个闭环,才能够保证行业的发展。

实习/全职编辑记者招聘ing

加入我们,亲身体验一家专业科技媒体采写的每个细节,在最有前景的行业,和一群遍布全球最优秀的人一起成长。坐标北京·清华东门,在大数据文摘主页对话页回复“招聘”了解详情。简历请直接发送至zz@bigdatadigest.cn