提供大规模、全面的药物 AI 泛化数据集,覆盖 AI 药物辅助设计任务中发生分布偏移的各类场景。

近日,腾讯 AI Lab「云深」平台发布业内首个药物 AI 大型分布外研究框架 DrugOOD,包括数据集整理器(curator)和基准测试(benchmark),以推动药化场景中的分布偏移(distribution shift) 问题研究,助力药物研发行业发展。

![]()

论文地址:https://arxiv.org/pdf/2201.09637.pdf

项目主页:https://drug.ai.tencent.com/drugood

开源 github 地址:https://github.com/tencent-ailab/DrugOOD

传统机器学习算法通常假设训练样本和测试样本来自同一概率分布(Independent and Identically Distributed,IID), 然而实际场景中,训练样本与测试样本往往有着不一样的分布(Out-of-Distribution,OOD),导致基于训练样本优化得到的模型在实际测试样本上性能急剧下降,降低了模型在实际应用中的稳定性及可靠性。

OOD 问题同时是 AI 辅助药物发现领域的一大挑战,从训练数据推广到实际数据,模型的泛化能力面临考验。例如在基于分子和靶点结构的虚拟筛选中,预测模型通常在已知的靶蛋白上训练。但是,未来极有可能遇到新的病毒靶点, 导致测试分布明显不同于训练分布, 此时模型性能就会急剧下降。

DrugOOD 针对药物 AI 研究中最重要的活性预测问题,提供大规模, 全面的药物 AI 泛化数据集,覆盖 AI 药物辅助设计任务中发生分布偏移的各类场景,可帮助药物 AI 社区更便捷地开展 OOD 问题研究,未来更有望扩展到属性预测、分子对接等问题。同时 DrugOOD 还为各类研究方法的泛化性能提供基准测试,进一步促进技术进步。

AI 制药领域长期存在缺少可靠数据的挑战。过往药物 AI 领域的公开数据往往整理自药化领域的一些大型数据库存网站,比如库存网站 ChEMBL(https://www.ebi.ac.uk/chembl/)持续从公开文献中收集整理大量的药物活性数据。过往少数固定的公开数据集往往不可重现,主要原因在于:1)库存网站上的药化数据格式脏乱且持续更新,数据集无法反映最新的数据情况;2)这些数据集没有公开具体的数据处理流程,比如如何处理不同形式的噪声,如何处理多测量值等;3)药化领域缺乏一些共识,比如关于如何选取活性的阈值不同专家针对不同检验(Assay)有不同观点。因此,在药物 AI 领域急需一个可定制的自动化数据整理器,以生成可重现的数据集。

针对上述问题,「云深」平台的 DrugOOD 提供了方便用户定制的数据整理流程,用户只需修改配置(config)文件中的相关参数,即可重新生成新的数据集。这些数据集可充分利用库存网站 ChEMBL 上多样且持续更新的海量数据。

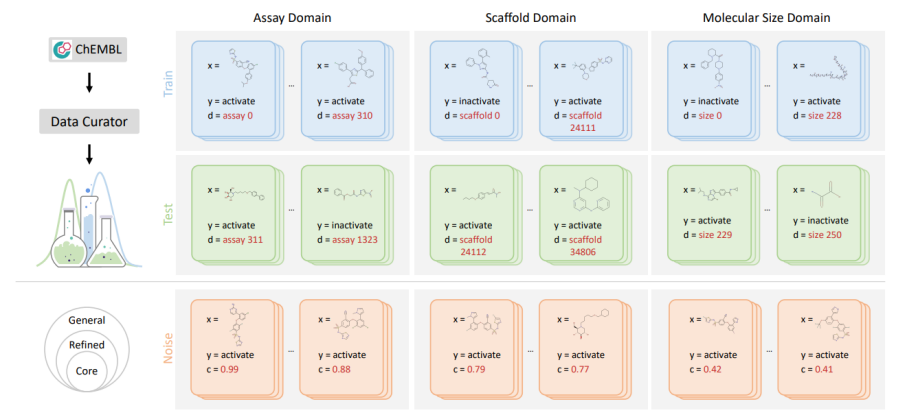

针对有噪声的分布外学习场景(OOD Learning with Noise),

DrugOOD 集成了 5 种域标定方法和 3 种噪声标定水平

。5 种域标定方法(scaffold、assay、molecule size、protein、protein family)能够反映药物 AI 中真实的分布偏移场景;3 种噪声标定水平(core、refined、general)根据测量置信度,度量标准,截断噪声等来制定,能够锚定数据中不同的噪声水平。

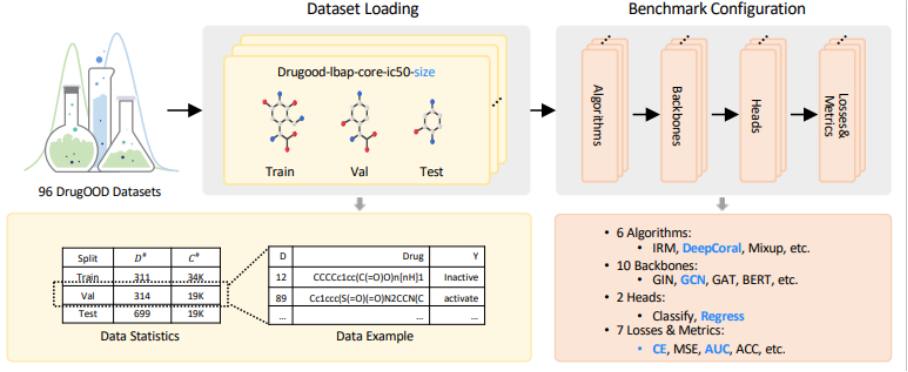

根据上述自动化数据整理器,该研究生成了总计 96 个样例数据集,构建了包括 Ligand Based Affinity Prediction、Structure Based Affinity Prediction 等在不同设置(偏移因素,预测目标,噪声水平)下的评测任务,用于测试不同方法的鲁棒性能。通过基准测试发现,在 DrugOOD 上现存多种 OOD 算法的分部内 - 分布外(ID-OOD)分类性能(AUC score)差异达到了 20% 以上,验证了此数据集中域标定和噪声标定方法的真实性和挑战性。

![]()

为解决 OOD 问题,此前行业已提出一些药物 AI 泛化研究方法,包括元学习、鲁棒优化、迁移学习等。但由于缺乏合适的 OOD 基准及标准化任务,这些方法的泛化性能难以得到系统性的评测,不利于技术社区形成统一认知,导致技术发展受阻。

基于 DrugOOD 数据集,

腾讯 AI Lab「云深」平台同时发布了全面的评测标准

(Benchmark),比较当前各类 OOD 问题研究方法的性能,这些研究包括不同的泛化方法(ERM,IRM,DeepCoral 等),以及不同网络架构(GIN,GCN,BERT 等)。该算法开发与测试平台已经开源:https://github.com/tencent-ailab/DrugOOD

![]()

![]()

近年来,AI 辅助药物设计技术已在多个药物发现任务中取得令人瞩目的成效,证明了人工智能技术助力药物研发的巨大潜力。

腾讯 AI Lab 于 2020 年发布了首个 AI 驱动的药物发现平台「云深」(https://drug.ai.tencent.com),整合了腾讯 AI Lab 在前沿算法、优化数据库的深厚积累,以及腾讯云计算资源上的优势,提供覆盖临床前新药发现流程的五大模块,包括蛋白质结构预测、虚拟筛选、分子设计 / 优化、ADMET 属性预测及合成路线规划。

DrugOOD 数据集是「云深」平台虚拟筛选模块基础能力的一大补充。

未来,「云深」平台将继续推动人工智能、大数据等技术与药物研发需求的深度结合,以先进的技术能力赋能药物研发行业,提高新药发现效率。

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com