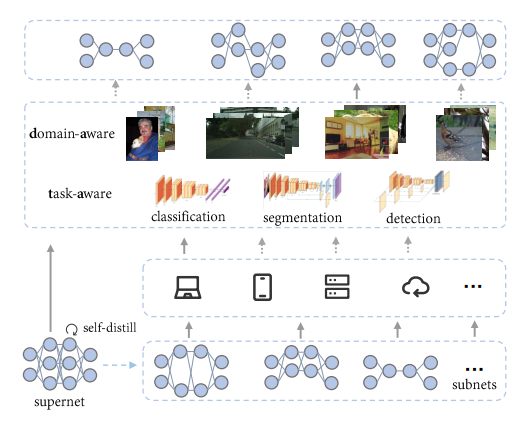

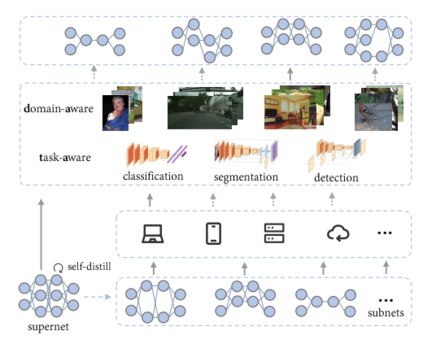

DATA: Domain-Aware and Task-Aware Pre-training

Qing Chang, Junran Peng, Jiajun Sun, Lingxi Xie, Haoran Yin, Qi Tian, Zhaoxiang Zhang

通过自监督学习 (SSL) 和对许多下游任务进行微调来在无标签的海量数据上训练模型的范式最近已成为一种趋势。然而,由于训练成本高和下游使用的无意识,大多数自监督学习方法缺乏对应下游场景多样性的能力,因为存在各种数据域、延迟约束等。神经架构搜索 (NAS) 是一种公认的克服上述问题的方式,但在 SSL 上应用 NAS 似乎是不可能的,因为没有提供用于判断模型选择的标签或指标。在本文中,我们介绍了 DATA,这是一种简单而有效的 NAS 方法,专门用于 SSL,提供数据域相关和任务相关的预训练模型。具体来说,我们 (i) 首先训练了一个超网,它可以被视为一组数百万个网络,涵盖了广泛的模型规模,没有任何标签,(ii) 其次提出了一种与 SSL 兼容的灵活搜索机制,可以针对没有提供明确指标的各种下游视觉任务和数据域,找到不同计算成本的网络。使用 MoCov2 实例化,我们的方法在下游任务的广泛计算成本上取得了可喜的结果,包括图像分类、目标检测和语义分割。DATA 与大多数现有 SSL 方法正交,并赋予它们根据下游需求进行定制的能力。大量的实验验证了所提出的方法在其他 SSL 方法(包括 BYOL、ReSSL 和 DenseCL)上的普适性。代码已开源在:

https://github.com/GAIA-vision/GAIA-ssl

DATA结构设计

成为VIP会员查看完整内容

相关内容

专知会员服务

14+阅读 · 2022年3月12日

Arxiv

0+阅读 · 2022年4月15日