AAAI 2022 | SASA: 重新思考三维物体检测中的点云采样问题

自动驾驶技术近年来迅速发展,其中无人车对周围环境的感知是最为重要的一个环节。为了保障行车安全,场景感知模块需要在三维环境中精确定位其他交通参与者,如车辆、行人、障碍物等。构建高精确度的场景感知模型对自动驾驶系统稳定安全地操纵车辆运行具有重要意义,因此3D物体检测(3D object detection)这一任务受到大量研究者关注。

目前,基于点云的3D物体检测模型主要分为划分体素进行特征提取的voxel-based方法和对点云直接进行特征提取的point-based方法。其中,在主流point-based方法中对点云进行下采样时容易丢弃很多前景点造成信息丢失,进而影响定位性能。

京东探索研究院联合悉尼大学提供了一种新的点云特征提取思路来帮助3D检测模型更多地关注前景物体,从而提高检测的精确度。该工作目前已被AAAI2022接收。

01

研究背景

3D检测任务中,点云(point cloud)图像是一种非常常见的视觉输入形式。相比于RGB图像,点云可以更好地提供深度信息从而帮助3D检测模型更好地定位物体的三维空间坐标。然而,由于点云是由非常多的离散点组成,其形式上与RGB图像有很大的差别,常见的特征提取网络(如卷积神经网络)无法直接在点云上使用。目前的3D检测器主要可以分为voxel-based方法和point-based方法,voxel-based方法将点云所处的3D空间划分成均匀的体素(voxel),再利用卷积神经网络在体素上进行特征提取;point-based方法通过特定网络PointNet直接对离散点进行特征提取。相比于voxel-based方法,point-based方法避免了体素化(voxelization)过程中的信息损失而被认为有更高的精度[2][3]。然而,我们发现在PointNet网络在对点云进行下采样过程中常用的采样策略容易丢弃大部分前景点,导致3D物体的空间信息没有被神经网络充分提取,进而影响了检测精度。

02

方法原理

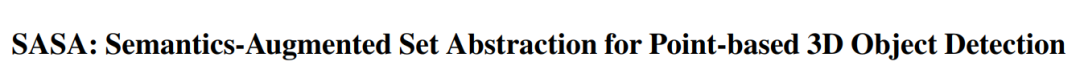

图1 SASA整体框架

为了使PoineNet能够在特征提取过程中主动地关注前景区域以提供更多与待检测物体有关的特征信息,我们选择直接使用输入点的语义信息作为启发式信息来引导采样算法选择更多的前景点。所以,我们在原生PointNet的下采样层 SA Layer上进行了以下两点改进:

(1) Point Segmentation Module

为了得到输入点集合的前景-背景分布,我们在SA Layer 中引入了一个轻量级的分割模块。它是一个两层的MLP网络,并从输入点的特征中判断该点是否属于前景点,并输出一个0到1之间的分数。

分割模块可以直接由一个交叉熵损失进行端到端优化,每个点的分割标签可以由ground-truth 3D框直接得到,在框内部的所有点被视为前景点,外部的则视为背景点。

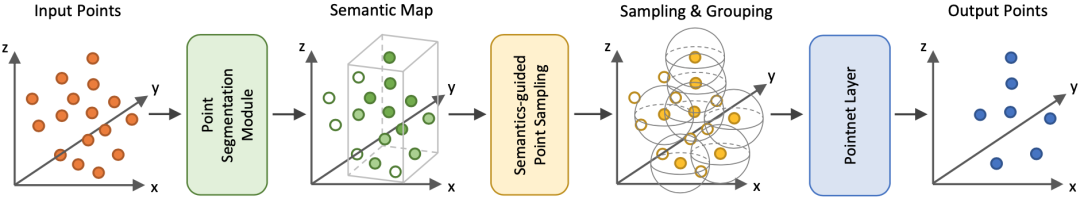

(2) Semantics-guided Point Sampling

我们已经得到了输入点的前景-背景分布,接下来我们对下采样算法Farthest Point Sampling (FPS) 进行改进,使其能够利用分割模块计算出的分数去选择更多的前景点。我们将它称为Semantics-guided Farthest Point Sampling (S-FPS),S-FPS算法具体流程如下:

相比于FPS算法,我们进行了以下修改:

1、将原始的选择策略由欧几里得距离

2、为了保证在不同的输入点排列下采样算法可以产生一致的结果 (permutation-irrelevant) [4],我们在第一轮的选择中直接选择分数最高的点,这样一来所有后续的选择都是唯一的。

03

实验结果

我们在两个典型的point-based方法中实现了SASA并测试它们的性能,一个是单阶段检测器3DSSD[3],一个是双阶段检测器PointRCNN[5]。

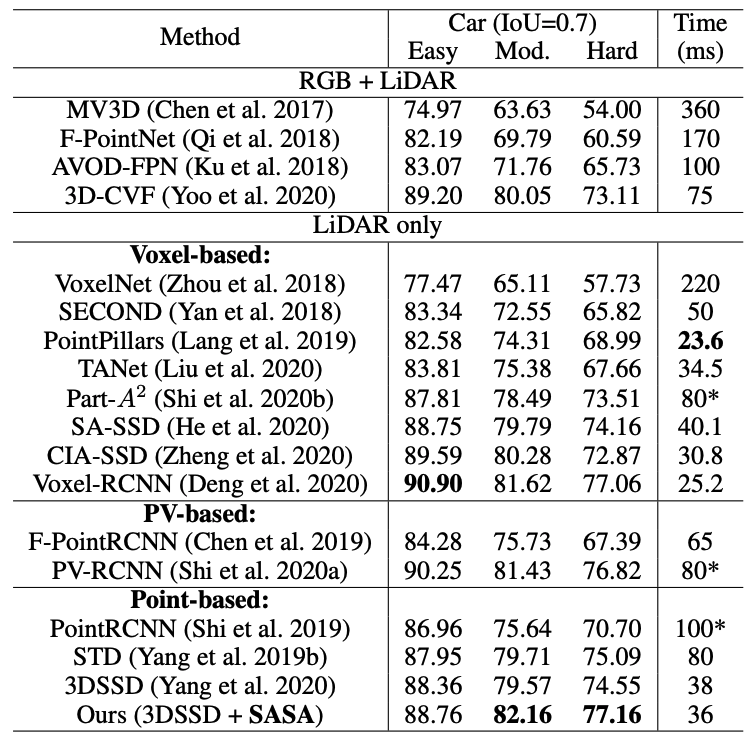

表1 不同方法在KITTI 3D detection benchmark上的检测结果

在KITTI test set中,SASA成功帮助3DSSD 取得了非常明显的精度提升,尤其是在Moderate和Hard难度上分别取得了2.59%, 2.61%的提升,并达到了SOTA水平。

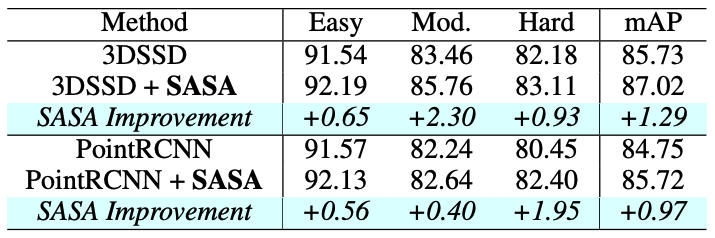

表2 SASA对3DSSD和PointRCNN在KITTI validation set上的效果

在KITTI validation set中,SASA对两个point-based方法在三个难度上均有提升,其中在Hard难度上对PointRCNN有大幅度的提升。

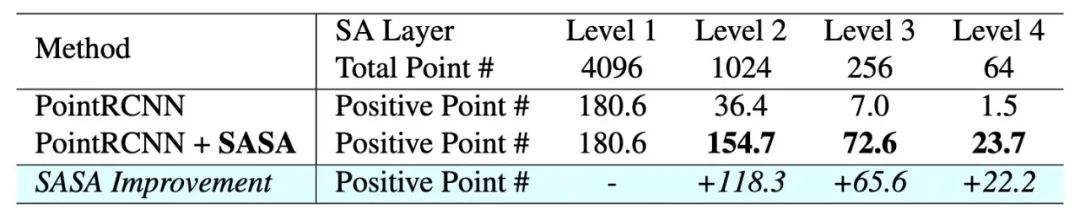

表3 PointRCNN中SASA对前景点采样的影响

我们逐层统计并对比了PointRCNN上每一层SA Layer中所保留的前景点的数量,由表格可以明显看出,引入SASA模块后,SA Layer所采样的前景点数量成倍增加。

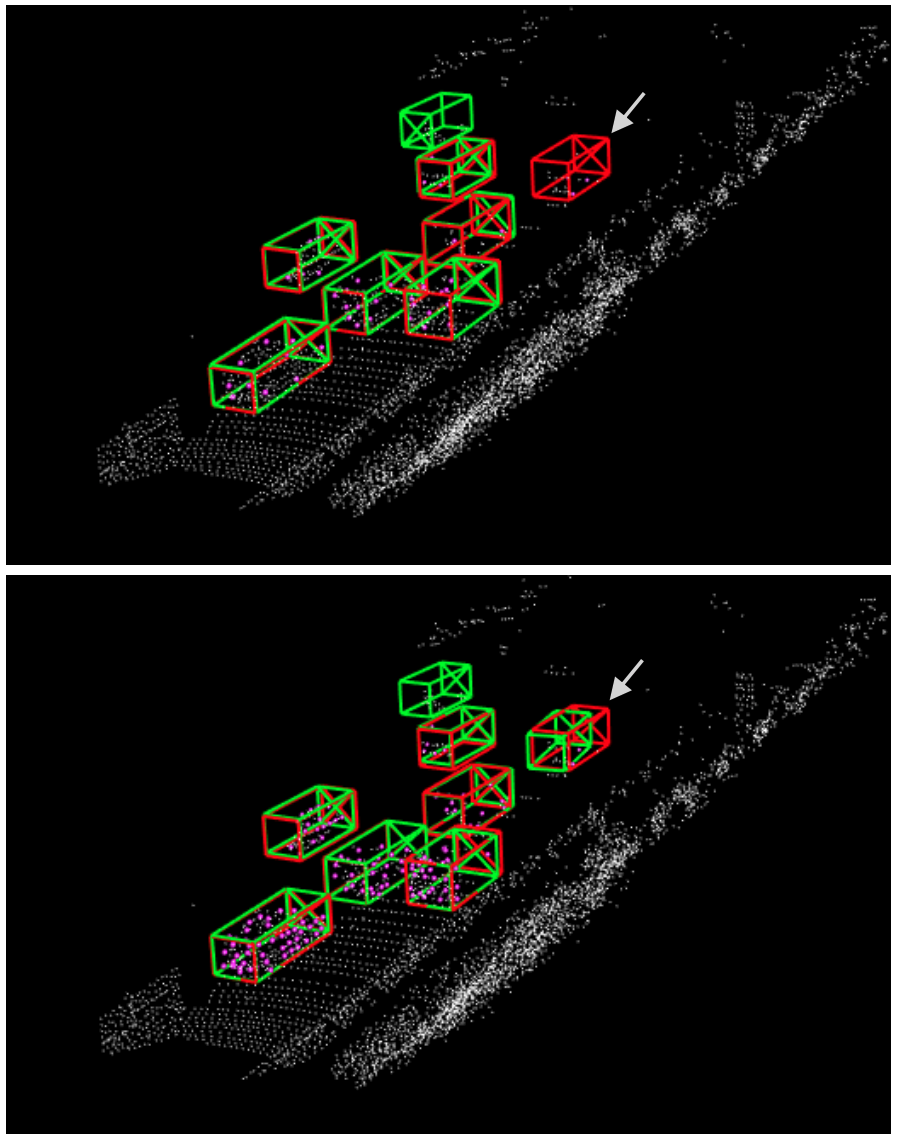

图2 3DSSD上的可视化结果

我们对检测结果和PointNet SA Layer采样点进行了可视化。如图所示,上图为3DSSD baseline的可视化结果,下图为引入SASA后的可视化结果。红色框和绿色框分别表示ground-truth标签和3DSSD的预测结果,粉色点表示3DSSD backbone的最后一层SA Layer所采样的前景点。可以看出,SASA保留的前景点更加密集,因此较远的物体和被遮挡的物体等难样本能更容易地被检测网络恢复出来。

04

总结与展望

本文提出了一种与语义结合的SASA模块来帮助3D检测模型更好地关注前景区域以提升检测精度,SASA可以很容易地移植到多种point-based检测器上并发挥作用。

我们希望SASA可以帮助point-based检测器解决采样问题以达到SOTA水平;将来,我们希望尝试将SASA的思想推广到其他任务中(如点云的语义分割、实例分割等)来帮助point-based方法取得进一步突破。

文章链接:https://www.zhuanzhi.ai/paper/832df527198f69e2217088093c560af0

项目链接:https://github.com/blakechen97/SASA

参考文献

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“SASA” 就可以获取《AAAI 2022 | SASA: 重新思考三维物体检测中的点云采样问题》专知下载链接