学界 | 不会写作文?试试这个文本模板生成系统呗

选自arXiv

作者:Sam Wiseman、Stuart M.Shieber、Alexander M.Rush

机器之心编译

参与:高璇、王淑婷

虽然神经编码器-解码器模型在文本生成方面取得了很大的成功,但这种生成方式仍存在一些尚未解决的问题。而本文提出了一种使用隐藏的半马尔可夫模型(HSMM)解码器的神经生成系统,可以学习潜在的离散模板并生成。

随着编码器-解码器模型在机器翻译及其相关任务中不断取得成功,人们对用该模型构建数据驱动的通用自然语言生成(NLG)系统 (Mei et al., 2016; Dusek and Jurcıcek ˇ , 2016; Lebret et al., 2016; Chisholm et al., 2017; Wiseman et al., 2017) 的兴趣大增。这些编码器-解码器模型 (Sutskever et al., 2014; Cho et al., 2014; Bahdanau et al., 2015) 使用神经编码器模型来表示源知识库,并以源编码为条件,用解码器模型逐字进行文本描述。这种生成方式与 NLG 中更为传统的分工方式形成了鲜明对比,NLG 着重强调分别解决「说什么」和「如何说」这两个问题,又因此形成了具有明确内容选择、宏观和微观计划、表面实现组件的系统。

编码器-解码器生成系统可以提高 NLG 输出的流畅性,同时减少所需的手动操作。然而,由于通用编码器-解码器模型的黑箱特性,这些系统在很大程度上牺牲了两个在更传统系统中常见的重要需求,即(a)在形式和内容上易于控制的(b)可解释输出。

本研究考虑构建可解释和可控的神经生成系统,并提出了具体的第一步:建立一种数据驱动的新生成模型,以学习条件文本生成的离散、模版式结构。核心系统使用一种新颖的神经隐藏半马尔可夫模型(HSMM)解码器,它为模板式文本生成提供了一种原则性方法。研究人员进一步描述了通过反向传播推导以完全数据驱动的方式训练该模型的有效方法。由神经 HSMM 引起的模版式结构生成明确表示了「系统打算说什么」(以学习到的模板形式)以及「它想如何说」(以实例化模板的形式)。

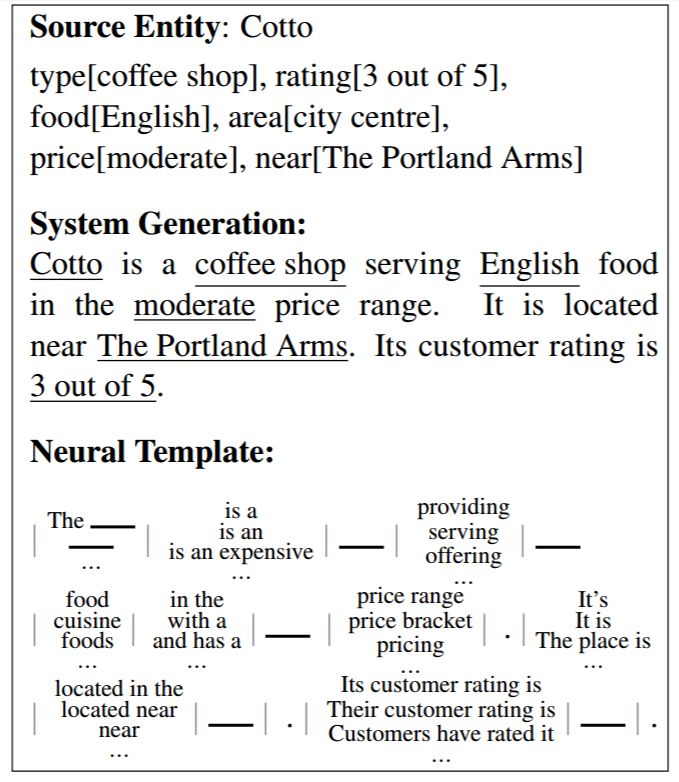

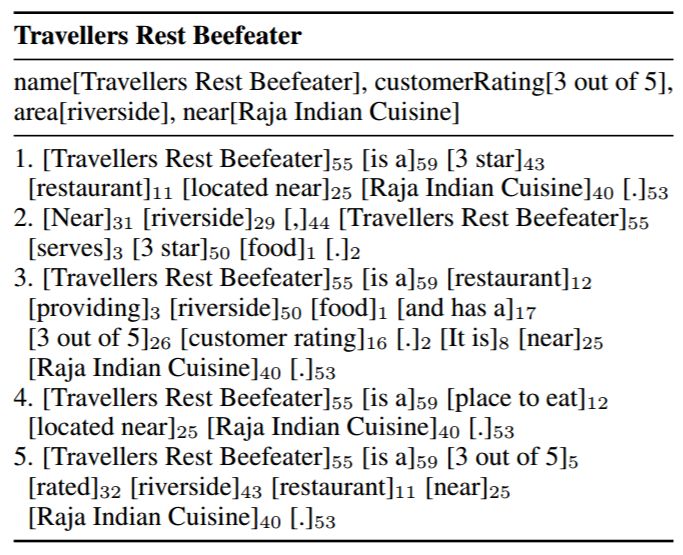

研究人员可以实现与其它神经 NLG 方法媲美的性能,同时满足上述两个需求。实验表明,可以在产生显式模板(如图 1 所示)的同时获得有竞争力的自动分数,并且可以通过操纵这些模板来控制和解释生成。最后,虽然实验侧重于从数据到文本的形式,但该方法代表了一种学习条件文本的离散、潜变量表示的方法。

图 1:E2E 生成数据集 (Novikova et al., 2017) 中的模版式生成示例。知识库 x(上)包含 6 条记录,yˆ(中)是系统生成; 记录显示为 [value] 类型。系统会学习生成的神经模板(下)并将其用于生成 yˆ。每个单元格代表学习段中的一个片段,「空白」表示在生成期间通过复制产生的填空位置。

论文:Learning Neural Templates for Text Generation

论文链接:https://arxiv.org/pdf/1808.10122v1.pdf

摘要:虽然神经编码器-解码器模型在文本生成方面取得了很大的成功,但这种生成方式仍存在一些尚未解决的问题。编码器-解码器模型在很大程度上无法解释文本,并且难以控制其措辞或内容。本文提出了一种使用隐藏的半马尔可夫模型(HSMM)解码器的神经生成系统,它学习潜在的、离散的模板并生成。我们展示了该模型学习有用模板的能力,并且这些模板让生成变得更具解释性和可控性。

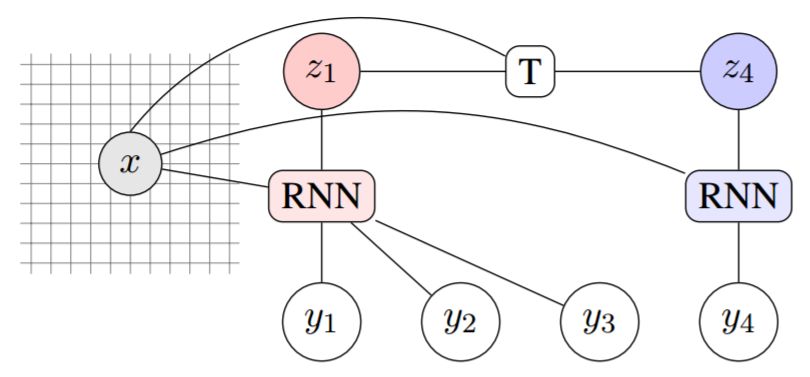

图 3:通过 HSMM 因子图(在已知的分段下)来说明参数。这里我们假设 z1 处于「红色」状态(K 个可能性中的一种),并且在发出三个单词后变为「蓝色」状态。如 T 所示的转换模型是两个状态和神经编码源 x 的函数。发射模型是「红色」RNN 模型(注意力超过 x)的函数,产生单词 1、2 和 3。转换后,下一个单词 y4 由「蓝色」RNN 生成,且独立于之前的词。

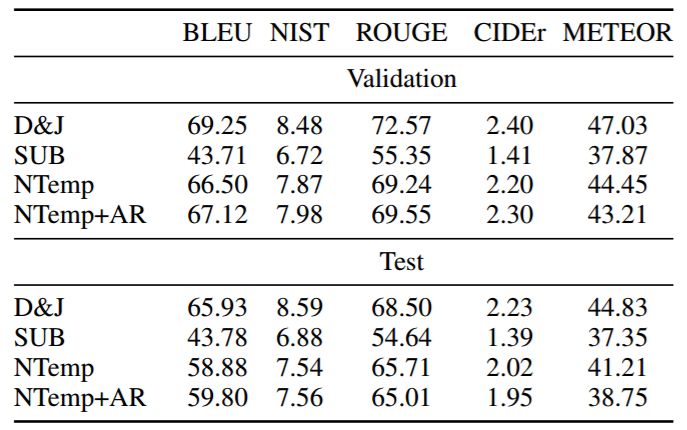

表 1:Dusek 和 Jurcıcek ˇ(2016)系统对比,后者构成了 E2E challenge 基线、基于替代的非参数基线(见文本),以及我们在 E2E 数据集上用于验证和测试的 HSMM 模型(非自回归和自回归版本分别表示为「NTemp」和「NTemp + AR」)。「ROUGE」是 ROUGE-L。模型通过官方 E2E NLG Challenge 评分脚本来评估。

表 3:改变模板 z(i)对 E2E 验证数据中单个 x 的影响;使用所选 z(i)的分段来注释生成。使用表 1 中的 NTemp + AR 模型获得结果。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com