只有条件GAN才能稳定训练?对抗+自监督的无监督方法了解一下

选自 arXiv

作者:Ting Chen、Ting Chen、Marvin Ritter、Mario Lucic、Neil Houlsby

机器之心编译

参与:刘晓坤、王淑婷

针对 GAN 在线对抗训练时出现的不稳定性问题,来自 UCLA 与谷歌大脑的研究者提出了对抗训练+自监督训练的新训练方法。该方法是无监督的,不需要标记数据,但可以达到和条件 GAN 相当的训练稳定性,同时 ImageNet 生成质量可以达到 FID33(这是在 ImageNet 上无条件训练获得的最佳结果。)。该研究入选了 NeurIPS 2018 Workshop。

生成对抗网络(GAN)是一类无监督的生成模型 [1]。GAN 涉及对抗地训练生成器和鉴别器模型,使得生成器可以从期望的数据分布中生成样本。训练 GAN 具有挑战性,因为它涉及在高维参数空间中搜索非凸博弈的纳什均衡。在实践中,GAN 通常使用交替的随机梯度下降进行训练,这通常是不稳定的并且缺乏理论保证 [2]。因此,训练可能表现出不稳定性、发散、循环行为或模式崩溃 [3]。为此,人们提出了许多稳定 GAN 训练的技术 [4,5,6,7,8,9,10]。导致训练不稳定的主要原因是生成器和鉴别器在非静态环境中学习。因为鉴别器是一种分类器,其中一类(假样本)的分布随着生成器在训练期间改变而改变。

在非稳态在线环境中,神经网络忘记了以前的任务 [11,12,13]。如果鉴别器忘记了先前的分类边界,则训练可能变得不稳定或循环。这个问题通常通过重复使用旧样本或应用连续学习技术来解决 [14,15,16,17,18,19]。在复杂数据集下,这些问题变得更加突出。其中的关键技术是条件化 [9,20,21,22],由此生成器和鉴别器都可以访问标记数据。可以说,用监督信息增强鉴别器可以鼓励它学习更稳定的表征,防止灾难性的遗忘。此外,学习每个类的条件模型比学习联合分布更容易。此设置的主要缺点是标记数据的必要性。即使标记数据可用,它通常也是稀疏的,仅涵盖数量有限的高级抽象概念。

受上述挑战的驱使,来自 UCLA 与谷歌大脑的研究者的目标是表明人们可以在不需要标记数据的情况下实现条件化的好处。为了确保鉴别器学习的表征更稳定和有用,研究者为鉴别器添加辅助的自监督损失。这实现了更稳定的训练,因为鉴别器表征对生成器输出质量的依赖性降低。研究者引入了一种新的模型:自监督的 GAN(self-supervised GAN,SS-GAN),其中生成器和鉴别器在表征学习的任务上合作,并在生成任务上进行竞争。

本研究的贡献:研究者提出了一种无监督的生成模型,它将对抗训练与自监督学习相结合。该模型实现了条件 GAN 的优势,但不需要标记数据。特别是,在相同的训练条件下,自监督的 GAN 弥补了无条件和条件模型之间的自然图像合成的差距。在此设置中,鉴别器表征的质量大大提高,这在迁移学习中可能会有潜在的应用价值。该模型实现了大规模无条件 ImageNet 图像生成。研究者认为,这项工作是朝着高质量、完全无监督、自然图像合成方向迈出的重要一步。

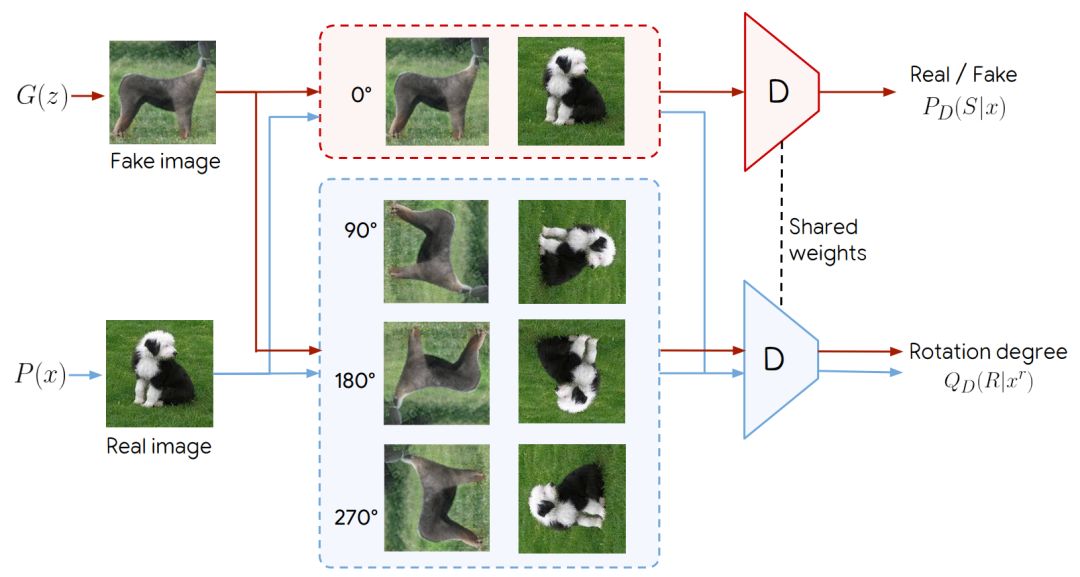

图 1:具有基于旋转的自监督的鉴别器。鉴别器 D 执行两项任务:真 VS 假的二值分类,以及旋转角度分类。真图像和假图像都分别旋转了 0°、90°、180°和 270°。彩色箭头表示只有直立的图像被用于真假分类损失任务中。至于旋转损失,所有的图像都需要让鉴别器根据其旋转程度进行分类。

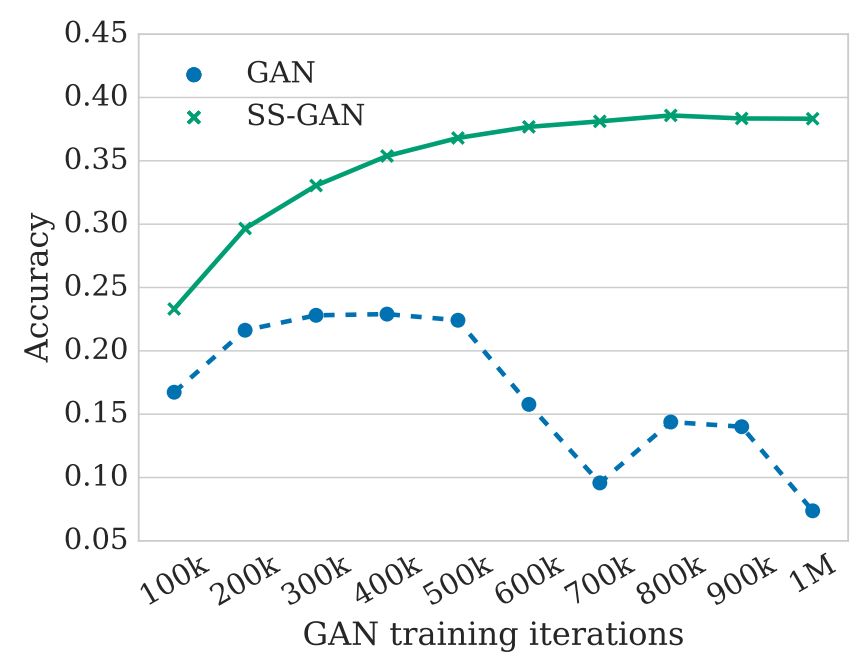

图 2:线性分类模型性能,该模型利用鉴别器的最后一层提取的表征在 ImageNet 上训练。Uncond-GAN 表示无条件 GAN。SS-GAN 表示添加自监督时的相同模型。对于 Uncond-GAN,该表征收集关于图像类别的信息并提高了准确率。然而,在 50 万次迭代后,表征损失了类别信息,同时性能开始下降。SS-GAN 缓解了这个问题。

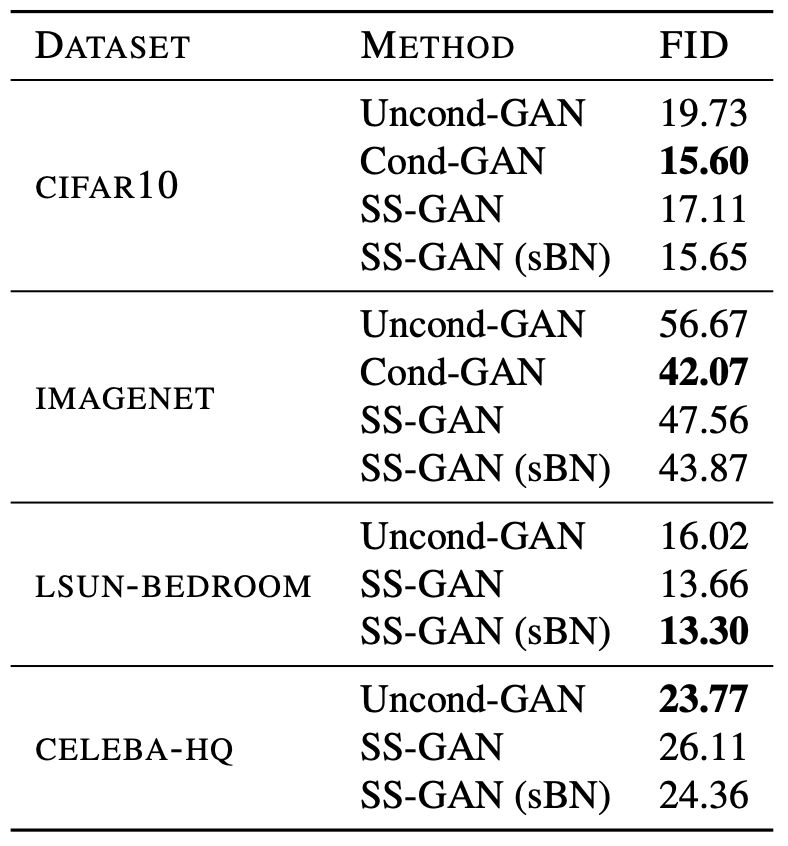

表 1:通过三个随机种子获得最佳 FID。在这种情况下,本文提出的方法实现了条件化的大部分好处。

研究者扩大了 SS-GAN 的训练,以获得无条件生成 ImageNet 的最佳 FID。研究者在 Google TPU v3 Pod 的 128 个核心上,使用了 1024 的批量,以 350,000 步训练所提出的模型,并获得了 33.5 的 FID 分数。附录中提供了架构的详细信息。

图 5 显示了模型生成的图像的随机样本。在 ImageNet 上无条件训练比有条件训练要难得多,因此,现有的相关技术并不多。使用自回归模型的无条件 ImageNet 生成结果已经出现,但并没有报道 FID 分数 [34]。通过使用很多附加的技巧和技术,一个基于条件生成的最新方法通过大规模训练已经获得了 9.6 的 FID 分数。虽然本文的无条件模型仍然远远落后于此,但在第 4.2 节的结果表明,在相同条件下,SS-GAN 和条件 GAN 的性能相当。这一方法有望在将来获得与无条件模型相当的分数。这是在 ImageNet 上无条件训练获得的最佳结果。

图 5:自监督模型无条件生成图像的随机样本(非随机样本)。虽然本文的无条件模型可以明显改进,但 4.2 节中的结果表明,在相同条件下,本文提出的方法可以与条件模型对应的方法性能相当。这是在 ImageNet 上无条件训练获得的最佳结果。

论文:Self-Supervised Generative Adversarial Networks

论文地址:https://arxiv.org/abs/1811.11212

摘要:条件 GAN 正处于自然图像合成的最前沿。这种模型的主要缺点是标记数据的必要性。在这本文中,我们利用两种流行的无监督学习技术:对抗训练和自监督,来缩小条件和无条件 GAN 之间的差距。特别是,我们允许网络在表征学习任务上进行协作,同时利用经典的 GAN 机制进行对抗训练。自监督的作用是鼓励鉴别器学习有意义的特征表征,这些表征在训练期间不会被遗忘。我们通过实验测试了学习到的图像表征的质量和合成图像的质量。在相同条件下,自监督的 GAN 获得了与最先进的条件 GAN 相似的性能。这种完全无监督学习的方法扩展到无条件 ImageNet 生成时可以达到 33 的 FID 分数。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者 / 实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告 & 商务合作:bd@jiqizhixin.com