【ICCV 目标跟踪性能最优】首个应用残差学习的深度目标跟踪算法

1新智元报道

编辑:闻菲

【新智元导读】不同于在目标检测和识别等领域取得的丰硕成果,深度学习在目标跟踪领域进展相对缓慢,很大原因是缺乏数据——目标跟踪只有第一帧的标定框作为训练数据,在这种情况下训练一个深度模型十分困难。现有的基于深度学习的方法从几个不同的角度解决这个问题,但在跟踪速度和精度方面仍有很大的提升空间。

在目标追踪界泰斗、UC Merced 杨明玄教授的指导下,香港城市大学、阿德莱德大学、SenseNet的研究人员从深度学习的角度出发,提出了一种端到端的跟踪模型,将特征提取和响应生成融合在深度学习框架中,只采用单层卷积的端到端结构,就达到了利用深度特征的传统协同滤波器的效果。

在此基础上,研究人员还引入残差学习来有效维持模型在目标运动中的预测性能,这也是残差学习的概念首次被用于目标跟踪领域。实验表明,新方法在标准的数据库中取得了state-of-the-art的精度效果。该工作将于10月末在意大利威尼斯举办的计算机视觉顶会ICCV 2017中面向全球学者进行呈现。新智元独家抢先对其内容进行详细报道。

目标跟踪(Object Tracking)一直是计算机视觉中应用广泛而且富有挑战性的问题。简单说,目标跟踪就是在一段视频中,给定第一帧目标物体的位置和大小信息(标定框)后,让跟踪算法在后续的每一帧中对目标物体的位置和大小进行预测。

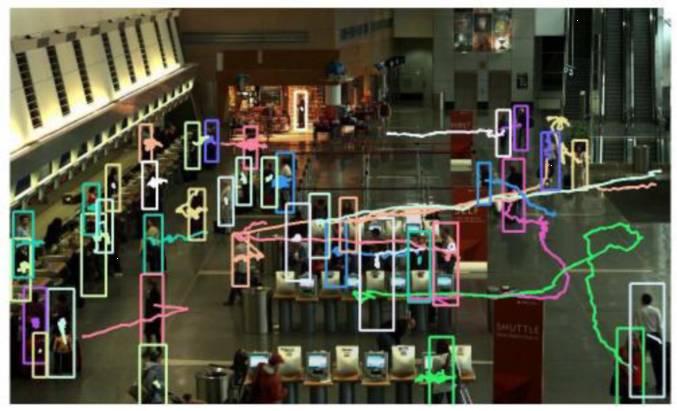

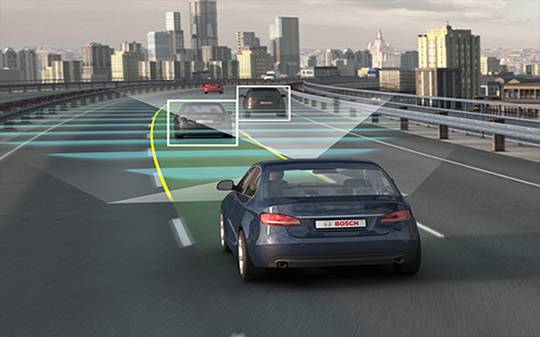

跟踪算法实时确定目标物体状态,为进一步智能分析提供了先决条件。目标跟踪技术在安防、人机交互和无人驾驶等一系列领域中都有应用。

安防监控场景中行人跟踪和轨迹预测

人机交互中对人手势的跟踪和识别

无人驾驶中临近车辆的跟踪和跟随行驶

在实际应用中,目标跟踪算法的效果受很多因素的制约,本质是由于物体在视频中出现的各种无法预测的变化。典型的制约因素包括:

☟ 物体在视频中从初始帧到当前帧,光照情况发生了剧烈的变化

☟ 物体在视频中运动姿态发生了很大的变化

☟ 物体在视频中出现了局部遮挡或全局遮挡的情况

☟ 物体在视频中与相似背景的混杂(目标汽车的尾灯和迎面而来汽车的头灯)

☟ 物体在视频中的大小发生了显著的变化

现实中制约目标跟踪的因素还有很多。为了克服这些因素带来的不良影响,目前主流的跟踪算法多采用深度卷积特征和传统的协同滤波相结合的方式。虽然在性能上得到了提升,但是深度学习的架构优势并未得到充分的利用(比如HCFT[1],DeepSRDCF[2],C-COT[3])。

另一方面,有一些深度学习模型将跟踪问题转化为了处理物体检测(MDNet[4])和校验(SINT[5])的思路。但是,这种方法在不利用额外的跟踪视频做训练的前提下,其精度无法匹及协同滤波。

下面要介绍的这项工作,从深度学习的角度出发,提出了一种端到端的跟踪模型,并用残差式学习来有效维持模型在目标运动中的预测性能,在标准的数据库中取得了state-of-the-art的精度效果。有鉴于其性能优异,方法创新——首次将残差学习应用于目标追踪,该工作已被ICCV 2017接收。

“CREST”(Convolutional RESidual learning for visual Tracking),也有勇攀高峰之意

充分挖掘深度学习在追踪算法研究中的优势,构建端到端的深度模型做预测

虽然深度学习方法在物体检测和识别方面已经取得了优异的效果,但是在物体跟踪的算法研究中,主流方向依然集中在协同滤波器的各种拓展。纵然使用深度学习,也只是将深度卷积特征作为传统特征的替代,提升跟踪的精度。

协同滤波的优势在于其在频率域的快速运算和对物体位置的密集估计特性,这一优点一直吸引研究人员在此框架内不断做新的探索。但是,协同滤波方法并非没有局限。首先,协同滤波跟输入特征没有关联,这样一个结构并没有对跟踪这个问题有专门的改进。其次,协同滤波器的在线更新方法是人先验设定的,并没有随着物体的在线变化过程而做自适应的调整。

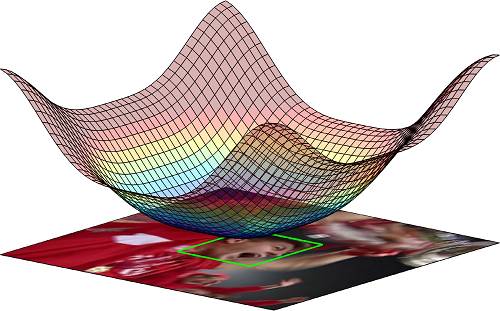

那么,有没有方法改进上述问题呢?从本质上说,协同滤波器是一个与物体特征做卷积从而生成二维高斯响应的过程。训练协同滤波器的系数,即为衡量卷积后的响应与真实高斯响应偏差多少的操作。

协同滤波将物体回归为二维高斯核,其峰值即为物体中心位置。

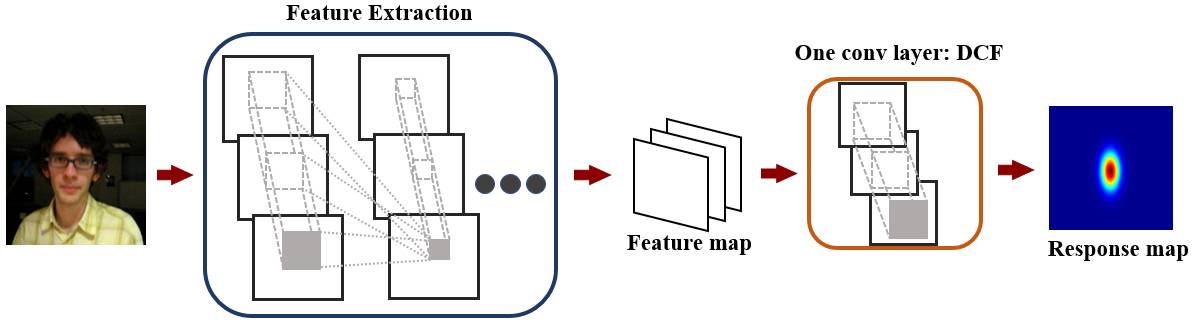

研究人员发现,这样一种训练方式,可以用L2损失函数训练单层卷积层来等价替换。采用单层卷积替代协同滤波的好处是,特征提取和高斯响应的生成可以紧密地结合在一起,为端到端的训练和预测提供了基础。此外,由于训练卷积层可以采用梯度下降的优化方法,就能够对整个框架为了实现跟踪任务进行一体的优化。另外,在线模型更新的过程也是网络根据物体的变化情况做自适应的调整。相比于传统协同滤波计算封闭解的方法和固定更新方法的人为先验设置,深度学习的优化框架无疑是更优越的。

端到端的预测和优化

同时,用单层卷积层代替协同滤波器,对特征的卷积操作也从频域转换到了时域,从而有效的克服了傅里叶变换带来的边界影响问题。

首次将残差学习用于目标追踪,提升网络预测质量

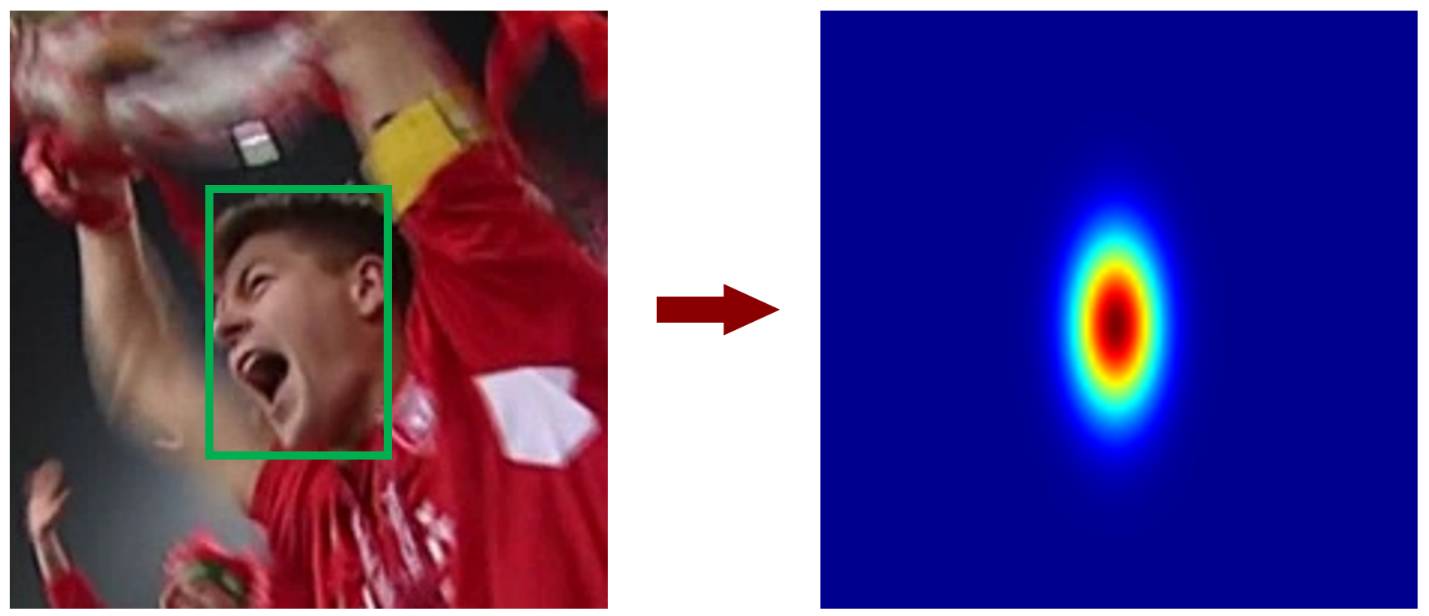

有了端对端建模,研究人员成功将物体从输入图像回归成二维的高斯响应图,峰值即为物体的位置。那么在理想情况下,网络会准确地对物体进行回归。

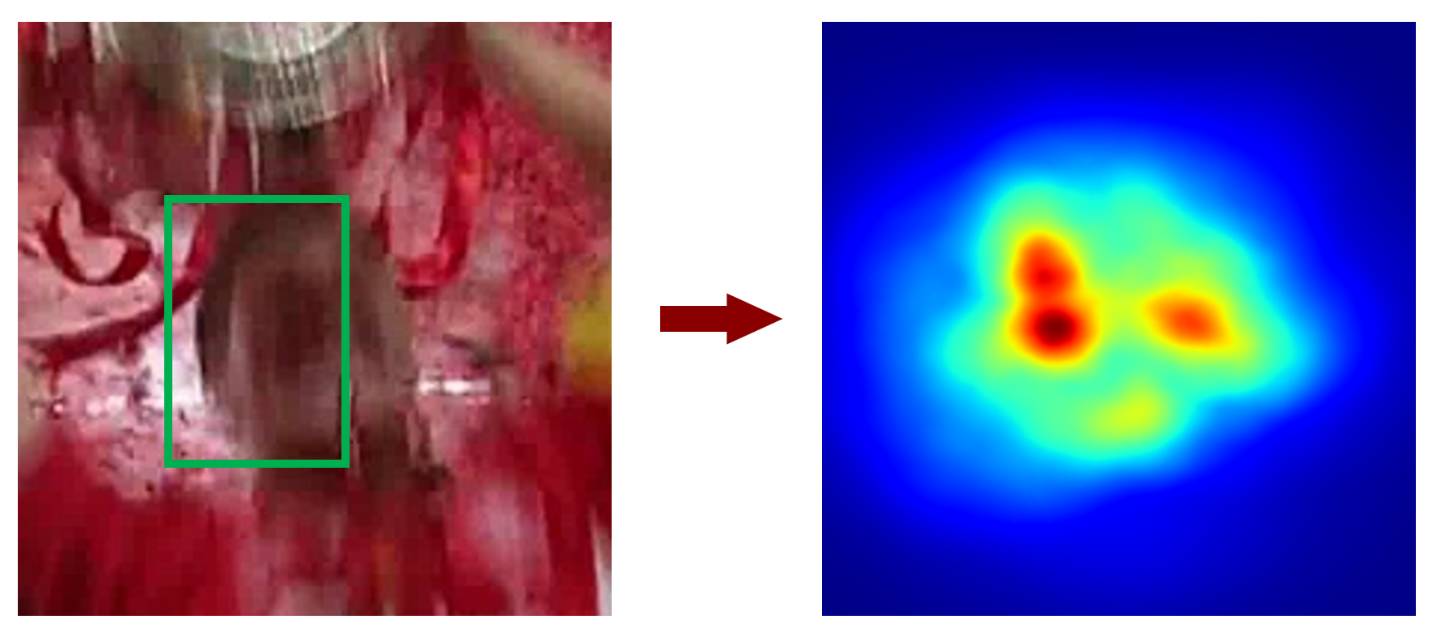

而当前文提到的制约因素,比如光照、目标物体大小发生了剧烈的变化,目标物体与背景相似时,网络将无法预测的准确二维高斯响应。这时,峰值发生了变化,导致物体位置预测失败。

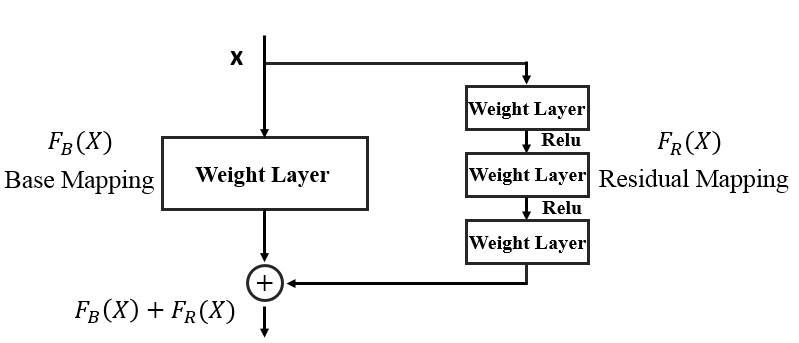

为了提升网络预测的高斯响应图的质量,本文提出了残差式学习的概念。具体讲,在单层卷积作为基本映射(Base mapping)的基础上,并行地引入了残差映射(Residual mapping),用这种方法来捕获基本映射和真实高斯响应之间的差异。

残差式学习的框架,由基本映射和残差映射组成

在物体处于平稳状态时,基本映射的输出和真实值的高斯响应很相似,此时残差网络几乎没有什么输出。在物体处于不稳定的状态时,残差网络能够很好的捕获基本映射的输出和真实值高斯响应的差异,通过加法操作补充基本映射的输出,从而使整个网络的输出更逼近真实值,更好地对目标进行定位。

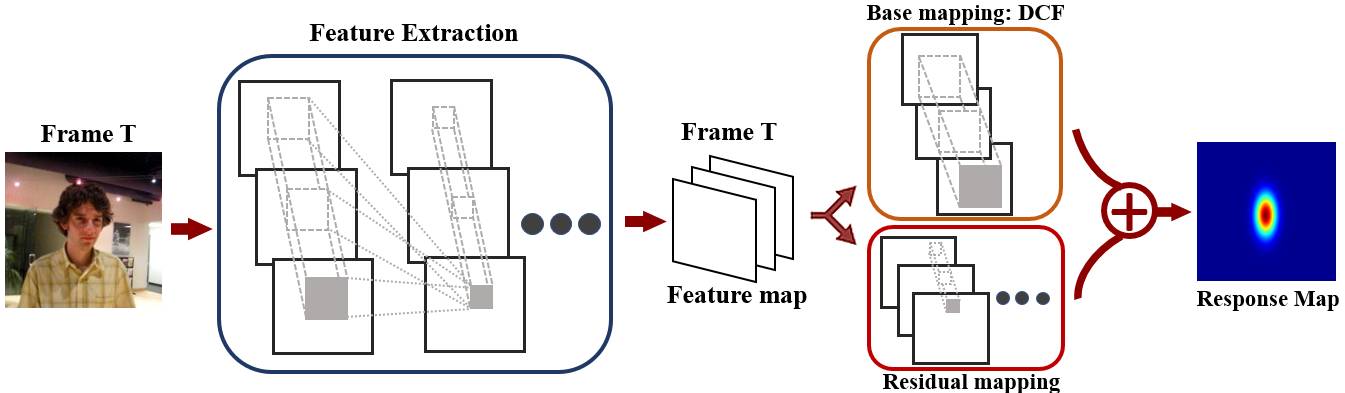

空间域的残差式学习

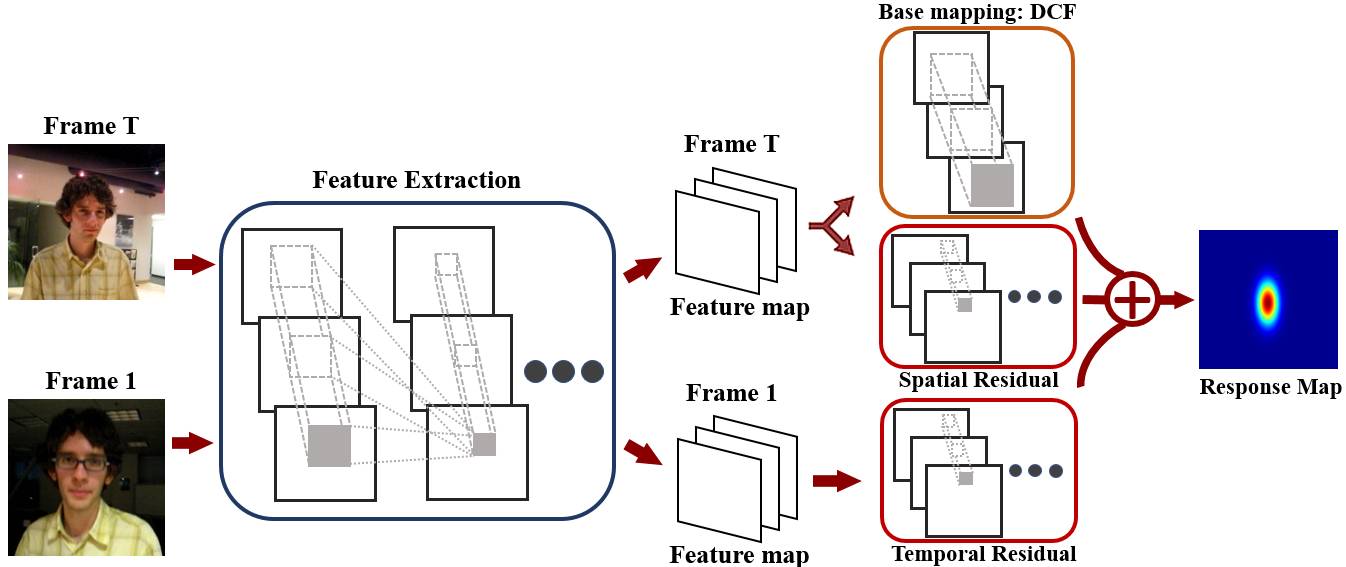

同时,本文也利用了第一帧的初始信息,将其残差补充于随后帧的预测中,帮助基本映射生成更优的高斯响应。

时域和空域的残差式学习

下图为残差式结构提升网络预测高斯响应的直观显示。

实验评估结果

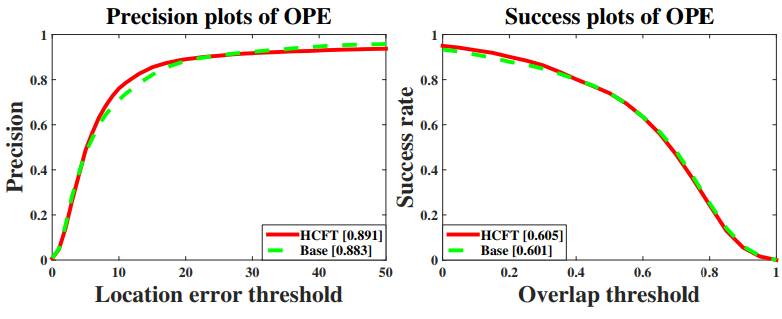

经过实验,作者发现新的方法只采用单层卷积的端到端结构,达到了利用深度特征的传统协同滤波器的效果。不仅如此,时空域的残差结构还提升了基本映射的精度。与其他跟踪方法相比,该方法在标准数据库上取得了state-of-the-art 的精度结果。

单层卷积(基本映射)与利用深度特征的传统滤波器效果相似

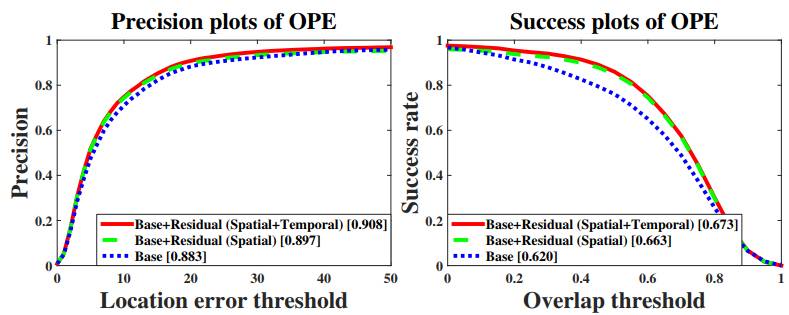

同时,在引入了时空域的残差式结构后,跟踪效果逐步提升。

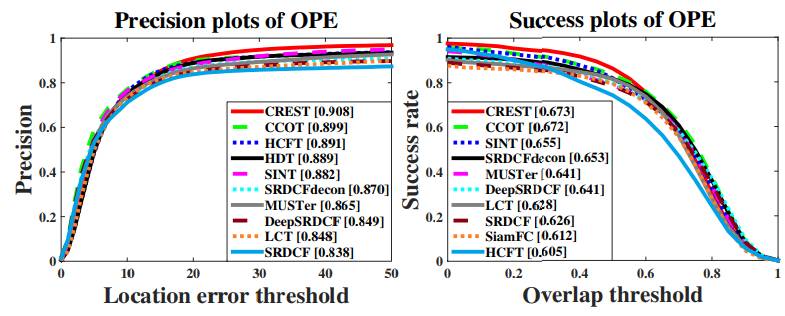

此外,在标准数据库OTB[6]上,本文提出的CREST方法取得的state-of-the-art的效果。更多的实验结果在文中进行了呈现。

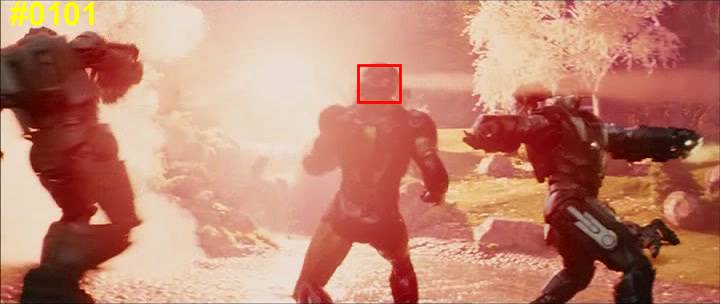

跟踪效果展示

下面是直观的跟踪效果展示,在标准数据库OTB[6]上比较了新方法CREST和目前主流的跟踪方法Staple[7],SRDCF[8],MDNet[4],C-COT[3]。以下为这些跟踪算法在一些挑战性场景下的效果。

☟ 当跟踪物体被遮挡时,CREST(红框)能够有效地对物体进行定位。C-COT(绿框)也行。

☟ 当跟踪目标出现相似物体的干扰时,MDNet(蓝框)无法有效区分,从而使得跟踪目标丢失。

☟ 当跟踪目标产生剧烈的运动变化时,CREST(红框)可以有效地进行跟踪。MDNet(蓝框)也能。

☟ 当跟踪目标与背景相似时,CREST(红框)和MDNet(蓝框)可以进行有效地区分。

可以看到,本文提出的CREST算法在挑战性的场景中,性能优于目前主流的跟踪算法。

结语

本文将利用深度学习框架,对目标跟踪进行了端到端的建模,从而能够进行全局的优化和更新。针对目标物体遇到的挑战性的场景,本文提出的残差式网络结构能够从时域和空域捕获高斯响应图的不足,并在整个网络中弥补单层卷积网络的带来的局限性。因此,跟踪的精度在标准数据库上得到了显著的提升。

本文已开源,项目地址请查阅:

www.cs.cityu.edu.hk/~yibisong/iccv17/index.html

参考文献

[1]. HCFT: Hierarchical Convolutional Features for Visual Tracking. Chao Ma, Jia-Bin Huang, Xiaokang Yang, and Ming-Hsuan Yang. ICCV 2015.

[2]. DeepSRDCF: Convolutional features for correlation filter based visual tracking. Martin Danelljan, Gustav Hager, Fahad Shahbaz Khan, and Michael Felsberg. ICCV 2015 workshops.

[3]. C-COT: Beyond correlation filters: Learning continuous convolution operators for visual tracking. Martin Danelljan, Andreas Robinson, Fahad Shahbaz Khan, and Michael Felsberg. ECCV 2016.

[4]. MDNet: Learning Multi-Domain Convolutional Neural Networks for Visual Tracking. Hyeonseob Nam, and Bohyung Han. CVPR 2016.

[5]. SINT: Siamese Instance Search for Tracking. Ran Tao, Efstratios Gavves, and Arnold W.M. Smeulders. CVPR 2016.

[6]. OTB: Online Object Tracking: A benchmark. Yi Wu, Jongwoo Lim, and Ming-Hsuan Yang. CVPR 2013.

[7] Staple: Complementary Learners for Real-Time Tracking. Luca Bertinetto, Jack Valmadre, Stuart Golodetz, Ondrej Miksik, and Philip Torr. CVPR 2016.

[8] SRDCF: Learning spatially regularized correlation filters for visual tracking. Martin Danelljan, Gustav Hager, FahadShahbaz Khan, and Michael Felsberg. ICCV 2015.

【号外】新智元正在进行新一轮招聘,飞往智能宇宙的最美飞船,还有N个座位

点击阅读原文可查看职位详情,期待你的加入~