Jeff Dean又掀超级智能旋风!谷歌公布下一代AI框架Pathways,全知全能还省电

新智元报道

新智元报道

来源:Google

编辑:好困 LRS

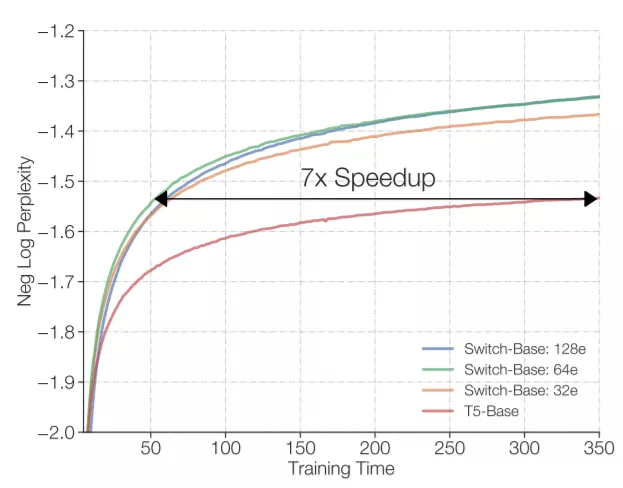

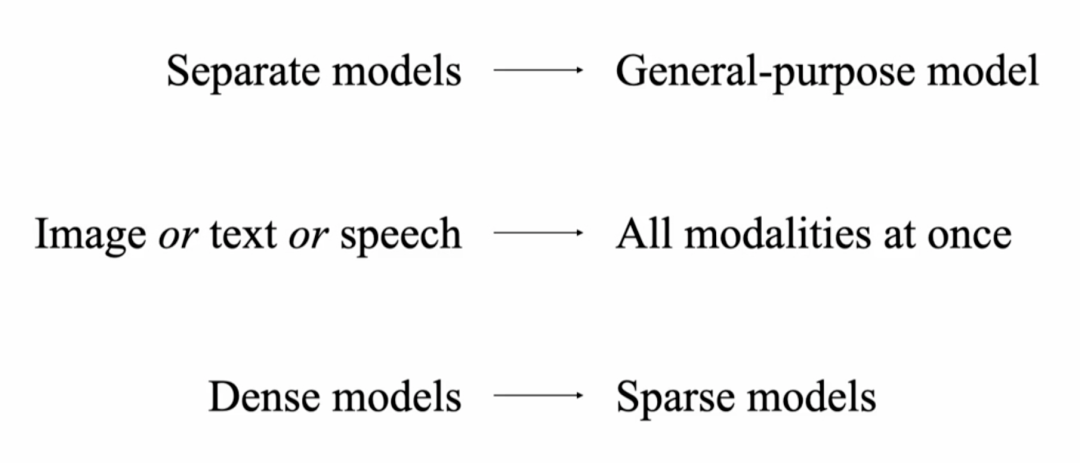

【新智元导读】通用人工智能(AGI)的目标是训练的模型具有和人类相当的智慧,却惹得无数研究人员竞折腰。最近Jeff Dean发文,称他们正在研究下一代AI框架Pathways,目标直指AGI。这次凭借谷歌的「钞」能力,Jeff Dean能否再掀起一场AI革命?

下一代AI架构:Pathways

下一代AI架构:Pathways

总结一下?

总结一下?

参考资料:

https://blog.google/technology/ai/introducing-pathways-next-generation-ai-architecture/

https://www.ted.com/talks/jeff_dean_ai_isn_t_as_smart_as_you_think_but_it_could_be/footnotes?utm_content=2021-10-28&utm_source=t.co&utm_medium=social&utm_campaign=social#t-13177

登录查看更多

相关内容

Google Research Group的Google高级研究员,他与人共同创立并领导了Google Brain团队,即Google的深度学习和人工智能研究团队。他和他的合作者正在研究语音识别,计算机视觉,语言理解和各种其他机器学习任务的系统。Jeff在Google期间,曾对Google的爬网,索引和查询服务系统,Google的主要广告和AdSense for content系统的主要部分以及Google的分布式计算基础结构(包括MapReduce,BigTable和Spanner)进行代码签名。杰夫(Jeff)是ACM和AAAS,美国国家工程院院士,计算机科学ACM -Infosys基金会奖获得者。他拥有华盛顿大学的计算机科学博士学位,在那里他与Craig Chambers一起研究了面向对象语言的全程序优化技术,并获得了明尼苏达大学的计算机科学和经济学学士学位。

Arxiv

0+阅读 · 2022年4月19日

Arxiv

14+阅读 · 2022年1月20日