近期必读的6篇顶会WWW 2020【迁移学习(Transfer Learning)】相关论文

CCF-A类顶会WWW2020最佳论文出炉!OSU最佳论文,北邮斩获最佳学生论文!

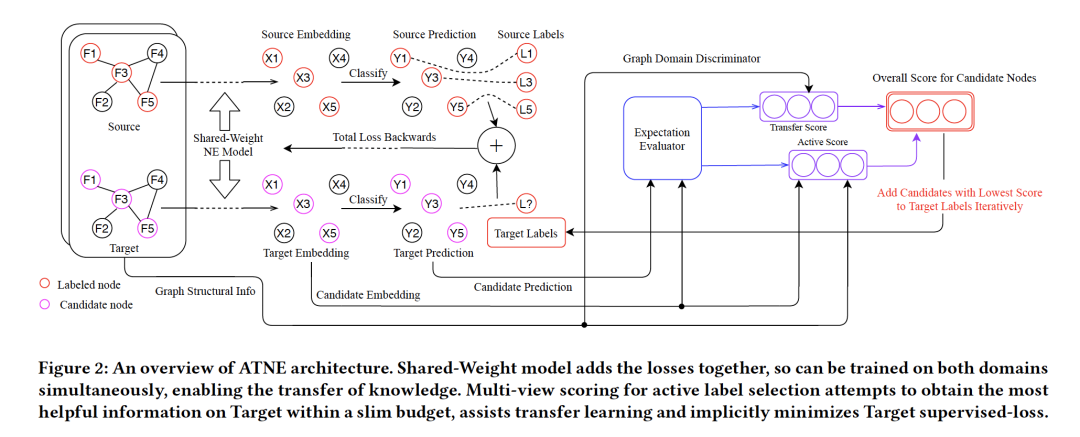

1. Active Domain Transfer on Network Embedding

作者:Lichen Jin, Yizhou Zhang, Guojie Song, Yilun Jin

摘要:最近的工作表明,端到端、监督(半监督)的网络嵌入模型可以生成令人满意的向量来表示网络拓扑,甚至可以通过归纳学习(inductive learning)适用于未知(unseen)的图。然而,归纳学习的训练网络和测试网络之间的域不匹配,以及缺乏标记数据,会影响这种方法的结果。相应地能够解决上述问题的迁移学习和主动学习(active learning)技术已经在常规独立同分布数据上得到了很好的研究,而它们在网络上的关注相对较少。因此,本文提出了一种网络上的主动迁移学习方法,称为主动迁移网络嵌入(Active-Transfer Network Embedding,ATNE)。在ATNE中,我们从迁移和主动学习两个角度综合考虑各个节点对网络的影响,从而在训练过程中结合这两个方面设计新颖有效的影响分值以方便节点的选择。我们证明了ATNE是有效的,并且与实际使用的模型是解耦的。进一步的实验表明,ATNE的性能优于最新的主动节点选择方法,并且在不同的情况下表现出了通用性。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380024

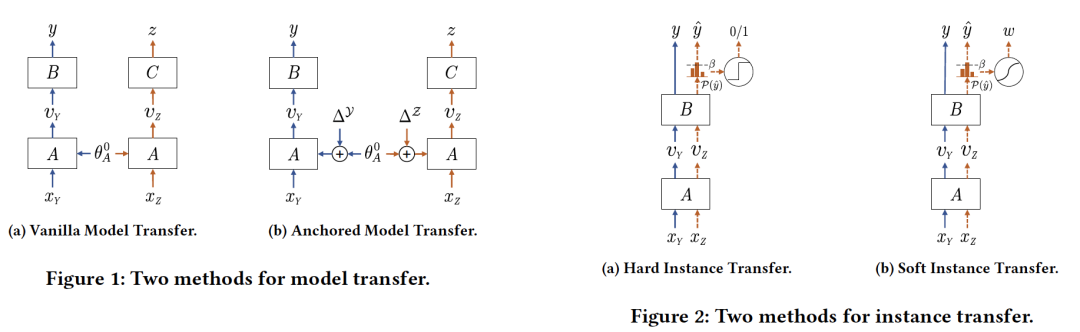

2. Anchored Model Transfer and Soft Instance Transfer for Cross-Task Cross-Domain Learning: A Study Through Aspect-Level Sentiment Classification

作者:Yaowei Zheng, Richong Zhang, Suyuchen Wang, Samuel Mensah, Yongyi Mao

摘要:监督学习在很大程度上依赖于容易获得的标记数据来推断有效的分类函数。然而,在有监督学习下提出的方法面临领域内标注数据稀缺的问题,且通用性不够强,不能适用于其他任务。通过允许跨域和跨任务共享知识,迁移学习已被证明是解决这些问题的一个有价值的选择。通过允许跨域和跨任务共享知识,迁移学习已被证明是解决上述问题的一个有价值的选择。本文提出了Anchored Model迁移(AMT)和Soft Instance迁移(SIT)两种迁移学习方法,这两种学习方法都是基于多任务学习,兼顾了模型迁移和实例迁移,可以结合到一个通用的框架中。我们证明了AMT和SIT对于aspect-level的情感分类的有效性,在基准数据集上我们的模型表现出比基线模型更有竞争力的表现。有趣的是,AMT + SIT的集成可在同一任务上实现最先进的性能。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380034

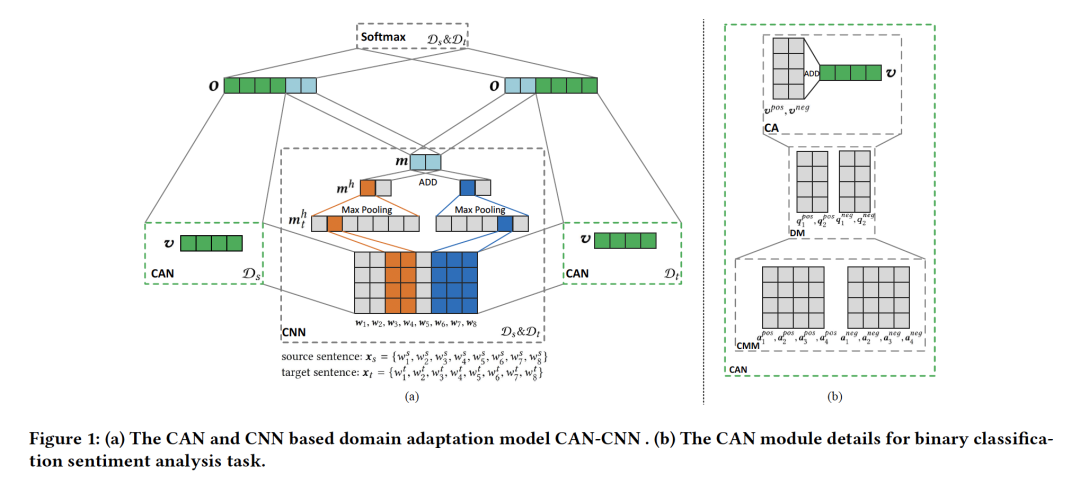

3. Domain Adaptation with Category Attention Network for Deep Sentiment Analysis

作者:Dongbo Xi, Fuzhen Zhuang, Ganbin Zhou, Xiaohu Cheng, Fen Lin, Qing He

摘要:跨域情感分类等领域自适应任务旨在利用源域中已有的已标记数据和目标域中未标记或很少的标记数据,通过减少数据分布之间的偏移来提高目标域的性能。现有的跨领域情感分类方法需要区中心点(pivots)(即领域共享的情感词)和非中心点(即领域特定的情感词),才能获得良好的自适应性能。本文首先设计了一个类别注意网络(CAN),然后提出了一种将CAN和卷积神经网络(CNN)相结合的CAN-CNN模型。该模型一方面将中心点和非中心点作为统一的类别属性词进行自动捕获,提高领域自适应性能;另一方面,对迁移后的类别属性词进行可解释性学习的尝试。具体地说,该模型的优化目标有三个不同的组成部分:1)监督分类损失;2)类别特征权重的分布损失;3)领域不变性损失。最后,在三个舆情分析数据集上对所提出的模型进行了评估,结果表明CAN-CNN的性能优于其他各种基线方法。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380088

4. Domain Adaptive Multi-Modality Neural Attention Network for Financial Forecasting

作者:Dawei Zhou, Lecheng Zheng, Yada Zhu, Jianbo Li, Jingrui He

摘要:金融时间序列分析在优化投资决策、对冲市场风险方面起着核心作用。这是一项具有挑战性的任务,因为问题总是伴随着双层(即数据级和任务级)的异构性。例如,在股价预测中,一个成功的具有有限风险的投资组合通常由来自不同领域(如公用事业、信息技术、医疗保健等)的大量股票组成,每个领域的股票预测可以视为一个任务;在一个投资组合中,每个股票的特征是从多个模态(例如金融、天气和新闻)收集的时间数据,这对应于数据层的异构性。此外,金融业遵循高度监管的过程,这就要求预测模型是可解释的,输出结果必须满足合规性。因此,一个自然的研究问题就是如何建立一个模型,既能在解决此类多通道多任务学习问题时取得满意的性能,又能为最终用户提供全面的解释。为了回答这个问题,本文提出了一个通用的时间序列预测框架Dandelion,它利用多模态的一致性,并使用深度神经网络来探索多个任务的相关性。此外,为了保证框架的可解释性,我们集成了一种新的三位一体的注意机制,允许最终用户在三个维度(即任务、通道和时间)上调查变量重要性。广泛的实证结果表明,Dandelion在过去15年中对来自4个不同领域的396只股票的金融市场预测取得了优异的表现。具体地说,两个有趣的案例研究显示了Dandelion在其盈利表现和输出结果对最终用户的可解释性方面的成效。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380288

5. Exploiting Aesthetic Preference in Deep Cross Networks for Cross-domain Recommendation

作者:Jian Liu, Pengpeng Zhao, Fuzhen Zhuang, Yanchi Liu, Victor S. Sheng, Jiajie Xu, Xiaofang Zhou, Hui Xiong

摘要:产品的视觉美学在购买外观优先的产品(如服装)的决策过程中起着重要的作用。用户的审美偏好作为一种个性特征和基本要求,是与领域无关的,可以作为领域间知识迁移的桥梁。然而,现有的工作很少考虑产品图像中的审美信息进行跨域推荐。为此,本文提出了一种新的深度审美跨域网络(ACDN),通过跨网络共享表征个人审美偏好的参数来实现领域间的知识传递。具体地说,我们首先利用审美网络来提取审美特征。然后,我们将这些特征集成到一个跨域网络中,以传递用户与领域无关的审美偏好。此外,还引入了网络交叉连接,以实现跨域的双重知识转移。最后,在真实数据集上的实验结果表明,我们提出的模型ACDN在推荐准确率方面优于基准方法。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380036

6. Modeling Users’ Behavior Sequences with Hierarchical Explainable Network for Cross-domain Fraud Detection

作者:Yongchun Zhu, Dongbo Xi, Bowen Song, Fuzhen Zhuang, Shuai Chen, Xi Gu, Qing He

摘要:随着电子商务行业的爆炸式增长,检测现实应用中的网络交易欺诈对电子商务平台的发展变得越来越重要。用户的连续行为历史为区分欺诈支付和正常支付提供了有用的信息。最近,已经提出了一些方法来解决这一基于序列的欺诈检测问题。然而,这些方法通常存在两个问题:预测结果难以解释和对行为内部信息的利用不足。针对上述两个问题,本文提出了一种分层可解释网络(HEN)对用户行为序列进行建模,不仅提高了欺诈检测的性能,而且使推理过程具有可解释性。同时,随着电子商务业务扩展到新的领域,例如,新的国家或新的市场,在欺诈检测系统中建模用户行为的一个主要问题是数据收集的限制(例如,可用的数据/标签非常少)。因此,在本文中,我们进一步提出了一个跨域欺诈检测问题的迁移框架,该框架的目的是从现有领域(源域)迁移足够成熟数据的知识,以提高在新领域(目标域)的性能。我们提出的方法是一个通用的迁移框架,它不仅可以应用于HEN,而且可以应用于嵌入&MLP范式中的各种现有模型。利用世界领先的跨境电商平台的数据,我们在不同国家进行了广泛的检测盗卡交易诈骗的实验,以展示HEN的优越性能。此外,基于90个迁移任务的实验,证明了我们的迁移框架不仅可以用于HEN的跨域诈骗检测任务,而且对现有的各种模型都具有通用性和可扩展性。此外,HEN和迁移框架形成了三个级别的注意力,极大地提高了检测结果的可解释性。

网址:

https://dl.acm.org/doi/abs/10.1145/3366423.3380172

请关注专知公众号(点击上方蓝色专知关注)

后台回复“WWW2020TL” 就可以获取《6篇顶会WWW 2020【迁移学习(Transfer Learning, TL)】相关论文》的pdf下载链接~