【干货|如何打开黑盒子模型?】41页最新机器学习可解释模型综述论文,143篇参考文献,2300次下载

【导读】最近一期的计算机顶级期刊ACM Computing Surveys (CSUR)出版,包含了来自意大利比萨大学的研究人员发布的一篇构建机器学习可解释性综述论文《A Survey of Methods for Explaining Black Box Models》,详细阐述了解释黑盒机器学习模型的术语概念以及相关方法,是构建可解释模型的重要指南.

Riccardo Guidotti, Anna Monreale, Salvatore Ruggieri, Franco Turini, Fosca Giannotti, and Dino Pedreschi. 2018. A Survey of Methods for Explaining Black Box Models. ACM Comput. Surv. 51, 5, Article 93 (August 2018), 42 pages.

论文获取

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“EBBM” 就可以获取综述论文PDF下载链接~

文章摘要

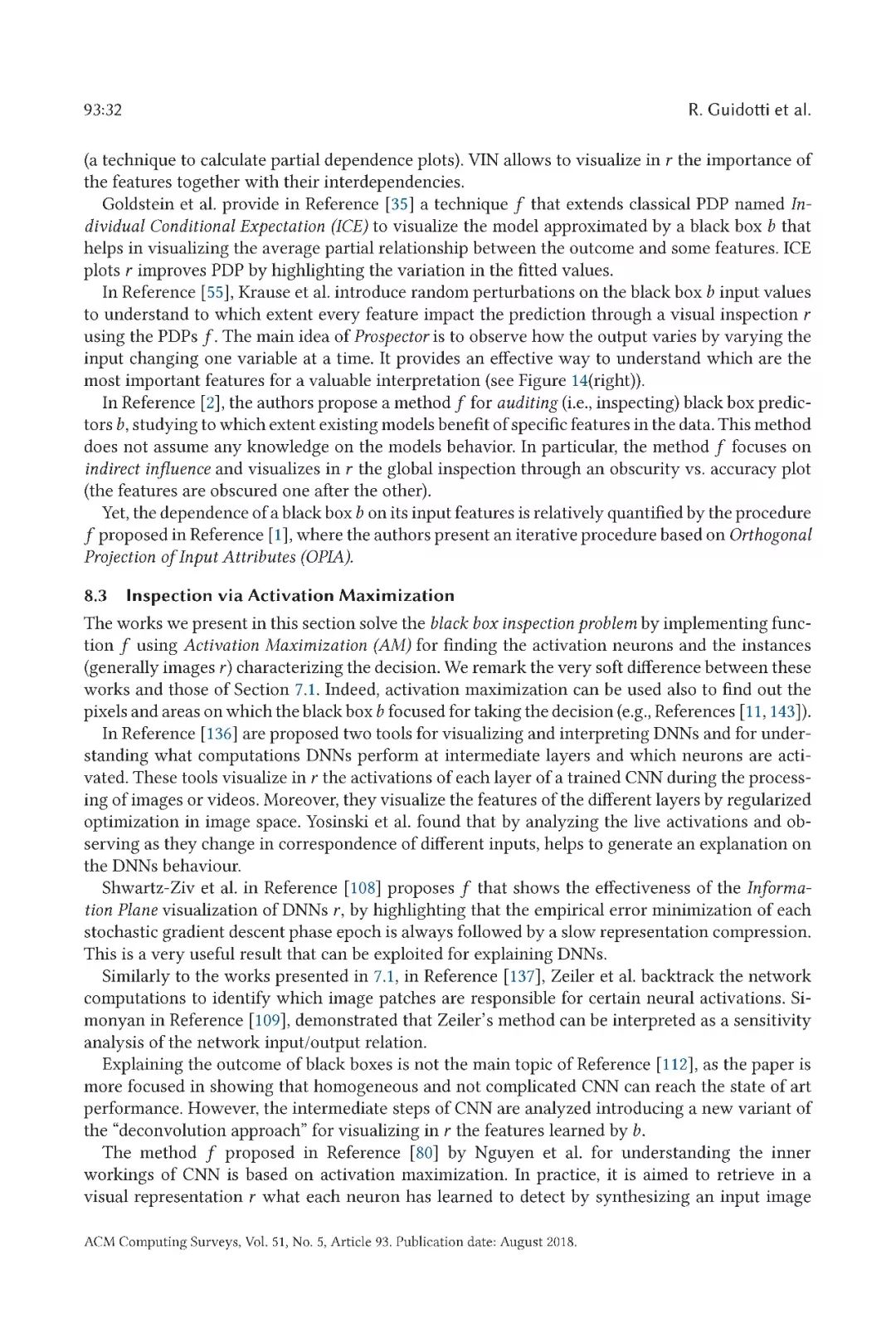

近年来,许多准确的决策支持系统被构建为黑盒子,即向用户隐藏其内部逻辑的系统。缺乏解释性既是实际问题,也是道德问题。这篇综述文献报道了许多旨在克服这一至关重要弱点的方法,有时以牺牲准确性为代价来提升可解释性。可以使用黑盒决策系统的应用是多种多样的,并且每种方法通常被开发以提供针对特定问题的解决方案,并且因此,其明确地或隐含地描绘其自身对可解释性的定义。本文的目的是提供调研文献中关于解释概念和黑匣子系统类型的主要问题的分类。给定问题定义,黑匣子类型和所需解释,此综述应该有助于研究人员找到对他自己工作更有用的建议。所提出的黑匣子模型分类方法也应该有助于对许多研究开放性问题。

文章导读

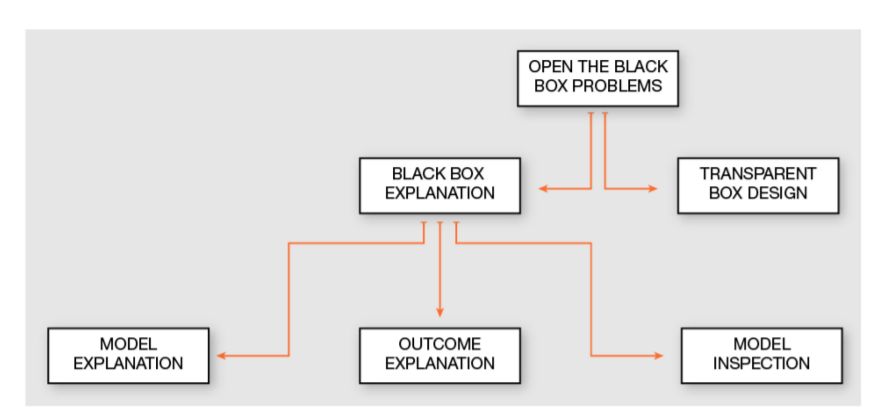

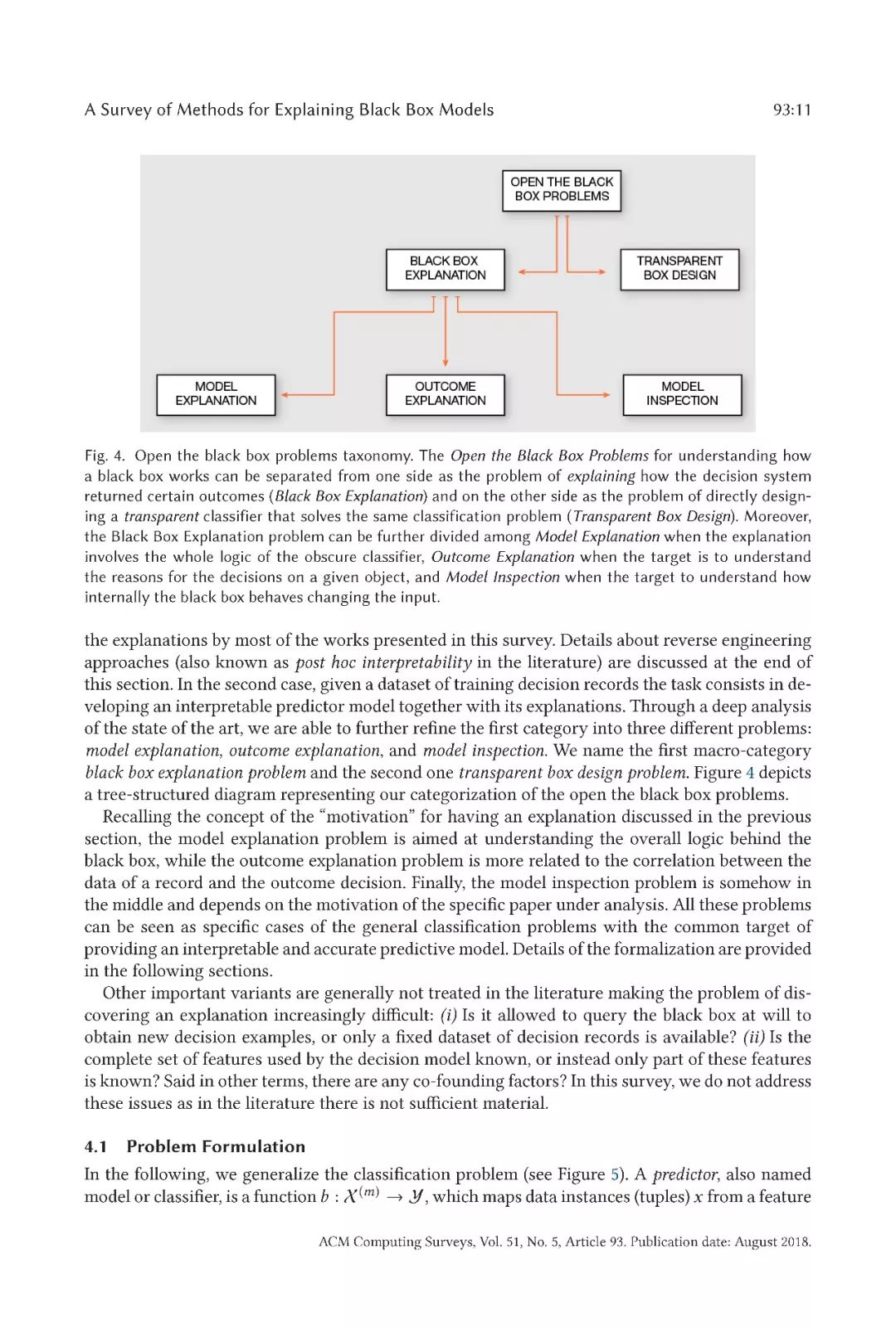

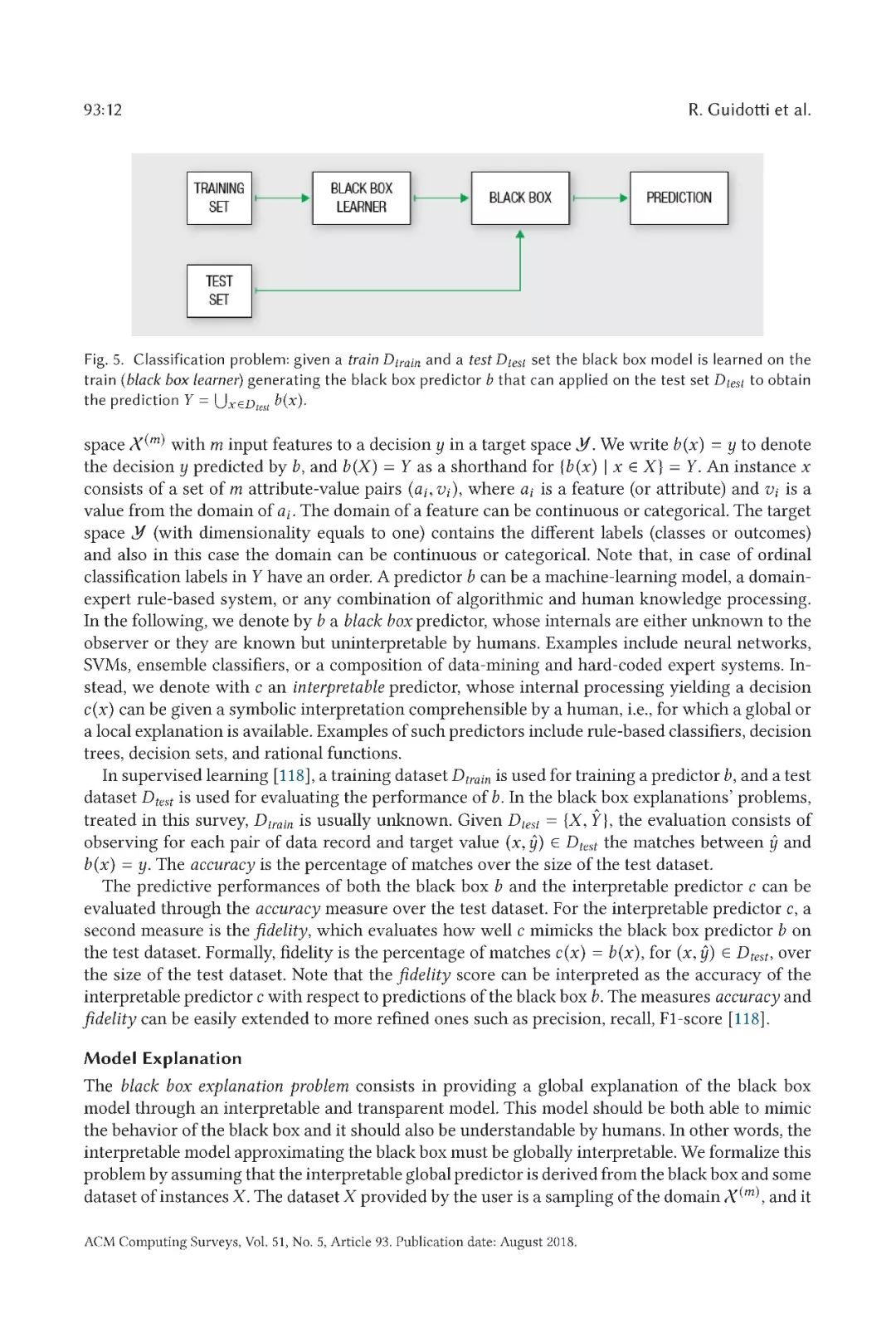

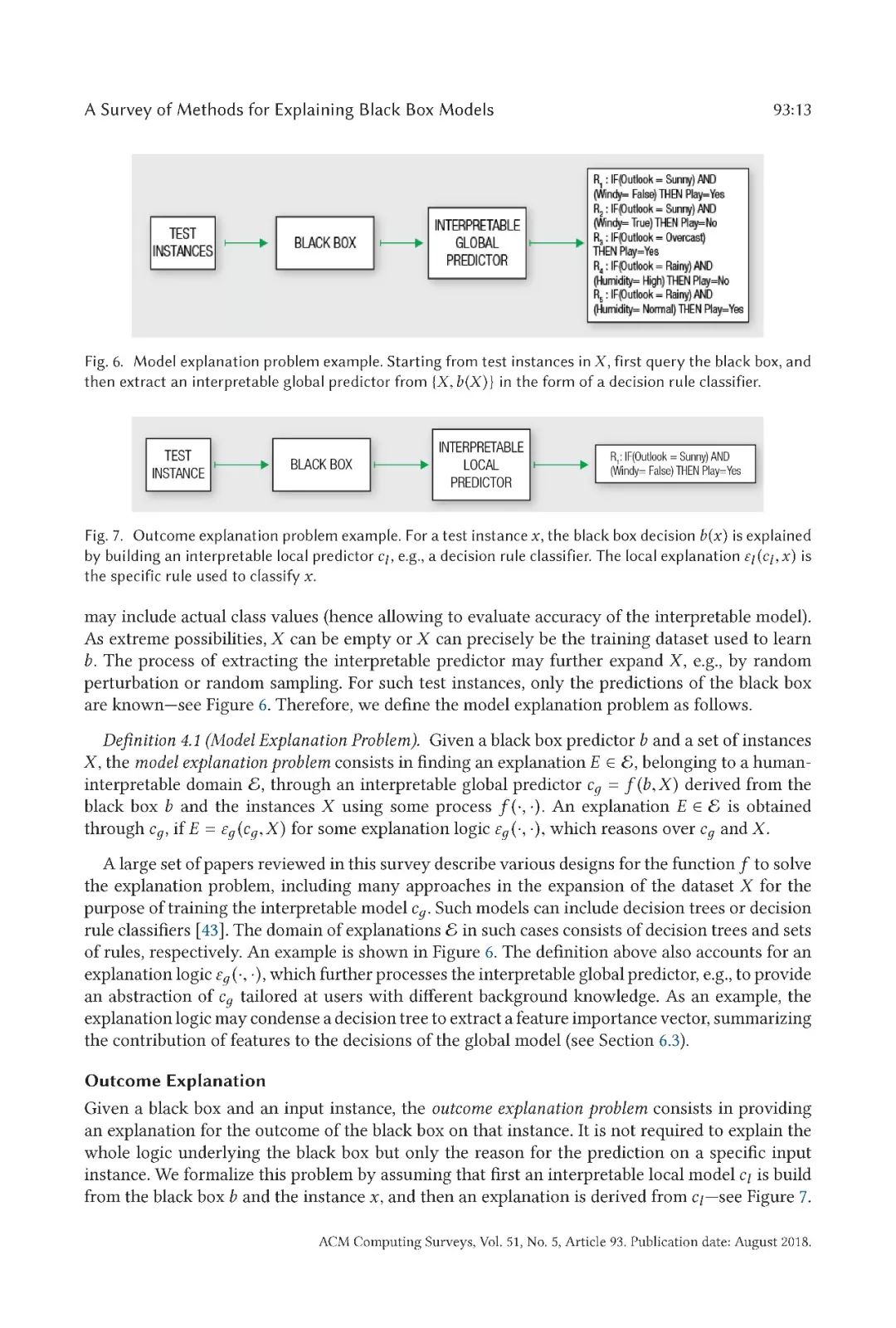

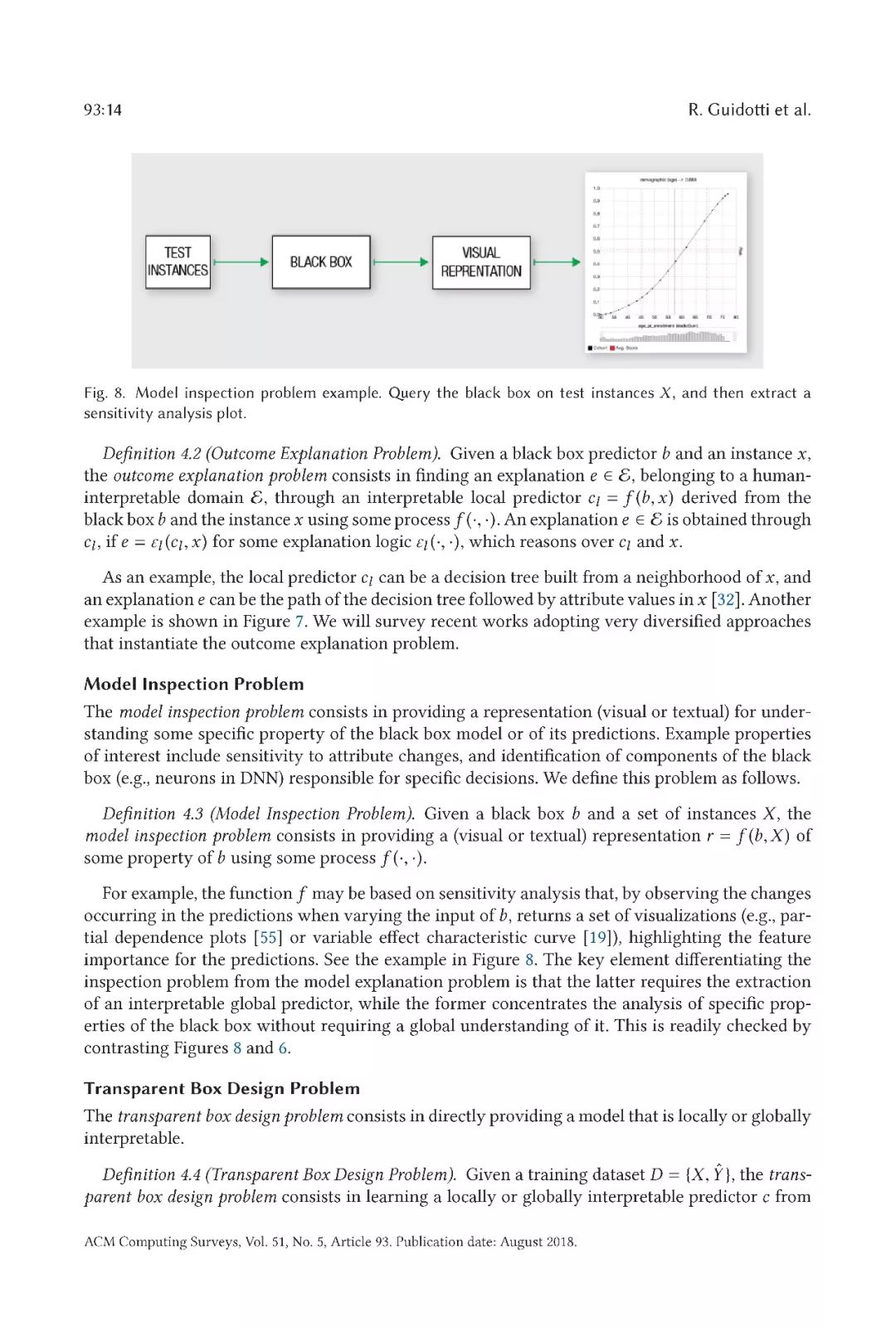

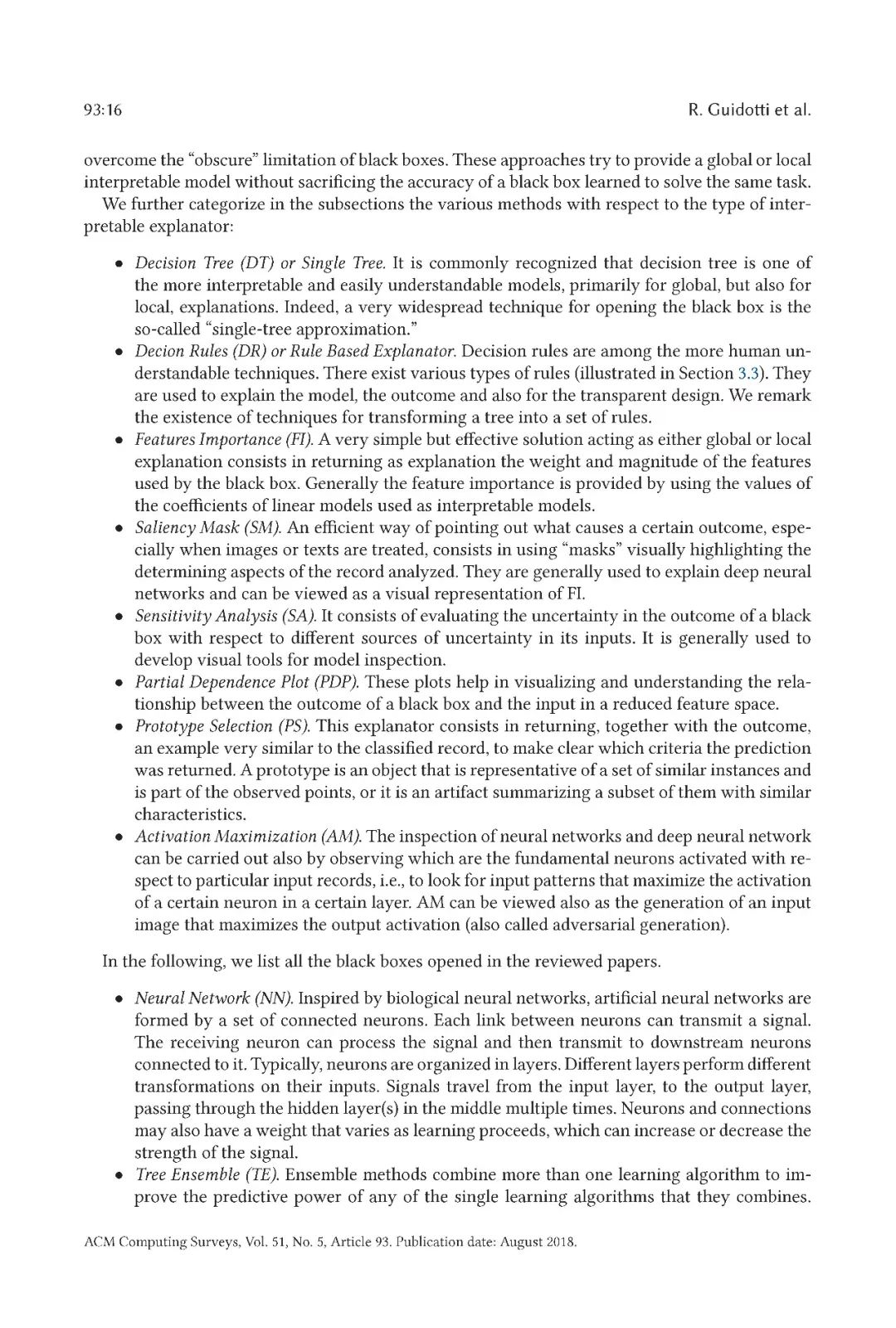

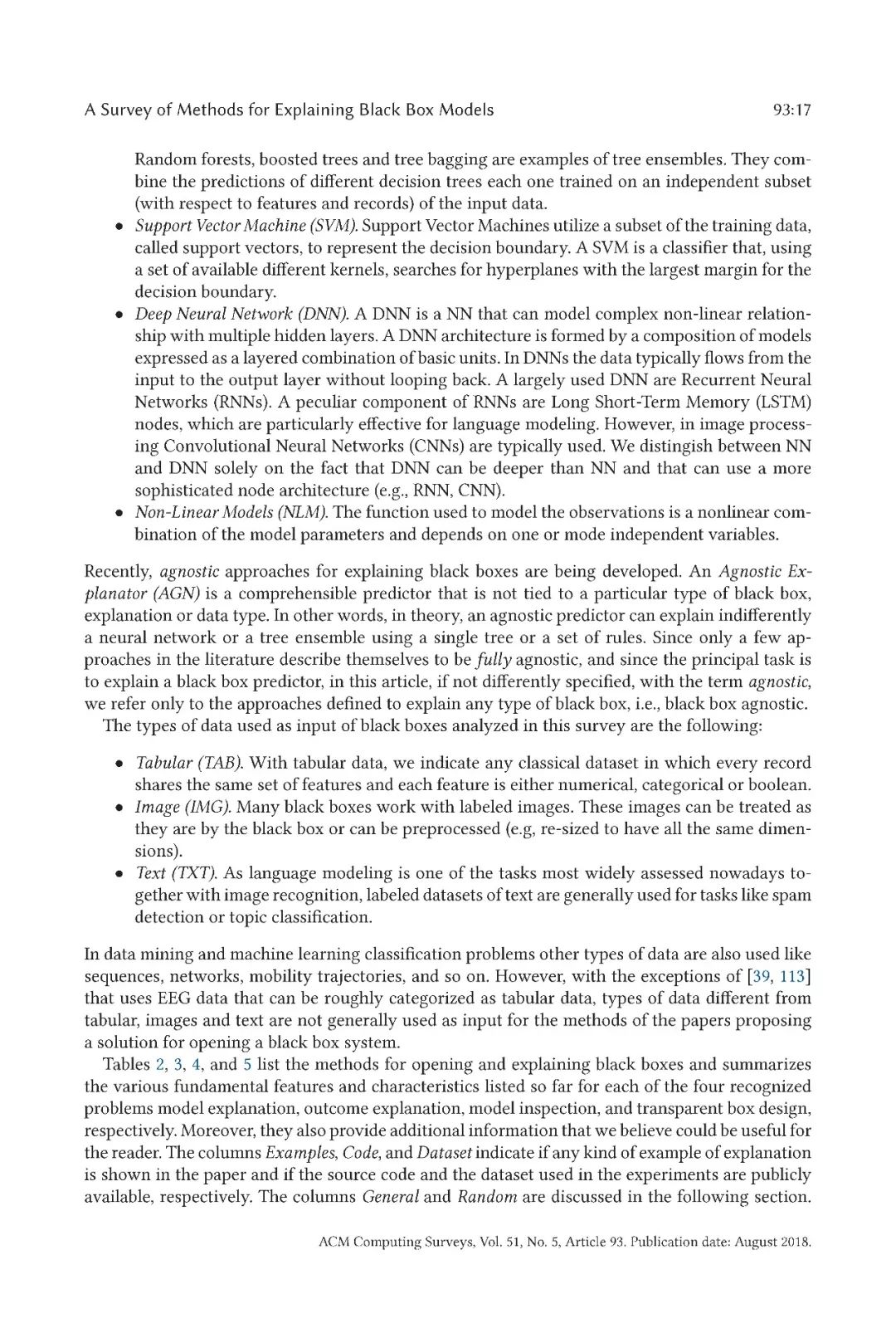

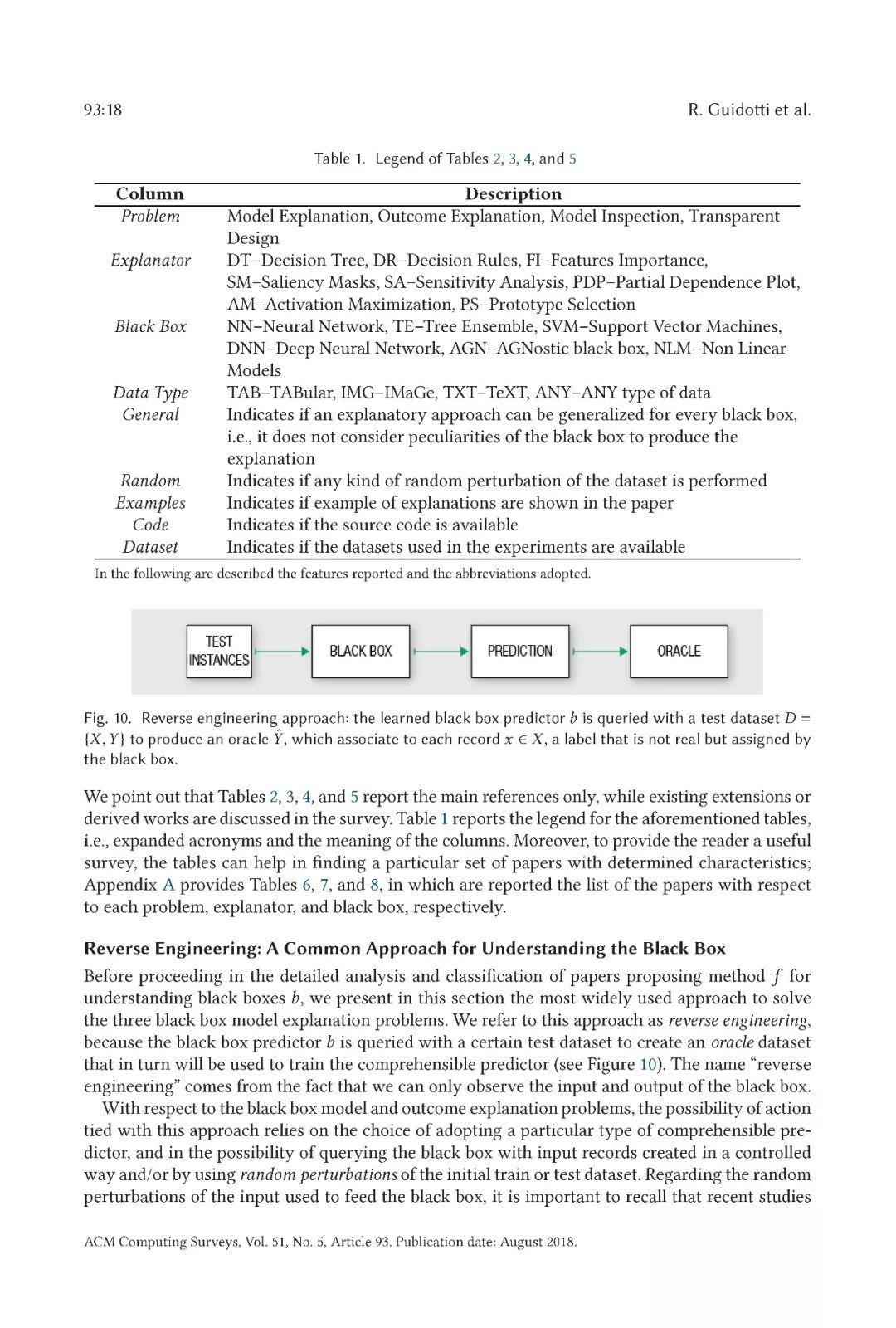

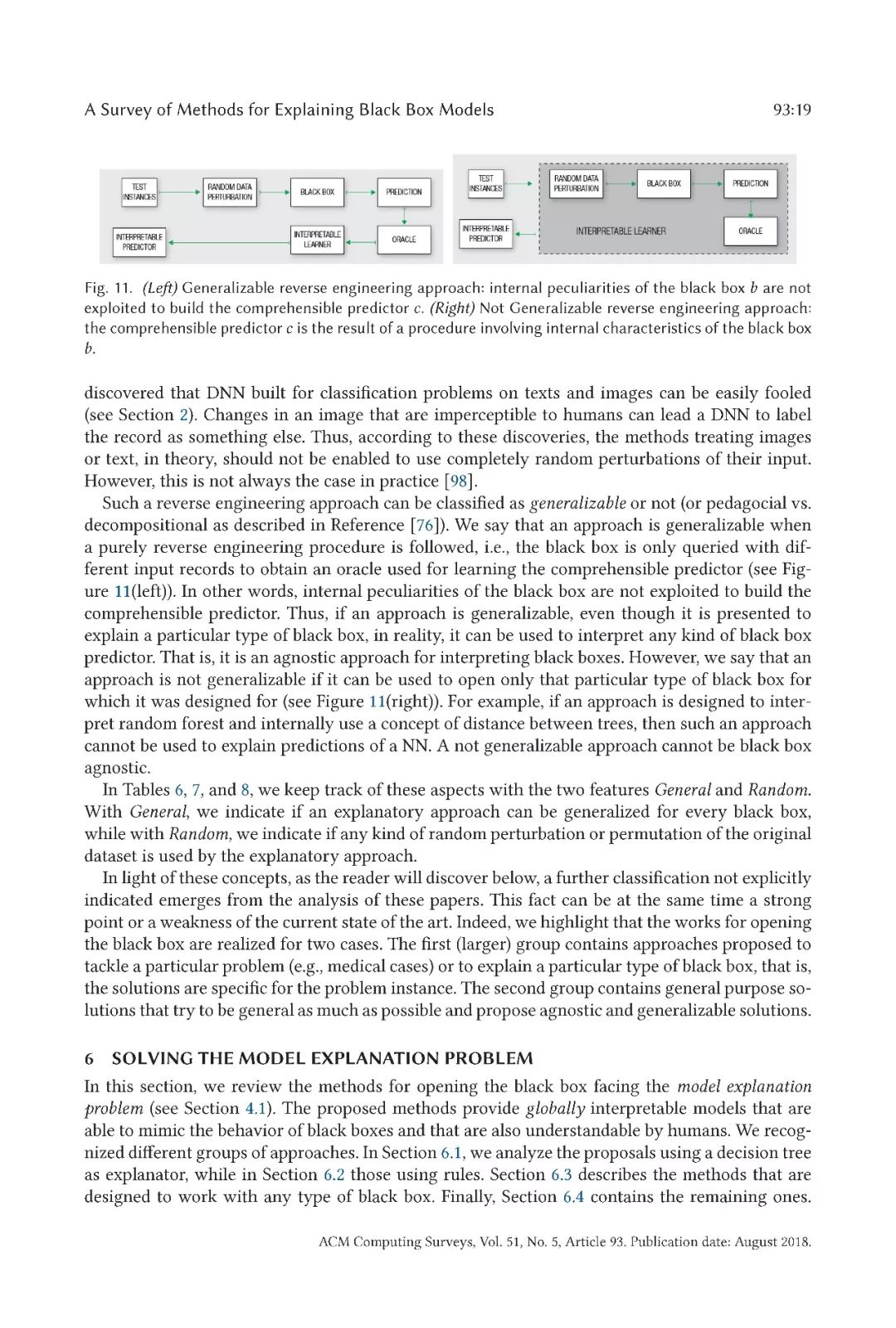

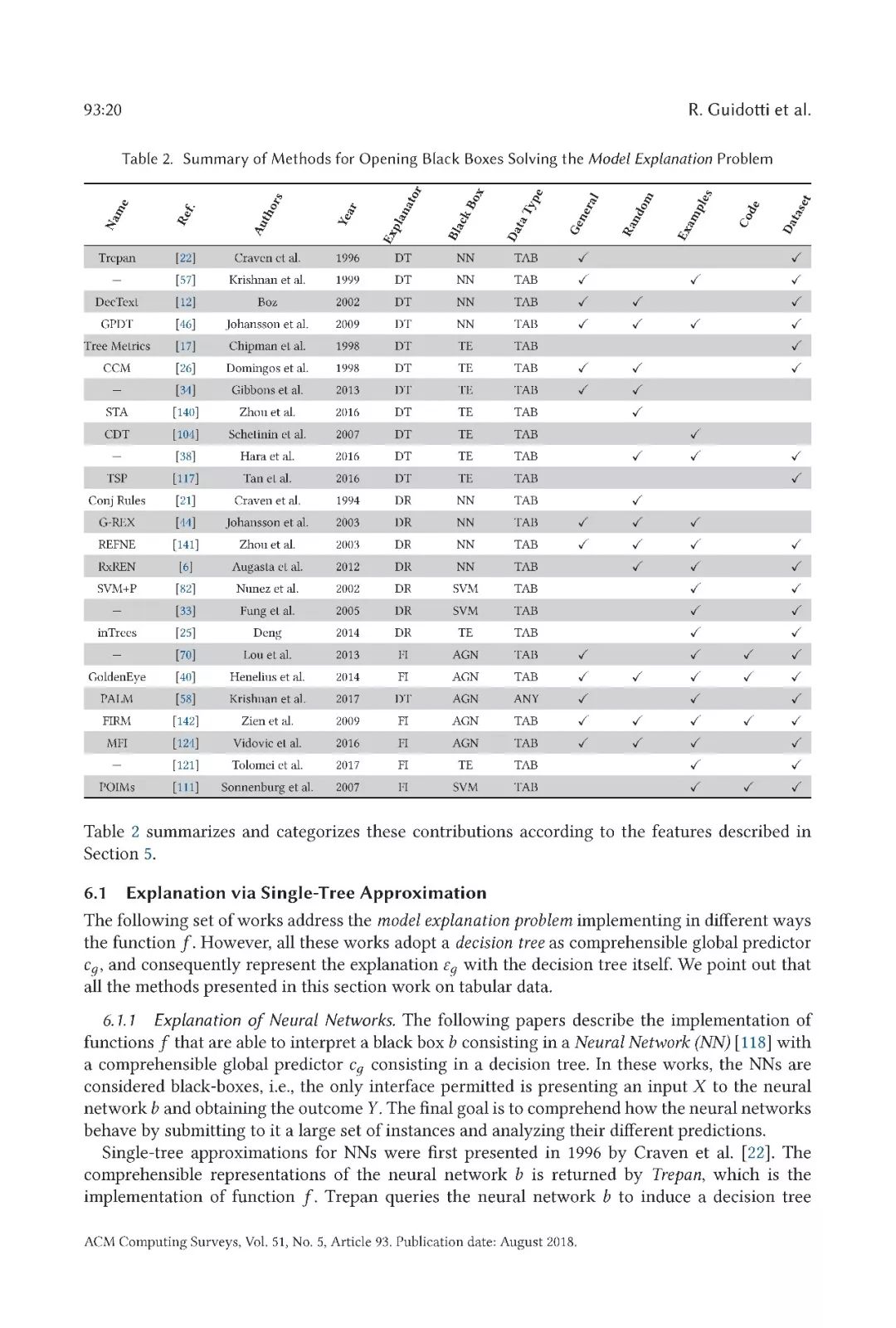

在本文中,我们对文献中提出的用于解释基于不透明和模糊机器学习模型的决策系统的方法进行了全面的概述。首先,我们确定了解释问题的不同组成部分。特别是,我们提供了属于该范畴的每个问题的正式定义,为每个问题捕获了适当的特性。我们将这些黑箱问题命名为:模型解释问题、结果解释问题、模型检查问题、透明箱设计问题。然后,我们提出了文献中研究的方法的分类,这些方法考虑了以下几个方面:解决的具体解释问题,采用的解释器的类型,打开的黑箱模型,以及黑箱模型输入的数据的类型。

-END-

专 · 知

人工智能领域26个主题知识资料全集获取与加入专知人工智能服务群: 欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知