打开人工智能黑箱:看最新16篇可解释深度学习文章,带您了解增强AI透明性

【导读】深度学习通常在监督任务上有较高的准确性,但是无法给出产出过程的明确解释,这也是一直被诟病“黑箱模型”。而可解释性AI在关于人类的很多应用方面是必需的,如医疗诊断、教育学习、政府决策等等。最近,关于深度学习的可解释性,学者们做了大量的研究工作,专知整理关于深度学习可解释性的最新一些文章,希望能给读者提供一些参考和帮助。

请关注专知公众号(扫一扫最下面专知二维码,或者点击上方蓝色专知)

后台回复“XAI” 就可以获取美国Darpa18页可解释人工智能PPT下载链接~

专知《深度学习:算法到实战》2019年1月正在开讲,欢迎报名!

专知开课啦!《深度学习: 算法到实战》, 中科院博士为你讲授!

可解释人工智能:从SML到XAI

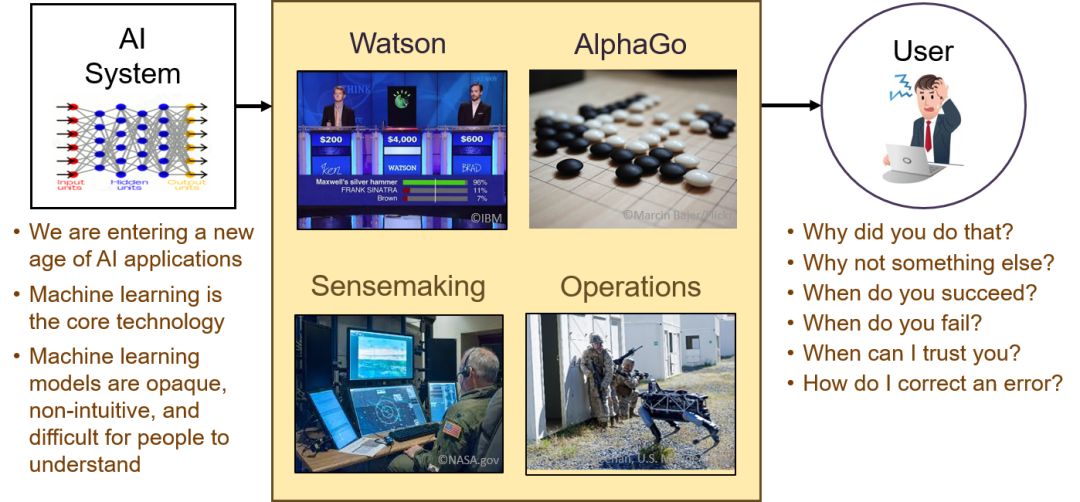

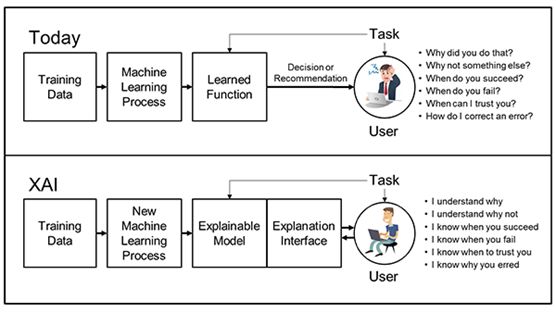

美国darpa网站,描述了传统机器学习模型与解释性人工智能模型的区别,现在的统计机器学习模型更加注重预测结果,比如推荐什么,识别是什么,什么决定。

https://www.darpa.mil/program/explainable-artificial-intelligence

而解释性人工智能模型除了给出预测结果,还更加注重预测结果的过程,为什么给出这样的预测结果,做出解释。增强 AI 模型的透明(transparency)是人机互信的前提。

比如

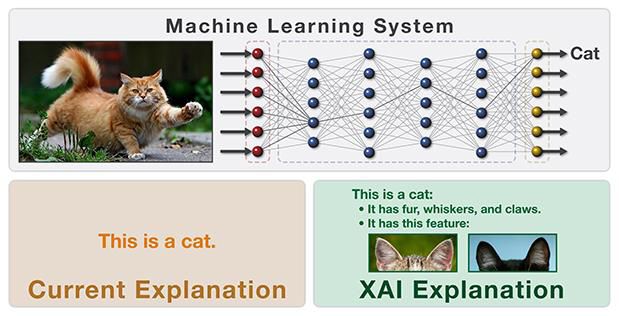

比如图像识别的任务,现在的模型通过卷积神经网络会识别出这是一只猫。

可解释人工智能模型,会给出解释,它有皮毛胡须 爪子, 这一确认这是一只猫。

最近《可解释性深度学习》论文

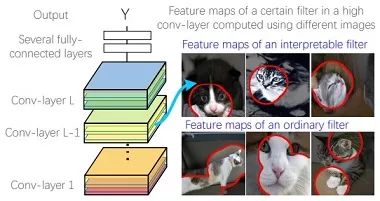

1. 可解释性卷积神经网络

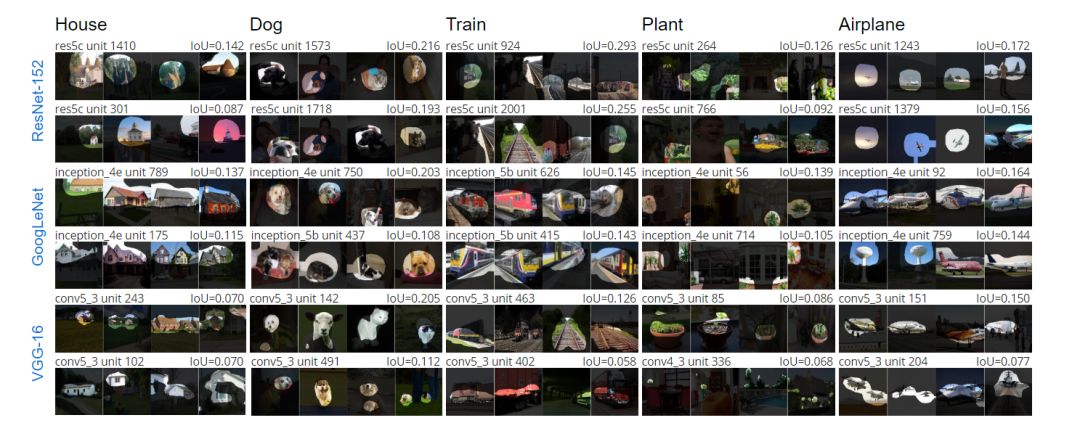

在视觉识别方面,卷积神经网络毫无疑问取得的巨大的识别性能提升。如何增强对识别过程的透明性,是一个重要的问题。这一方面,相关学者做了很多工作。周博磊博士(香港中文大学)和张拳石博士(上海交通大学)在这方面做了大量的工作。

视觉智能的可解释表示学习

Interpreting Deep Visual Representations via Network Dissection.

Bolei Zhou*, David Bau*, Aude Oliva, and Antonio Torralba. IEEE Transactions on Pattern Analysis and Machine Intelligence, June 2018.http://netdissect.csail.mit.edu/

Bolei Zhou, Interpretable Representation Learning for Visual Intelligence. PhD thesis submitted to MIT EECS, May 17, 2018.

Committee: Antonio Torralba, Aude Oliva, Bill Freeman.http://people.csail.mit.edu/bzhou/publication/thesis.pdf

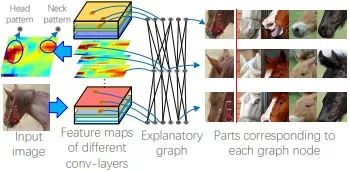

可解释CNN

Visual interpretability for Deep Learning: a Survey. Quanshi Zhang and Song-Chun Zhu. Frontiers of Information Technology & Electronic Engineering. Vol. 19, No. 1, page 27-39, 2018

http://www.zhuanzhi.ai/paper/cc8b59ceb80123200f202301e1a81e2f

Interpretable Convolutional Neural Networks. Quanshi Zhang, Ying Nian Wu, and Song-Chun Zhu. CVPR (Spotlight) 2018

http://www.zhuanzhi.ai/paper/e667f830addd942807055f020b80594c

Interpreting CNN Knowledge via an Explanatory Graph. Quanshi Zhang, Ruiming Cao, Feng Shi, Ying Nian Wu, and Song-Chun Zhu AAAI, 2018

http://www.zhuanzhi.ai/paper/e224cdc24f8c2a7f0fbfbb5f749d940a

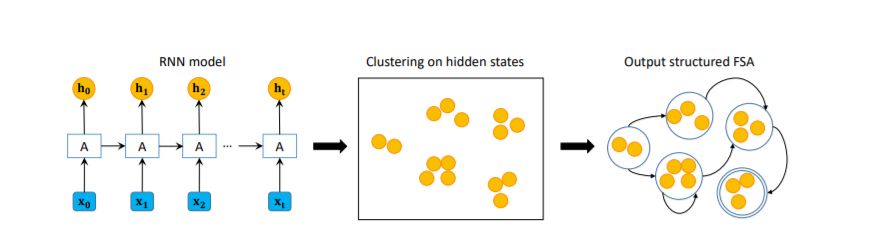

2. 可解释性循环神经网络

周志华老师最新文章。Learning with Interpretable Structure from RNN. Bo-Jian Hou, Zhi-Hua Zhou

http://www.zhuanzhi.ai/paper/82929da4eacc81e9e25cf9f0e9770814

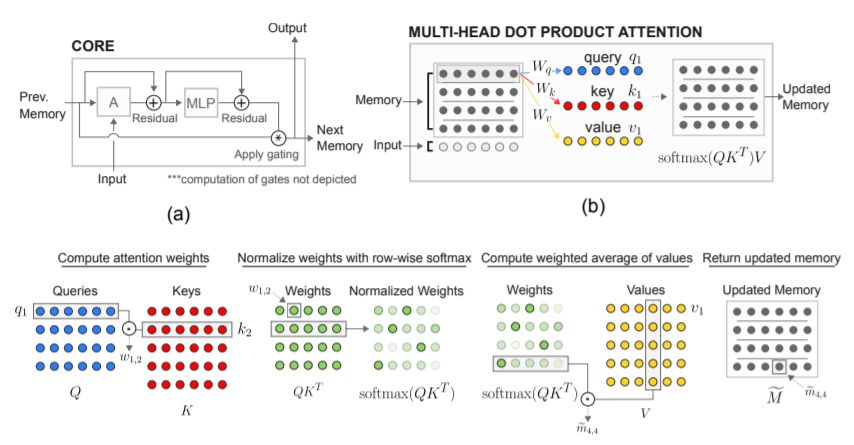

Relational recurrent neural networks. Adam Santoro,Ryan Faulkner,David Raposo,Jack Rae,Mike Chrzanowski,Theophane Weber,Daan Wierstra,Oriol Vinyals,Razvan Pascanu,Timothy Lillicrap

http://www.zhuanzhi.ai/paper/ecd625987c9e4c5dba887fa20fc1d3bd

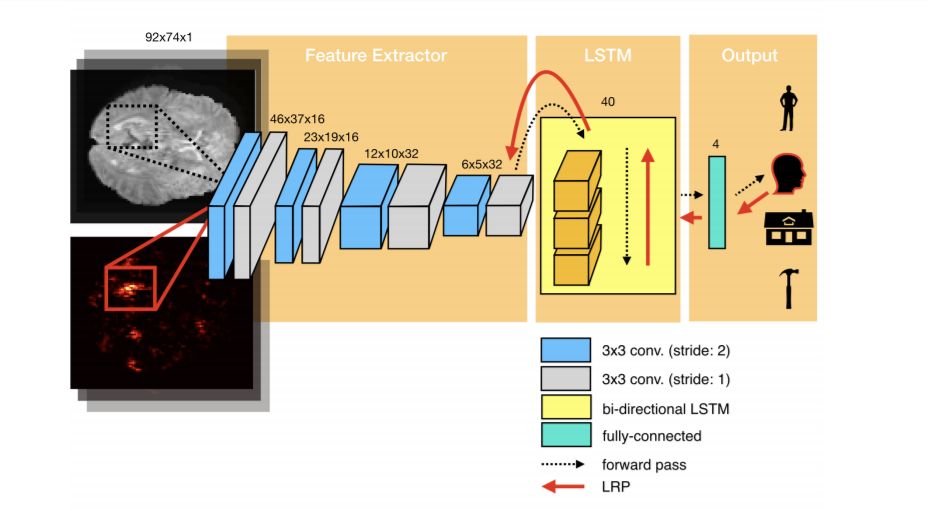

Interpretable LSTMs For Whole-Brain Neuroimaging Analyses. Armin W. Thomas, Hauke R. Heekeren, Klaus-Robert Müller, Wojciech Samek.

https://arxiv.org/abs/1810.09945

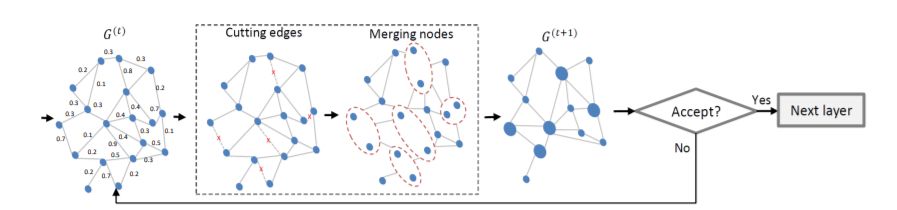

Interpretable Structure-Evolving LSTM. Xiaodan Liang, Liang Lin, Xiaohui Shen, Jiashi Feng, Shuicheng Yan, Eric P. Xing

https://arxiv.org/pdf/1703.03055.pdf

3. 图神经网络

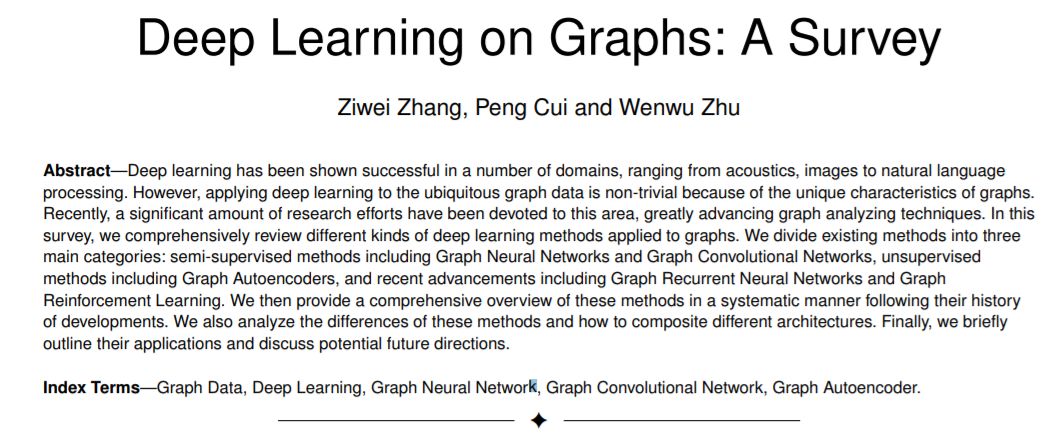

Deep Learning on Graphs: A Survey. Ziwei Zhang,Peng Cui,Wenwu Zhu

http://www.zhuanzhi.ai/paper/abe85f14a3697712fd1c3d0c3b5ddcb0

从声学、图像到自然语言处理,深度学习在许多领域都取得了成功。然而,将深度学习应用于无所不在的图数据并非易事,因为图形具有独特的特性。近年来,这一领域的研究取得了很大的进展,极大地推动了图分析技术的发展。在本研究中,我们全面回顾了应用于图深度学习各种方法。我们将现有的方法分为三大类:半监督方法,包括图神经网络和图卷积网络; 非监督方法,包括图自动编码器; 然后,我们根据这些方法的发展历史,系统地概述这些方法。我们还分析了这些方法的差异以及如何组合不同的体系结构。最后,简要概述了它们的应用,并讨论了未来可能的发展方向。

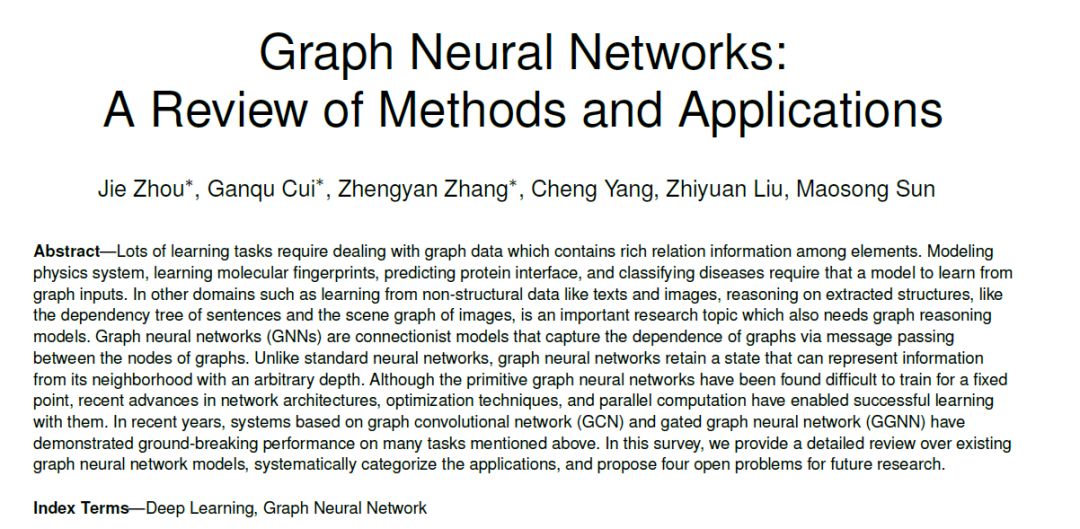

Graph Neural Networks: A Review of Methods and Applications. Jie Zhou,Ganqu Cui,Zhengyan Zhang,Cheng Yang,Zhiyuan Liu,Maosong Sun

http://www.zhuanzhi.ai/paper/488d7f3542ddb0fbda2d94de0a95f882

很多学习任务都需要处理图形数据,这些数据包含了元素之间丰富的关系信息。建模物理系统,学习分子指纹,预测蛋白质界面,以及疾病分类都需要模型从图形输入中学习。在从文本、图像等非结构化数据学习等领域,对提取出的句子依赖树、图像场景图等结构进行推理是一个重要的研究课题,也需要图形推理模型。图神经网络(GNNs)是一种连接主义模型,它通过在图的节点之间传递消息来获取图的依赖性。与标准神经网络不同的是,图神经网络保留了一种状态,这种状态可以用任意深度表示邻居的信息。虽然原始图神经网络很难训练成定点,但是最近在网络结构、优化技术和并行计算方面的进展使得利用它们进行成功的学习成为可能。近年来,基于图卷积网络(GCN)和门控图神经网络(GGNN)的系统在上述许多任务上都表现出了突破性的性能。在本研究中,我们对现有的图神经网络模型进行了详细的回顾,系统地对其应用进行了分类,并提出了四个有待进一步研究的问题。

A Comprehensive Survey on Graph Neural Networks.

http://www.zhuanzhi.ai/paper/9b6b624c68a446ccc9b952c90c76c72b

摘要:近年来,从图像分类到视频处理再到语音识别和自然语言处理,深度学习已经变革了多项机器学习任务。这些任务中的数据通常表示在欧几里得空间中。然而,越来越多的应用使用非欧几里得域生成的数据,并将它们表示为具有复杂关系和相互依赖关系的图。虽然图数据的复杂性对现有机器学习算法提出了重大挑战,但最近许多研究开始将深度学习方法扩展到图数据。本文综述了数据挖掘和机器学习领域中的图神经网络(GNN),并按照新的方法对图神经网络的最新进展进行了分类。在关注图卷积网络的同时,他们还回顾了最近开发的其他架构,例如图注意力网络、图自编码器,图生成网络以及图时空网络等。我们还进一步讨论了图神经网络在多个领域的应用并总结了不同学习任务现有算法的开源代码及基准。最后,我们提出了这一快速发展领域的研究方向。

4. 其他

SDRL: Interpretable and Data-efficient Deep Reinforcement Learning Leveraging Symbolic Planning. Daoming Lyu, Fangkai Yang, Bo Liu, Steven Gustafson. AAAI 2019

Explaining AlphaGo: Interpreting Contextual Effects in Neural Networks. Zenan Ling, Haotian Ma, Yu Yang, Robert C. Qiu, Song-Chun Zhu, Quanshi Zhang

http://www.zhuanzhi.ai/paper/098d54a6f36db868ab0ec5093d57fd67

Explainable Recommendation Through Attentive Multi-View Learning Jingyue Gao (Peking University)*; Xiting Wang (Microsoft Research Asia); Yasha Wang (Peking University); Xing Xie (Microsoft Research Asia) AAAI 2019.

Explainable Reasoning over Knowledge Graphs for Recommendation

Interesting resources related to XAI (Explainable Artificial Intelligence)

-END-

专 · 知

专知《深度学习: 算法到实战》课程正在开讲! 中科院博士为你讲授!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程