梯度下降算法的工作原理

极市导读

梯度下降算法是工业中最常用的机器学习算法之一,但也是很多新手难以理解的算法之一。如果你刚刚接触机器学习,那么梯度下降算法背后的数学原理是比较难理解的。本文将帮助你了解梯度下降算法背后的工作原理。 >>加入极市CV技术交流群,走在计算机视觉的最前沿

介绍

什么是损失函数

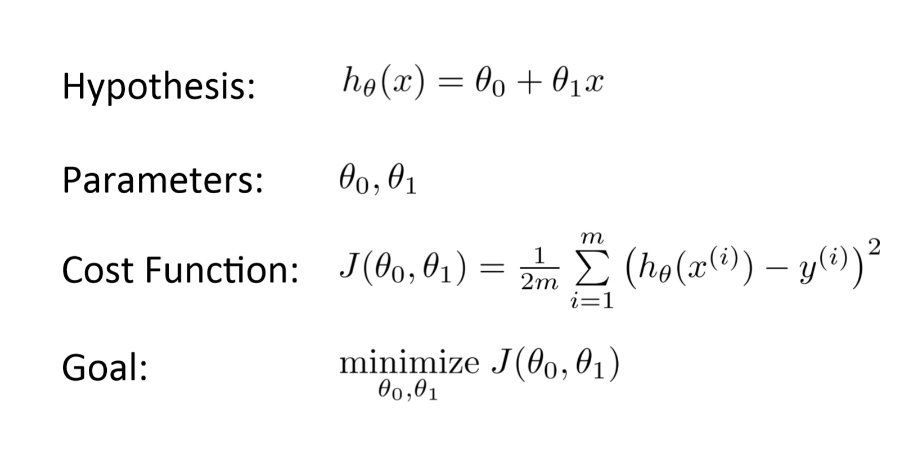

它是一个函数,用于衡量模型对任何给定数据的性能。损失函数将预测值与期望值之间的误差进行量化,并以单个实数的形式表示出来。

什么是梯度下降

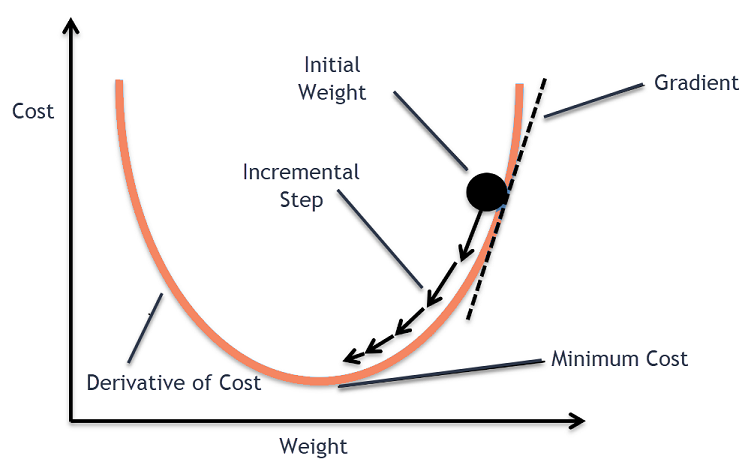

梯度下降法是一种求解函数局部极小值的迭代优化算法。

-

计算梯度(斜率),函数在该点的一阶导数 -

在与梯度相反的方向上移动一步(移动)

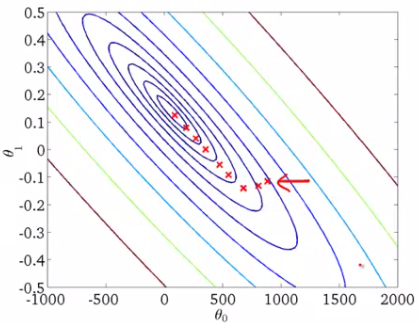

绘制梯度下降算法

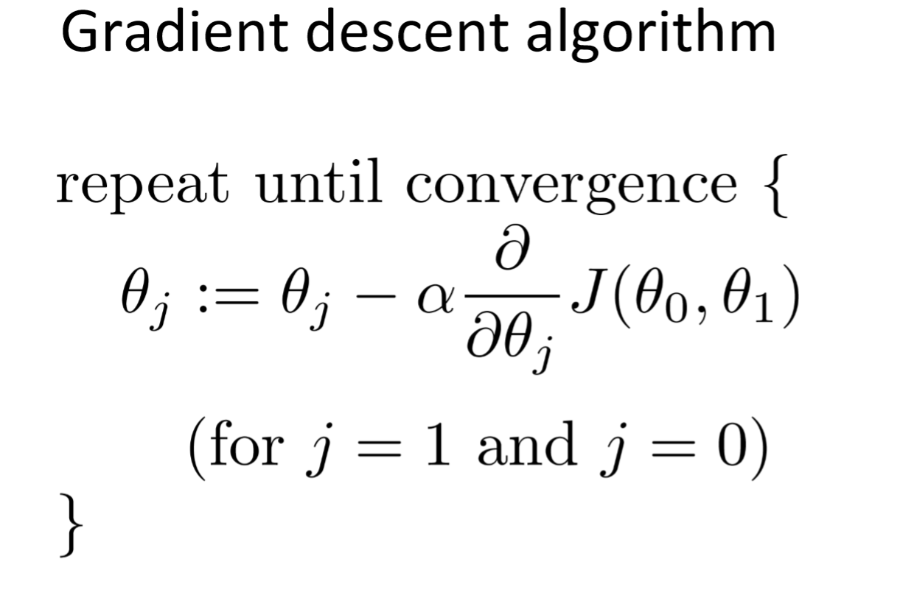

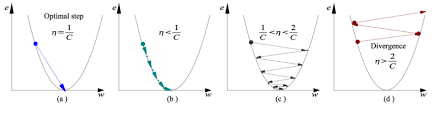

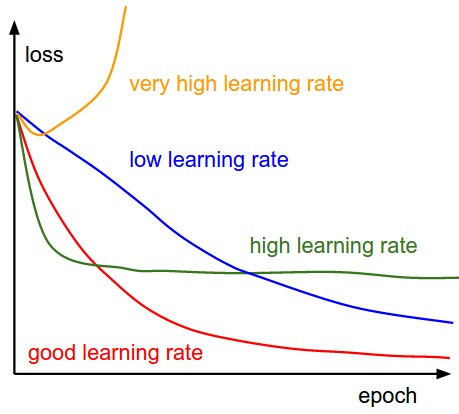

α-学习率

-

如果学习率太高,我们可能会超过最小值,而不会达到最小值 -

如果学习率太低,训练时间可能会太长

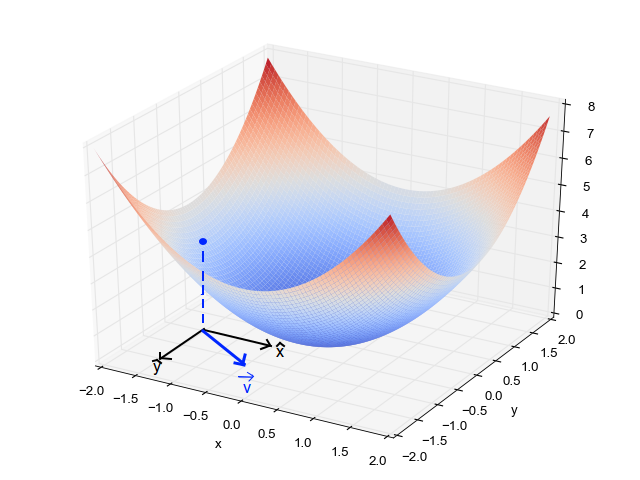

局部最小值

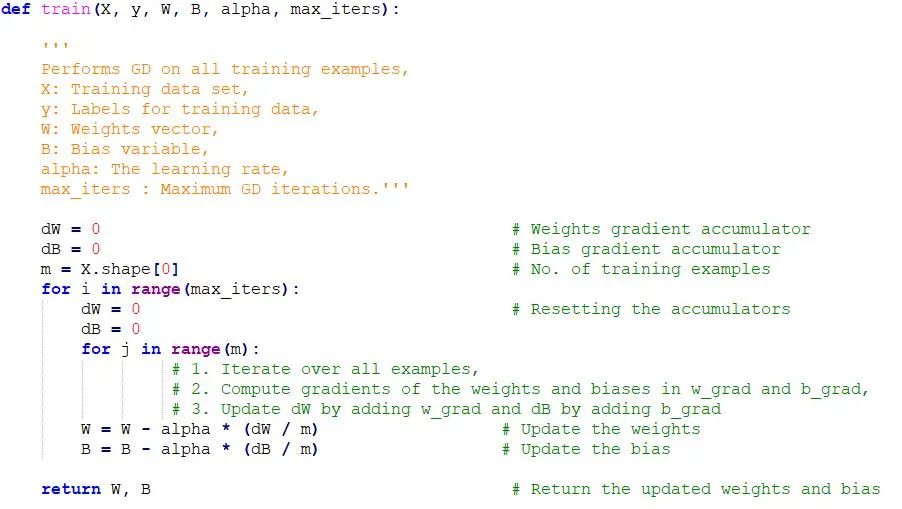

梯度下降的Python代码实现

结尾

推荐阅读

登录查看更多