NeurIPS 2020 | 聚焦自监督学习

InvP

论文标题:

Unsupervised Representation Learning by Invariance Propagation

论文链接:

https://arxiv.org/abs/2010.11694

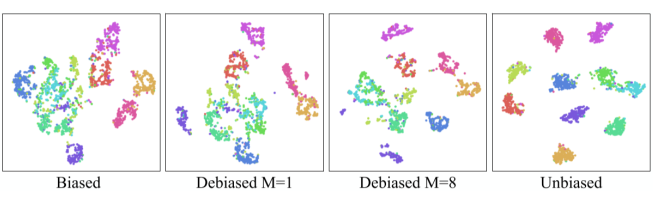

Conclusion: 学习 category-level 的不变性表示。

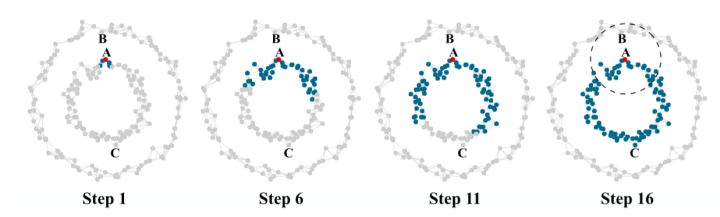

传统的 contrastive learning 是属于 instance-level 的不变性表示,即每个图片单独为一类,该图片与其 argumented images 包含的类别信息保持不变,但是不能保证同一类的两张图片在隐空间相互接近(如何保证同一类的两张图片在隐空间相互接近:有监督对比学习可以在有 label 的情况下实现 category-level 的不变性表示。)。

Contributions:

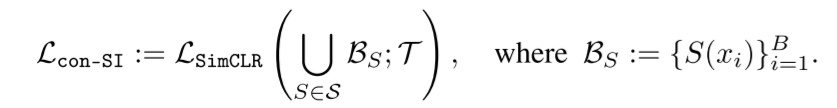

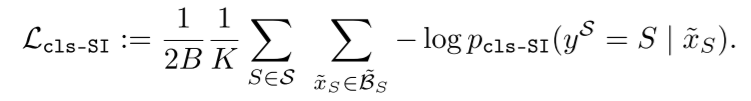

Positive sample discovery:

Hard sampling mining:

-

Hard positive sampling:在上述找到的正样本集合 中选 个与 相似度最小的构成集合 (上图中 C 相对于 A 即最难正样本) -

Hard negative sampling:找 的 近邻构成 , 要足够大使得 ,然后难负样本集合为 。

Experiments:

Opinions:

迭代式的 KNN 真的比传统 KNN 好吗?并不见得!如果两个 high-density region 很靠近,或者相互重叠,那么多次迭代的结果会选择更多的语义信息不相同的数据点。当然这只是我的看法,作者的实验中这样的方法还是有改善的。

整体来看还是比较 Heuristics。

MoCHi

论文标题:

Hard Negative Mixing for Contrastive Learning

论文链接:

https://arxiv.org/abs/2010.01028

Conclusion:通过在特征空间进行 mixup 的方式产生更难的负样本

Contributions

Opinions:

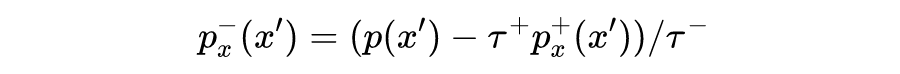

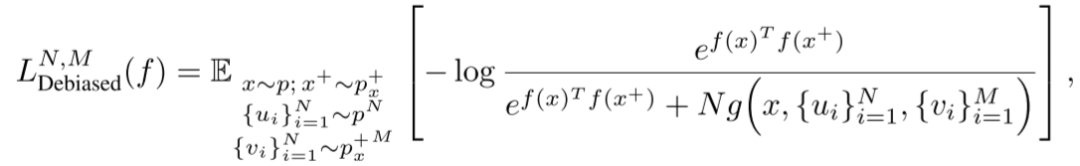

论文标题:

Debiased Contrastive Learning

论文链接:

https://arxiv.org/abs/2007.00224

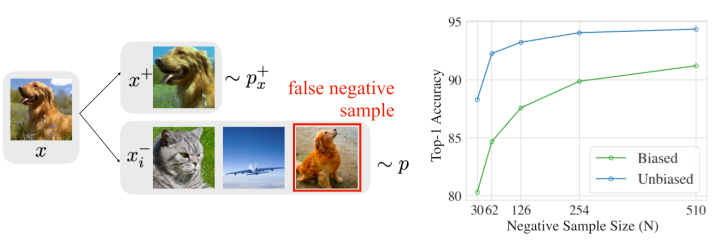

Conclusion: 克服 sample bias:在没有 label 的情况下,尽可能减少负样本中的 false negative samples。

Contributions:

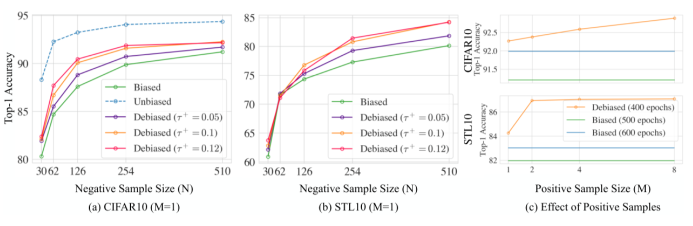

Experiments

在一些常见数据集上做了实验,可以看到通过 unbiased 的损失带来了不小的提升。

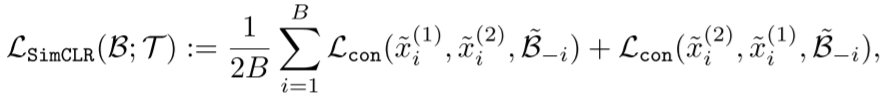

CSI

论文标题:

CSI: Novelty Detection via Contrastive Learning on Distributionally Shifted Instances

论文链接:

https://arxiv.org/abs/2007.08176

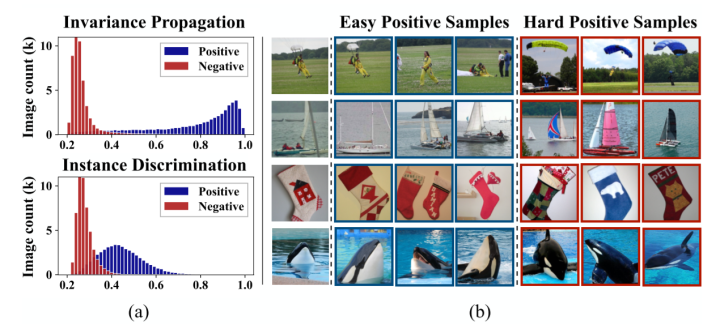

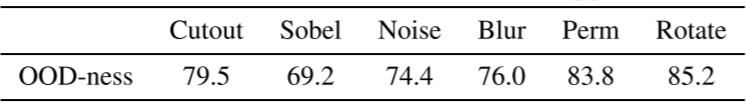

Conclusion: 将 anchor 进行数据增强得到的 image 作为负例来提升 OOD 检测性能。

Contributions

文章主要有两个贡献:

二者相加就是文章的整体损失:

参考文献

[1] https://ieeexplore.ieee.org/abstract/document/4787647

[2] https://arxiv.org/abs/1906.12340

更多阅读

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。