论文浅尝 | 面向视觉常识推理的层次语义增强方向图网络

论文笔记整理:刘克欣,天津大学硕士

链接:https://dl.acm.org/doi/abs/10.1145/3475731.3484957

动机

视觉常识推理(VCR)任务旨在促进认知水平相关推理的研究。现有的方法仅考虑了区域-词的相似性来实现视觉和语言域之间的语义对齐,忽略了视觉概念和语言词之间的隐式对应(如词-场景、区域-短语和短语-场景)。文章提出了一种层次语义增强方向图网络,设计了一个模态交互单元(MIU)模块,通过聚合层次视觉-语言关系来捕获高阶跨模态对齐。

亮点

文章的亮点主要包括:

1.提出了一种新颖的层次语义增强方向图网络(Hierarchical Semantic Enhanced Directional Graph Network, HSDGN)用于视觉常识推理任务,该网络能够捕获不同模式间的高阶相关性,并执行清晰的推理过程。;2.提出了一个HSF层,通过探索视觉概念和语言词之间的层次语义对应,更准确地捕捉跨模态语义对齐;3.设计了一个DCGR模块,该模块可以在每个推理步骤中根据实体的重要性动态选择有价值的实体,从而使推理过程更具可解释性。

概念及模型

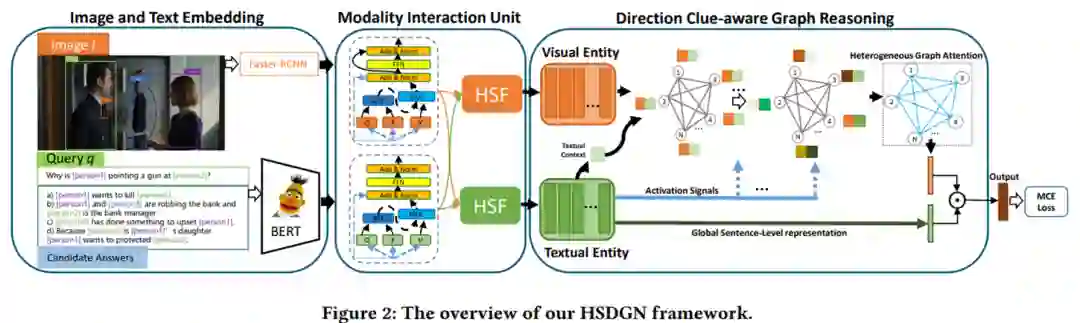

文章提出的HSDGN包括三个部分:

•图像和文本嵌入模块:使用自上而下的注意力提取图像的区域级特征,是以哦那个预训练的BERT提取文本的单词级特征。•模态交互单元(Modality Interaction Unit, MIU)模块:包括模态内上下文建模层和层次语义融合(Hierarchical Semantic Fusion, HSF)层。通过聚合层次视觉-语言关系来捕获高阶跨模态对齐。•方向线索感知图推理(Direction Clue-aware Graph Reasoning , DCGR)模块:利用激活信号帮助执行有向图推理,然后利用异构图注意聚合演化的图表示以获得最终结果。

模型整体框架如下:

•图像和文本嵌入模块 对于每张图片,文章使用Faster-RCNN提取了N(N=36)个区域,表示为R={r_1,r_1,…,r_N},然后使用全连接层学习每个区域的特征表示:

其中W和B是参数。同时,文章为图像区域编码了位置特征:

其中(p_i ) ̃是i区域的位置,W和B是参数,σ是激活函数。最终的视觉表示为:

对于文本,文章使用预先训练的BERT来提取上下文增强的词级嵌入,表示为E={e_1,e_1,…,e_B}。然后使用全连接层学习最终的文本表示:

•模态交互单元 模态交互单元(MIU)由模态内上下文建模层和分层语义融合层组成。文章堆叠MIU 来捕获足够的上下文注意流,用于通道内和通道间的交互。

模态内上下文建模. 使用自注意力机制来建模模态内的上下文:

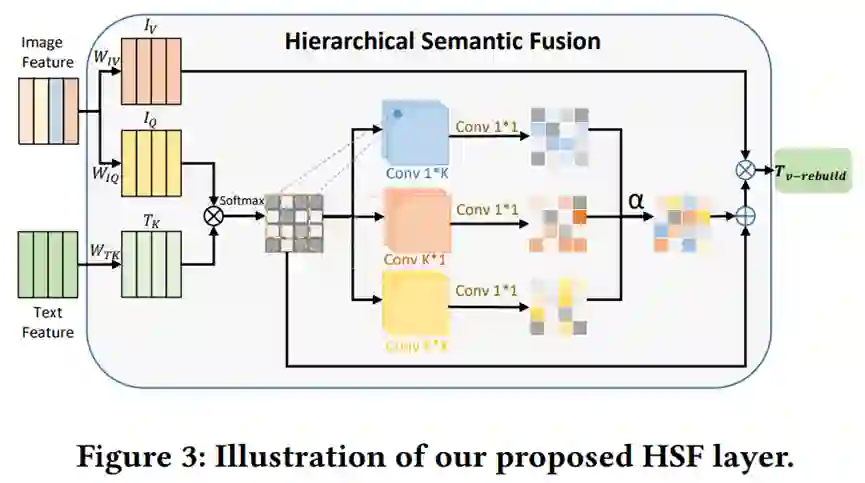

层次语义融合. 层次语义融合(HSF)层旨在获取词-场景、区域-短语和短语-场景的层次语义,以实现更有区别的视觉和语言对齐。

首先计算每个图像区域和每个词之间的注意力分布:

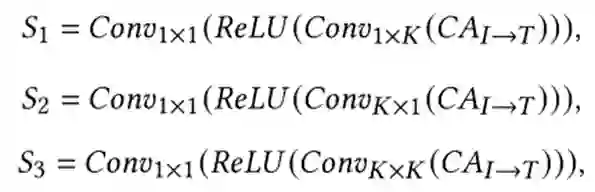

在获得每个区域-词对之间的关系后,文章在亲和矩阵上使用三种类型的卷积核并行捕获层次语义关联。具体来说,使用1×K的卷积核捕捉词和场景(K个区域)之间的关系,使用K×1的卷积核捕捉短语(K个词)和区域的关系,使用K×K的卷积核捕捉短语(K个词)和场景(K个区域)的关系。之后,再采用ReLU函数进行激活,然后在每个通道中使用1×1的卷积核。计算公式如下:

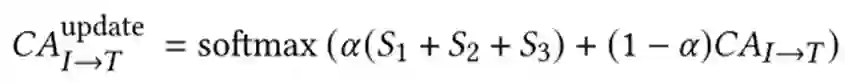

然后对多层级的关系进行融合:

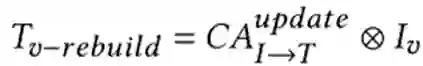

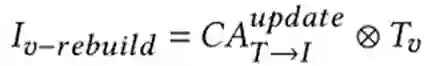

然后,利用层次语义重构文本值矩阵,公式如下:

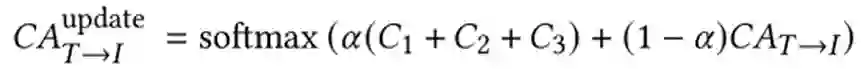

其中 代表矩阵乘法。类似的,图像到文本的注意力可以更新如下:

C1, C2, C3分别代表区域-短语,词-区域和短语-场景的层次语义。然后,利用层次语义关系重构视觉值矩阵:

其中 代表矩阵乘法。

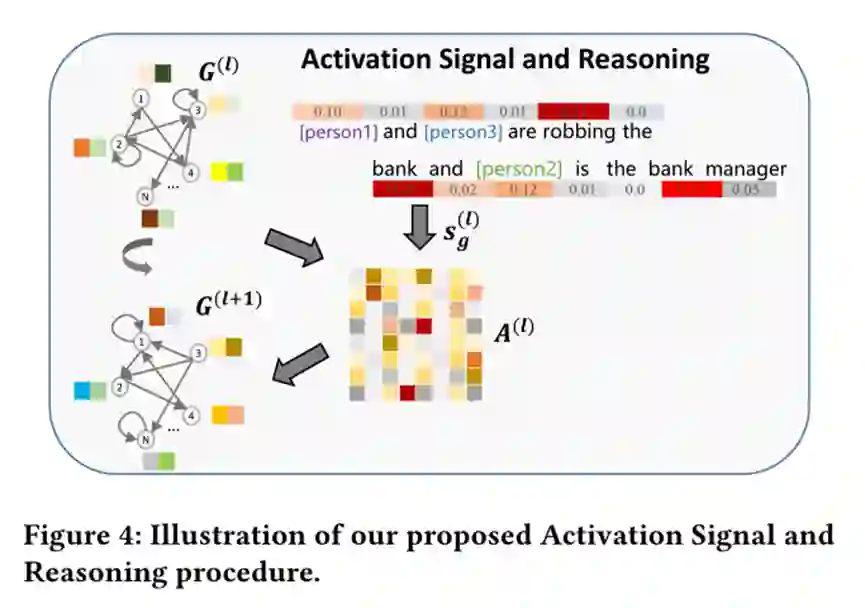

•方向线索感知图推理 方向线索感知图推理模块基于上述MIU模块输出的具有区别性的视觉与一特征进行有向图推理。主要包括三部分内容:(1)图构建,即利用视觉概念和语言词汇构建异构图。(2)激活信号与推理。激活信号赋予模型在每个推理步骤中动态选择有价值实体的能力。(3)异构图注意,用于聚合演化的图以获得最终答案。

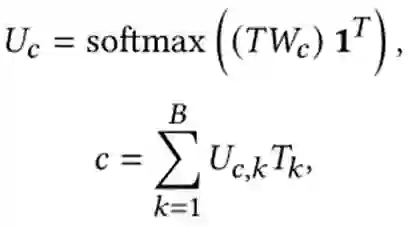

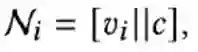

图构建. 文章使用不包含文本上下文的区域表示构件图。给定视觉嵌入V={v_1,v_1,…,v_N}和文本嵌入T={t_1,t_1,…,t_N},上下文区域表示为:

然后拼接视觉嵌入和上下文区域表示作为图的节点:

其中,|| 表示拼接操作。

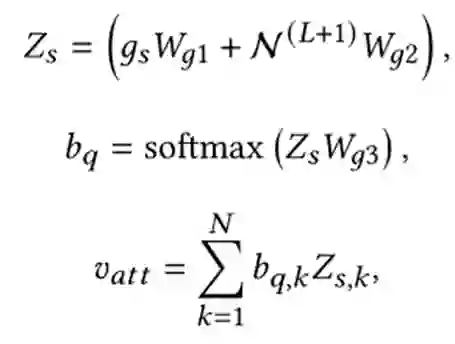

激活符号和推理. 推理模块动态的选择有价值的实体。具体的,利用实体的重要性来修正不同推理步骤的边权值。

异构图注意力. 文章设计了一种基于文本的注意力机制,以获取图嵌入作为增强的视觉特征。

理论分析

实验

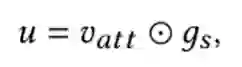

作者在公开数据集VCR上进行了实验。首先是对比实验,模型的评价指标为准确率。

文章所提的方法在VCR验证数据集上获得了54.4%的总体准确性,优于最先进的神经模块模型。

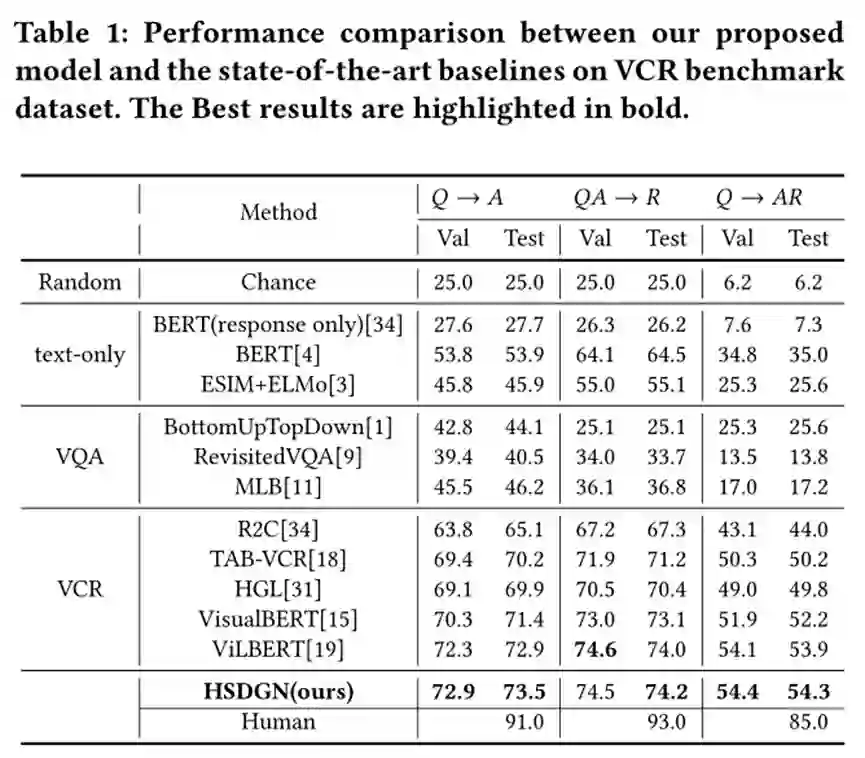

此外,文章进行了消融实验以验证模型各个模块的有效性。

同时,作者在VQAv2验证数据集上将所提的KI-Net与最先进的场景图生成模型GB-Net进行了比较。

实验结果验证了MIU模块,DCGR模块以及两个模块中的子部分的有效性。其中MIU模块中的ICM对整个结果的预测最为重要。

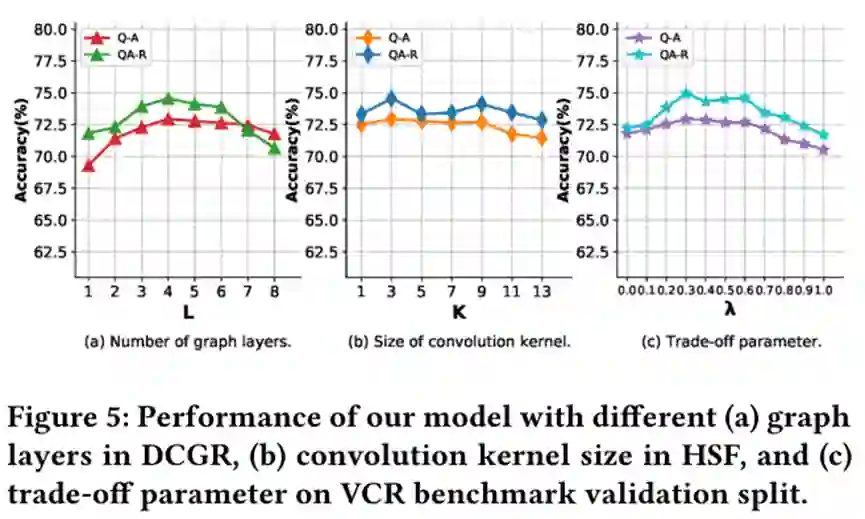

同时,文章实验了模型中参数的敏感性:

总结

文章提出了一种视觉常识推理模型HSDGN。具体地说,将模态交互单元和方向线索感知图推理整合到一个统一的框架中。根据区域和词之间丰富的相关性,设计了分层语义融合层,实高阶视觉语言对齐。此外,文章引入了一个方向线索感知的图推理模块,使最终答案的推理过程具有可解释性。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。