【NeurIPS2022】M4I:多模态模型成员推断

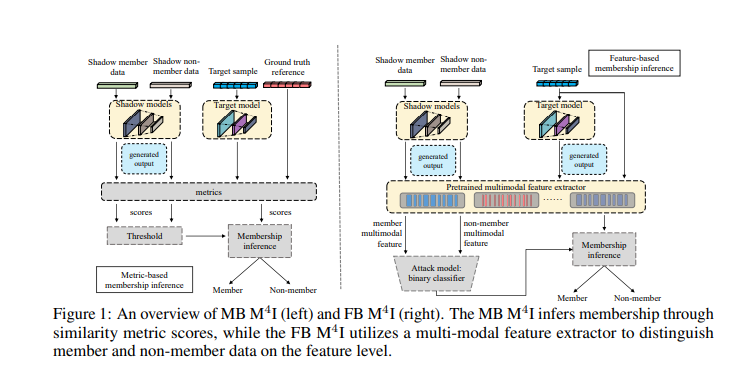

随着机器学习技术的发展,真实世界的数据以不同模态的形式存在,研究的重点已从单模态学习转向多模态学习。然而,多模态模型通常比单模态模型携带更多的信息,它们通常应用于敏感场景,如医疗报告生成或疾病识别。与现有的针对机器学习分类器的成员推理方法相比,我们关注的是多模态模型的输入和输出是不同形式的问题,如图像字幕。本文从成员推理攻击的角度研究了多模态模型的隐私泄露问题,成员推理攻击是一个判断数据记录是否参与模型训练过程的过程。为此,我们提出了多模态模型成员推断(M4 I),并使用两种攻击方法来推断成员状态,分别称为基于度量(MB) M4 I和基于特征(FB) M4 I。更具体地说,MB M4 I在攻击时采用相似度度量来推断目标数据的成员。FB M4 I采用预训练的阴影多模态特征提取器,通过比较提取的输入输出特征的相似性来达到数据推理攻击的目的。大量的实验结果表明,这两种攻击方法都能取得较好的性能。在不受限制的场景下,平均攻击成功率分别为72.5%和94.83%。此外,我们评估针对攻击的多种防御机制。M4 I攻击的源代码可以在https://github.com/MultimodalMI/ Multimodal-membership-inference.git上公开获取。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“M4I” 就可以获取《【NeurIPS2022】M4I:多模态模型成员推断》专知下载链接

登录查看更多

相关内容

Arxiv

11+阅读 · 2020年7月31日