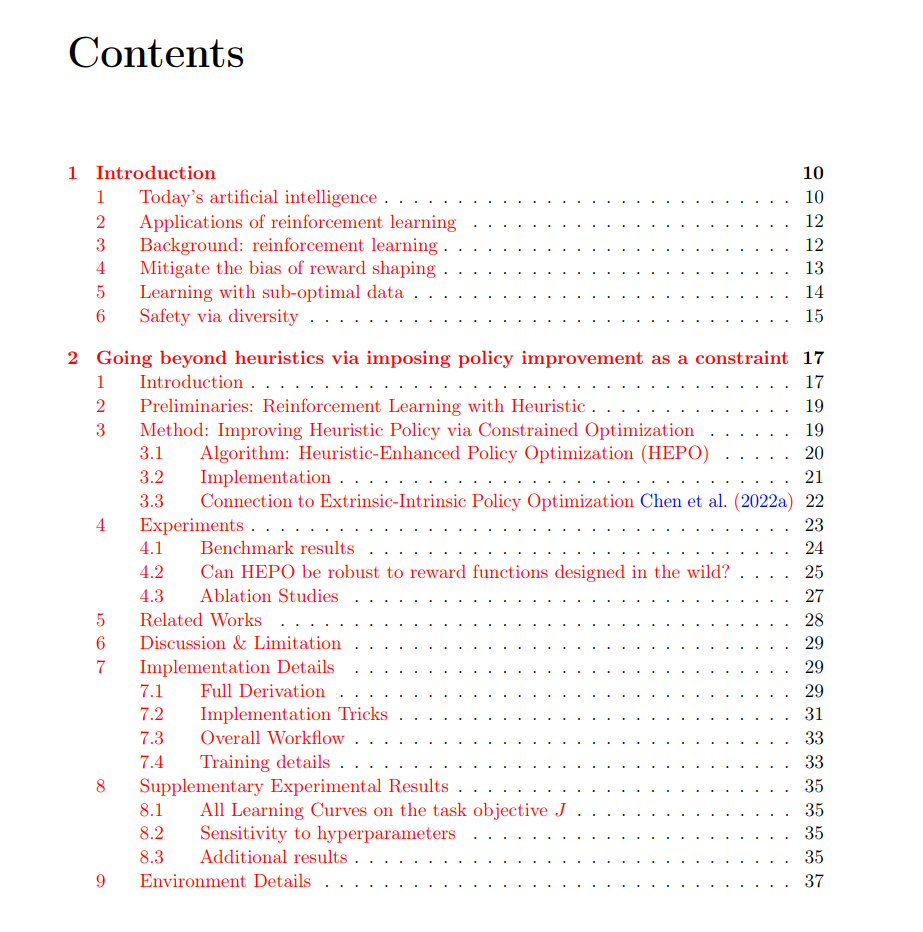

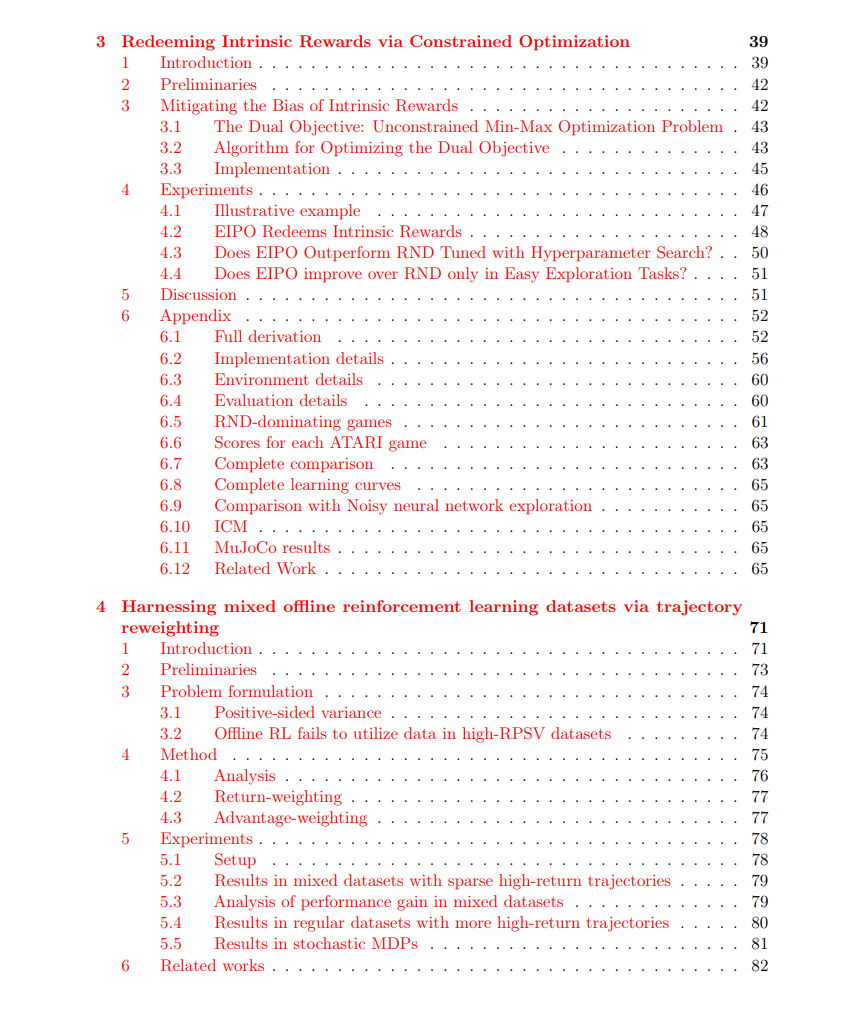

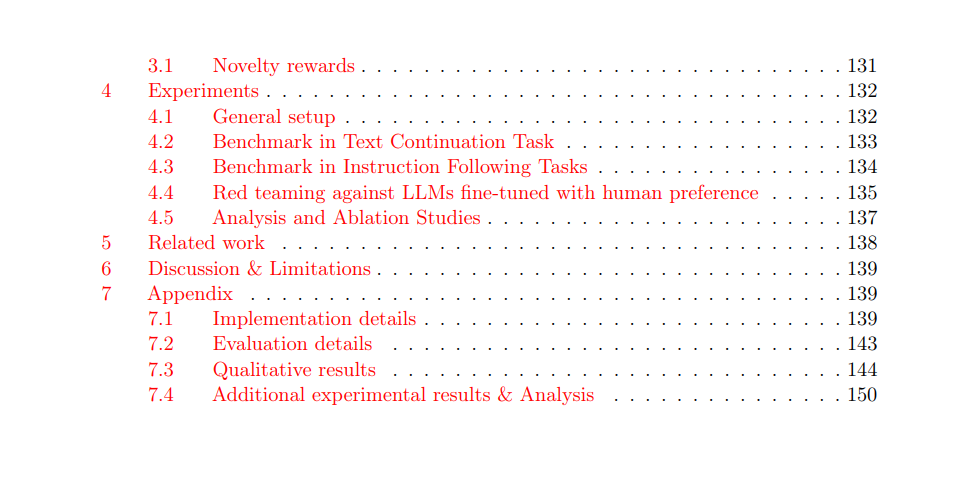

发现新知识对技术进步至关重要,这一过程类似于人类和动物学习新技能的方式——通常通过试错法。例如,古代人类通过尝试不同的方法发现了火,孩子们通过反复的尝试和失败学会了走路和使用工具。在化学领域,科学家通过测试各种组成来发现新的催化剂。但人类是如何利用试错法改进现有的解决方案的(例如,学习更高效的走路方式或合成新化合物)?我们能否设计出模仿或超越人类发现过程的计算模型?这样的计算模型可以大大加速科学和工程的进展,因为它们可以自动化或辅助人类科学家和工程师的工作,更高效地发现新知识(例如,发现新化合物、简化机器人控制器设计等)。强化学习(RL)非常适合发现任务,因为它使机器能够通过试错法进行学习。我的工作克服了当前RL算法的以下主要局限性,从而推动了它们在发现任务中的潜力: 减少奖励塑形的偏差。强化学习依赖于来自试错经验的奖励信号,但这些信号可能是稀疏的,意味着只有在找到期望的解决方案时才会提供奖励,否则奖励为零。因此,大多数试验几乎没有反馈。为了在稀疏奖励的情况下提高性能,常见的策略是提供额外的提示(即奖励塑形)来引导RL算法。然而,如果这些提示不准确,它们可能会将算法引导到比没有提示时更差的解决方案。我提出了一种新的RL框架,可以与任何标准RL算法结合,确保使用提示进行训练时能够找到更好的解决方案,而不会损害性能。 使用次优数据进行学习。强化学习不仅可以通过与世界的在线互动来学习,还可以通过已记录经验的数据集来学习。对于像材料发现或机器人学习这样的昂贵或耗时的任务,离线强化学习可能更为优选,因为它利用现有数据,而不需要与世界进行新的交互。然而,这些数据集可能包含大多数低奖励的解决方案,这限制了离线RL算法在发现比数据集中更好的解决方案时的性能(正如我们在本文中稍后所展示的)。我提出了样本重加权策略,这些策略通过重新加权数据集,使得使用加权样本训练的当前离线RL算法能够发现比数据集中更好的解决方案,即使数据集中低奖励的解决方案占主导地位。 通过多样性保障安全。标准的RL算法旨在找到一个“最佳”解决方案。然而,在许多发现问题中——例如药物开发——产生多个具有不同特性的高奖励解决方案(即多样性)比仅关注单一解决方案更具价值。我研究了这个问题在一个新兴的发现任务中的应用——对抗大型语言模型(LLM)。在对抗测试中,我们需要生成多样化的提示,触发目标语言模型的不良输出。目前的做法利用RL训练一个LLM来对抗另一个LLM,但它们生成的提示多样性不足,通常会收敛到几个始终触发不良输出的提示。我提出了奖励智能体最大化生成提示的多样性,这也提高了提示在触发目标LLM的不良输出方面的成功率。