耶鲁大学发布自然语言处理资源引擎TutorialBank: 让NLP学习不再困难

【导读】近日,耶鲁大学研究团队通过人工收集6500个自然语言处理领域的综述,教程,论文,课程,数据集以及代码等各种资源,建立起一个自然语言处理领域的资源搜索引擎TutorialBank。这使得研究者可以很方便的系统获取各种学习资源,将极大的降低自然语言处理学习的门槛。搜索引擎现已开放使用, 相关资源也已开源,这项工作发表在ACL 2018上。

链接:http://tangra.cs.yale.edu/newaan/

使用方法:可以通过两种方式来获取资源

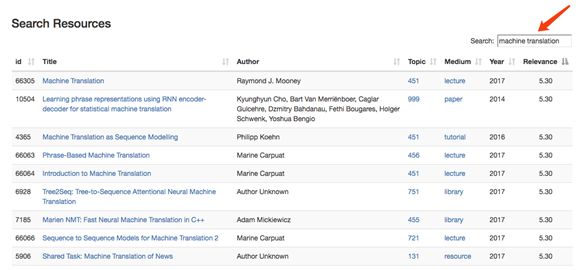

第一种是直接通过关键词搜索:

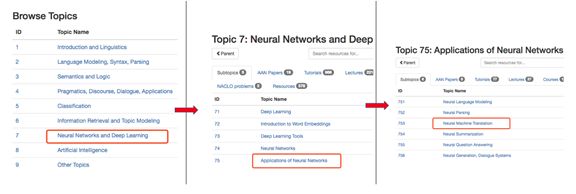

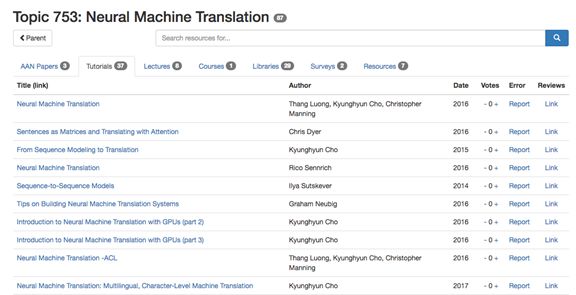

第二种方式通过多级检索目录查询感兴趣的领域:

以下是TutorialBank的官方介绍

作者 | Alexander R. Fabbri

编译 | 专知

参与 | Mandy, Xiaowen, Sanglei

TutorialBank: Learning NLP Made Easier

介绍(Introduction)

欢迎大家!如果你对自然语言处理(NLP)或相关领域感兴趣,请继续阅读!NLP正在迅速成长, 因此, 在这一领域的进步对学生或研究者来说似乎是令人望而生畏的。为了帮助不断增长的NLP社区和推动与NLP相关的教育应用研究,我们通过我们的搜索引擎引入了一个新的语料库,叫做All About NLP(AAN)(在aan.how【1】和我们的论文【2】“TutorialBank: Using a Manually-Collected Corpus for Prerequisite Chains, Survey Extraction and Resource Recommendation”可以找到相关介绍【3】)

什么是TutorialBank?

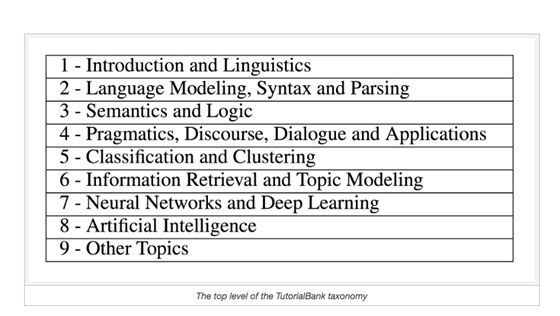

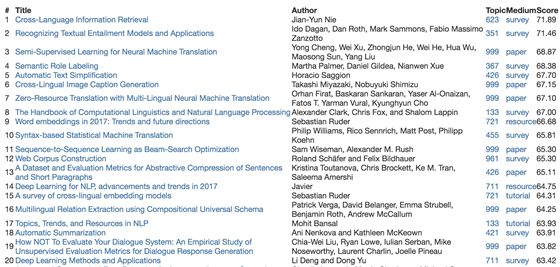

TutorialBank是一个人工收集的数据库,它包含了NLP,人工智能(AI),机器学习(ML)和信息检索(IR)等相关领域的约6,500条资源。几年来,我们精选了与这些领域相关的优质资源。其中包括了surveys, tutorials, libraries, codebases等。我们觉得除了学术论文之外,学生们还从阅读教程(tutorials)中学到很多东西,所以我们专注于论文以外的资源。对于每个资源,我们使用元数据来填充数据库(比如论文中所述的资源类型),并根据我们自己对300多个主题的分类方法对每个资源进行分类。这些主题涵盖了广泛的领域,从基础数据结构、算法到数学和语言学,以及在深度学习、机器翻译和强化学习等方面的最先进的技术。下面列出了一些主题:

如何使用TutorialBank?

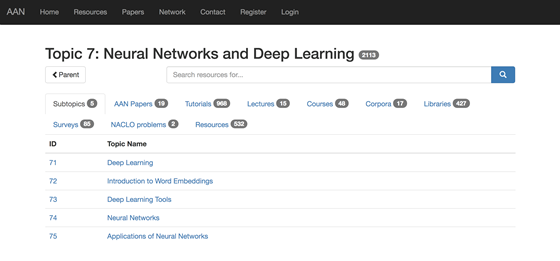

非常容易!我们创建了一个搜索引擎,我们称之为“All About NLP”(AAN),你可以使用它来快速搜索我们的语料库(访问语料库)。缩写AAN来自于ACL Anthology Network语料库(可以通过文章【4】和文章【5】来了解)。我们将我们的新搜索引擎与来自ACL Anthology Reference Corpus【6】的超过24000篇论文整合在一起,并不断用新资源更新我们的搜索引擎。你可以浏览我们的资源分类,并通过单击“Browse Resources by Topic:”选择你正在查找的资源类型:

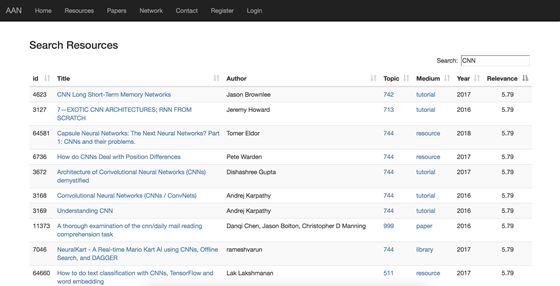

或者你可以通过单击“Search Resources”来搜索特定的术语,如下所示:

资源推荐(Resource Recommendation)

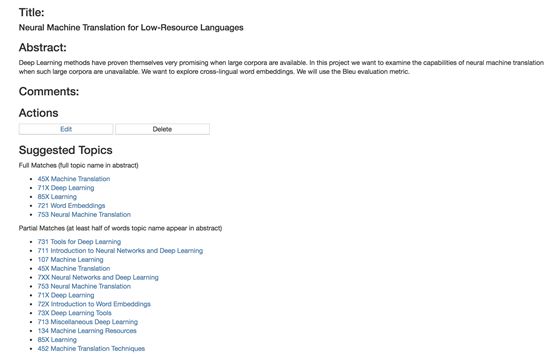

我们网站的另一个令人振奋的功能是基于标题和摘要对来推荐资源。通常情况下,你可能会被指派一项任务,或者对一个项目有一个早期的想法,并且需要找到资源来推进你的想法。基于这个出发点,我们想为你推荐一些资源来完成你的项目,比如编写一个由tutorial组成的参考书目。要使用此功能,请访问Dashboard【7】(需要登录)并单击“Public Projects”以查看示例,或者点击“My Projects”创建你自己的项目。除了来自我们语料库的相关资源列表之外,我们还推荐基于文本匹配的分类主题。我们计划通过探索标题和抽象对之间的关系来改进当前的baseline。示例输出如下:

还有更多功能吗?

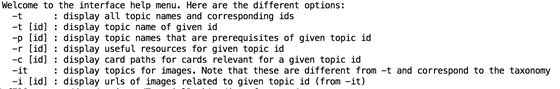

当然有!虽然在搜索引擎中收集的这些资源本身是很好的,但是更好的是我们标注我们的语料库,使其对学生和研究者都更有用。此外,我们还创建了一个简单的命令行工具(与语料库一起提供),以使我们的标注(annotations)更易于访问,如下所述。

Survey Topics,Reading Lists,Prerequisite Chains

我们创建了一个200个主题的列表,我们觉得主题的调查会让学生受益。正如论文中所说的,这些主题与分类主题不同,因为我们不希望我们的调查主题过于宽泛或细粒度。对于每个主题,标注者(annotators)创建了关于该主题的最多5个资源的阅读列表。然后,我们将这些list的资源分成内容卡片,并将这些卡片标记为有用的或不适用于学习当前主题的。这一点很重要,因为资源通常是在一个更一般化的主题上,而且只是部分地涵盖了你想要了解的主题。

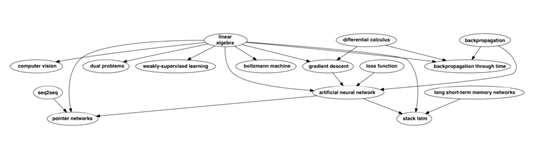

如果你不知道从哪一个主题开始,怎么办呢?为了解决这个问题,我们标注了哪些主题是其他主题的先决条件;你应该学习哪些主题来更好地理解一个给定的主题。我们的图表的一部分如下所示:

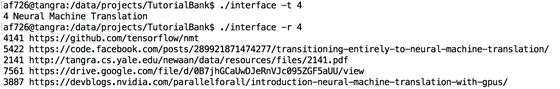

访问我们的标注(Accessing our annotations)

这听起来有点拗口。幸运的是,我们创建了一个命令行工具,使我们的标注易于访问:

如何使用TutorialBank来进行学术研究?

我们正在发布使用我们语料库中的资源的连接(点击这里查看资源的mysql转储【8】)。鉴于版权问题,我们的资源链接不包括完整的文档,但是包含脚本可以用来下载资源【9】。 我们对资源类型和主题分类的标注促进了文本分类和主题建模方面的研究,同时我们希望我们的标注阅读列表和调查提取标注将促进科学主题的信息检索。最后,我们广泛的先决条件链标注可用于以监督或半监督的方式来学习概念依赖关系。

我能如何对此作出贡献?(How can I contribute?)

AAN是为用户而建,所以我们非常感谢你能有任何反馈。当你按主题浏览资源时,你可以为特定的资源进行向上(赞同)或向下(反对)的投票。这样的投票将帮助我们确定哪些类型的资源是受欢迎的,并允许我们在将来更好地添加到语料库中。此外,你还可以查看一个资源,并分享你对该资源的想法和见解【10】。你也可以报告错误。例如,你可能认为资源已被错误分类,或者链接可能不再指向所需的资源。对于其他问题,请随时给我发电子邮件或在我们的网站“联系”下发送信息。最后,你可能想向我们建议一个宝贵的资源,该资源目前不是我们的语料库的一部分。你可以通过点击建议资源链接从Dashboard(需要登录)这样做。我们的小组将对包含建议的资源做出最后的决定。我们要求该资源对更广泛的社区具有普遍的兴趣。

What can I expect in the future?

在未来,我们计划扩大我们的分类和语料库,以便更广泛的覆盖范围。我们还将添加新的功能,并改进现有的搜索和推荐算法。此外,我们正在计划细化我们的注释,更深入地探索prerequisite chains、 resource recommendation 和 survey extraction的研究领域。

Reference

@InProceedings{fabbri2018tutorialbank,

author = {Fabbri, Alexander R and Li, Irene and Trairatvorakul, Prawat and He, Yijiao and Ting, Wei Tai and Tung, Robert and Westerfield, Caitlin and Radev, Dragomir R},

title = {TutorialBank: A Manually-Collected Corpus for Prerequisite Chains, Survey Extraction and Resource Recommendation},

year = {2018},

booktitle = {Proceedings of ACL},

publisher = {Association for Computational Linguistics}

}

1.http://tangra.cs.yale.edu/newaan/

2.https://arxiv.org/pdf/1805.04617.pdf

3.https://github.com/Yale-LILY/TutorialBank

4.http://clair.si.umich.edu/~radev/papers/aan09.pdf

5.http://clair.si.umich.edu/~radev/papers/aan_lre.pdf

6.http://clair.si.umich.edu/~radev/papers/lrec08.pdf

7.http://tangra.cs.yale.edu/newaan/index.php/auth/login

8.https://github.com/Yale-LILY/TutorialBank/blob/master/data/resources.sql

9.https://github.com/Yale-LILY/TutorialBank/blob/master/src/download_all.py

10.http://tangra.cs.yale.edu/newaan/index.php/resource/review/3386

原文链接:

https://alex-fabbri.github.io/TutorialBank/

http://tangra.cs.yale.edu/newaan/

https://github.com/Yale-LILY/TutorialBank

https://arxiv.org/pdf/1805.04617.pdf

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取

[点击上面图片加入会员]

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知